基盤モデルとは?新たなAI開発の形?代表11モデル・導入方法・メリット・選び方の重要性について解説

最終更新日:2025年08月19日

基盤モデルとは、大量のデータで学習されたAIモデルであり、幅広いタスクに対応が可能で、近年は、基盤モデルを用いたAIシステムの開発が進んでいます。

本記事では今注目されている基盤モデルについて紹介していきます。基盤モデルとは一体どんなものなのか?従来のAIとどう違うのか?そのメリットとは?など気になる点を解説していきますので、最後までご覧ください。

AIシステム開発の基本や手順についてはこちらの記事で詳しく説明していますので併せてご覧ください。

貴社ニーズに特化したAI開発に強い開発会社の選定・紹介を行います

今年度AIシステム開発相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・画像認識、予測、LLM等、AI全対応

完全無料・最短1日でご紹介 AI開発に強い会社選定を依頼する

ChatGPT/LLM導入・カスタマイズに強いAI開発会社を自力で選びたい方はこちらで特集していますので併せてご覧ください。

基盤モデルとは

基盤モデル(Foundation Model:ファウンデーションモデル)とは、大量かつ多様なデータで訓練され、多様な下流タスクに適応(ファインチューニングなど)できるAI・機械学習モデルのことをいいます。ファインチューニングとは、既に学習したモデルが、特定のタスクを行うためにデータセットで再学習をし、モデルを微調整することです。

基盤モデルのわかりやすい例として生成AIであるOpenAIのChatGPTやAnthropicのClaudeなどが挙げられます。例えば「GPT-3.5」や「GPT-4」は、大量で多様なテキストデータを学習しています。

OpenAIは、ChatGPTで文章生成や質問応答、感情分析などのタスク(=下流タスク)を行うために基盤モデル(GPT)をファインチューニングして構築されています。

従来のAIとの違いとは

基盤モデルは、従来のAIと大きく異なります。従来のAIは、処理したいタスクごとにデータセットを用意しモデルを設計・訓練する必要がありました。目的のタスクに特化させると、目的のタスクでは高い性能を発揮しますが、それ以外では精度が低く、汎用性に欠けてしまいます。

一方、基盤モデルは、大量かつ多様なデータを学習し、さらに多様なタスクに対応することを想定しており、様々なタスクで高い能力を発揮することができます。基盤モデルは精度の高さと汎用性を兼ね備えたAIと言えます。

LLM(大規模言語モデル)と基盤モデルの違い

基盤モデルとは、大量かつ多様なデータで学習され、様々なタスクに応用できる汎用的なAIモデルのことですが、LLM(大規模言語モデル)とは、基盤モデルの一種で大量のテキストデータを学習した大規模な言語モデルのことを指します。

つまり、基盤モデルは様々なタイプのデータ(テキスト、画像、音声など)を学習できる汎用モデルで、LLMはその中でもテキストデータに特化した基盤モデルと言うことができます。

LLMの代表例としてGPT-3.5があげられることから、しばしばLLMと基盤モデルが同義で語られることがあります。しかし、厳密にはLLMは基盤モデルの一種であり、全ての基盤モデルがLLMというわけではありません。

多くのLLMは対話や文章生成など特定のタスクができるようファインチューニングされていますが、これは基盤モデルの特徴である汎用性を活かしているからだと言えます。

貴社ニーズに特化したAI開発に強い開発会社の選定・紹介を行います

今年度AIシステム開発相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・画像認識、予測、LLM等、AI全対応

完全無料・最短1日でご紹介 AI開発に強い会社選定を依頼する

基盤モデルを使うメリット

基盤モデルにはどんなメリットがあるのでしょうか?例えば以下のようなものがあげられます。

- 汎用性が高い

- 自社用にパーソナライズできる

- 開発費用を抑えることができる

汎用性が高い

基盤モデルの最大の特徴は、多様なタスクに対応できるようにファインチューニングできることです。これにより、従来のAIにはない汎用性の高いAIとなります。

単純なデータ分析や画像認識だけではなく、自然言語での文章作成や要約、画像から文章を作成する、文章から画像を作成すると言った様々なタスクに利用することができます。

自社用にパーソナライズできる

企業でAIを利用する場合は、自社や業界独自の情報を活用できることが重要です。従来のAIでは、自社特有のデータを特定の目的で活用することが一般的でしたが、基盤モデルはファインチューニングすることで、様々なタスクでパーソナライズされた情報を活用することができます。

基盤モデルには学習されていない業界や自社独自のデータを基盤モデルにファインチューニングすることで、自社用にパーソナライズすることができます。

開発費用を抑えることができる

基盤モデルはAIの開発費用を抑えることができます。従来のAIは、その設計から開発、学習にかなりの費用がかかりました。特に学習段階では大量のデータをラベリングする手間と準備コストが発生します。

しかし、基盤モデルは既に大量のデータセットで学習されています。そして、汎用的な処理をできるようにファインチューニングできます。基盤モデルをそのまま活用するのであれば開発費用はほぼ発生しません。

自社独自にパーソナライズする場合でも、一からではなく、既存のモデルに追加でファインチューニングをすることで済み、学習もラベリング等の作業が必要ないため従来のAI開発に比べてコストを抑えることができます。

AI開発の代表的な手順については、こちらで詳しく解説しています。

基盤モデルの代表例

近年、基盤モデルの数は急速に増加しており、現在では数十種類の基盤モデルが開発されていると言われています。中でも代表的な基盤モデルは以下のようなものがあります。

GPT

GPT(Generative Pre-trained Transformer)は、OpenAIが2018年に発表した基盤モデルです。GPTは大量のテキストデータを用いて事前学習され、次の単語を予測するタスクで高い性能を発揮します。これにより、文章生成や言語翻訳など、様々なタスクに応用可能となりました。

生成AIが有名となったきっかけであるChatGPTは、GPT-3.5 をベースにしたものです。GPT-3.5をベースにしたChatGPTの登場は、対話AI界に大きなインパクトを与えました。

その後開発されたGPT-4 は、画像や文章・音声など様々な形式の内容を理解して文章としてアウトプットすることができるマルチモーダルモデルで、様々な生成AIに採用されています。

Meta Llama 2

Llama 2(ラマ2)はMetaとMicrosoftが共同で開発した基盤モデルで、研究や商用利用に無料で提供されています。その名前は「Large Language Model Meta AI」の略から来ています。

Llama 2はGoogleやOpenAIのLLMの代替として機能し、大量のテキストデータを学習することでさまざまな自然言語処理タスクをこなすことができます。Llama 2は、3つの異なるモデルを提供しており、それぞれ70億、130億、700億のパラメーターでトレーニングされています。

Llama 2の提供は2023年7月18日に開始され、商用利用も可能な形で無料で提供されるため、その活用範囲は広がると期待されています。Elyzaなど多くの日本語LLMもLlamaベースで開発されています。

Llamaの詳細な特徴、使い方をこちらの記事で詳しく説明していますので併せてご覧ください。

BERT

Bidirectional Encoder Representations from Transformers (BERT) は、Googleが2018 年にリリースした初期の自然言語処理の基盤モデルです。2019年には、Google検索エンジンのアルゴリズムにも採用されました。

BERTの最大の特徴は、文脈の双方向からの理解を可能にしたことです。つまり、単語の前後関係を両方向から理解することで、より正確に文脈を把握できるようになりました。

BERTは大量のテキストデータを用いて事前学習され、その後各種タスク(文章分類、質問応答、固有表現認識など)に対してファインチューニングを行うことで、高い性能を発揮します。

BERTをGoogle検索エンジンに組み込んだことで、ユーザーが入力したキーワードから検索の意図を予測し、検索精度の向上につながりました。

関連記事:「BERTとは?Googleの自然言語処理モデルが重要な理由・アーキテクチャ・メリット・活用例を徹底解説!」

Claude

ClaudeはアメリカのAnthropic社が開発した基盤モデルで、安全性が高い事が特徴のモデルです。「Constitutional AI」と呼ばれる独自の手法で学習されています。

Claudeは自然言語処理や知識推論などの分野で非常に高い能力を示しており、性能はGPT-4に匹敵するとも言われています。実際、Claude 2は数百ページのテキストや、本 1 冊分の翻訳や文章の作成ができ、上位モデルのClaude 2.1 はさらに長い文章に対応しています。

Claudeシリーズは、AIに倫理的な制約を組み込むことで、安全性と信頼性を重視して出力するための学習やファインチューニングがなされています。

T5 (Text-to-Text Transfer Transformer)

T5は、2020年にGoogleが発表した基盤モデルです。T5の特徴は、あらゆるNLPタスクを「テキストからテキストへの変換」として扱う点です。例えば、文章要約であれば、入力文章に「要約:」というプレフィックスを付けて入力し、要約文を生成します。

T5は大規模なウェブデータを用いて事前学習され、各種タスクでSOTA(特定の専門技術領域において最先端レベルを達成していること)を達成しました。また、T5はマルチタスク学習にも適しており、複数のタスクを同時に学習することで、さらなる性能向上が可能です。

PaLM

PaLMは、2022年にGoogleが発表したLLM(大規模言語モデル)です。PaLMは、5400億のパラメータを持つ超大規模モデルであり、GPT-3の10倍以上の規模を誇ります。

PaLMは、「Chain of Thought」と呼ばれる推論手法を用いることで、複雑な推論を必要とするタスクにおいても高い性能を発揮します。これは、問題解決のプロセスを言語化することで、より正確な推論を可能にする手法です。

PaLMは、言語理解や知識推論、コードの生成など、幅広いタスクで驚異的な性能を示しており、LLM(大規模言語モデル)の新たな可能性を示しました。

AI21 Jurassic

AI21 Labsが開発したLLM(大規模言語モデル)です。Jurassic-1は2021年に発表され、1780億のパラメータを持つモデルです。Jurassic-1は、文章生成、文章要約、質問応答など、多様なタスクで高い性能を示しました。

2022年には、Jurassic-Xと呼ばれる改良版が発表されました。Jurassic-Xは、Few-Shot Learningという手法を用いることで、少量のデータから効率的に学習することが可能です。これにより、特定のドメインや業界に特化したモデルを、素早く構築することが可能となりました。

AI21 Labsは、自然言語処理の研究に注力しており、Jurassicシリーズの他にも、語彙力や文章理解力を測定するツールなども提供しています。

DALL・E

DALL・E(ダリ)は、OpenAIが2021年に発表した画像生成の基盤モデルです。DALL・Eは、テキストの記述から画像を生成することが可能で、高い表現力と創造性を持っています。

DALL・Eは、大量の画像とキャプションのペアを用いて事前学習されます。この際、テキストから画像を生成するだけでなく、画像からテキストを生成する学習も行われます。これにより、テキストと画像の関係性を深く理解することが可能となりました。

DALL・Eは、2022年にアップデートされたDALL・E 2では、さらに高解像度で詳細な画像の生成が可能となっています。

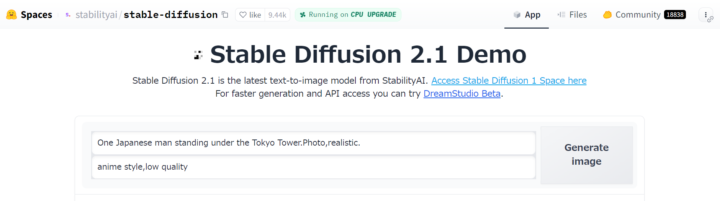

Stable Diffusion

Stable Diffusionは、Stability AIが2022年に発表したオープンソースの画像生成モデルです。Stable Diffusionは、拡散(Diffusion)モデルと呼ばれる生成手法を用いており、ノイズを徐々に除去することで画像を生成します。

Stable Diffusionは、LAION-5Bという大規模な画像データセットを用いて学習されており、テキストから高品質な画像を生成することが可能です。また、Stable Diffusionはオープンソースで公開されているため、誰でも利用・改変が可能であり、様々な派生モデルが開発されています。

CLIP

CLIP(Contrastive Language-Image Pre-training)とは、OpenAIが2021年に発表した文章と画像の組み合わせを学習した画像認識の基盤モデルです。

CLIPの大きな特徴は、ゼロショット学習の概念を画像認識AIに適応させたことです。ゼロショット学習とは、追加学習無しで新たなデータに対応できる学習方法で、自然言語処理モデルで活用される学習方法でしたが、これを画像認識で行ったのがCLIPです。

これにより、画像認識特有の膨大な学習がなくとも画像認識ができることになりました。

関連記事:「Clipとは?OpenAIのマルチモーダル基盤モデルの仕組み・活用事例・課題を徹底解説!」

Imagen

ImagenはGoogleが2022年に発表した、テキストから高解像度の画像を生成するモデルです。Imagenは、CLIPと拡散モデル(Diffusion Model)を組み合わせることで、高品質な画像生成を実現しています。

Imagenの特徴は、高い解像度(1024×1024ピクセル)の画像を生成できる点と、物体の詳細や位置関係、背景などを正確に表現できる点です。また、顔や物体の変形が少なく、自然な画像を生成することが可能です。

Imagenは、テキストから画像を生成するだけでなく、画像に対して編集指示を与えることで、画像を修正することも可能です。例えば、「猫の画像から犬に変更する」といった指示を与えると、猫の画像を犬の画像に変換することができます。

以下モデルが発表されています。

- Imagen 1

リリース時期: 2022年

特徴:Googleが初めて発表したテキストから画像を生成するモデル。高い写実性とテキスト理解能力を持つ。

用途:主に研究目的で公開され、商用利用は制限されていた。 - Imagen 2

リリース時期: 2023年

改善点:テキストプロンプトの理解力向上。

利用範囲:Vertex AIを通じて一部の企業や開発者に提供。 - Imagen 3

リリース時期:2024年

特徴:写実性、細部表現、光の表現がさらに向上、テキストレンダリング能力の強化。

各バージョンは進化を重ね、より高度な画像生成能力と安全性を備えるようになっています。Imagenは、画像生成タスクにおいて新たな可能性を示したモデルであり、今後のビジュアルコミュニケーションや、クリエイティブ分野への応用が期待されています。

Gemini

Geminiは、DeepMind社が2023年6月に発表した大規模マルチモーダル基盤モデルです。Geminiは、テキスト、画像、音声などの異なるモダリティのデータを統合的に処理することができます。

Geminiは、様々なタスクを汎用的にこなすことができるマルチモーダルエージェントを目指すものです。Geminiは、この概念を具現化したモデルと言えます。

Geminiの特徴は、以下の通りです。

- マルチモーダル性:テキスト、画像、音声など、異なるモダリティのデータを統合的に処理可能。

- 汎用性:Geminiは、質問応答、文章生成、画像認識、音声認識など、様々なタスクを汎用的にこなすことが可能。

- 少量データでの学習:Geminiは、少量のデータから効率的に学習することが可能。

- マルチリンガル:Geminiは、複数の言語を理解し、生成することが可能。

Geminiは、各種ベンチマークタスクにおいて、GPT-4やPaLMなどのLLM(大規模言語モデル)を上回る性能を達成しています。また、Geminiは、言語の壁を越えて、画像や音声も理解することができるため、より自然なコミュニケーションを可能にすると期待されています。

Geminiの登場は、AIの新たな可能性を示すものと言えます。単一のモダリティに特化するのではなく、様々なモダリティを統合的に処理することで、より汎用的で柔軟なAIの実現が期待されます。また、GeminiのようなマルチモーダルAIは、言語の壁を越えたグローバルなコミュニケーションを促進する可能性を秘めています。

貴社ニーズに特化したAI開発に強い開発会社の選定・紹介を行います

今年度AIシステム開発相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・画像認識、予測、LLM等、AI全対応

完全無料・最短1日でご紹介 AI開発に強い会社選定を依頼する

基盤モデルの課題

現状の日本企業では、基盤モデルについて以下のような課題を抱えている現状です。

日本語への対応が遅れている

現在、有名となっている基盤モデルは、GPT等の海外製基盤モデルが中心となっています。そのため、構築する際に用いられている学習データは、日本語も含まれていますが、海外の言語テキストの方が圧倒的に多くなっています。

外国テキストを多く学習していることで、日本語の細かいニュアンスや微妙な表現の違いなどを適切に理解することが難しいと言われています。実際、GPTモデルで開発されたChatGPTは、英語でのプロンプトの方が正確性が増します。

基盤モデルの日本語への対応の遅れは、日本企業が基盤モデルを活用して、様々なサービスを日本人向けに開発する際の課題となることがあるでしょう。

尚、昨今は英語ベースで構築されたオープンソースの基盤モデルLLM等を元に、日本語にファインチューニングを行うケースも出てきています。

関連記事:「楽天グループ、日本語に最適化したLLMの基盤モデル「Rakuten AI 7B」をオープンモデルとして公開」

莫大な開発費用がかかる

基盤モデルを一から開発するには開発費用が大きくなります。現在主流の基盤モデルは、GoogleやMicrosoftなどの海外のメガテック企業が中心となっています。研究開発の取り組みから、モデルの構築に必要となる学習データやノウハウの蓄積などの多くが海外のメガテック企業が寡占されている状況です。

そのため、日本語に対応した基盤モデルの研究自体が遅れており、そのような状況下で日本企業が基盤モデルを一から開発するには莫大なコストが発生するでしょう。

なぜ基盤モデルを導入するためには選び方が重要?

企業が基盤モデルを導入するには、モデルの選び方が重要になります。なぜ基盤モデルの選び方が重要なのでしょうか?

基盤モデルの数が多い

現在、公開されている基盤モデルは数十モデルあると言われていますが、その性能は様々です。基本的に、基盤モデルの性能は以下の3つで変動すると言われています。

- 訓練ステップ

- データセットサイズ

- パラメータ数

基盤モデルは、これらが大きいほど性能が高くなると言われており、選択するモデルがどれくらいのデータセット量やパラメータ数なのか、どのくらいの性能を発揮するのかを把握することは非常に重要です。

ただし、上記の数が多いから自社のユースケースに必ず合う、というわけではありません。昨今は、SLMのようにパラメータ数を少なくしても、特定の業務領域に特化して適切な出力を行うことが可能なモデルも登場してきています。そのため、自社のユースケースに沿った基盤モデルを選定することが重要です。

入出力形式が違う

基盤モデルは、言語系や画像系、プログラミング現語など入出力の形式が異なります。マルチモーダルと呼ばれるモデルは複数の形式に対応しています。

自社でどのように基盤モデルを活用したいかで選択するモデルが変わってくるため、モデルの入出力形式を確認して選ぶことが重要です。

関連記事:「AIの開発環境に必要なのは?必須のハードウェア・ソフトウェア、構築手順を徹底解説!」

ファインチューニングをする必要がある

基盤モデルは、一般的なデータセットを活用してタスクを処理する目的で行われています。

しかし、自社用にカスタマイズするには、自社や業界独自のデータセットでファインチューニングをしなければなりません。自社でファインチューニングができるのかや、ファインチューニングの操作はやりやすいのか、ファインチューニングの手順に関する情報が多いのかなど、効率よくファインチューニングをするための基盤モデルを選ぶことが重要です。

関連記事:「AI導入用APIをプラットフォーム別に紹介!各ツールの特徴を徹底解説!」

コストと性能のバランス

基盤モデルを活用することで、AI開発のコストは大幅に下げることができますが、基盤モデルの利用やファインチューニングには、オープンモデルでない限りコストが発生します。

選択する基盤モデルを使うためのコストが、それに見合う性能であるかを考慮しておくことも重要でしょう。また、XAI(説明可能なAI) を導入すれば、モデルの意思決定の透明性が向上し、リスク管理や規制対応がしやすくなります。結果として、長期的なコストパフォーマンスの最適化につながります。

関連記事:「MLOpsとは?導入すべき理由・手順・DevOps・LLMOpsとの違いを分かりやすく解説!」

貴社ニーズに特化したAI開発に強い開発会社の選定・紹介を行います

今年度AIシステム開発相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・画像認識、予測、LLM等、AI全対応

完全無料・最短1日でご紹介 AI開発に強い会社選定を依頼する

基盤モデルについてよくある質問まとめ

- 基盤モデルとは ?

基盤モデル(Foundation Model:ファウンデーションモデル)とは、大量かつ多様なデータで訓練され、多様な下流タスクに適応(ファインチューニングなど)できるAI・機械学習モデルのことをいいます。基盤モデルのわかりやすい例は「GPT-3.5」や「GPT-4」です。「GPT-3.5」や「GPT-4」は、大量で多様なテキストデータを学習しています。OpenAIは、ChatGPT で文章生成や質問応答、感情分析などのタスク(=下流タスク)を行うためにファインチューニングしました。

- 大規模言語モデルと基盤モデルの違いは?

基盤モデルとは、大量かつ多様なデータで学習され、様々なタスクに応用できる汎用的なAIモデルのことですが、大規模言語モデル(LLM)とは、基盤モデルの一種で大量のテキストデータを学習した大規模な言語モデルのことを指します。

つまり、基盤モデルは様々なタイプのデータ(テキスト、画像、音声など)を学習できる汎用モデルで、LLMはその中でもテキストデータに特化した基盤モデルということができます。

まとめ

基盤モデルとは、大量かつ多様なデータで訓練されたAIモデルで、多様な下流タスクに適応するためにファインチューニングすることが可能なAIモデルです。

基盤モデルは、データセットのサイズやパラメータ数によって性能が左右されるもので、これらが大きいほど高性能で汎用的なモデルと言えます。そのようなモデルを活用することは、従来のAI開発よりも高性能で汎用的なAIを使用できるということです。また、従来のAI開発に比べても低コストで利用できるメリットもあります。

基盤モデルは、

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp