ControlNetとは?Stable Diffusionを変える拡張機能・特徴・使い方・商用利用について徹底解説!

最終更新日:2025年07月05日

画像生成AIの進化に伴い、クリエイティブな表現を追求するユーザーにとって、より直感的で精密な制御が求められています。ControlNetは、Stable Diffusionの可能性を大幅に広げる拡張機能であり、プロンプトだけでは実現できない細かな条件を指定して画像を生成することが可能です。

この記事では、

関連記事:「Stable Diffusionとは?なぜ商用利用におすすめ?ビジネス活用方法・実際の出力例・注意点を解説!」

AI Marketでは

画像生成に強いAI開発会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

目次

ControlNetとは?

ControlNetは、Stable Diffusionの画像生成プロセスにおいて、ニューラルネットワーク技術でより詳細な制御を可能にする拡張機能です。2023年2月に発表されたこの技術は、テキストプロンプトに加えて画像や姿勢などの追加情報を入力することで、より精密で意図した通りの画像生成を実現します。

Stable Diffusionは、テキストプロンプトを入力することで画像を生成するAIモデルですが、プロンプトだけでは意図した通りの画像が生成されないことが多々あります。この時にControlNetが役立ちます。

例えば、バレリーナが片足で立ち、両腕を優雅に広げたポーズの指定や、エッフェル塔を真下から見上げた視点で描写することができます。このような、プロンプトだけでは表現することが難しい詳細な要素を画像に反映させることが可能です。

ControlNetは、Stable Diffusion Web UIに拡張機能として導入することが可能です。ユーザーは、元画像や手書きの画像を挿入し、プリプロセッサとモデルを選択することで、指定した条件に基づいた画像を生成します。

モデルの一部を追加して効率的にチューニングするLoRAは、主にモデル全体のパフォーマンス向上や特定タスクへの適応を目的としています。一方、ControlNetは既存のモデルに対して追加の条件(ポーズや構図など)を与えることで、生成される画像の細部を制御します。

ControlNetにより、生成する画像の品質や精度が向上し、より細かなイラスト制作が可能になります。

ControlNetの運営元

ControlNetの運営元は、主に以下の研究者と組織によって開発および運営されています。

- チャン・リュミン(Lvmin Zhang): ControlNetの主要な開発者であり、スタンフォード大学の博士課程に在籍しています。

- Anyi Rao: ControlNetの共同著者であり、スタンフォード大学での研究に貢献しています。

- Maneesh Agrawala: ControlNetの共同著者であり、スタンフォード大学での研究に貢献しています。

- lllyasviel: ハンドルネームで知られるチャン・リュミン氏が主導するプロジェクトで、GitHub上でControlNetの技術やモデルが公開されています。

- Mikubill: ControlNetをAUTOMATIC1111で使用するための拡張機能をオープンソースで公開している開発者です。

ControlNetの仕組み

ControlNetは、テキストプロンプトに加えて画像や姿勢などの追加情報を入力することで、より精密な制御を実現します。この条件付き画像生成の仕組みは、主に以下のステップで構成されます。

- 入力画像の準備:ユーザーは生成したい画像の元となる参考画像を用意します。これには、線画、ポーズ、深度情報などが含まれます。

- プリプロセッサの選択:ControlNetは、入力画像から特定の特徴を抽出するための特定のプリプロセッサを使用します。

- モデルの適用:抽出された特徴を基に、選択したモデルが画像生成を行います。

プリプロセッサは、入力画像から特定の特徴を抽出するための前処理を行うツールです。例えば、線画を抽出する「Canny」や、ポーズを抽出する「OpenPose」などがあります。プリプロセッサは、元画像を解析し、ControlNetが理解できる形式に変換します。これにより、特定の情報(輪郭、ポーズ、深度など)を抽出し、その情報を基に画像生成を行うことができます。

モデルは、プリプロセッサによって抽出された特徴を基に新しい画像を生成するアルゴリズムです。例えば、「control_canny-fp16」や「control_openpose-fp16」などがあります。モデルは、抽出された特徴情報を利用して、ユーザーが指定した条件に基づいた画像生成を行います。

各プリプロセッサとモデルの組み合わせは、使用目的や求める結果によって選択されます。これにより、プロンプトだけでは難しい詳細な条件を反映した画像が生成されます。

AI Marketでは

ControlNet の主要機能

ControlNetの主要機能と活用法について詳しく解説します。

線画からの画像生成

ControlNetは、線画を基にした画像生成を可能にします。Cannyプリプロセッサを使用することで、入力画像から線画を抽出し、その線画を基に新たな画像を生成します。

これにより、異なる画風やスタイルの画像を作成することができます。例えば、線画をアニメ風やリアルな絵画風に変換することが可能です。線画の抽出と色付けが一体となった機能を持つ拡張機能は多くありません。

他にも、Scribbleプリプロセッサでは手書きの線画から高品質な画像を生成することができます。手書きのスケッチをアート作品に変換したり、漫画のキャラクターをリアルな人物画に変換することができます。

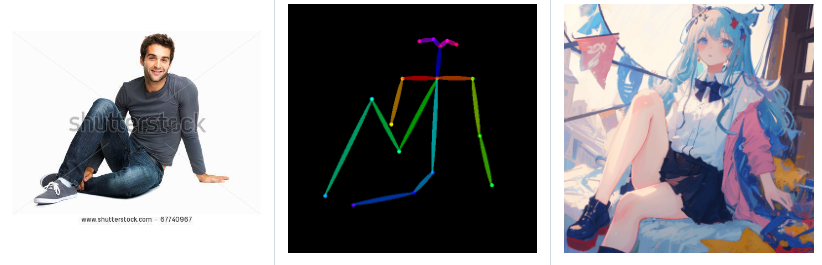

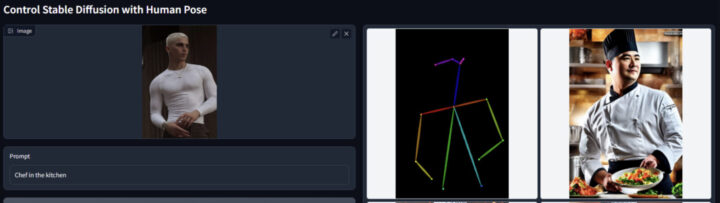

ポーズ指定による人物生成

Openposeプリプロセッサを使用することで、特定のポーズを持つ人物画像を生成できます。ユーザーは、入力画像からポーズ情報を抽出し、そのポーズを基にした新しい画像を生成します。

この機能により、ダンスの動きやスポーツの瞬間など、特定の姿勢を持つキャラクターを詳細に描写することが可能です。例えば、チアリーダーのポーズを取り入れたキャラクターを生成したり、ヨガのポーズを取る人物の画像を作成できます。プロンプトのみ、または他の拡張機能を使っても、Openposeほどの詳細なポーズ指定は困難です。

立体画像の生成

Depthプリプロセッサを使用することで、入力画像から深度情報を抽出し、立体感のある画像を生成できます。この機能により、風景や建築物の画像において、奥行きや立体感を強調したリアルな描写が可能となります。

具体的な活用例として、山岳地帯の風景をより立体的に表現したり、建物の内部を透視したような視点で描写することができます。深度情報を利用した立体感のある画像生成を、ここまで簡単にできる拡張機能はControlNetのほかにはほとんどありません。

構図の指定

特定の構図やレイアウトを指定することで、意図した通りの画像を生成できます。例えば、特定のポーズやアングルを持つ画像を生成することができます。

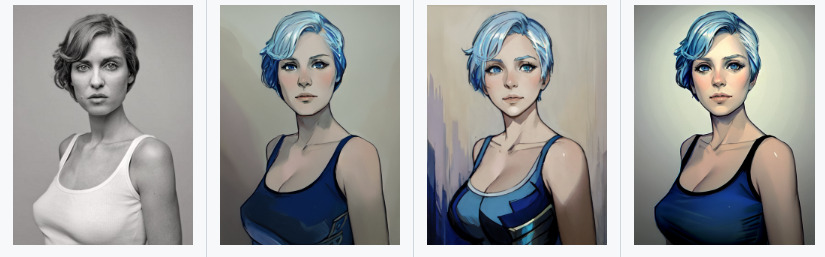

スタイルの変更

Referenceプリプロセッサでは、参照画像のスタイルや色彩を保持しつつ、新しい要素や変化を加えた画像を生成することができます。元画像の特徴を維持しながら、異なるスタイルや画風に変換することが可能です。例えば、同じ人物の画像を異なる時代背景や文化に合わせて再現することができます。

部分的な修正

画像の一部を修正することで、特定の部分だけを変更したり、背景を変更したりすることができます。これにより、細部にこだわった画像生成が可能です。例えば、広告用に特定の製品を強調したり、背景を季節に合わせて変更することができます。

Stable Diffusionで使用するControlNet の代表的なプリプロセッサ

ControlNetは、Stable Diffusionの画像生成プロセスにおいて、ユーザーが特定の条件を指定することで、より精密な制御を可能にする拡張機能です。ここでは、ControlNetの代表的なプリプロセッサについて詳しく解説します。

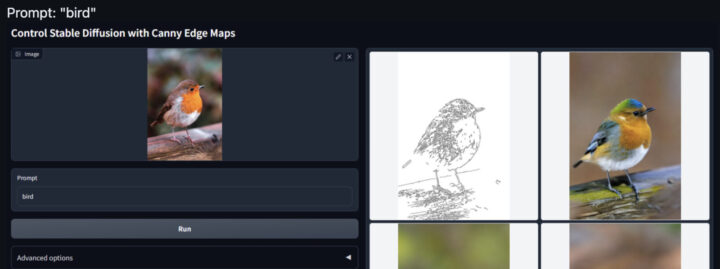

Canny

Cannyは、Canny edge detectionというアルゴリズムを使用して、入力された画像から線画情報を抽出します。そして、その線画に基づいて新しい画像を生成するプリプロセッサです。このプリプロセッサは、元の画像の構図や詳細なディテールを保持しながら、色やスタイルを変更することが可能です。

元画像の髪の色だけを変えたい、服の色を変えたいなど、部分的な変更を加えたい場合に最適です。

例えば以下の画像では、鳥の画像の構図を線画で抜き出した上で、背景などを変更しています。

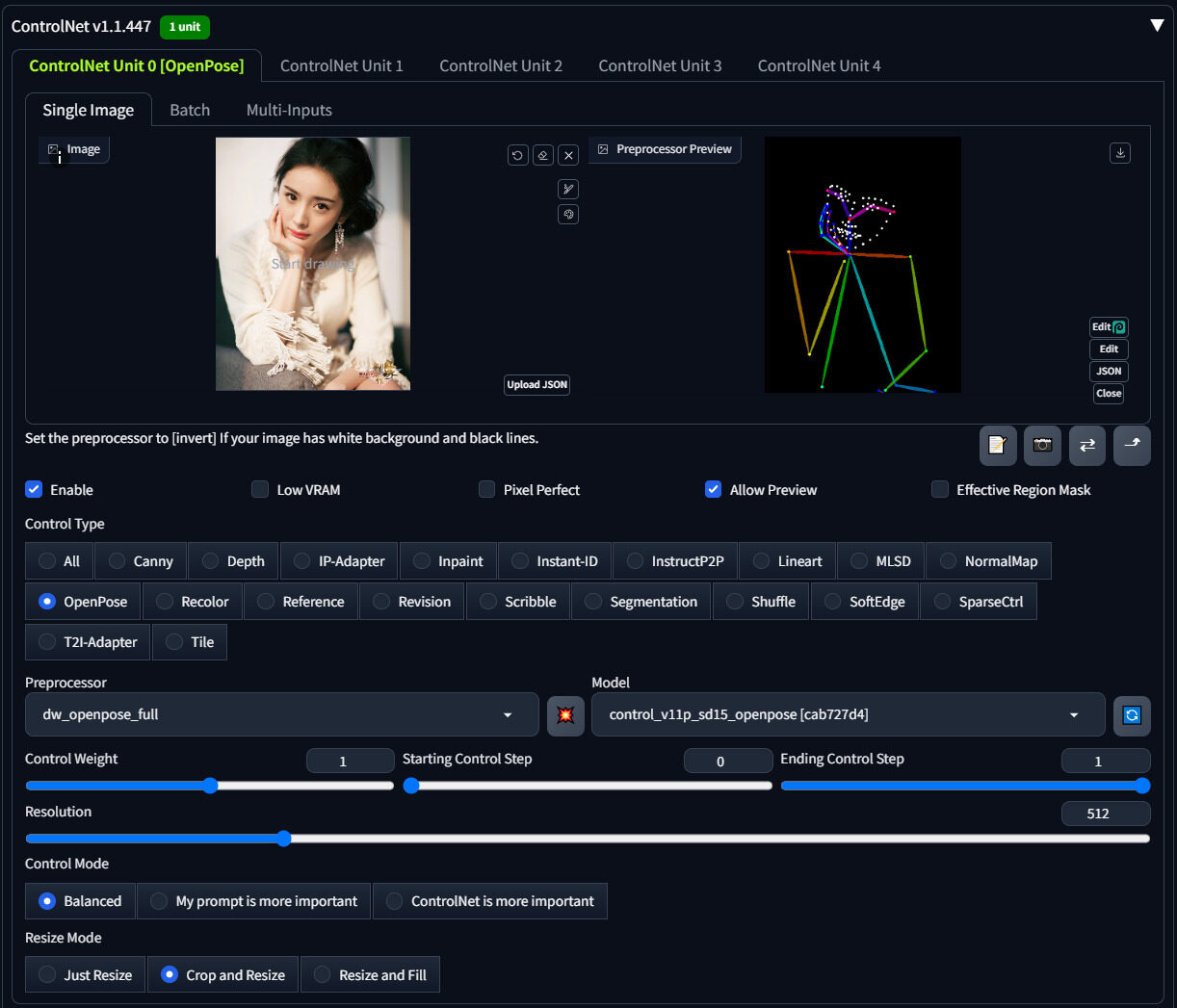

OpenPose(Human Pose)

Openpose(Human Pose)は、人物のポーズを指定して画像を生成するモデルです。Openposeプリプロセッサを使用して、入力画像からポーズ情報を抽出し、その情報を基に新しい画像を生成します。

アニメーションやゲームキャラクターのデザイン、広告用のモデルポーズ指定など、特定のポーズを持つ画像が必要な場合に最適です。

Reference_only

Reference_onlyは、元画像の特徴を保持しながら、服装や背景、画風を変更するモデルです。このモデルは、元画像の顔や重要な特徴を維持しつつ、新しいスタイルや要素を追加することができます。

同一人物の画像を様々なパターンで生成したい場合や、特定のキャラクターの服装や背景を変更したい場合に使われます。

tile_resample

tile_resampleは、元の画像を高品質・高解像度にアップスケールするモデルです。このモデルは、画像の細部を補正しながら、解像度を高めることができます。

高解像度のポスターや広告用画像の作成、詳細なディテールが求められるデザイン作業などに適しています。

Depth

Depthは画像の深度情報を抽出します。元画像の奥行きを表現したい時に使用されます。例えば、体の重なりなどを描写する時に有効です。

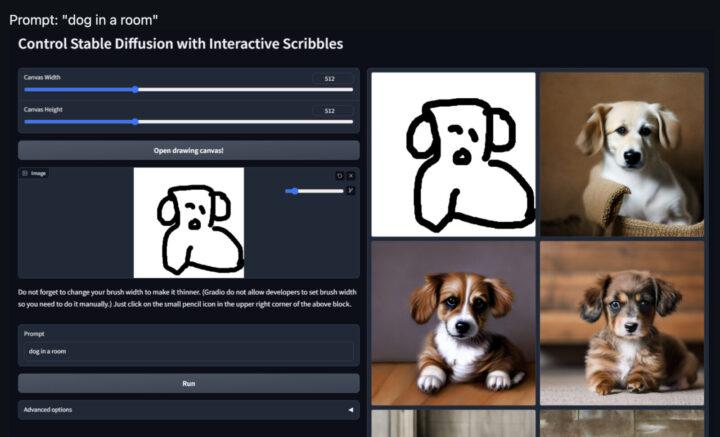

Scribble

Scribbleは手書きのようなラフ画からイラストを生成します。大まかな構図や配置を指示したい時に使用されます。自作のラフな落描きから詳細なイラストを生成することが可能です。

Lineart

Lineartはイラストから線画を抽出します。線画の画像を使って色塗りができるようになります。アニメ風やリアル風など、異なるスタイルで線画を生成できます。

Soft Edge (HED)

Soft Edge (HED)はイラストの線画を忠実に抽出します。cannyやlineartよりも細かな線を抽出し、元画像と似せて生成する際に使用されます。

ControlNet を Stable Diffusion で使い始めるまでの手順

ControlNetをStable Diffusionで使用するための手順について説明します。以下の手順に従って、インストールから基本的な設定と操作方法までを確認してください。

インストール方法

ControlNetのインストールは、AUTOMATIC1111のStable Diffusion WebUIを使用することが一般的です。以下の手順に従ってインストールを行います。

- Stable Diffusion WebUIを起動し、メイン画面にアクセスします。

- 画面上部の「Extensions」タブをクリックします。

- 「Install from URL」タブをクリックします。

- GitHub上のControlNetページで、「Install」ボタンをクリックします。

- インストールが完了したら、「Installed」タブを開き、ControlNetがリストに表示されていることを確認します。

- 「Apply and restart UI」ボタンをクリックして、WebUIを再起動します。

基本的な設定と操作方法

ControlNetをインストールした後、基本的な設定と操作方法について説明します。

- ControlNetの有効化

「txt2img」または「img2img」タブを開き、ControlNetセクションが表示されていることを確認します。

「Enable」チェックボックスをオンにします。 - 使用したい機能に応じて、PreprocessorとModelを選択

例えば、線画から画像を生成する場合は「Canny」を選択します。 - 入力画像のアップロード

必要に応じて、detectmapを入力することもできます。その場合、Preprocessorを「none」に設定します。 - 必要な追加設定を行う

「Low VRAM」:8GB以下のグラフィックボードを使用している場合はチェックを推奨します。

「Pixel Perfect」:入力画像と出力画像の解像度が異なる場合に、解像度を自動で調整します。詳細な描写を保持するために有効です。

「Allow Preview」:Preprocessorのプレビューを許可します。プレビューアイコンをクリックするとdetectmapが確認できます。 - 「Generate」ボタンをクリックして画像生成を開始します。

これらの手順を通じて、ControlNetを活用した精密な画像生成が可能となります。

ノードUIで拡張性の高いComfyUIでも、ControlNet Preprocessors for Comfyという拡張機能を用いることで画像生成の前処理を行います。これにより、特定のヒント画像を生成し、生成プロセスを制御できます。

ControlNet の現状課題と商用利用の可能性

ControlNetは、Stable Diffusionの画像生成能力を大幅に向上させる技術ですが、その現状と将来の展望についても理解しておくことが重要です。ここでは、現在の技術的制約と今後の課題について詳しく解説します。

- 計算リソースの要求: 高解像度の画像生成には高性能なGPUが必要です。

- 複雑な設定: 初心者には設定が難しく、適切なモデルやプリプロセッサの選択が必要です。

- 商用利用の制約: 著作権や使用許諾に注意が必要で、商用プロジェクトでは慎重な対応が求められます。

Mikubillの提供するControlNetは、GPL-3.0ライセンスの下で提供されており、商用利用が可能です。GPL-3.0ライセンスは商用利用を禁止していないため、ControlNetを使用した製品やサービスの開発、販売が許可されています。ただし、実際には各プリプロセッサ、及びモデルで設定されたライセンスの要件を満たす必要があります。

例えば、BRIA 2.3 ControlNet-Background Generationモデルは、ライセンスされたデータセットのみを使用して訓練されており、商用利用が安全であるとされています。また、ControlNet内で提供されているOpenPose機能もApache-2.0ライセンスの下で提供されており、商用利用が可能です。このライセンスは商用利用を許可しており、追加のライセンス料は発生しません。

まとめ

ControlNetの導入により、Stable Diffusionを用いたオープンソースの下での画像生成の可能性は飛躍的に広がりました。企業やクリエイターは、この技術を新規事業の開発や既存プロジェクトの効率化に活用することを強くお勧めします。広告やデザイン分野において、より精密で意図通りのビジュアルを迅速に生成し、競争力を高めることが可能です。

また、ControlNetの進化に伴い、今後さらに多様な入力条件や出力結果が実現されることが期待されます。これを機に、企業は

AI Marketでは

ControlNetについてよくある質問まとめ

- ControlNetとは何ですか?

ControlNetは、Stable Diffusionの画像生成プロセスにおいて、ニューラルネットワーク技術でより詳細な制御を可能にする拡張機能です。テキストプロンプトに加えて画像や姿勢などの追加情報を入力することで、より精密で意図した通りの画像生成を実現します。

- ControlNetの主要機能は何ですか?

ControlNetの主な機能には、線画からの画像生成、ポーズ指定による人物生成、立体画像の生成、構図の指定、スタイルの変更、部分的な修正などがあります。これらの機能により、ユーザーはより細かく画像生成を制御できます。

- ControlNetの代表的なプリプロセッサには何がありますか?

代表的なプリプロセッサには、Canny(線画抽出)、OpenPose(ポーズ指定)、Reference_only(特徴保持)、Depth(深度情報抽出)、Scribble(ラフ画からの生成)、Lineart(線画抽出)などがあります。各プリプロセッサは異なる特徴を抽出し、画像生成に活用します。

AI Marketの編集部です。AI Market編集部は、AI Marketへ寄せられた累計1,000件を超えるAI導入相談実績を活かし、AI(人工知能)、生成AIに関する技術や、製品・サービス、業界事例などの紹介記事を提供しています。AI開発、生成AI導入における会社選定にお困りの方は、ぜひご相談ください。ご相談はこちら

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

弊社代表 森下𝕏:@ymorishita

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp