Meta社がLlama 4モデル群を発表、ネイティブマルチモーダルAIを開始

最終更新日:2025年04月07日

記事監修者:AI Market ニュース配信チーム

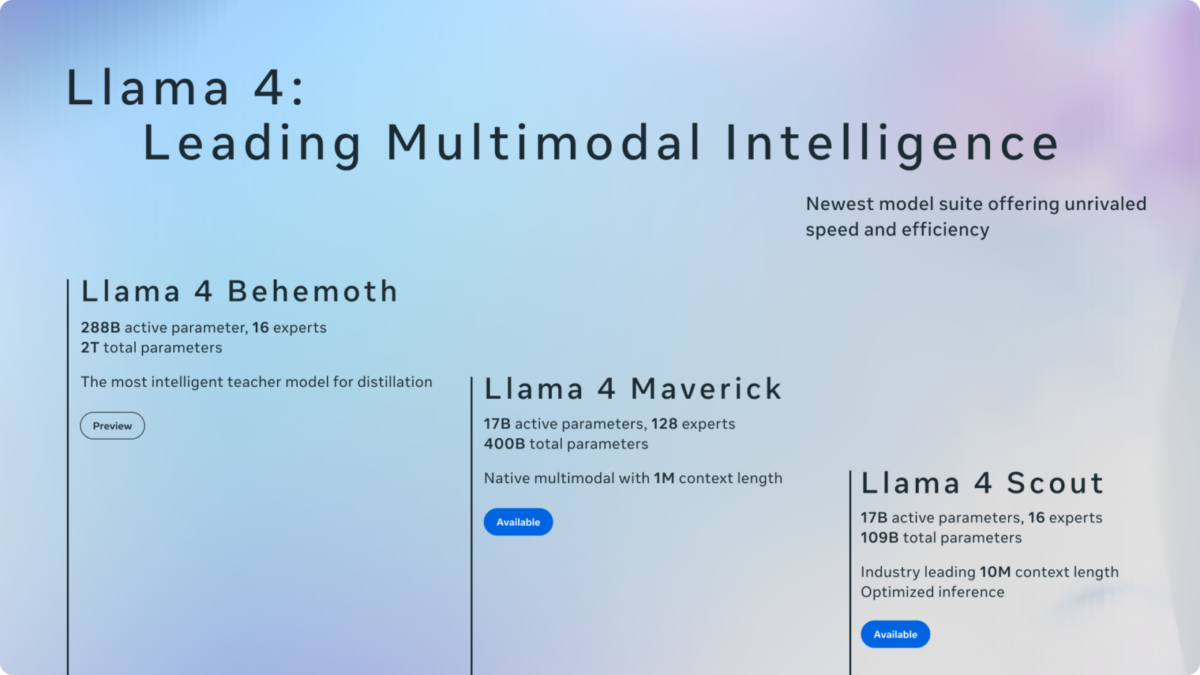

Metaは2025年4月5日(現地時間)、同社初のネイティブマルチモーダルかつMoE(Mixture of Experts)アーキテクチャを採用したLlama 4モデル群を発表した。

Llama 4 ScoutとLlama 4 Maverickの2モデルが公開され、現在も開発中の最上位モデルLlama 4 Behemothの詳細も明らかにされた。

- Llama 4 ScoutとLlama 4 Maverickは世界初のオープンウェイトのネイティブマルチモーダルMoEモデルであり、同クラス最高性能を実現

- Llama 4 Scoutは17B活性パラメータで業界最長の1000万トークンのコンテキストウィンドウをサポートし、単一のNVIDIA H100 GPUで動作可能

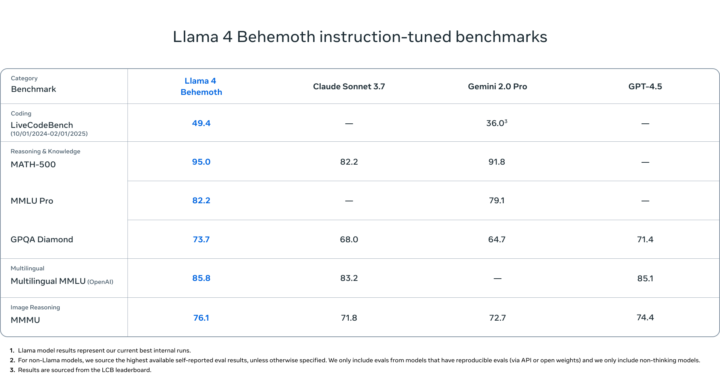

- 研究中のLlama 4 Behemothは288B活性パラメータの教師モデルで、複数のSTEMベンチマークでGPT-4.5やClaude Sonnet 3.7を上回る性能を発揮

Metaは2025年4月5日、同社の最新大規模言語モデル「Llama 4」シリーズの最初のモデルとなる「Llama 4 Scout」と「Llama 4 Maverick」を発表した。

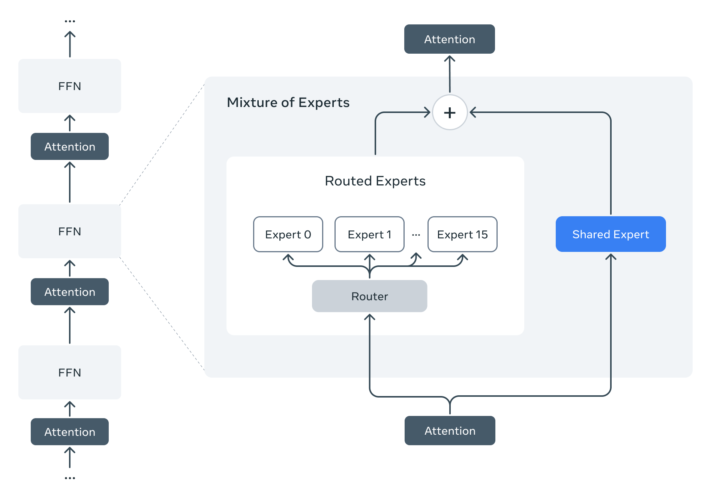

これらはMetaにとって初めてのネイティブマルチモーダル(テキストと画像の統合処理が可能)なモデルであり、MoE(Mixture of Experts)アーキテクチャを採用している点が特徴だ。

Llama 4 Scoutは17B(170億)の活性パラメータと16エキスパートを持ち、単一のNVIDIA H100 GPUで動作可能なサイズながら、業界最長となる1000万トークンのコンテキストウィンドウをサポートする。

一方、Llama 4 Maverickも17Bの活性パラメータだが128エキスパートを持ち、総パラメータ数は400Bに達する。MoEアーキテクチャにより、すべてのパラメータがメモリに保存されるが、トークン処理時に活性化するのは一部のみとなり、推論効率が向上している。

両モデルの特筆すべき技術的特徴として、ネイティブマルチモダリティのためのearly fusion手法の採用がある。これにより、テキスト、画像、ビデオのトークンをモデルのバックボーンに統合できるようになった。

また、MetaCLIPをベースにした改良版ビジョンエンコーダーを搭載し、LLMとの連携を強化している。前処理段階では200言語を対象とし、そのうち100言語以上が10億トークン以上のデータで学習されており、Llama 3と比較して多言語トークンは10倍に増加した。

モデルの学習効率を高めるためにFP8精度を使用し、質を犠牲にすることなく高いモデルFLOPs利用率を確保している。Llama 4 Behemothモデルの事前学習ではFP8と32K GPUを使用し、GPU当たり390TFLOPsを達成した。

Metaは現在、これらのモデルの教師役となる「Llama 4 Behemoth」も開発中だと発表した。

これは288Bの活性パラメータと16エキスパートを持ち、総パラメータ数は約2兆に達する同社最強のモデルだ。

Llama 4 BehemothはGPT-4.5、Claude Sonnet 3.7、Gemini 2.0 Proなどの競合モデルを数学やマルチ言語、画像理解などのベンチマークで上回るとしている。

この巨大モデルから知識を蒸留することで、より小型でありながら高性能なLlama 4 ScoutとLlama 4 Maverickが実現された。

これらのモデルは即日からllama.comとHugging Face上でダウンロード可能となり、WhatsApp、Messenger、Instagram Direct、Meta.AIウェブサイトなどでもMeta AIとして利用できる。

AI Market の見解

Metaの今回のLlama 4シリーズの発表は、LLM市場における競争をさらに加速させる重要な動きと言える。

特に注目すべきは、MoE(Mixture of Experts)アーキテクチャを採用することで、比較的小さな活性パラメータ数ながら高い性能を実現している点である。

この技術により、従来よりも少ないコンピューティングリソースで高度なAIモデルを実行可能となり、クラウドプロバイダーや企業のコスト削減に貢献すると想定される。

また、業界最長の1000万トークンのコンテキストウィンドウをサポートする機能は、多文書要約や大規模コードベースの分析など、これまで困難だった応用を可能にする。オープンな形でこれらのモデルを提供するMetaの戦略は、AIの民主的な利用促進と同時に、同社のエコシステム強化にも寄与すると考えられる。

競合他社のモデルを複数のベンチマークで上回るという主張は、独立した検証が待たれるものの、オープンソースモデルの技術的進化が加速していることを示している。

参照元:Meta

Llama 4に関するよくある質問まとめ

- Llama 4モデルはどこでダウンロードできますか?

Llama 4 ScoutとLlama 4 Maverickモデルは、llama.comとHugging Faceでダウンロード可能です。また、近日中に主要なクラウドプラットフォーム、エッジシリコン、グローバルサービスインテグレーターからも利用できるようになる予定です。

すでにWhatsApp、Messenger、Instagram Direct、Meta.AIウェブサイトでMeta AIとしての利用が開始されています。

- Llama 4モデルの主な特徴は何ですか?

Llama 4モデルの主な特徴は、ネイティブマルチモーダル機能(テキストと画像の統合処理)、MoE(Mixture of Experts)アーキテクチャによる効率的な推論、そして特にLlama 4 Scoutの1000万トークンという長大なコンテキストウィンドウです。

また、200言語の事前学習、画像理解能力、安全対策の強化なども重要な特徴といえます。

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp