Gemma 2とは?特徴・メリット・デメリット・活用分野を徹底紹介!

最終更新日:2025年10月04日

2024年6月27日、Googleが提供するGemini基盤のオープンソースAI(人工知能)モデル「Gemma(ジェマ)」の新バージョン「Gemma 2」が登場しました。従来モデルと比較して、パフォーマンスと推論効率が大幅に向上し、生成AI開発を一層加速させると期待されています。

本記事では、Gemma 2の特徴や前モデルなどの基本情報を解説するとともに、メリットやデメリット、活用分野を紹介します。Gemma 2に興味を持っている方、もしくはオープンソースのAIモデルに関心のある方は、ぜひ最後までご覧ください。

なお、Gemma 2の基盤ともなる「LLM(大規模言語モデル)」とは何か?基本的な仕組みとその重要性についてはこちらで解説していますので、併せてご覧ください。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

ChatGPT/LLM導入・カスタマイズに強いAI開発会社を自力で選びたい方はこちらで特集していますので併せてご覧ください。

目次

Gemma 2とは?

Gemma 2とは、生成パフォーマンスと推論効率を両立するように設計されたSLM(小規模言語モデル)です。2024年6月27日にGoogle社からリリースされました。

2025年3月に登場したGemma 3の前バージョンです。

SLMとは、LLM(大規模言語モデル)よりもサイズが小さく軽量化された言語モデルです。Microsoftの提供するPhi-3もSLMで、SLMのGemma 2はリソース効率が良い点も特徴です。

Googleの生成AIモデルの柱であるGeminiと同じ研究技術を基に開発されており、大規模な事前学習済みモデルを引き継ぐ「知識蒸留」の採用により、第1世代よりも高性能な推論が可能になったうえに、クラウド環境からローカル環境まで幅広いハードウェアに対応できるようになりました。

さらに、より信頼性の高い学習データの選別や人間のフィードバックを強化学習へ取り入れることで、回答の安全性を高めています。

Gemmaファミリーには、汎用的な性格のGemmaのほかに、コード生成に特化したCodeGemma、プライバシー保護を特色としたVaultGemmaなどがあります。

Gemma 2の特徴

Gemma 2の主な特徴は、以下のとおりです。

- オープンソースモデル

- 軽量

- 無料利用可能

Gemma 2はオープンソースモデルであり、企業は自社のニーズに合わせて生成AIシステムの開発へ自由に利用できます。

関連記事:「オープンソースLLMを徹底比較!特徴・活用メリット・代表モデルの比較ポイントも解説」

また、現在提供されている20億(2B)、90億(9B)、270億(27B)パラメータのモデルは、どれもChatGPTなどのクローズドモデルに比べて軽量であり、ローカル環境や小規模なシステムでも動かせる点が強みです。

セキュリティ強化やカスタマイズ性向上の観点から、オープンソースLLM、軽量化、は2024年でLLM市場におけるトレンドとなっており、今後も更に進化していくと想定されます。

尚、KaggleやGoogle Colabの無料枠を通じて利用できる点も大きなメリットで、開発コストを抑えられます。また、Google AI Studioで無料で27Bモデルをフル性能で利用可能です。

性能

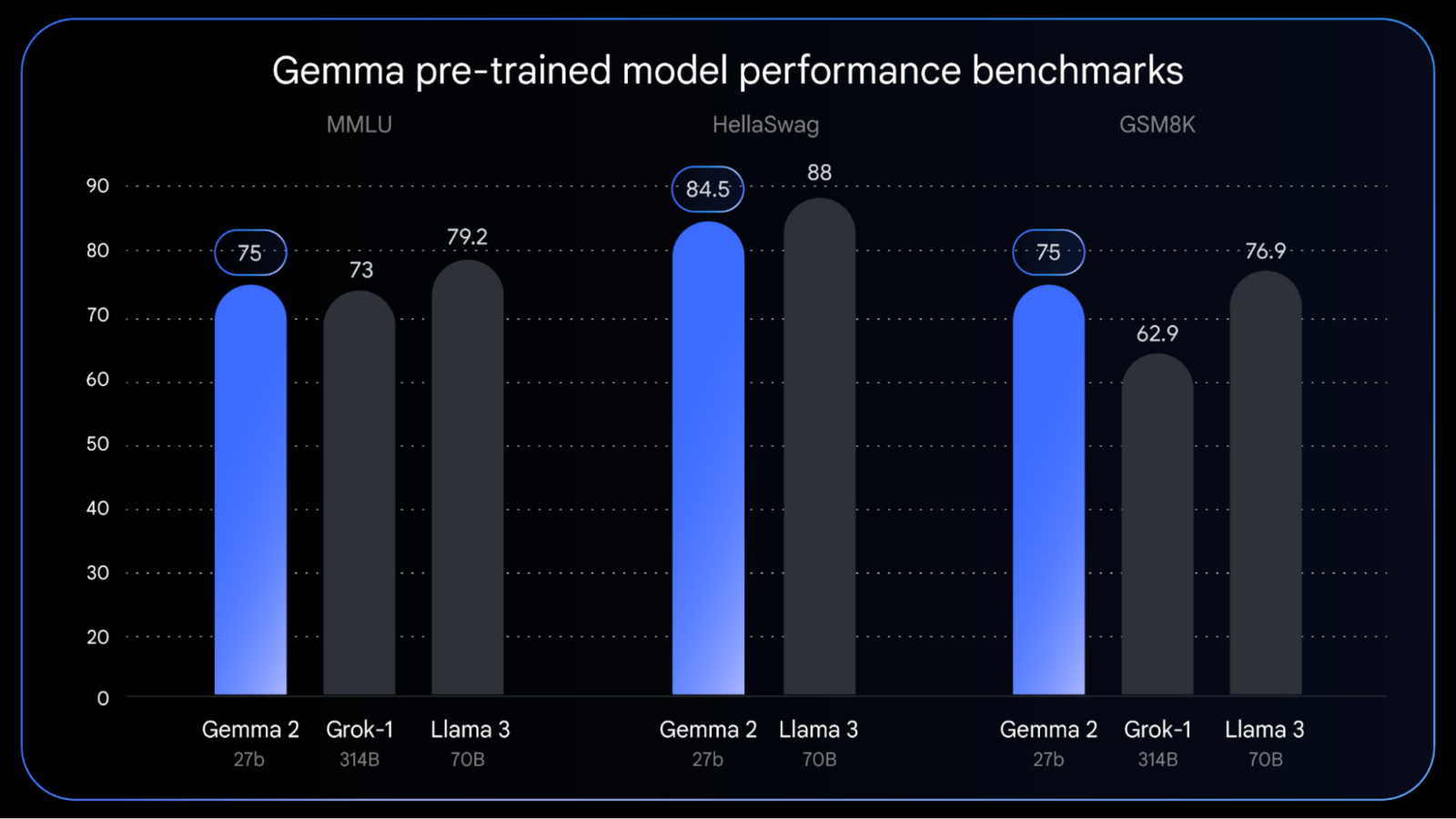

Gemma 2の各モデルは、さまざまな評価で優れた性能を示しています。

例えば、Gemma 2の27Bは、Hugging Faceの評価スイートにおいて、同カテゴリ内のLLaMA-3 70Bなどはるかに大きなLLMと比較して遜色ないパフォーマンスを発揮しています。

また、Gemma 2の2B・9Bモデルは、同サイズ程度のLLaMA 3 8Bを上回るパフォーマンス向上に成功しました。

「複数ターンの対話評価」においても、Gemma 2の2B・9B・27Bすべてが従来バージョンのGemma 1.1と比較して、ユーザー満足度と会話の達成度で優れていると評価されています。「複数ターンの対話評価」は、人間の評価者にモデルとの会話をさせ、指定されたシナリオに従わせて性能を評価するベンチマークです。

商用利用について

Gemma 2は、前バージョン同様、「Apache License 2.0」に基づいて商用利用が可能です。そのため企業は自由にGemma 2の各モデルを活用し、独自の生成AIアプリケーションを構築できます。

KaggleやHugging Face Modelsからモデルの重みをダウンロード可能です。

Geminiとの違い

GeminiとGemma 2は、扱えるデータの種類に大きな違いがあります。

まずGeminiとは、テキストのほかに、画像や音声など複数のデータ形式を統合して処理できる高性能なマルチモーダルAIです。2024年12月にはGemini2.0が発表されました。

例えば、マルチメディアコンテンツの生成や複数のセンサー情報を組み合わせたAI分析など、複雑で多様なデータを扱うビジネスアプリケーションに向いています。

一方、Gemma 2は言語処理に特化した小規模言語モデルで、軽量なタスクに最適化されています。Geminiに比べて、パラメータサイズが小さく、計算リソースをあまり消費しないため、文章生成やチャットボットなど特定の言語タスクや中小規模のプロジェクトに適しています。

関連記事:「Geminiに関する概要から特徴、同じ対話型AIのChat GPTとはどう違うのか、将来性、さらには業界別の具体的な活用事例まで徹底解説」

Googleは以下のようなAIモデル開発で培った技術を基盤に発展させ、Geminiのために最新研究の成果を統合しています。

BERT

PaLM 2

Gemma 2

DataGemma

Google Bard

LaMDA

Duet AI

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Gemma 2の5つのメリット

Gemma 2はリソースやコスト、セキュリティ面で多くのメリットがあります。以下では、Gemma 2のメリットを紹介します。

推論効率が高い

Gemma 2は、同規模のパラメータ数を持つ他のモデルと比較して、推論効率が高い点が大きなメリットです。特に、LLaMA-3 70Bなど2倍以上のパラメータ数を持つモデルに匹敵する推論効率を誇り、リソースを抑えつつ高精度な推論が可能です。

9Bモデルも、同サイズの他社オープンモデル(例:LLaMA 3 8B)を上回る性能を示しています。さらに、2Bモデルも、GPT-3.5モデルをChatbot Arenaで上回る性能を示し、エッジデバイスでの利用も可能です。

Gemma 2を採用することで、計算リソースが限られている場合でも、高性能な推論ができるLLMサービスの提供が可能となります。

少ない計算リソースでも開発可能

Gemma 2の27Bモデルでは、以下のような比較的少ない計算リソース環境で開発が可能なように設計されています。

- 単一のGoogle Cloud TPUホスト

- NVIDIA A100 80GB Tensor Core GPU

- NVIDIA H100 Tensor Core GPU

そのため、従来のモデルよりも効率的に動作し、計算リソースを最適化するため、企業のAI開発にかかるインフラコストを抑えられます。ゲーミングノートPCから高性能デスクトップPC、クラウド環境まで、様々なハードウェア構成で高速に動作するよう最適化されています。

導入コストを削減できる

Gemma 2は、Googleのクラウドプラットフォーム「Vertex AI」で利用可能であり、クラウド環境での導入により初期コストを大幅に削減できます。Vertex AIは、機械学習環境が整っているため、インフラ整備にかかる時間やコストが削減され、迅速な導入が可能です。

また、以下に挙げる主要なAIフレームワークと互換性があります。

- Hugging Face Transformers

- PyTorch

- TensorFlow(Keras 3.0経由)

- vLLM

- JAX

- Gemma.cpp

- Llama.cpp

- Ollama

特に、小規模な開発や試験的に利用したい企業にとって、導入コストを抑えながら活用できるのは大きなメリットです。

関連記事:「Vertex AIの機能や料金、導入するメリットを解説」

安全性が高い

Gemma 2は、学習する際に、潜在的な偏見やリスクを最小限に抑えるための厳格な安全プロセスが実装されています。具体的には、事前トレーニングデータのフィルタリングを行い、CSAMフィルタリング(児童性的虐待コンテンツの排除)や、特定の個人や組織におけるセンシティブデータの保護が適用されています。

これにより、有害・違法なコンテンツが除外された信頼性・安全性の高い回答が可能となり、ビジネスでの商用利用においても安心して導入できます。

カスタマイズ性が高い

Gemma 2は、効率的なファインチューニング手法であるLow Rank Adaptation(LoRA)を完全にサポートしています。LoRAにより、トレーニング可能なパラメータ数を大幅に削減できます。パラメータ数の削減により、学習速度が向上します。

また、LoRAのランク(通常4〜16の範囲)を調整することで、モデルの適応能力と計算効率のバランスを取ることができます。

Gemma 2のデメリット

Gemma 2には開発面でさまざまなメリットがある一方で、利用上のデメリットがいくつかあります。以下では、Gemma 2のデメリットについて紹介します。

日本語の対応力が低い

Gemma 2は主に英語のデータセットでトレーニングされているため、日本語の対応力が低いのが大きな課題です。日本語のプロンプトでは細やかなニュアンスや文脈が理解されず、十分な回答を得られない可能性があります。

特に、皮肉や慣用句などの言語の微妙な特徴を理解することが難しいようです。これは、自然な会話や文学的なテキストの解釈において制限となる可能性があります。

そのため、日本市場向けのアプリケーションや日本人ユーザー向けのサービスを提供する場合には、モデルを日本語向けにチューニングする必要があります。

ハルシネーションのリスクがある

他のLLMと同様に、Gemma 2にもハルシネーション(事実と異なる情報を生成してしまうリスク)が存在します。これは、モデルが未確認の情報や不正確な情報でも自信を持って生成してしまう現象です。

特に、クリティカルなビジネスシーンでの利用においては、生成された出力に対する人間による検証プロセスを導入し、ハルシネーションによる誤情報の影響を最小限に抑える対策が求められます。

コンテキスト理解の限界

長文や複雑なコンテキストを必要とするタスクでは、理解や一貫性の維持に課題がある可能性があります。これは、長期的な対話や複雑な文書解析において制限となる可能性があります。

また、技術的なタスクでは優れた性能を示しますが、複雑な推論や現実世界の深い理解を必要とするタスクでは苦戦する傾向があります。学習データや設計が技術的な領域に特化していることが原因だと思われます。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Gemma 2の使い方

Gemma 2は、さまざまなプラットフォームで簡単に利用を開始できます。

| 活用シーン | おすすめプラットフォーム | プラットフォームの特徴 |

|---|---|---|

| 手軽にGemma 2の性能を試したい | Google AI Studio |

|

| モデルのカスタマイズや微調整をしたい | Hugging Face |

|

| AIプロジェクトの実験を行いたい | Kaggle |

|

| 小規模なプロジェクトや実験でクラウドベースの開発環境が必要 | Google Colab |

|

| 商用AIサービスの開発 | Google Cloud Vertex AI |

|

Google AI Studioでは、特別なハードウェア要件を気にせずに、無料でGemma 2の性能を試せます。現在2B・9B・27Bの3つのモデルが利用可能で、Gemma 2を利用したい場合はもちろん、それぞれの違いを比較したい場合にもおすすめのプラットフォームです。

KaggleやGoogle Colabといった無料の開発環境でも、Gemma 2を使ったモデルの試用や開発が可能です。一方本格的な商用利用には、Google Cloudの「Vertex AI」がおすすめです。

Gemma 2の活用分野

Gemma 2は、軽量かつ高パフォーマンスなことから、さまざまなシーンでの活用が期待されます。以下では、Gemma 2の主な活用分野を紹介します。

- コーディングタスク:プログラミングコードの生成・補完からバグの修正、コード最適化の提案

- 数学・科学計算:複雑な数式の解析、シミュレーション支援

- データ分析:大規模データセットの分析、パターン認識、予測モデリング

- カスタマーサポートや質疑応答システム向けのチャットボット:自社の業種やサービスに特化したチャットボットを構築

- エッジAI:リアルタイムでの画像認識や異常検知が必要な産業用IoTデバイス

精度向上とハルシネーションの軽減を目的として「Gemma 2 27B」をベースに開発されたDataGemmaも発表されています。Google が公開しているナレッジ グラフ「Data Commons」と呼ばれる2,400億以上の膨大な統計データポイントがある知識グラフを参照し、信頼性の高いデータに基づいた数値情報や統計情報の回答を生成できる点が大きな特徴です。

関連記事:「DataGemmaの仕組みやメリット・デメリット、そして企業での活用方法を徹底的に紹介」

Gemma 2についてよくある質問まとめ

- Gemma 2はどのような分野で活用できますか?

Gemma 2は、コーディングタスク、チャットボット、Webコンテンツ制作、エッジAIなど、さまざまな分野で活用可能です。特に、自然言語処理やテキスト生成、軽量な推論タスクに強みがあります。

- Gemma 2は商用利用できますか?

はい、Gemma 2はApache License 2.0に基づいており、商用利用が可能です。企業は自社のニーズに合わせて自由にカスタマイズし、商用プロジェクトに活用できます。

まとめ

カスタマイズ性が高く、少ないリソースで高い推論効率を実現できる点がメリットです。一方で、日本語対応の弱さやハルシネーションのリスクといった課題もあります。

適切な導入と調整を行うことで、コーディングタスクやチャットボット、エッジAIなど、さまざまな分野で業務の自動化と効率化に貢献します。この機会にGemma 2を導入し、ビジネスの競争力をさらに高めましょう。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp