LLMの処理コストが急激に低下、年率90%減の「LLMフレーション」現象がAI革命を加速するとa16zが報告

最終更新日:2024年11月13日

a16zは2024年11月12日(現地時間)、LLM(大規模言語モデル)の推論処理コストが急激に低下している現象「LLMフレーション」を報告した。

この現象は、PC革命時のムーアの法則やドットコムブーム時のエドホルムの法則を上回るペースで進行しており、同等の性能を持つLLMの処理コストが年率で10分の1に低下していることが明らかになった。

この劇的なコスト低下は、新たなAIユースケースの創出を促進し、AI革命の更なる進展を示唆している。

目次

<本ニュースの10秒要約>

- GPT-3発売以降、LLMの処理コストが3年間で1,000分の1まで低下し、年率90%減の急激な価格下落傾向を示す現象を確認

- GPU性能向上、モデル量子化、ソフトウェア最適化、小規模モデルの性能向上など、複数の要因が価格低下を実現

- コスト低下により、音声アシスタントやコード処理など、これまで採算が取れなかった新たなAIアプリケーションの実用化が可能に

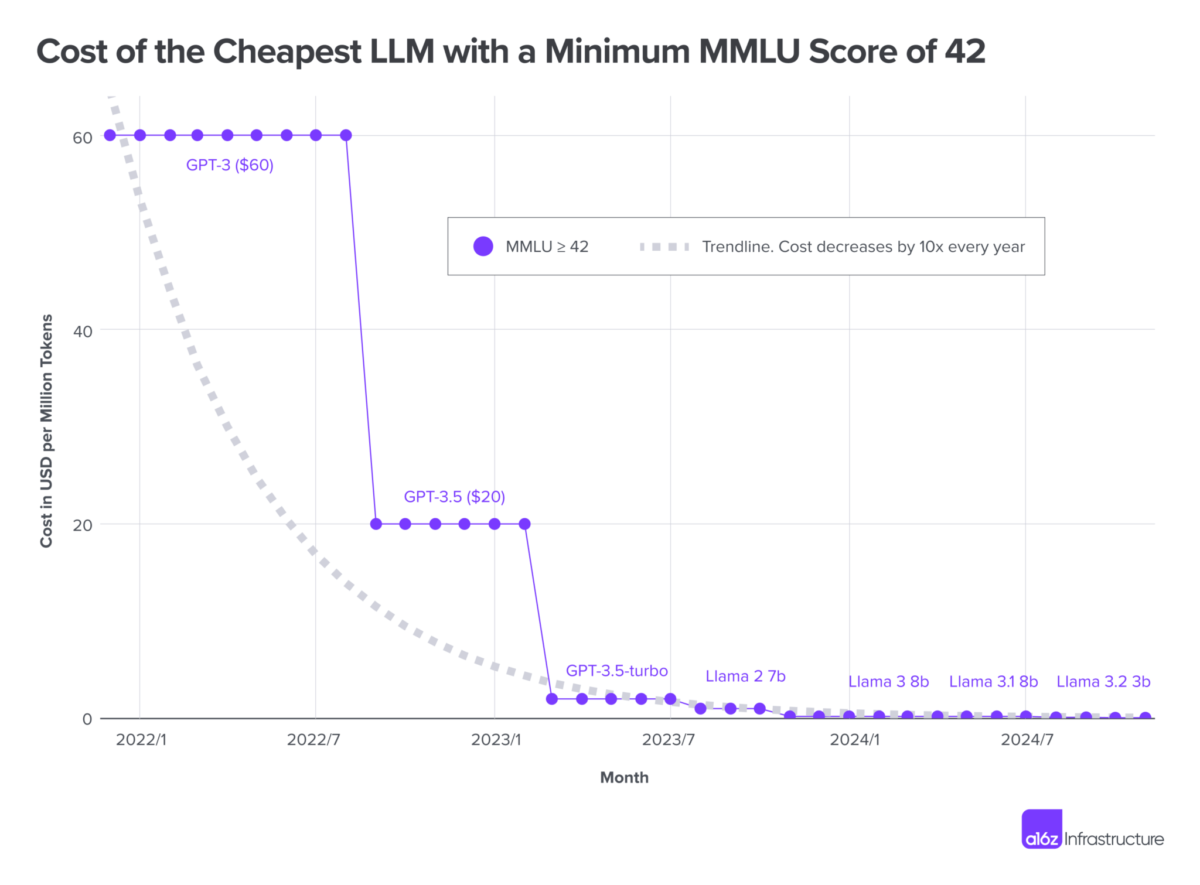

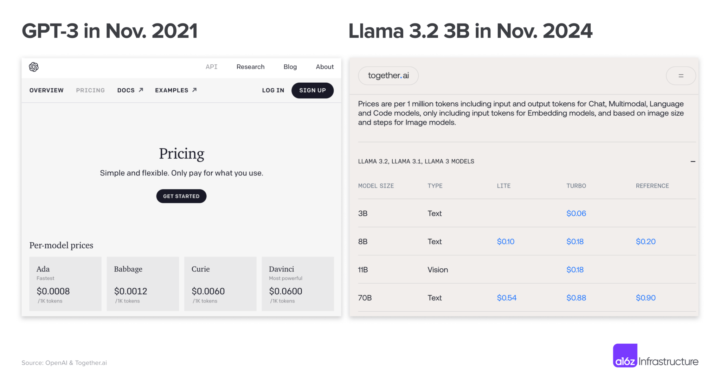

LLMフレーションの実態と検証方法

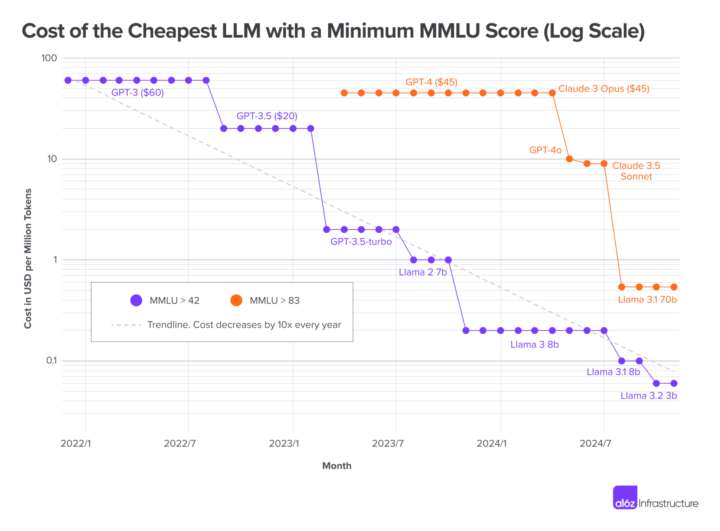

LLMの性能評価にMMULUスコアを用い、OpenAI、Anthropic、MetaのLlamaモデルの過去の価格データを分析した結果、MMULUスコア42以上のモデルでは、2021年11月のGPT-3公開時の100万トークンあたり60ドルから、2024年現在の0.06ドルまで、約1,000分の1にコストが低下している。

また、より高性能なMMULUスコア83以上のモデルでも、2023年3月以降、約62分の1までコストが低下している。

コスト低下を実現した技術的要因

LLM処理コストの急激な低下は、複数の技術革新によってもたらされた。GPUの性能向上、4ビット量子化による効率化、ソフトウェアの最適化、より少ないパラメータで高性能を実現する小規模モデルの開発、instruction tuningの進化、オープンソースモデルの登場などが主な要因だ。

これらの要因が複合的に作用し、従来のムーアの法則を上回るペースでのコスト低下を実現している。

市場への影響と新たな可能性

コストの劇的な低下により、これまで採算が取れなかった新たなAIアプリケーションの実用化が可能になっている。

例えば、1日10時間、年間を通じて話し続けた場合の音声データをGPT-3クラスのLLMで処理するコストは年間2ドル程度まで低下し、Linuxカーネル全体(約4,000万行のコード)の処理も1ドル未満で可能になった。

音声合成モデルも同様に低コスト化が進み、音声アシスタントの構築が実質的に無料で可能になっている。

AI Market の見解

LLMフレーションは、AIの民主化を加速させる重要な現象だ。コスト低下の各要因は独立しており、一部の要因では今後の進展が予測困難なものもあるが、総じて価格低下傾向は継続すると考えられる。

特筆すべきは、高性能モデルプロバイダーが高価格帯に注力する一方で、オープンソースモデルの普及により低価格帯での競争が活性化している点だ。

この二極化は、AIエコシステムの多様化を促進し、新たなビジネスモデルの創出につながる可能性が高い。今後、AIアプリケーション開発の敷居が更に下がることで、スタートアップを中心としたイノベーションの加速が期待できる。

参照元:a16z

生成AI(ジェネレーティブAI)について詳しく知りたい方はこちらの記事もご参考ください。

AIに関するご相談はAI Marketへ

AI Marketでは

メルマガ会員登録(無料)

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp