Microsoft、次世代小型言語モデル(SLM)「Phi-3」3.8Bを発表

最終更新日:2024年06月24日

Microsoftは2024年4月23日(米国時間)、最新の小型言語モデル(SLM)の「Phi-3」を発表した。

Phi-3は、同等またはより大きなサイズのモデルを上回る高い性能を実現しながら、コストを抑えた画期的な小型言語モデルとなっている。まずは3.8B規模の「Phi-3-mini」が、Azure AI Studio、HuggingFace、Ollamaで提供開始された。

<本ニュースの10秒要約>

- コンパクトながらLLM(大規模言語モデル)を上回る高性能な小型言語モデル「Phi-3」がリリース

- リソース制約環境でも使用可能な3.8B規模の「Phi-3-mini」が先行提供開始

- AIデバイスやオフライン環境など、幅広い用途での活用が期待される

Phi-3の卓越した性能

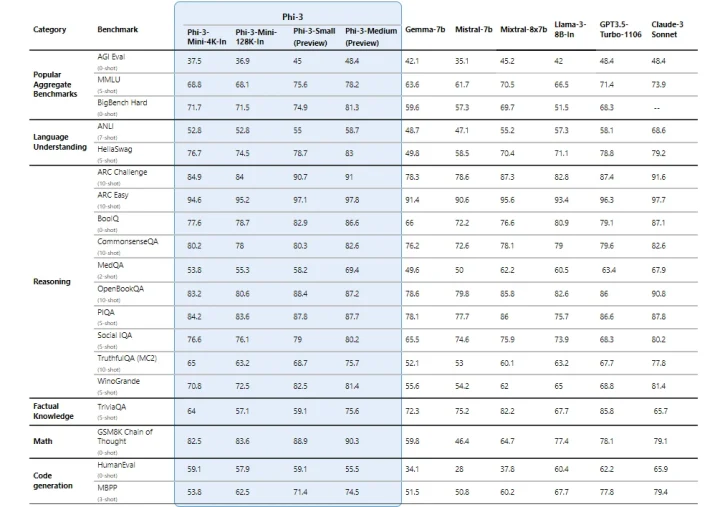

Phi-3モデルは、同等規模や大規模な他の言語モデルを上回る優れた性能を発揮する。ベンチマークでは、Phi-3-miniが自身の2倍の大きさのモデルよりも高いスコアを示し、Phi-3-smallやPhi-3-mediumは、GPT-3 175Bを凌駕しているとのことだ。

Phi-3は言語、推論、コーディング、数学の各タスクで高い能力を発揮するが、モデルサイズの制約上、一般的な知識については大型モデルに及ばない面があるとしている。

責任あるAI開発のための徹底した安全性評価

Phi-3は、「Accountability(説明責任)」「Transparency(透明性)」などのMicrosoft社内の責任あるAI標準に基づいて開発された。

人間の監視の下で強化学習を行うことで、ハームのリスクを大幅に低減。また、数十のハームカテゴリーに渡る自動テストと評価、手動によるレッドチームテストなど、徹底した安全性評価と改善を経ている。

多様なニーズに応える柔軟性

Phi-3には、Phi-3-mini(3.8B)のほか、今後、Phi-3-small(7B)、Phi-3-medium(14B)が追加リリースされる予定だ。

小型モデルは、リソース制約環境でのオンデバイス推論、低レイテンシーが求められるシナリオなど、様々な用途に適している。小規模ながら長いコンテキストウィンドウを持つPhi-3は、大量のテキスト、コード、ウェブページなどに対する推論が可能で、分析タスクにも適しているとのことだ。

参照元:Microsoft

生成AI(ジェネレーティブAI)について詳しく知りたい方はこちらの記事、SLMとは何か、Phii-3以外にどんなモデルがあるか、こちらの記事で詳しく説明していますので併せてご覧ください。

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp