Sakana AI、新手法「TAID」を用いた小規模日本語言語モデル「TinySwallow-1.5B」の公開

最終更新日:2025年01月31日

記事監修者:AI Market ニュース配信チーム

Sakana AIは2025年1月30日、新しい知識蒸留手法「TAID」を用いて開発した小規模日本語言語モデル「TinySwallow-1.5B」を発表した。

32Bパラメータの大規模モデルの知識を1.5Bパラメータの小型モデルに効率的に転移させることで、同規模モデル中で最高性能を達成。スマートフォンやPCでの完全オフライン実行を可能にし、外部APIを必要としないプライベートなAIアシスタントの実現を可能にした。本研究は機械学習のトップ国際会議ICLRに採択された。

<本ニュースの10秒要約>

- 新手法「TAID」により32Bの大規模モデルの知識を1.5Bの小型モデルに効率的に転移し最高性能を実現

- スマートフォンやPCで完全オフライン実行が可能な日本語AIモデルとして、プライバシーを確保した利用が可能

- ウェブアプリとローカル実行版の両方を公開し、開発者が独自のAIアプリケーションを構築可能な環境を提供

TAIDの技術的特徴

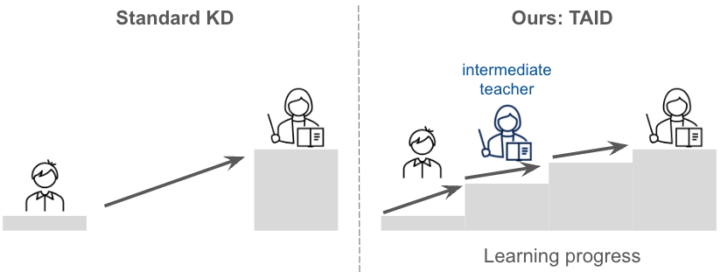

TAIDは、生徒モデルの学習進度に合わせて教師モデルを段階的に変化させる新しい知識蒸留手法だ。

従来手法では教師モデルが大きすぎると生徒モデルの性能が低下する課題があったが、TAIDは中間教師を導入することでこの問題を解決した。人間の学習過程からヒントを得たこの手法により、教師モデルのサイズに比例して生徒モデルの性能が向上することが実証された。

TinySwallow-1.5Bの性能と特徴

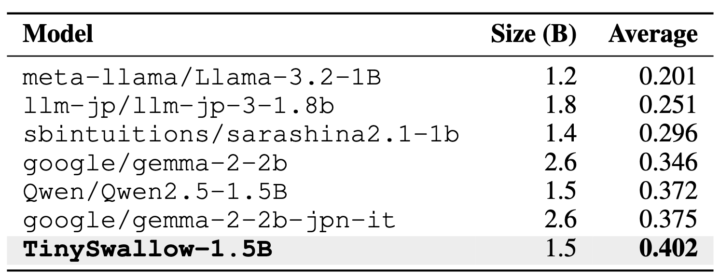

TinySwallow-1.5Bは日本語言語モデルベンチマークにおいて、3B未満の小規模モデル中で最高性能を達成した。

モデルはiPhoneでも動作可能で、高速なテキスト生成を実現。ウェブアプリ版とPythonベースのローカル実行版が提供され、ネットワーク接続なしでの完全オフライン実行が可能だ。

これにより、社内文書や個人メモに基づいたプライベートなAIアシスタントの構築や、オフラインゲームのAIキャラクター実装などが可能になる。

今後の展開と応用可能性

TAIDの適用範囲は言語モデルに限定されず、英語視覚言語モデル「TAID-VLM-2B」でも既存手法を上回る性能を確認している。今後は様々なモデルや環境条件下での検証を進め、AIの恩恵をより多くの人々が享受できる世界の実現を目指す。特に、データを外部に送信せずにローカルで完結するAI業務支援や、小型AIエージェントの開発など、幅広い応用が期待される。

AI Market の見解

TAIDの開発は、AIモデルの小型化における重要な技術的ブレークスルーだ。特に、生徒モデルの学習進度に応じて段階的に知識を転移させる手法は、効率的なモデル圧縮の新たな標準となる可能性がある。

また、完全オフライン実行可能な日本語モデルの公開は、プライバシーとセキュリティを重視する企業や個人向けのAIアプリケーション開発を加速させるだろう。この技術は、エッジAIの実用化を大きく前進させる重要な一歩となる。

参照元:sakana.ai

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp