Codestral Mambaとは?商用利用・メリット・始め方・展望を徹底紹介!

最終更新日:2025年08月27日

2024年7月16日、OpenAIの対抗馬として注目されている、フランスのAI(人工知能)スタートアップのMistral AIが、新たなコード生成特化LLM「Codestral Mamba」をリリースしました。

本記事では、Codestral Mambaの概要、商用利用の可否やメリット、展望までを網羅的に紹介します。Codestral Mambaやコード生成AIを活用して開発効率を向上させたい企業担当者は、ぜひ最後までご覧ください。

関連記事:「コード生成AIとは?企業ユースにおすすめのサービスでプログラミングを効率化!」

コード生成・解析に強いAI会社の選定・紹介を行います

今年度AI相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・リファクタリング、ソース解析、AI駆動開発等

完全無料・最短1日でご紹介 コード生成・解析に強い会社選定を依頼

目次

Codestral Mambaとは?

Codestral Mambaとは、MixtralシリーズのMistral AI社が2024年7月に発表したコード生成特化型のLLMです。開発者のコーディングの生産性向上を目的として設計されています。

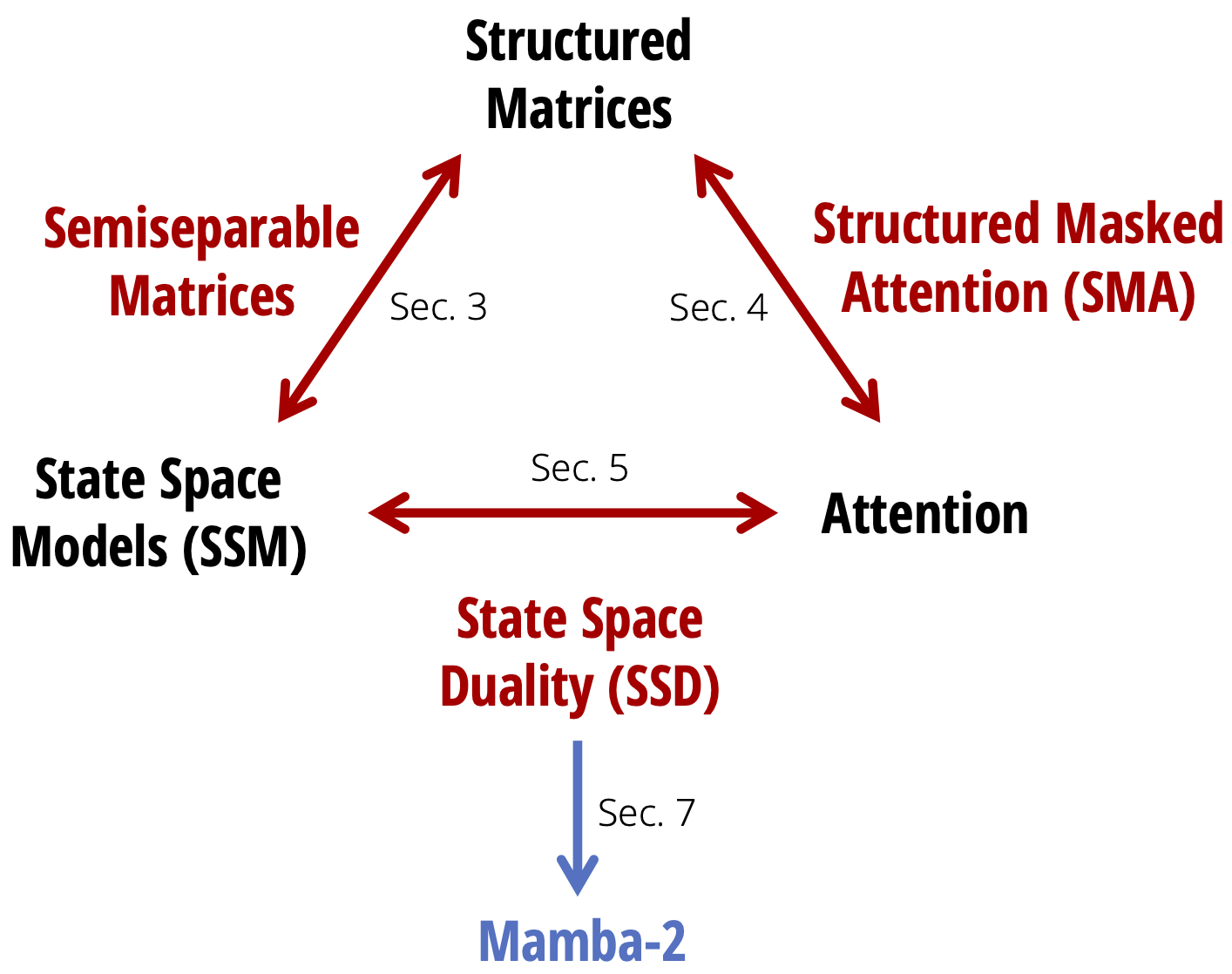

Codestral Mambaの特筆すべき点は、従来のLLMの定番であったTransformerアーキテクチャに代わる「Mamba2」と呼ばれる新しいアーキテクチャの採用です。

Mambaは選択的状態空間モデル(SSM)を活用しており、入力データを選択的に処理する仕組みによって理論的には無限長のシーケンスを処理できます。

そのため、複雑なコード構造や長いコンテキストを必要とするプログラミングタスクにも対応可能です。

このような特徴から、開発者が日常的に行うコード補完や自動生成のタスクにおいて、高い正確性と効率性を実現するツールとして注目を集めています。

Mistral AI社の生成AIモデル

Mistral AIは、Meta社・Google DeepMind社などAI(人工知能)分野に強い企業出身の従業員が在籍し、生成AIの開発に強みを持つフランスのAIスタートアップ企業です。同社は、2023年6月の設立後、わずか数カ月で6億ユーロ(約1,000億円)もの大規模な資金調達を成功させるなど、幅広い業界から期待されています。

Mistral AIは以下のような用途に応じた高性能な生成AIモデルを多数提供しています。

- Mistral Large:数学やコーディングタスクで高性能なフラグシップモデル

- Mixtral 7B:英語やコード生成に強みを持つLLM

- Mistral-Nemo:デスクトップPSで利用できるSLM

Mistral AIから提供される主なモデルは、オープンソースとして公開されている点が特徴です。開発者や企業はMistral AIの最先端のモデルを自由に利用し、ニーズに合わせてカスタマイズすることが可能です。

生成AI分野における最前線を進むMistral AIは、さまざまなニーズに応える多彩なモデルを提供することで、開発者や企業に新たな可能性をもたらしています。

MambaアーキテクチャとTransformerとの違い

MambaアーキテクチャとTransformerは、どちらもシーケンスデータを処理する技術ですが、計算効率や情報処理方法に大きな違いがあります。

| 特徴 | Mambaアーキテクチャ | Transformer |

|---|---|---|

| アーキテクチャ | 選択的状態空間モデルを採用し、入力データを選択的に処理 | 全入力シーケンスを均一に処理するアテンションメカニズムを採用 |

| 計算効率 | 入力長に対して線形時間で計算可能で、入力長が増えても高速な応答が可能 | 計算コストが入力長の二乗に比例して増加し、シーケンスが長くなるほど応答時間が遅延 |

| 情報処理方法 | 必要な情報を選択的に伝播し、無関係な情報を忘却 | 全ての情報を均等に処理 |

| 応用分野 | 長いシーケンスや時系列データに特化した処理が得意 | 短い文脈や汎用的な言語処理に強み |

上記にあるように、MambaはTransformerが抱える計算効率の課題や長いシーケンスデータ処理の限界を克服するために開発された点が特徴です。

まず、Transformerは、全ての入力データを均一に処理する仕組みを採用しているため、入力の長さが増えると計算量がその二乗に比例して増加する欠点があります。Transformerの計算コストの欠点は、大量のデータや長いシーケンスを扱う場面で大きな課題となります。

対してMambaは、「選択的状態空間モデル」を採用し、入力データを選択的に処理する仕組みです。具体的には、無関係な入力データをフィルタリングし、重要な情報だけを伝播させる仕組みで、長系列データに対しても高速で高精度な推論を保てます。

したがって、Mambaは、計算効率と文脈理解の両立できる技術として、シーケンスデータ処理における新たな選択肢となるでしょう。

Codestral Mamba他のコード生成AIとの違い

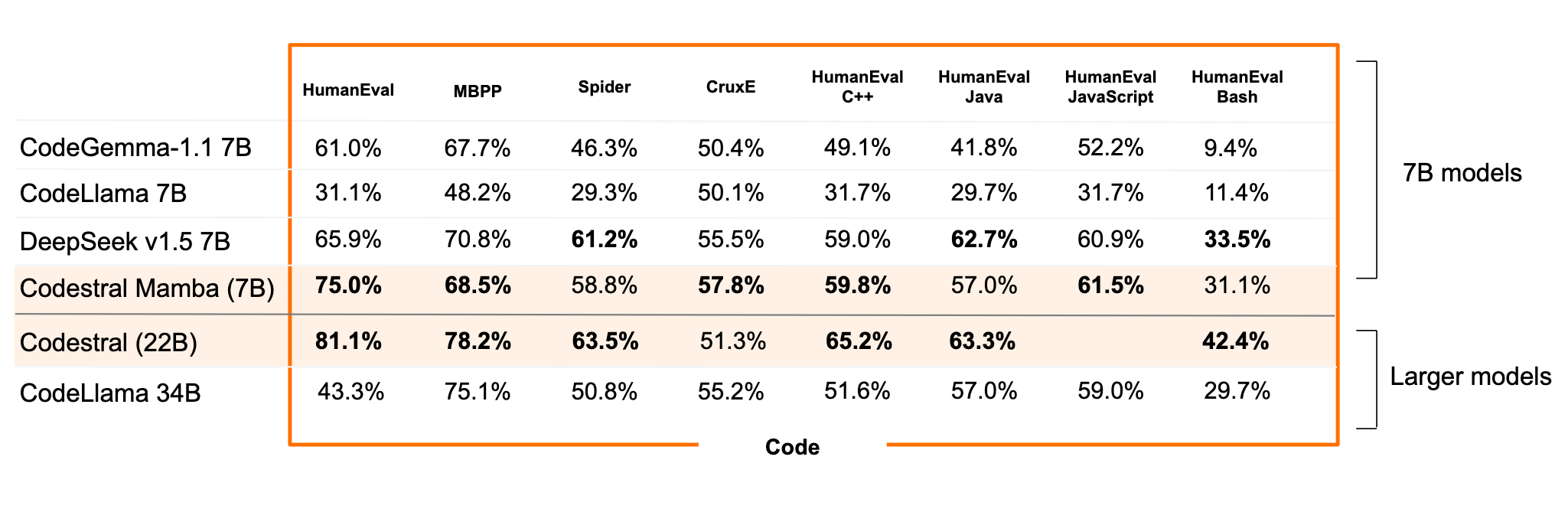

近年、Codestral Mambaのような小規模なコード生成AIが多数提供されています。

以下の表で、Codestral Mamba・CodeGemma-1.1 7B・CodeLlama 7B・DeepSeek v1.5 7Bの特徴とベンチマークを比較しました。また、大型モデルとの比較のためにCodestral 22Bを最下部に追加しました。

| モデル名 パラメーターサイズ | アーキテクチャ | HumanEval | MBPP |

|---|---|---|---|

| Codestral Mamba 7B | Mamba | 75.0% | 68.5% |

| CodeGemma-1.1 7B | デコーダオンリー | 61.0% | 67.7% |

| CodeLlama 7B | Transformer | 31.1% | 48.2% |

| DeepSeek v1.5 7B | デコーダオンリー | 65.9% | 70.8% |

| Codestral 22B ※大型モデル比較のために追加 | Transformer | 81.1% | 78.2% |

上記の比較表より、Codestral Mambaは無限長のシーケンスを線形時間で処理可能なことから、長いコンテキスト処理に特化したモデルとして際立っています。7Bサイズのコード特化モデルではトップクラスのコード生成能力を見せており、22Bモデルに迫るベンチマークです。

一方で、CodeGemma-1.1 7BとCodeLlama 7Bはコード補完や生成に特化し、自然言語処理やマルチプログラミング言語サポートで優位性を持っています。また、DeepSeek v1.5 7Bは比較的小規模なトークンウィンドウながらも、特定のコード生成タスクに適した設計が特徴です。

ベンチマークのHumanEvalは関数シグネチャとdocstringからコード本体を生成する上級の実践的タスクを特徴としています。、MBPPは入門者向けの基本問題を大量に解決する基礎能力と正確性が問われます。両者を併用することで、コードAIモデルの汎用的コーディング能力を多面的に評価可能です。

このように、同じコード生成AIであっても得意分野が異なるため、タスクや要件に応じて選ぶと良いでしょう。

コード生成・解析に強いAI会社の選定・紹介を行います

今年度AI相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・リファクタリング、ソース解析、AI駆動開発等

完全無料・最短1日でご紹介 コード生成・解析に強い会社選定を依頼

Codestral Mambaのメリット

Codestral Mambaでは長文のコンテキスト処理に優れていることから、活用することでさまざまなメリットを得られます。以下では、Codestral Mambaのメリットを紹介します。

長いコンテキストを迅速に処理できる

現在一般的に使用されている多くの生成モデルは、1万トークン以下しか扱うことができません。一方で、Codestral Mambaは理論上は無限長のシーケンス長を持っています。

実用上は、最大256,000トークンの文脈ウィンドウを処理可能なコンテキスト内検索機能でテストされています。従来のモデルが対応できない膨大なシーケンスを処理する場面でも活用可能です。

一般的なコード生成AIモデルでは長い入力シーケンスで学習されておらず、長い入力データにおいて計算負荷の増加や文脈の誤解釈の発生が課題として挙げられます。

一方でCodestral Mambaは、拡張されたコンテキストウィンドウを効果的に活用し、長大な入力データを処理する際にも一貫したパフォーマンス能力を発揮することが可能です。実際に、実験では上限の256,000トークンに近い入力でも一貫したパフォーマンスを示せたと報告されています。

そのため、長いコードベースや複雑なコンテキストを要するタスクなど、膨大なデータを扱う大規模なプロジェクトでも安定した性能を維持できます。

高速処理

Codestral MambaはMambaアーキテクチャの採用により、Transformerベースのモデルと比較して応答時間が速く、長い入力シーケンスを扱う際でも短いシーケンス同様に高速な処理が可能です。

これらの特長により、Codestral Mambaは、大規模プロジェクトや長いコードシーケンスを扱う複雑な環境下で開発者にとって有用なツールとなっています。

商用利用可能

Codestral Mambaは、Hugging Faceにて「Apache 2.0ライセンス」に基づいて提供されており、商用利用が可能です。

具体的には、以下のような活用が可能です。

- ソフトウェアをそのまま使用する

- 必要に応じてコードを変更し、自社のニーズに合わせてカスタマイズする

- カスタマイズしたバージョンを再配布する

Codestral Mambaは柔軟なライセンス形態を取っているため、開発者や企業は製品やサービスの中核に組み込むなど商業プロジェクトにおいて積極的に活用できます。

汎用的に使える

入力シーケンスを効率的に処理できるCodestral Mambaは、「ローカルコードアシスタント」として、小規模なスクリプトから大規模なプロジェクトまで幅広いコーディングタスクで優れた性能を発揮します。

具体的には、以下のようなタスクを支援します。

- 関数の作成:新しい関数を迅速に生成し、必要に応じて文脈に合った提案を提供

- 構文のクリーンアップ:コードの可読性を向上させるためのリファクタリングや、構文エラーの検出と修正

- 単純なコード生成の処理:定型的なコードの作成や初期化処理の記述を支援し、開発者の作業負担を軽減

Codestral Mambaは高速な推論速度により、これらのタスクを瞬時に実行することが可能です。Codestral Mambaは素早い応答性と正確性から、日常的なコーディングにおいて信頼できるアシスタントとして活用できます

多言語サポート

またPython/Java/C++/JavaScriptなど主要言語に加え、Swift/Fortranなどニッチ言語も含めて、80以上の言語をサポートしています。網羅しているだけでなく、以下表のように多くの言語で高水準の能力を発揮しています。

| 言語 | Codestral Mamba | DeepSeek v1.5 7B |

|---|---|---|

| C++ | 59.8% | 59.0% |

| Java | 57.0% | 62.7% |

| JavaScript | 61.5% | 60.5% |

| Bash | 31.1% | 33.5% |

※HumanEvalスコア

Codestral Mambaの始め方

ここでは、Codestral Mambaを使い始めるための手順を紹介します。Codestral Mambaは、Google Colabを利用することで、簡単に環境を構築できます。

以下が、具体的な手順です。

- ライブラリをインストール

- Mistral AIが提供する推論ツールキット「Mistral Inference」

- Mambaモデルの核となるライブラリ「mamba-ssm」と「causal-conv1d」

- Hugging Faceからモデルをダウンロードするための「huggingface_hub」ライブラリ

- Hugging FaceのリポジトリからCodestral Mambaモデルをダウンロード

これらの手順を完了すれば、Codestral Mambaを使用したコード生成や補完タスクを開始できます。

コード生成・解析に強いAI会社の選定・紹介を行います

今年度AI相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・リファクタリング、ソース解析、AI駆動開発等

完全無料・最短1日でご紹介 コード生成・解析に強い会社選定を依頼

Codestral Mambaの展望

Codestral Mambaはシステムの強化により、活用領域をさらに広げることが見込まれています。具体的なシステム展開の方向性は、以下に分類できます。

- モデルのスケールアップ

- 特化型への派生

モデルのスケールアップ

まず、現在は7Bパラメータの小規模なモデルですが、今後さらに数十億単位のパラメータを持つ大規模なモデルへのスケールアップが期待されています。パラメータが増えることで、より複雑で高度なコード生成能力を提供し、幅広いプログラミングタスクに対して適用が可能になります。

特化型への派生

汎用的なコード生成AIとしての枠を超え、Pythonなど特定のプログラミング言語にファインチューニングして特化したモデルシリーズも計画されるでしょう。特定の言語環境でのパフォーマンスがさらに向上し、開発者のニーズにより的確に応えることも可能になります。

プラットフォーム化

Codestral Mambaを、幅広いユーザー層が使えるようプラットフォーム化するニーズが増える可能性があります。以下のようなコード生成AIプラットフォームやツールが人気で、よく使われています。

| 製品名 | 開発元 | 安全面での特徴 |

|---|---|---|

| GitHub Copilot (GitHub Copilot X) | GitHub (Microsoft) | Copilot Businessであれば、使用したプロンプトや候補はGitHub Copilotに保存をされない |

| Amazon CodeWhisperer | Amazon Web Services (AWS) |

|

| v0 (ブイゼロ) | Vercel | 環境変数の取り扱いに注意を払い、セキュアな実装を推奨 |

| Code Llama | Meta | 安全性を考慮した開発が行われ、有害なコンテンツの生成を防ぐフィルタリング機能 |

Codestral Mambaについてよくある質問まとめ

- Codestral Mambaは商用利用できますか?

はい、Codestral MambaはApache 2.0ライセンスのもとで提供されており、商用利用が可能です。

このライセンスにより、ソフトウェアを自由に使用、変更、再配布できるため、企業のプロジェクトや製品開発にも安心して利用できます。

- Codestral Mambaは、既存のTransformerベースのコード生成AIと何が違うのですか?

Codestral MambaはMambaアーキテクチャを採用しており、入力長に対して線形時間で計算が可能です。これにより、Transformerベースのモデルと比較して、長いシーケンスを高速に処理できます。

また、選択的状態空間モデルにより、関連性の高い情報に焦点を当て、より正確なコード生成を可能にします。

まとめ

Codestral Mambaは、長いシーケンスデータを効率的に処理する性能をもたらす「Mambaアーキテクチャ」を採用し、日常的なコーディングタスクの生産性向上に役立つコード生成AIです。また、「Apache 2.0ライセンス」に基づき商用利用が可能で、Google ColabやHugging Faceなどを通じて手軽に利用を始められる点も大きな魅力です。

ただし、実際の導入や活用においては、個々の開発環境やプロジェクトの特性に合わせた検討が必要です。より詳細な技術的な知識や、具体的な導入支援が必要な場合は、AI技術に精通した専門家にご相談いただくことをお勧めします。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp