【Meta LLM】Llama 4とは?特徴や機能、性能、Llama 3との違い、できること、料金や使い方、活用例を徹底解説

最終更新日:2025年08月21日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

- Llama 4は、マルチモーダル対応と超長文処理性能を備え、幅広い業務を強力に支援。

- Mixture of Expertsアーキテクチャ採用で、高精度かつ低コストな推論・学習を実現。

- ScoutとMaverickの2モデルが、多様なニーズに応じた柔軟な運用を可能に。

- オープンソースで無料利用が可能、英語・日本語を含む12言語に対応しグローバル展開を加速。

Metaが2025年4月6日に発表したLlama 4は、マルチモーダル対応、高い長文処理性能とコストパフォーマンスを誇るLLM(大規模言語モデル)です。

本記事では、Llama 4とは何か、特徴や機能、料金や使い方、活用事例まで徹底的に解説します。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

LLMに強いAI会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

目次

Llama 4とは?

Today is the start of a new era of natively multimodal AI innovation.

Today, we’re introducing the first Llama 4 models: Llama 4 Scout and Llama 4 Maverick — our most advanced models yet and the best in their class for multimodality.

Llama 4 Scout

• 17B-active-parameter model… pic.twitter.com/Z8P3h0MA1P— AI at Meta (@AIatMeta) April 5, 2025

Llama 4は、Meta社が開発・提供する高性能なオープンソースLLMであるLlamaシリーズのモデルです。

テキストと画像をネイティブに統合できる「マルチモーダル」機能を備え、優れた性能とコスト効率を両立しています。

2種類のモデル「Llama 4 Scout」と「Llama 4 Maverick」が提供されており、用途に応じた柔軟な運用が可能です。また、「Llama 4 Behemoth」が今後提供予定です。

Llama 4 Scout

Llama 4 Scoutは、Llama 4シリーズの中でも軽量で高速なモデルです。17億のアクティブパラメータを持ち、単一のNVIDIA H100 GPU上で動かすことができるため、ローカル環境や小規模なクラウド環境でも扱いやすいのが特徴です。

また、最大1,000万トークンというコンテキスト長を持ち、非常に長いドキュメントや複数の文書をまたいだ処理に適しています。 マルチモーダル機能(テキスト+画像入力)にも対応しており、軽量かつ多用途に使えるモデルです。

Llama 4 Maverick

Llama 4 Maverickは、Llama 4シリーズの中でも高性能・多機能なモデルです。 こちらもアクティブパラメータは17億ですが、内部には128個のエキスパートが搭載され、より高精度な推論、コーディング、マルチリンガル対応、画像理解が可能です。

最大コンテキスト長は100万トークンとScoutよりは短いものの、画像推論・長文処理・多言語対応のすべてにおいて高いパフォーマンスを発揮し、性能はScoutを凌駕します。 また、推論コストも比較的低く、コストパフォーマンスに優れています。

Llama 4 Behemoth

Metaが開発したLlamaシリーズの中で最も高度かつ大規模な言語モデルで、約2兆個という膨大なパラメータを持つ「超巨大モデル」です。

従来のGPT-4.5やClaude 3.7、Gemini 2.0 Proといった最新の競合モデルを、数学・論理・多言語処理などのSTEM分野におけるベンチマークで上回る性能を発揮しており、現在存在する中でも最強クラスのAIモデルといえます。

但し、2025年4月時点で学習中であり、リリースされていません。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llama 4の機能・特徴

Llama 4は、次のような機能・特徴を持っています。

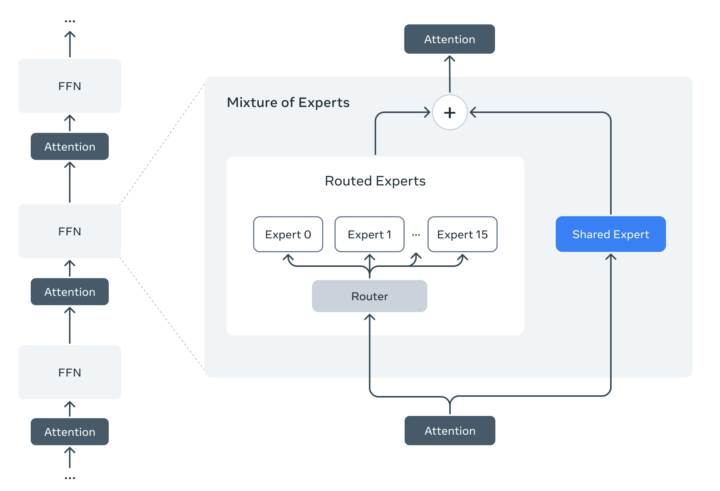

Mixture of Experts(MoE)アーキテクチャを採用し、効率的な計算を実現

Llama 4は「Mixture of Experts(MoE)」という仕組みを採用しています。MoEでは、入力されるトークンごとに必要な一部の専門ユニット(エキスパート)だけが動作するため、全体のパラメータ数を抑えながらも高い出力品質を実現できます。

この方式により、モデルサイズが大きくなっても推論や学習にかかる計算量とコストを効率的に抑えることができ、より高速な処理が可能になっています。

特に、Llama 4 Scoutは、最新のGPU「NVIDIA H100」を使用すれば、1つのGPUでモデルを動かすことができます。これは、非常に高い運用効率を意味しており、スモールスタートでの導入や、クラウドコストを抑えた開発にも最適です。

高品質×低価格を実現

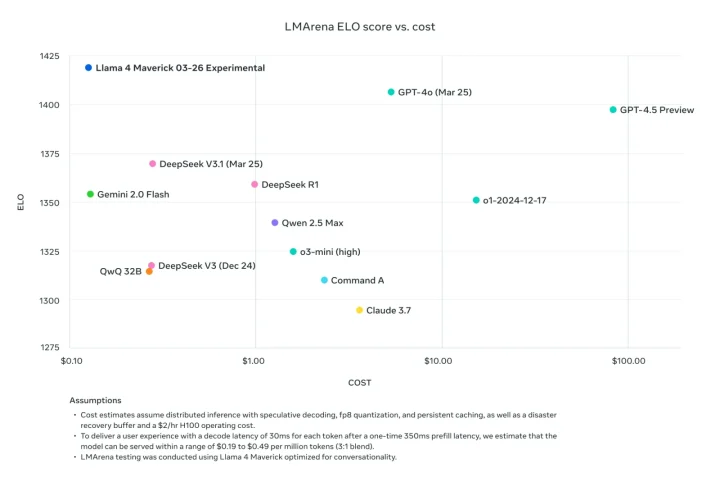

Llama 4 Maverickは、驚異的な会話性能(ELOスコア1417)を誇りながら、運用コストは業界最安レベルに抑えられています。

他の競合モデルと比較しても、Llama 4 Maverickは性能面で並ぶか、あるいは上回る一方で、推論コストは10分の1以下というケースもあります。

上記画像の通り、LMArenaのベンチマークでは、他モデルを凌駕する品質を持ちながら、数ドル未満のコストで運用可能であることが確認されています。

つまり、性能もコストも妥協したくない企業や開発者にとって、Llama 4 Maverickは最有力の選択肢となり得ます。

多言語対応かつ膨大なコンテキスト長(10Mトークン)をサポート

Llama 4は多言語対応しており、英語、日本語を含む12言語(アラビア語、英語、フランス語、ドイツ語、ヒンディー語、インドネシア語、イタリア語、ポルトガル語、スペイン語、タガログ語、タイ語、ベトナム語)で優れたパフォーマンスを発揮します。

それだけでなく、Llama 4 Scoutは最大1,000万トークンという、膨大なコンテキスト長をサポートしています。これにより、多くの言語の数百ページにわたる長文データや複数のドキュメントをまたいだ解析・要約も可能です。

マルチモーダル対応で高い画像理解能力、画像生成にも対応

Llama 4は、テキストだけでなく画像も理解できるマルチモーダルモデルです。

特にScoutモデルでは、ユーザーが入力した自然言語により示される画像内の物体を特定する「画像グラウンディング(Image Grounding)」機能が強化されています。これにより、単なる「画像の説明」だけでなく、ユーザーの意図を正確にくみ取り、画像の中の対象物に応じた細かな応答や指示が可能となります。

画像生成にも対応しており、ビジュアルなタスクにも強いモデルになっています。

Behemothモデルから学習

Llama 4 ScoutとMaverickは、教師役となる「Llama 4 Behemoth」という超大型モデルから学ぶ形で作られました。

この学習方法は、DeepSeekで用いられた蒸留と類似した手法で、共蒸留と呼ばれています。

これにより、Behemothが持つ高い推論力やコーディング力、多言語対応力をScoutとMaverickが引き継いでおり、以前のモデルよりも推論の正確さ、コード生成の精度、長い文章を扱う力が大きく向上し、より実用的で強力なAIモデルに仕上がっています。

Llama 4の性能

Llama 4 Scoutの性能

また、Llama 4 Scoutも、より軽量なモデルながら同クラスの他モデルを上回る性能を誇ります。

特に、最大1,000万トークンという圧倒的なコンテキスト長をサポートしており、複数の文書や非常に長い文章をまたいで推論できる点で、大きな強みを持っています。

これらの結果から、Llama 4シリーズは、マルチモーダル性能と長文処理能力において、現在提供されているモデルの中でも最高水準に位置しているといえます。

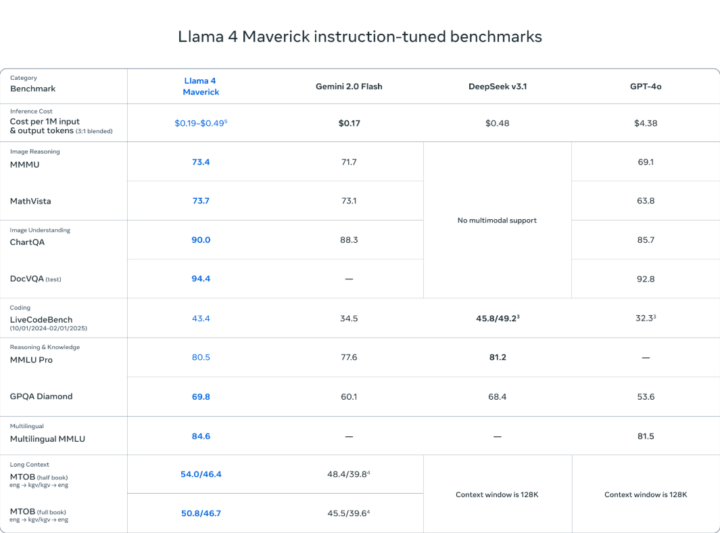

Llama 4 Maverickの性能

Llama 4 Maverickは、Gemini 2.0 FlashやGPT-4oといった競合モデルと比べても、あらゆる分野で優れた性能を発揮しています。特に、推論、マルチリンガル対応、長文処理、画像理解といった幅広いタスクで、いずれも高いスコアを記録しました。

例えば、画像推論タスクであるMMMUでは73.4、画像理解タスクのChartQAでは90.0という高スコアを達成しています。

さらに、推論・知識分野を測るMMLU Proでは80.5、多言語理解を評価するMultilingual MMLUでは69.8という結果を残しており、業界トップクラスの性能を示しています。

長文処理の分野でも、MTOB(full book)タスクにおいて英語からカガバ語への翻訳で54.0、逆方向で46.4という水準に達しています。

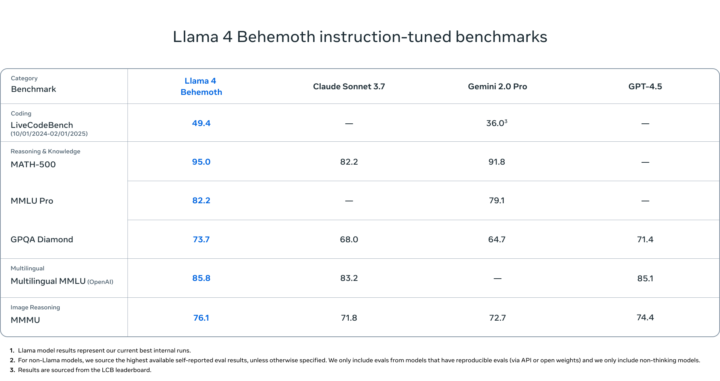

Llama 4 Behemothの性能

Llama 4 Scoutの性能で特に注目すべきは、数学・推論・コーディングといった難易度の高いタスクでの強さです。

例えば、数学力を測る「MATH-500」では95.0点と、他の主要モデル(ClaudeやGemini)を大きく上回っています。プログラミング力を評価する「LiveCodeBench」でも49.4点と高得点を記録し、Geminiを大きくリードしています。

さらに、多言語理解や画像推論の分野でも優秀で、200言語以上で学習されており、マルチモーダルな入力(テキスト+画像)にも対応しています。

このように、Llama 4 Behemothは、あらゆる分野でGPT-4.5やClaude 3.7を超える性能を示しています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llama 4の料金

Llama 4はオープンソースで提供されているため、モデルそのものを利用するのに料金はかかりません。誰でも無料でダウンロードし、自社環境に導入することができます。

ただし、Llama 4を運用するためには、GPUサーバーなどの推論環境が必要となり、そのインフラコストが発生します。

例えば、Llama 4 Maverickを使用する場合、推論にかかるインフラコストは1Mトークンあたりおよそ0.19〜0.49ドルとMeta社は見積もっており、他モデルに比較し、安価になります。

単一のGPUホスト環境では0.30〜0.49ドル、分散推論を行う場合は0.19ドル程度に抑えることができ、非常にコストパフォーマンスに優れたモデルです。

関連記事:「GPUとは?重要性・AIとの関係を徹底解説!」

Llama 3との違い

以下の表は、前のモデルであるLlama 3とLlama 4を比較した表です。

| 機能・特徴 | Llama 3 | Llama 4 | 補足説明 |

|---|---|---|---|

| マルチモーダル機能 | △ 3.2以降はマルチモーダル | ◯ | テキストに加え画像入力にも対応し、視覚情報を含む高度な推論が可能 |

| 最大コンテキスト長 | 128K (Llama 3.1 405B) | 10M | 長文や複数ドキュメントにまたがる解析・要約ができる |

| 推論コスト | 高め | 低め | Mixture of Experts(MoE)で計算資源を節約し、コストを抑制 |

| 多言語対応 | 8言語 (Llama 3.1 405B) | 12言語 | Llama 4は12言語で高精度な応答が可能 |

これらだけでなく、推論精度や安全性(誤答防止、バイアス低減)についても改善されています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llama 4の使い方

Llama 4は以下の方法で利用可能です。

- Metaの公式サイトやHugging Faceからダウンロードしてローカル環境で動かす

- WhatsApp、Messenger、Instagram Direct、Meta.AI上でMeta AIとして利用

- APIやクラウドプラットフォーム(AWS、Microsoft Azure等)を通じた運用

ローカル環境で使用する場合は、NVIDIA H100相当のGPUが必要になります。

また、Meta AIとして利用する方法については、2025年4月時点で日本から使用することはできません。

Llama 4を使う上での注意点

Llama 4をビジネス利用する場合、以下のリスクに注意が必要です。

- ハルシネーション(虚偽生成)

高性能モデルでも事実と異なる情報を生成する可能性があり、重要なビジネス判断には慎重な検証が求められます。 - バイアス問題

政治的・社会的なトピックに関しては、中立性を保つ努力がされていますが、完全なバイアス排除には至っていない点に留意する必要があります。 - コーディング能力

Llama 4のコーディング能力について懐疑的なコメントを残している投稿が散見されました。コーディング能力は向上しているとされていますが、実用的かどうかについては注意が必要です。

Llama 4 seems to actually be a poor model for coding.

Scout (109B) and Maverick (402B) underperform 4o, Gemini Flash, Grok 3, DeepSeek V3 and Sonnet 3.5/7 on the Kscores benchmark which tests on coding tasks like this.

ELO-maxxing on LMarena doesn’t create the best models. pic.twitter.com/NACtOU6FzJ

— Deedy (@deedydas) April 6, 2025

Llama 4の活用例

Llama 4は、膨大なドキュメントを横断して要約や検索を行うほか、複数の画像を解析して視覚的な推論や診断レポートを自動生成する用途に活用できます。

また、自然言語からのコード生成やデバッグ支援、マルチリンガル対応のチャットボット・仮想アシスタントの開発にも利用可能です。

Llama 4の活用例としてXに投稿されているものを以下でご紹介します。

画像生成

one-shot animation in Llama4 generated in <20sec

this is faster than GPT4o’s image (no animation) generation.(you can do it yourself on https://t.co/AFyJc2uwfK) pic.twitter.com/hzs2jmBrTR

— Arnav Gupta (@championswimmer) April 5, 2025

Llama 4についてよくある質問まとめ

- Llama 4の特徴は?

Llama 4は、テキストと画像をネイティブに統合できるマルチモーダル対応の大規模言語モデルです。

さらに、最大1,000万トークンという超長文コンテキストに対応し、長文解析や複数ドキュメントにまたがるタスクにも強いのが特徴です。

Mixture of Experts(MoE)アーキテクチャを採用しているため、高性能かつ低コストで動作できる点も魅力です。

- Llama 4は無料で使える?

オープンソースで提供されているため、モデル自体は無料でダウンロード・利用できます。

ただし、モデルの動作にはNVIDIA H100相当のGPUが必要で、GPUサーバーなどのインフラコストは別途かかるので注意が必要です。

まとめ

Llama 4は、ネイティブマルチモーダル対応、超長文コンテキスト、優れたコストパフォーマンスを兼ね備えたLLMです。ScoutとMaverickという2つのモデルラインアップにより、軽量から高性能まで幅広いニーズに応えます。

Llama 4は、オープンソースであることも特徴的で、業務効率化から新しいAIサービス開発まで幅広い応用先が考えられます。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、現場のお客様の課題ヒアリングや企業のご紹介を5年以上実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp