Phi-4とは?特徴・活用メリット・始め方・注意点まで最新情報を徹底紹介!

最終更新日:2025年09月08日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

2024年12月13日、Microsoft社は「Phi」シリーズに新たなモデルとしてPhi-4をリリースしました。Phiシリーズは、低コスト・低レイテンシでありながら、LLM(大規模言語モデル)並みに高度なパフォーマンスを発揮するSLM(小型言語モデル)として注目されています。

LLM(大規模言語モデル)についてはこちらで詳しく説明していますので併せてご覧ください。

中でも、Phi-4は数学的推論や複雑な問題解決に優れた性能を発揮し、AI(人工知能)分野をさらに加速させる存在として期待されています。

本記事では、Phi-4の特徴や活用メリット、始め方まで最新情報を網羅的に紹介します。Phi-4がどのようにビジネスや研究に役立つかを理解できる内容となっていますので、AI導入を検討している企業担当者はぜひ最後までご覧ください。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

ChatGPTの導入支援ができるAI開発会社について知りたい方はこちらで特集していますので併せてご覧ください。

目次

Phi-4とは?

Phi-4とは、Microsoft社が開発した140億のパラメータで構成されるSLM(小規模言語モデル)の一つで、従来の言語処理能力に加えて、数学をはじめ複雑な推論に強みを持つモデルです。以下が、Phi-4の推論能力を向上させるために採用された技術です。

- 高品質な合成データセットの活用:推論と問題解決に特化したデータを合成し学習データの多様性と関連性を向上

- 高品質な有機データの厳選:Webサイトやライセンス取得など済みの書籍など、教育的価値の高いデータをフィルタリングし、合成データ生成の基盤を構築

- 事後学習(ポストトレーニング)による精度向上:成功確率に大きく影響するトークンを優先する「ピボタルトークン検索」(Pivotal Token Search:PTS)の導入

- 改良されたSFT(Supervised Fine-Tuning)データセットの活用:モデルの応答精度や推論能力をさらに向上

これらのデータ品質を重視した学習プロセスによって、Phi-4は特に数学関連の推論において同等のモデルよりも高いパフォーマンスを見せました。

参考:Introducing Phi-4:Microsoft’s Newest Small Language Model Specializing in Complex Reasoning

2024年12月のPhi-4の発表後、2025年2月に、Microsoft社は5.6BパラメータのPhi-4-multimodalと、3.8BパラメータのPhi-4-miniを発表しました。

Phi-4-multimodalは、音声、画像、テキストを同時に処理できるモデルとなっており、Phi-4-miniは、テキストタスクにおいて卓越した精度とスケーラビリティを、コンパクトな形で実現しています。

参考:Empowering innovation: The next generation of the Phi family

Phiモデルの住み分け

Phiシリーズの各モデルは特定のタスクに最適化されており、以下のように明確な棲み分けがされています。

- Phi-1:1.3BパラメータのモデルでPythonコーディング用

- Phi-1.5:1.3Bパラメータのモデルで推論と理解を目的としたモデル

- Phi-2:2.7Bパラメータのモデルで言語理解用

- Phi-3:言語理解と推論タスク向け。3.8BパラメータのPhi-3-mini

- Phi-3.5:高速推論、多言語タスク、マルチモーダル性能などに特化した以下モデルを含む

- Phi-3.5-mini-instruct:3.8Bパラメータで高速推論タスクに最適化

- Phi-3.5-MoE-instruct:6.6Bパラメータの最大モデルで複雑なマルチリンガルタスクに対応

- Phi-3.5-vision-instruct:4.2Bパラメータのマルチモーダルモデル

Phiシリーズの中で、Phi-4は数学的推論に特化したモデルとして位置付けられています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Phi-4のメリット

Phi-4は、ビジネスで活用する際にさまざまなメリットをもたらします。以下では、Phi-4のメリットを紹介します。

パラメータが少ないが高性能

| モデル | パラメータ数 | MMLU(マルチタスク言語理解ベンチマーク) |

|---|---|---|

| Phi-4 | 140億 | 84.8 |

| Qwen2.5-14B-Instruct | 147億 | 79.9 |

| GPT4o-mini | 非公開 | 81.8 |

| Llama-3.3 70b instruct | 700億 | 86.3 |

Phi-4は140億パラメータという比較的小規模なモデルながら、特に数学的推論においてSLMの中でも特に高い性能を持ちます。

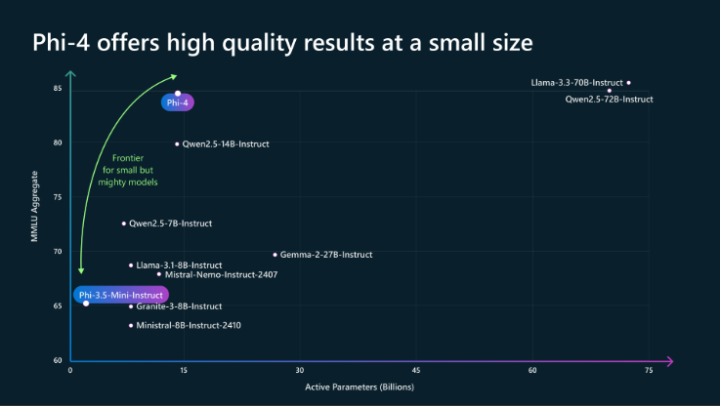

実際に、Microsoftが公開した以下の「MMLUのベンチマークテスト」では、同等のパラメータ数を持つSLMより優れているだけでなく、約5倍ものパラメータ差があるLLMとの性能も僅差であったと公表されています。

Phi-4の高性能は、高品質なデータセットの活用と事後学習の最適化によって実現されています。

このような性能結果から、Phi-4は少ないリソースで高い専門性を必要とするタスクに最適化されたモデルとして注目されています。

参考:arXiv:Phi-4 Technical Report

また、軽量モデルであることから、エッジデバイスに乗せて動かすエッジLLMとしての活用なども行いやすくなります。

長文処理

Phi-4は初期のコンテキスト長4,096トークンから、ミッドトレーニング段階で16,000トークンに拡張されました。これにより、長文処理能力が大幅に向上しています。その結果、長文ドキュメントからの情報抽出や要約などのタスクにおいて優れたパフォーマンスを発揮しました。

同じパラメータ数のQwen-2.5-14Bと比較して、多くの長文タスクで優れた性能を示しています。特にICLタスクでは、Qwen-2.5-14Bは67.6%にとどまったのに対し、Phi-4は77.0%のスコアを達成しました。

また、Phi-4は一部のタスクにおいて、より大規模なモデルであるLlama-3.3-70Bに匹敵する、あるいはそれを上回る性能を示しています。

このようにPhi-4は優れた長文処理能力を持つことから、法的文書の要約や技術的レポートの解析、研究論文の理解など、長文を扱うさまざまな場面での応用可能性が期待されています。

LLMと同レベル以上の数学推論が可能

Phi-4は、数学的推論において膨大なパラメータ数を有するLLMと同レベル以上の性能を持ちます。

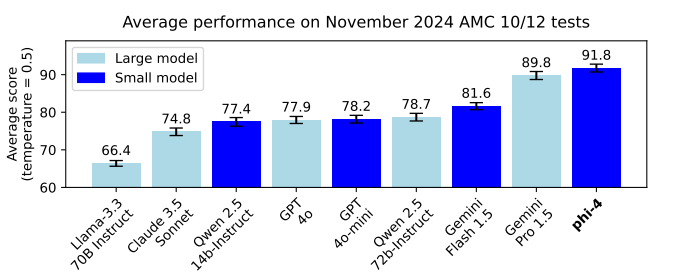

2024年11月に行われた以下の米国数学オリンピックの入門となる「AMC 10/12の数学コンテスト」では、Phi-4は平均スコア91.8を達成し、Gemini Pro 1.5やQwen 2.5などの競合モデルを上回りました。

MATHベンチマークでも、Phi-4は80.4のスコアを達成し、多くのLLMを上回りました。

特に、数学的な高度な問題解決や複雑な数式の解析において、GPT-4oやLlama-3.3 70BなどのLLMを超える能力があると言われています。

Phi-4の高い数学推論能力は、教育や研究、科学的計算など、特に高度な計算力を必要とする領域での活用が期待されています。

安全性が高い

Phi-4は、Microsoftの提供する「Azure AI コンテンツセーフティ機能」(Azure AI Content Safety)を使用できるため、安全性に優れています。

Azure AI コンテンツセーフティ機能で提供される安全機能は、以下のとおりです。

- プロンプトシールド:敵対的な攻撃を防ぐ

- 保護対象素材の検出:センシティブな内容や保護すべき情報を検出

- 根拠に基づく検出(Groundedness detection): 生成されたコンテンツの信頼性を向上させる

- コンテンツフィルタリング:不適切なコンテンツを検出しフィルタリング

これらの機能は、開発者が単一のAPIを通じてアプリケーションに簡単に統合できるため、導入コストを抑えつつ高い安全基準を担保できます。

またAzure AI コンテンツセーフティ機能に加え、アプリケーションの品質や安全性をリアルタイムでモニタリングし、敵対的なプロンプト攻撃やデータ整合性のリスクを監視する体制も整えられています。Phi-4の利用時に問題が発生した際には、リアルタイムでアラートを送信し、タイムリーにサポートしてもらえます。

AIの導入ノウハウがない場合にもPhi-4を安全に活用可能です。

Phi-4の始め方

Phi-4はAzure AI Foundry、またはHugging Faceを利用すれば、1分程度で手軽に始められます。

Azure AI Foundryから使用する場合は、Azure AI Foundryのモデルカタログにアクセスします。最新のSLMやLLMの候補が表示されるので「Phi-4」を選択し、MicrosoftのアカウントもしくはGitHubのアカウントでサインインを行います。

仮想マシンやインスタンス数など表示される項目に沿って設定を行い、最後にデプロイをクリックすれば利用を開始できます。

また、Hugging Face経由でも利用可能です。Hugging Faceでは、さまざまなAIモデルの実装環境が整っており、Phi-4もその一部として提供されています。Hugging Faceにアクセスして、簡単にPhi-4を試したり、プロジェクトに統合したりできます。

Phi-4は、これらのクラウドサービスを通じて気軽にお試し利用ができます。

Phi-4の商用利用について

Phi-4は2025年1月10日にMITライセンスで公開されました。MITライセンスは非常にオープンなライセンスで、商用利用を含む幅広い用途での使用が許可されています。モデルの改変や再配布も自由に行えます。

以前は、「Microsoft Research License Agreement (MSRLA)」に基づき商用利用はできませんでした。Microsoft社は研究者や開発者に向けてPhi-4を公開しており、非商用・研究目的に限って改変や私的利用が可能でした。

Phi-4は現在、商用利用を含む幅広い用途で利用可能です。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Phi-4活用時の注意点

以下では、Phi-4活用時の注意点を紹介します。Phi-4の得意分野を踏まえて活用することで、導入効果を高められます。

適用範囲が限定的

Phi-4は数学的推論が得意なモデルであることから、活用するうえでいくつか制約があります。

まず、数学的推論では非常に高い性能を持つ一方で、自然言語処理の分野では他のSLMに劣る場合があります。そのため、文章生成や汎用的な言語タスクで主に生成AIを使用する場合には、他のモデルを検討する必要があるでしょう。

と言っても、Phi-4は自然言語処理の分野でも高い性能を示しています。MMLUベンチマークでは84.8のスコアを達成し、他のSLMを上回る結果を示しています。

Phi-4を活用する際には、能力と制約を十分に理解し、適切な用途に限定して導入する必要があります。

ハルシネーションのリスクがある

Phi-4は数学的推論に特化したモデルとして優れた性能を持っていますが、それでも完全にハルシネーション(AIが誤った情報を生成する現象)のリスクを排除することはできません。たとえ単純な数式の比較問題であっても、意図しない誤った答えを生成するケースが報告されています。

Phi-4でハルシネーションが起こる理由は、AIモデルが内部で行う計算や推論の過程で、正しい文脈や条件を見落とす場合があるためです。

そのため、Phi-4を利用する際には、人間によるチェック体制を設けることが重要です。特に、生成された回答が重要な意思決定や業務プロセスに影響を与える場合、AIによる結果を鵜呑みにせず、エンジニアやプログラマーが内容を確認し、正確性を担保する必要があります。

また、利用環境に応じたリスク管理の一環として、生成内容を精査するツールやプロセスを取り入れることで、ハルシネーションによる誤解や問題を未然に防ぐことが可能です。現状でPhi-4の能力を最大限活用するためには、人間の介入が必要です。

ハルシネーション対策として、Microsoftも以下の取り組みを行っています。

- 拒否メカニズムの導入:モデルが確信を持てない場合に「わかりません」と応答する機能

- Azure AI Content Safety機能の提供:不適切なコンテンツの検出やフィルタリング

Phi-4についてよくある質問まとめ

- Phi-4はどのようなタスクを得意としていますか?

Phi-4は特に数学的推論に強みを持っています。複雑な数式の解析や高度な問題解決など、高い計算力を必要とする分野でその能力を発揮します。

- Phi-4を始めるにはどうすればよいですか?

Phi-4はAzure AI Foundryを通じて無料で利用可能で、特別なアカウント登録も必要ありません。また、Hugging Face経由でも利用できます。どちらの方法でも、手軽に利用を開始できます。

まとめ

Microsoft社が開発した最新のSLM「Phi-4」は、パラメータが少ない割にLLMに匹敵する高いパフォーマンスを実現し、注目を集めています。特に、数学分野で優れた性能を持ち、研究者や企業にとって効果的なツールとなることが期待されています。

Phi-4を最大限に活用するためには、これらの特徴を理解し、適切な利用環境を構築することが不可欠です。もし、あなたのビジネスでより専門的なAIの導入や具体的な課題解決が必要な場合は、専門家への相談も検討することをおすすめします。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、現場のお客様の課題ヒアリングや企業のご紹介を5年以上実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp