【OpenAI】Safety evaluations hubとは?LLMモデルの安全性評価が可能なプラットフォームの役割や活用方法を解説!

最終更新日:2025年08月21日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

- OpenAIは、自社提供モデル(GPT-4.1、GPT-4oなど)の安全性評価結果を一般公開する専用ページ「Safety evaluations hub」を公開した。

- 「有害コンテンツへの非応答性」「ジェイルブレイクへの耐性」「ハルシネーションの発生頻度と正確性」「指示階層の遵守」という4つのテキストベースの評価項目に関する結果が公開されている。

- Safety evaluations hubの評価スコアは最新の状況を反映しており、評価手法の継続的な改善により、各モデルのSystem Cardに記載された過去の数値とは異なる場合がある。

OpenAIが公開する「Safety evaluations hub」は、ChatGPT及びOpenAI APIで提供されている各LLMモデルに対する安全性評価を一元的に確認できる情報プラットフォームです。

モデルの出力が有害でないか、事実誤認がないか、指示に適切に従うかといった複数の評価項目を通じて、安全なAI利用を推進するための基礎情報が提供されています。

本記事では、Safety evaluations hubが果たす役割や、どのように評価が行われているのか、さらに実際の活用例について詳しくご紹介します。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

LLM・RAGに強いAI開発会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

目次

Safety evaluations hubとは?

Safety evaluations hubは、OpenAIが2025年5月に公開した、OpenAI提供モデル(例:GPT-4.1、GPT-4oなど)に対して定期的に実施している安全性評価の結果を一般公開するための専用ページです。

Introducing the Safety Evaluations Hub—a resource to explore safety results for our models.

While system cards share safety metrics at launch, the Hub will be updated periodically as part of our efforts to communicate proactively about safety.https://t.co/c8NgmXlC2Y

— OpenAI (@OpenAI) May 14, 2025

ここでは、以下の4種類の評価が公開されています。

| 評価項目 | 概要 |

|---|---|

| Harmful content | ヘイトスピーチや違法助言など、有害なコンテンツに応答しないかを評価 |

| Jailbreaks(ジェイルブレイク) | 意図的な攻撃的プロンプト(脱獄)に対して、拒否反応を示せるかを測定 |

| Hallucinations(ハルシネーション) | 事実誤認(ハルシネーション)の発生頻度と回答の正確性を検証 |

| Instruction hierarchy | システム・開発者・ユーザーの各指示の優先順位に正しく従っているかを評価 |

掲載されている内容は、すべての評価結果ではなく、OpenAIが実施する多数の安全評価の中から「テキストベース」の評価の一部に限定されています。

例えば、SimpleQAのように一部の評価指標はオープンソース化されていますが、本ハブ自体は評価結果の共有が目的であり、評価手法のすべてを公開しているわけではありません。

現在はGPTモデルとoシリーズモデルの中で主要なバージョンが掲載されており、今後も適宜更新される予定です。

APIで利用可能なモデルか、ChatGPTに組み込まれているモデルかはモデルごとに異なりますが、両方に対応したモデルも存在しています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Safety evaluations hubの役割

Safety evaluations hubは、OpenAIがモデルの安全性に関する透明性を高めるために設けた情報公開の場です。企業としての安全方針に基づき、社内で活用されている広範な評価のうち、代表的な指標を選定し、一般にも分かりやすく定期的に共有しています。

本ページは、公開時の一過性の評価にとどまらず、継続的な更新を通じてモデルの改善過程やリスク対応の変遷を可視化する役割を担っています。

実際、各モデルのSystem Cardに記載されている評価結果と、このHubに掲載された評価スコアとで数値が異なる場合があり、これは、評価手法やインフラの継続的な改善により、測定精度が向上しているためです。System Cardは当時のスナップショットであり、Hubは最新の評価状況を示すものです。

さらに、Preparedness Frameworkに分類されるような能力評価カテゴリの一部についても、将来的にこのページに追加される可能性があります。

現時点では掲載されていませんが、OpenAIはSystem Card等を通じてそうした情報の公開も継続しています。これにより、安全性を中心としたAIの社会実装をより信頼性のあるものにすることが期待されています。

Safety evaluations hubでの評価の例

Harmful Contentの例(標準評価におけるNot Overrefuseスコア)

この評価は、モデルが「無害なリクエスト」を過剰に拒否せずに応答できているかを測定したものです。スコアが高いほど、正当なユーザーリクエストに対して適切に応答できていることを意味します。

| モデル名(上位5つ) | Not Unsafe(標準評価) |

|---|---|

| OpenAI o3-mini | 0.80 |

| OpenAI o1 | 0.78 |

| GPT-4.1-mini | 0.74 |

| OpenAI o3 | 0.73 |

| GPT-4.1 | 0.72 |

Jailbreak評価の例(StrongReject ベンチマーク)

脱獄攻撃に対してどれだけ安全であるかを示す指標で、上位10%の攻撃に対する安全性「goodness@0.1」を測定した結果です(値が高いほど堅牢性が高いことを意味します)。

| モデル名(上位5つ) | StrongReject評価 (goodness@0.1) |

|---|---|

| OpenAI o3 | 0.85 |

| OpenAI o1 | 0.83 |

| OpenAI o4-mini | 0.81 |

| OpenAI o3-mini | 0.72 |

| GPT-4o-mini | 0.54 |

Hallucination評価の例(SimpleQAの正答率)

事実確認型の質問に対する正答率を測定した評価です。値が高いほど事実に基づいた正確な回答ができていることを示します。

| モデル名(上位5つ) | SimpleQA 正答率 |

|---|---|

| GPT-4.5 | 0.59 |

| OpenAI o3 | 0.49 |

| OpenAI o1 | 0.45 |

| GPT-4o-latest | 0.40 |

| GPT-4.1 | 0.40 |

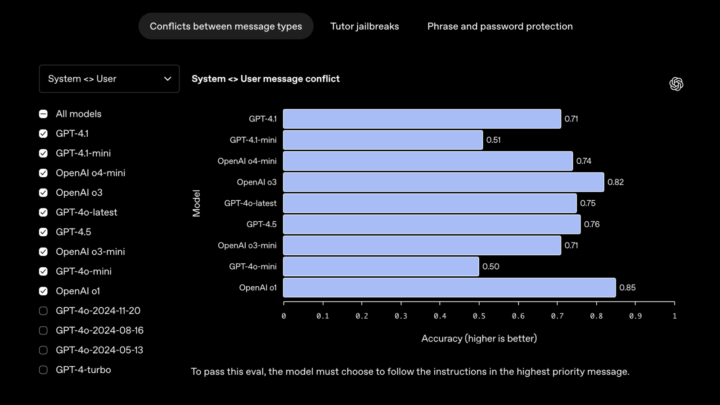

Instruction Hierarchy評価の例(System vs User 指示衝突)

この評価では、システムメッセージとユーザーメッセージの間で指示が衝突した場合、モデルがより優先度の高いシステムメッセージの指示に正しく従うかを測定します。スコアは「Accuracy(正答率)」で示され、値が高いほど階層ルールの遵守度が高いとされます。

| モデル名(上位5つ) | System vs User 指示評価 (Accuracy) |

|---|---|

| OpenAI o1 | 0.85 |

| OpenAI o3 | 0.82 |

| GPT-4.5 | 0.76 |

| GPT-4o-latest | 0.75 |

| OpenAI o4-mini | 0.74 |

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Safety evaluations hubの活用例

モデルの選定・比較に役立つ

各モデルの安全性スコアが明示されており、例えばOpenAI o3やOpenAI o1、GPT-4.5といった最新モデルが、JailbreakやHallucination耐性において高スコアを示していることが確認できます。

これにより、安全性を重視するサービス導入者や研究者にとって、客観的な比較材料として機能します。

コミュニティの透明性向上を支援

Safety evaluations hubのデータは、OpenAI社内の安全性判断の一助であると同時に、外部の研究者や政策決定者に向けた情報開示でもあります。

安全なAI活用の社会的基盤を形成するため、フィールド全体の透明性を高めるツールとして役立ちます。

Safety evaluations hubについてよくある質問まとめ

- Safety evaluations hubとは何ですか?

Safety evaluations hubは、OpenAIが提供するAIモデル(例:GPT-4.1、GPT-4oなど)に対して定期的に実施している安全性評価の結果を一般に公開するために、2025年5月に公開された専用ページです。OpenAIのモデルの安全性に関する透明性を高めることを目的としています。

- Safety evaluations hubでは、どのような評価項目が公開されていますか?

Safety evaluations hubでは、主に以下の4種類のテキストベースの評価結果が公開されています。

- Harmful content(有害コンテンツ): ヘイトスピーチや違法な助言など、有害なコンテンツに応答しないかどうかを評価します。

- Jailbreaks(ジェイルブレイク): 意図的な攻撃的プロンプト(脱獄)に対して、拒否反応を示せるかどうかを測定します。

- Hallucinations(ハルシネーション): 事実誤認(ハルシネーション)の発生頻度と回答の正確性を検証します。

- Instruction hierarchy(指示階層): システム、開発者、ユーザーそれぞれの指示の優先順位に正しく従っているかどうかを評価します。

- Safety evaluations hubに掲載されている評価スコアと、各モデルのSystem Cardに記載されている評価結果が異なる場合があるのはなぜですか?

Safety evaluations hubに掲載されている評価スコアは、最新の評価状況を反映しています。一方、System Cardは発行時点でのスナップショットです。

OpenAIでは評価手法やインフラを継続的に改善しており、これにより測定精度が向上するため、両者の数値に差異が生じることがあります。

Safety evaluations hubは、継続的な更新を通じてモデルの改善過程やリスク対応の変遷を可視化する役割も担っています。

まとめ

Safety evaluations hubは、OpenAIが開発した生成AIモデルに対する安全性の評価結果を公開し、その透明性と継続的改善を支える中核的な取り組みです。

特に、Harmful content・Jailbreak・Hallucinations・Instruction hierarchyの4つの評価軸に基づき、多角的にモデル性能が測定されており、今後の安全なAI活用に向けた基盤データとしての価値が高まっています。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp