XAIとは?解釈性の高い出力へのアプローチ手法、メリット・デメリット、活用分野を徹底解説!

最終更新日:2025年08月19日

AI(人工知能)には、出力に至るまでのプロセスがブラックボックス化するという課題があります。回答のみが提供されるため、その回答に信頼性があるかどうかを証明するのは、不可能とされていました。

しかし、こうしたAIの信頼性を高めるために、XAI(説明可能なAI)が開発されました。AIによる説明のアプローチは、ブラックボックスによる信頼性・透明性の低さを解決する手法として注目されています。

この記事では、XAIの概要からアプローチ手法、メリット、課題、活用分野を解説していきます。説明責任を負えるようになり、意思決定のサポートに大きく貢献できるXAIに興味がある方は、最後までご覧ください。

XAIを導入する際にはシステム開発全体の流れや体制づくりが重要となるため、AIシステム開発に必要な体制作り、工数や手順についてはこちらの記事で詳しく説明していますので併せてご覧ください。

貴社ニーズに特化したAI開発に強い開発会社の選定・紹介を行います

今年度AIシステム開発相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・画像認識、予測、LLM等、AI全対応

完全無料・最短1日でご紹介 AI開発に強い会社選定を依頼する

AI開発会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

目次

XAIとは?

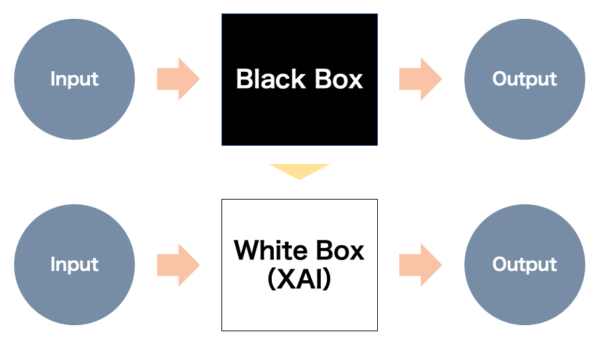

XAI(Explainable AI)とは、AIの出力結果がどのように導かれたのかをユーザーが理解できるようにするための技術とアプローチを指します。

近年のAI開発においては、高度な予測精度だけでなく、判断の根拠を明確に示せることが求められており、XAIの重要性が増しています。AIの判断根拠を人間が理解できる形で説明する手法であり、「説明可能なAI」として注目されています。AIの判断根拠を人間が理解できる形で説明する手法であり、「説明可能なAI」として注目されています。

AIがどのようなデータや基準に基づいて決定を下しているのかを可視化し、その根拠を明確にすることで、出力結果の信頼性や透明性を高めます。これにより、多くの分野での応用や信頼性の向上を実現します。

例えば、個人情報を利用する場合や偏見を排除することが求められる分野で必要とされており、AIの「ブラックボックス」問題を解決し、AIの判断が公平であるかを確認するための手段として、XAIは実用化が期待されています。

AIに説明が求められる理由

AIの判断に説明が求められる背景には、信頼性の確保や社会的な責任が深く関わっています。AI技術は医療や金融、法律などの専門的かつ社会に影響を及ぼす分野で利用されるようになり、その意思決定が人々の生活や利益に影響を及ぼすケースが増加しています。

しかし、従来のAIでは出力に至るまでのプロセスが説明できない、いわゆるブラックボックス化が課題とされてきました。なぜAIが特定の判断を下したのか、その根拠を理解できないため、AIによる回答の信頼性・透明性が不確実となります。

現在でも医療や金融などの分野においてAIの実用化が進んでいない主要な理由の一つと言われています。

AIやAGI(汎用人工知能)を超越した知能を持つとされるASI(人工超知能)を実現するためにも、XAIは欠かすことのできない技術です。ASIはあらゆる分野で人間の知的能力を上回り、自己改良や学習を通じて自律的に進化することができる知能とされています。

貴社ニーズに特化したAI開発に強い開発会社の選定・紹介を行います

今年度AIシステム開発相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・画像認識、予測、LLM等、AI全対応

完全無料・最短1日でご紹介 AI開発に強い会社選定を依頼する

XAIのメリット

XAIは、従来のAIモデルにはなかった新たなメリットを提供してくれます。XAIの具体的なメリットについて見ていきましょう。

出力結果の信頼性・透明性の向上

XAIの導入によって、AIモデルの出力結果に対する信頼性と透明性が向上します。特に、マルチモーダルAIのように複数のデータを統合処理するモデルでは、判断過程が複雑になりやすく、XAIによる根拠の可視化が重要になります。

従来のAIモデルはブラックボックスとして扱われることが多く、ユーザーは予測結果を得るものの、その判断根拠を把握するのが困難でした。

しかし、XAIを用いることで、モデルがどの特徴や要因に基づいて判断を下しているかが明確になり、結果に対する納得感や信頼が得られます。これにより、医療診断や金融リスク評価といった分野では、AIの判断に基づいた意思決定を行えるようになります。

法的・倫理的な遵守

AIが医療や金融、公共サービスといった分野で広く利用されるようになるにつれ、その判断や行動が社会的責任を伴う場面も増加しています。こうした状況下で、AIがどのようにして特定の結論に達したのかを明らかにすることは、法的な監査や倫理的な確認においても重要です。

XAIによる根拠の明確化によって、判断が倫理的に行われていることを可視化できるため、企業は法的リスクを軽減し、透明性のあるサービスを提供することが可能です。こうした法的・倫理的な遵守が保障されることで、AIの利用は社会的に受け入れられやすくなり、より多くの分野での応用が進む要因となります。

公平性の確保とバイアスの軽減

AIモデルが学習に使用するデータには、意図せず偏りが含まれていることがあり、その結果として予測や判断にバイアスがかかる場合があります。このような偏見が反映されたままのAIを利用すると、社会的に不公平な結果を生み出すリスクが生じます。

XAIは判断における根拠を明確にすることで、特徴が予測に対してどれくらい影響しているのかを可視化し、バイアスが存在するかどうかを検証します。これにより、不公正な影響を排除するための修正を行いやすくなります。

結果として透明性と公平性が担保されることで、AIの信頼性が向上し、バイアスを軽減することにもつながります。

XAIによる説明が特に必要とされている分野

XAIによる説明は、以下のような分野において重要視され、導入や実用化に必須とされています。

- 医療

- 金融

- 人事・採用

- 法律

それぞれの分野とXAIについて解説していきます。

医療

医療分野では、AIが診断や治療方針の提案、リスク予測などに活用されており、その判断根拠を説明するXAIの重要性が高まっています。

医師がAIの提案を基に意思決定を行う際、AIがどのように判断したのかを理解できなければ、信頼を持って治療に臨むことが難しくなります。例えば、AIが「がんのリスクが高い」と判断した場合、その根拠となる画像や患者の特徴がどれであるかを医師や患者に説明できなければ、命に関わる誤診を招く危険性があります。

高度な画像処理とAIアルゴリズムを統合し、様々な医療専門分野における診断、治療計画、回復支援を促進しています。このような技術の進歩により、未知の異常や稀少な疾患の検出能力が向上し、より包括的な医療診断が可能になっています。

未知物体検出技術も、この課題に対して新たな可能性を開いています。既知の疾患を分類するだけでなく、新しい/未知の疾患を検出することができます。この技術は、COVID-19のような新興感染症の早期発見にも応用可能であることが示されています。

医療のような命に関わる領域では、AIの導入による利便性だけでなく、XAIを用いた判断の根拠提示が明確になることで、安全で信頼性の高い医療サービスの提供につながります。

金融

金融分野では、主にローン審査や信用スコアリング、リスク管理などの業務においてXAIの導入が期待されています。

ローン審査でAIが「貸付可」と判断した根拠が示されると、銀行や金融機関は、その決定をより正確かつ公平なものとして説明でき、顧客に対する透明性も向上します。信用スコアリングにおいても、AIが重視した個々の要素(収入、信用履歴、支出など)を理解することで、顧客は自身の信用度を改善する具体的な方策を見出しやすくなります。

さらに、XAIは市場予測やポートフォリオ管理におけるリスク根拠を説明できるため、金融機関や投資家の意思決定をサポートします。金融分野では事務的な業務をAI化するケースはありましたが、XAIによってよりお金の動きにAIを活用できるようになるでしょう。

人事・採用

人事・採用分野では、人材評価にAIが利用されることが増え、XAIによる判断の説明が重要視されています。AIが応募者の適性やスキルを評価する際、その判断基準や根拠が明確でなければ、候補者や採用担当者にとって不透明さが残り、不公平な採用結果を招く可能性もあります。

また、XAIは潜在的なバイアスを排除するためにも有効です。年齢や性別、人種などの属性が判断に不当に影響を与えていないかを確認できるため、企業は公正かつ客観的な採用基準を守りやすくなります。

これにより、候補者にとっても自分がどの点で評価されたのかが理解でき、採用への信頼感が向上します。応募者とのミスマッチングを防ぎ、適切な人材を確実に採用できるようになります。

法律

契約書のリーガルチェックや判例の分析、法的リスクの評価といった法律分野においてもAIの活用が期待されており、XAIがその信頼性や透明性を高めるのに欠かせない技術となります。

AIが法的な文書を解析し、リスクのある条項を指摘する場合、その根拠が不透明だと弁護士やクライアントが結果を信頼しづらくなります。XAIによって、なぜ特定の条項がリスクと見なされたのかが説明できれば、法的判断に対する信頼性と理解が高まります。

さらに、XAIはAIが判例データを用いて結論を導く際に、どの判例や要因を重視したのかを明示するため、弁護士が戦略を組み立てる上でも有効です。AIの出力が透明であれば、法的助言や裁判の準備においても意思決定の精度が向上し、クライアントの信頼感が高まります。

法律のように高い正確性と説明責任が求められる分野で、XAIはAI活用の推進に不可欠な要素となっています。

貴社ニーズに特化したAI開発に強い開発会社の選定・紹介を行います

今年度AIシステム開発相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・画像認識、予測、LLM等、AI全対応

完全無料・最短1日でご紹介 AI開発に強い会社選定を依頼する

XAIを実現する大域的説明アプローチ

XAIを実現するための主な技術的手法は、大きく「大域的説明」と「局所的説明」の2つのアプローチに分類されます。大域的説明(Global Explanation)は、AIモデル全体の振る舞いを解釈することを目的としています。

手法を組み合わせたり、問題の性質に応じて適切な手法を選択したりすることで、AIモデルの判断プロセスをより包括的に理解し、説明することが可能になります。

Permutation Importance

Permutation Importanceは、各特徴がモデルの予測にどれだけ重要かを評価するための手法です。ある特徴の値をランダムに並び替え、モデルのパフォーマンスの変化を観察し、特徴の重要度を測定します。

Permutation Importanceのメリットは、モデルが持つ複数の特徴の中で、どれがより重要かを直感的に理解できる点です。モデルに依存しないため、回帰や分類モデルなど多様なアルゴリズムに対して汎用的に利用可能です。

特徴量重要度

特徴量重要度は、AIモデルにおいて各入力変数(特徴量)が予測結果にどれだけ影響を与えているかを数値化したものです。各特徴量に対して単一のスコアを割り当てることで、モデルの意思決定プロセスを簡潔に表現します。

代表的な手法には以下があります。

- ランダムフォレストの特徴量重要度

- 勾配ブースティングの特徴量重要度

- 線形モデルの係数の絶対値

モデルの全体的な挙動を簡潔に表現できる強力なツールですが、特徴量間の相互作用や非線形性を捉えきれない場合があるため、他のXAI手法と組み合わせて使用することが推奨されます。

XAIを実現する局所的説明アプローチ

局所的説明(Local Explanation)は、特定の入力に対するモデルの予測を説明することに焦点を当てます。手法を組み合わせることで、AIモデルの判断プロセスをより包括的に説明し、透明性と解釈可能性を向上させることができます。

LIME

LIME(Local Interpretable Model-agnostic Explanations)は、特定の入力データに対するモデルの判断根拠を、局所的に解釈可能にする手法です。LIMEは複雑なAIモデルに対して適用可能で、モデル自体の仕組みに依存しない方法で解釈する点が特徴です。

解釈可能なモデル(線形回帰や決定木など)を使用して、元のモデルを局所的に近似します。

LIMEでは、データの局所的な特徴が予測にどれだけ影響を及ぼしているかが明らかにすることが可能で、ユーザーはモデルの判断における要因を直感的に理解できます。

SHAP

SHAP(SHapley Additive exPlanations)とは、ゲーム理論に基づいてAIモデルの判断根拠を説明する手法であり、各特徴が予測結果に与える影響を評価することが可能です。

SHAPは、各特徴量のシャープレイ値(SHAP値)を算出することで、個々の特徴が予測結果にどれだけ貢献しているかを明らかにします。シャープレイ値とは、ゲーム理論で各プレイヤーが共同で得た成果に対してどの程度貢献したかを示す数値です。

AIモデルがどのような要素を重要視しているのかを理解できるようにしています。

SHAPでは、複数の特徴が同時に影響を与えるような状況でも、各特徴の貢献度を分解し、個別に評価することを可能にします。モデルが扱うデータの多様な要素を反映するため、複雑なモデルの解釈にも有効です。

Integrated Gradients(統合勾配)

Integrated Gradientsは、ニューラルネットワークの各入力特徴が予測結果にどれだけ寄与しているかを可視化する手法で、ディープラーニングモデルの解釈に適しています。入力値をゼロ(ベースライン)にした場合から実際の入力値に近づくまでの勾配を積分することで、予測における各特徴の影響度を示します。

Integrated Gradientsはモデルの内部構造に沿った形で解釈ができるため、画像認識や自然言語処理などの高次元データに適しています。これによってディープラーニングのブラックボックス性を低減し、ユーザーにとっても理解しやすい解釈を提供するのに役立ちます。

Attention機構(注意機構)

Attention機構(注意機構)は、モデルが重要な情報に注意を集中させることで、より精度の高い予測や解釈を可能にする手法です。

自然言語処理(NLP)におけるディープラーニングモデルであるTransformer(トランスフォーマー)を設計する技術です。文中の重要な単語やフレーズに焦点を当てることで複雑なタスクの性能を向上させる役割を担っています。

例えば、テキスト分類において「このレビューは肯定的である」という判断をモデルが下した際、どの単語やフレーズがその判断に影響を与えたのかが明確になります。このように、Attention機構(注意機構)はモデル内部が注目するポイントを可視化することで、モデルの解釈性を高め、より透明な判断を可能にします。

貴社ニーズに特化したAI開発に強い開発会社の選定・紹介を行います

今年度AIシステム開発相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・画像認識、予測、LLM等、AI全対応

完全無料・最短1日でご紹介 AI開発に強い会社選定を依頼する

XAIを実現するその他のアプローチ

局所的説明(Local Explanation)は、特定の入力に対するモデルの予測を説明することに焦点を当てます。実際の適用においては、問題の性質やモデルの種類、説明の目的に応じて適切な手法を選択することが重要です。

決定木

決定木は、データの特徴に基づいて意思決定を行うモデルであり、判断過程を分かりやすく視覚化できます。木構造の各ノードは、データの特徴に基づいて「はい」か「いいえ」で分岐するため、最終的な予測に至るまでの道筋をユーザーが直感的に理解することが可能です。

複雑な計算を行うブラックボックス型のモデルとは異なり、決定木では特徴の重要度や判断基準が明確に示され、結果の根拠をユーザーに説明しやすくなります。さらに、重要な特徴を特定することも簡単であり、モデルがどのデータポイントを重視しているのかを把握しやすくすることも可能です。

XAIの課題

XAIには多くのメリットがある一方で、実装や活用に際して解決すべき課題も存在します。ここでは、実用化の障害となっている課題について解説していきます。

実装までに時間とコストがかかる

XAIを導入するには、通常のAIモデルに比べ追加のリソースや技術が必要であり、実装までに多くの時間とコストがかかることが大きな課題となります。従来のAIモデルでは予測精度を追求することが優先されてきましたが、XAIではその予測や判断を説明可能にする必要があるため、開発に追加の工数が求められます。

さらに、複雑なアルゴリズムを解釈可能な形に変換するためには、高度な専門知識と技術が必要であり、人件費やツールの導入コストに影響するでしょう。そのため、企業はどのアプローチが最適かを判断するためのリサーチや試行錯誤も必要であり、総合的なコスト負担がかかることは考慮しなければいけません。

複雑なモデルへの適用は難しい

ディープラーニングをはじめとする高度なモデルは、膨大なパラメータと多層構造で構成されており、各層の相互作用が予測結果に影響を与えています。このようなモデルは高い精度を誇る一方で、内部構造が複雑すぎるために、判断過程を解釈するのが難しいという問題があります。

本記事で紹介した手法もモデルの複雑さに伴い精度や解釈性が低下することがあり、処理速度が遅くなるといった制約も発生します。そのため、企業や開発者は高精度なモデルの採用と説明可能性の確保とのバランスを見極める必要があります。

説明の正確性は保証されない

XAIの手法によって提供される説明は、必ずしも正確性が保証されているわけではありません。多くのXAIアプローチはあくまで近似的な解釈であるため、モデルの真の判断基準を完全に再現できるとは言えないでしょう。

特に、モデルが複雑な構造を持つ場合や、特徴間の相互作用が強い場合、得られた説明が予測の実態とは異なる可能性があるのです。

さらに、ユーザーが得た説明を「正確である」と過信してしまうリスクも存在します。これはAIが生成した説明を誤解し、不適切な意思決定につながる恐れがあることを意味します。

したがって、XAIが出力する情報であっても参考情報として捉え、常に人間による補完的な判断を行いましょう。XAIはAIモデルのブラックボックス性を軽減する一方で、提供される説明の正確性には限界があることを理解する必要があります。

XAIについてよくある質問まとめ

- 説明可能AI(XAI)とは?

XAIは「Explainable AI」の略で、AIの動作を多角的に理解し、信頼性を高めることを目的とした技術を指します。日本語では「説明可能なAI」と呼ばれ、出力結果や判断の根拠を説明できるAIを意味します。

- XAIにはどんな種類がありますか?

XAIにはいくつかの手法が存在し、「大域的な説明(Global Explanation)」と「局所的な説明(Local Explanation)」という2つの主要なアプローチに分類されます。

- XAIを導入するメリットは?

XAIはAIの判断根拠を明確に示すことで、誤判断の特定を容易にします。これにより、AIによるエラーの発生頻度やその影響を抑えることができます。また、AIの判断にバイアスがないか確認でき、公平性の担保にも役立ちます。

- XAIの実装において注意すべき課題は何ですか?

主な課題は3点あります。1つ目は実装に追加の時間とコストが必要なこと。2つ目は複雑なディープラーニングモデルへの適用が技術的に困難なこと。3つ目は説明の完全な正確性が保証されないため、人による判断の補完が必要なことです。

まとめ

XAI(説明可能なAI)は、AIの判断根拠を理解可能な形で提示し、その信頼性と透明性を高める技術です。医療や金融、人事、法律などの分野において、XAIは公平性や法的遵守、倫理的な配慮を確保するための役割を担っています。

一方で、XAIには導入コスト説明精度の限界といった課題も存在します。それでも、AIがより広範な分野で活用されていく今、XAIを適切に活用し、安全で有益な環境を構築することがますます重要になるでしょう。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp