Meta、オープンソース且つこれまでで最も高性能な「Llama 3.1 405B」モデルを公開

最終更新日:2024年10月10日

記事監修者:AI Market ニュース配信チーム

2024年7月23日、Metaは最新の大規模言語AIモデル「Llama 3.1」シリーズを発表した。この中で特に注目を集めているのが、4050億パラメータを持つ「Llama 3.1 405B」モデルだ。

これは、オープンソースAIモデルとしては世界最大規模であり、性能面でも非公開モデルに匹敵する能力を持つという。

<本ニュースの10秒要約>

- 4050億パラメータを持つ大規模オープンソースAIモデル「Llama 3.1 405B」の登場

- 8言語対応と12万8千トークンのコンテキスト長を実現した多言語・長文処理能力の向上

- AIシステム全体の開発を促進するためのツールとAPIの提供によるエコシステムの拡大

関連記事:「オープンソースLLMを徹底比較!特徴・活用メリット・代表モデルの比較ポイントも解説」

Llama 3.1シリーズの特徴と性能

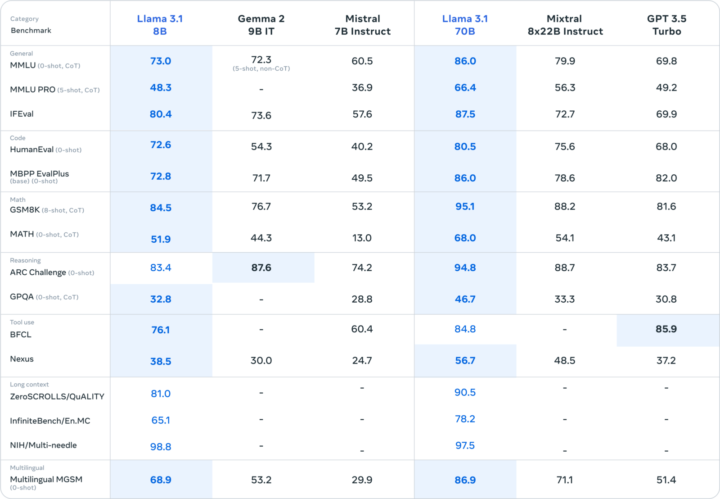

Llama 3.1シリーズは、405Bと8B、70Bのアップグレード版の3つのモデルサイズで構成されている基盤モデル。これらのモデルは、多言語対応と12万8千トークンのコンテキスト長を実現し、高度な推論能力を持つ。

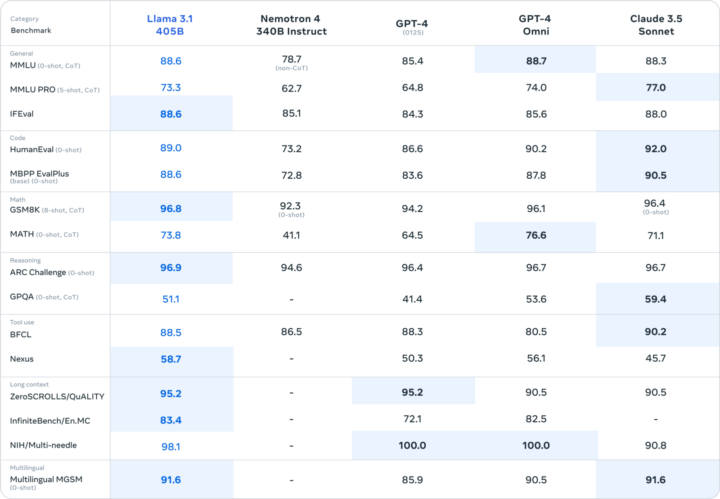

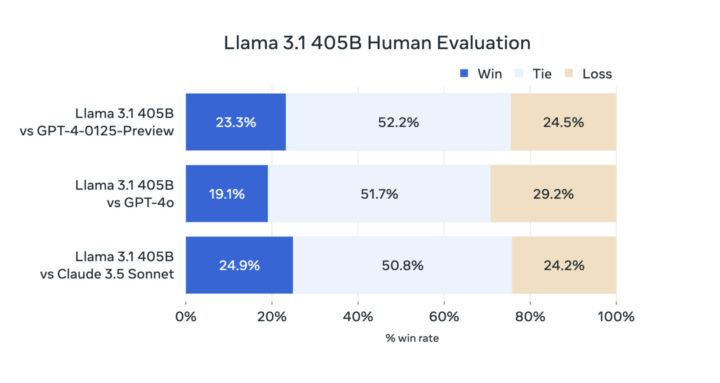

特に405Bモデルは、GPT-4やClaude 3.5 Sonnetなどの非公開モデルと同等の性能を発揮するとされる。Metaは150以上のベンチマークデータセットを用いて評価を行い、実際の使用シナリオでも人間による評価を実施した。これにより、Llama 3.1 405Bが幅広いタスクで競争力を持つことが確認された。

モデルアーキテクチャと学習プロセス

Llama 3.1 405Bの学習には、15兆以上のトークンが使用された。この大規模な学習を可能にするため、Metaは学習スタック全体を最適化し、16,000台以上のH100 GPUを使用した。

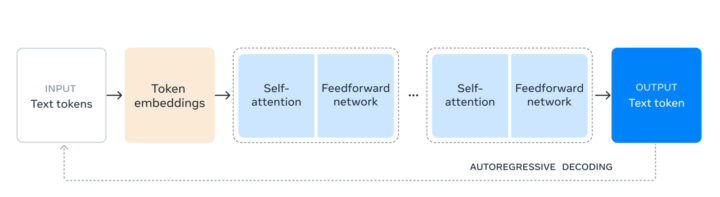

モデルアーキテクチャには、学習の安定性を重視して標準的なデコーダーオンリーのトランスフォーマーモデルを採用している。また、教師あり微調整と直接選好最適化を組み合わせた反復的な後処理手順を導入し、各能力の性能向上を図った。データの質と量の両面で改善を行い、事前学習と後処理のデータ品質を向上させている。

指示対応と安全性への取り組み

Llama 3.1 405Bは、ユーザーの指示に対する応答の質と詳細さを向上させることに重点を置いている。同時に、高レベルの安全性も確保している。モデルの後処理では、教師あり微調整、棄却サンプリング、直接選好最適化を組み合わせた複数のラウンドを実施している。

また、高品質な合成データを生成し、これを厳選してファインチューニングに使用することで、あらゆる能力で高い品質を実現し、さらに、Llama Guard 3という多言語安全モデルやPrompt Guardというプロンプト注入フィルターなど、安全性を高めるための新しいツールも提供している。

Llamaエコシステムの拡大と今後の展望

Metaは、「Llama Stack」と呼ばれる標準化されたインターフェースの提案を行い、エコシステム全体での相互運用性の向上を目指している。

AWSやNVIDIA、Google Cloudなど25以上のパートナー企業と協力し、初日からサービスを提供できる体制を整えている。

参照元:Meta

LLMについて詳しく知りたい方はこちらの記事もご参考ください。

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp