OpenAIが初のオープンウェイト言語モデル「gpt-oss-120b」「gpt-oss-20b」をリリース

最終更新日:2025年08月06日

記事監修者:AI Market ニュース配信チーム

OpenAIは2025年8月5日、Apache 2.0ライセンスで提供される初のオープンウェイト言語モデル「gpt-oss-120b」と「gpt-oss-20b」をリリースした。

gpt-oss-120bは単一80GB GPUで効率稼働しながらo4-miniと同等性能を実現し、gpt-oss-20bは16GBメモリのエッジデバイスでo3-miniと同様の結果を出す。

- OpenAI初のオープンウェイト言語モデル2種類をApache 2.0ライセンスで無償提供開始

- gpt-oss-120bは80GB GPU、gpt-oss-20bは16GBメモリで動作する効率的設計を採用

- 推論タスクでo3-miniやo4-miniと同等以上の性能を発揮し、ツール使用機能も搭載

OpenAIが発表したgpt-oss-120bとgpt-oss-20bは、GPT-2以来初となる同社のオープンウェイト言語モデルだ。

両モデルはmixture-of-experts(MoE)アーキテクチャを採用し、gpt-oss-120bは総パラメータ117億個でトークンごとに51億個をアクティブにし、gpt-oss-20bは総パラメータ21億個でトークンごとに36億個をアクティブにする。

モデルは36層(120b)と24層(20b)の構成で、128個と32個のエキスパートをそれぞれ持ち、最大128kのコンテキスト長をネイティブサポートする。

事前学習にはSTEM、コーディング、一般知識に重点を置いた高品質英語データセットを使用し、OpenAI o4-miniとGPT-4oのトークナイザーのスーパーセット「o200k_harmony」でトークン化を実施した。

事後学習においては、o4-miniで使用されたプロセスと同様の教師ありファインチューニングと高計算RL段階を経て、OpenAI Model Specに合わせた調整を行った。

モデルは回答生成前にCoT推論の適用とツール使用を学習し、レイテンシとパフォーマンスをトレードオフする3種類の推論レベル(低、中、高)をサポートする。開発者はシステムメッセージ内でreasoning_effortを簡単に設定可能だ。

安全性面では、事前学習でCBRN関連の有害データを除外し、事後学習では熟慮的アライメントと指示階層を用いて安全でないプロンプト拒否とプロンプトインジェクション防止を学習させた。

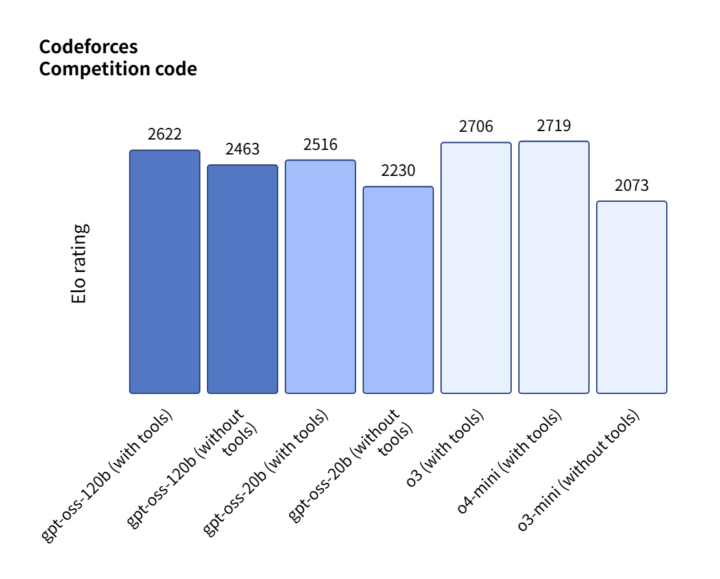

評価結果では、gpt-oss-120bが競技コーディング(Codeforces)、一般問題解決(MMLU および HLE)、ツール呼び出し(TauBench)でo3-miniを上回り、o4-miniに匹敵または上回る性能を示した。

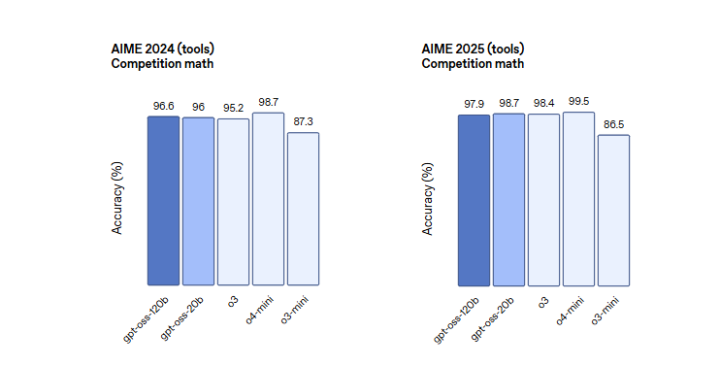

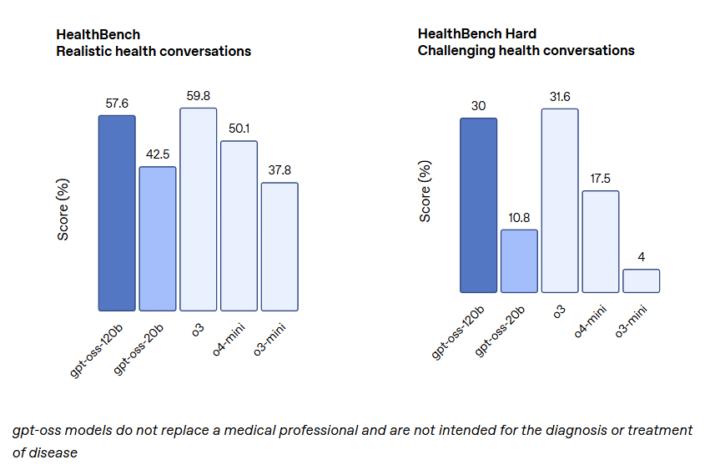

特に健康関連クエリ(HealthBench)と競争数学(AIME 2024 & 2025) ではo4-miniより優秀な結果を記録している。gpt-oss-20bはサイズが小さいにもかかわらずo3-miniに匹敵または上回る性能を発揮し、競争数学と健康分野では上回った。

両モデルとも、CodeforcesでそれぞれEloレーティング2622、2516を記録し、AIME 2024では96.6%、96%の精度を達成した。

HealthBenchでは57.6%、59.8%のスコアを獲得し、o3の37.8%を大きく上回る結果となった。

モデルはHugging FaceからMXFP4で数値化された状態で無料ダウンロード可能で、gpt-oss-120bは80GBメモリ、gpt-oss-20bは16GBメモリで実行できる。ハーモニープロンプト形式で事後学習されており、PythonとRustのハーモニーレンダラーがオープンソース化される。

PyTorchとApple Metalプラットフォーム上での推論リファレンス実装とサンプルツールコレクションもリリースされる。

Hugging Face、Azure、vLLM、Ollama、llama.cpp、LM Studio、AWS、Fireworks、Together AI、Baseten、Databricks、Vercel、Cloudflare、OpenRouterなど主要展開プラットフォームとの提携により、開発者の広範な利用を支援する。

AI Marketの見解

今回のOpenAIによるオープンウェイトモデルリリースは、AI業界における戦略的転換点と想定される。

技術的観点から、MoEアーキテクチャの採用により計算効率を大幅に改善し、限られたハードウェアリソースでも高性能を実現している点が注目に値する。

特にgpt-oss-20bが16GBメモリで動作する設計は、エッジコンピューティングやローカル推論の普及を加速させると想定される。

ビジネス的には、Apache 2.0ライセンスでの無償提供により、中小企業や研究機関のAI活用障壁が大幅に低下し、新たな市場創出が期待される。

OpenAIがオープンソース戦略に転換した背景には、Google、Meta、Anthropicとの競争激化と、オープンソースエコシステムでの影響力確保という戦略的意図があると想定される。

今後の市場では、プロプライエタリモデルとオープンモデルの共存が進み、用途に応じた選択肢の多様化が促進されると想定される。

参照元:OpenAI

gpt-ossモデルに関するよくある質問まとめ

- gpt-oss-120bとgpt-oss-20bの主な違いはなんですか?

gpt-oss-120bは総パラメータ117億個で80GBメモリが必要で、gpt-oss-20bは総パラメータ21億個で16GBメモリで動作します。120bモデルはより高性能だが、20bモデルはエッジデバイスでの利用に適しています。

- これらのモデルは商用利用できますか?

はい、Apache 2.0ライセンスで提供されているため、商用利用が可能です。ライセンス条件に従えば、企業での利用や製品への組み込みも認められています。

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp