BitNet b1.58が1ビットLLMと呼ばれる理由は?メリット・概要・活用方法について徹底解説!

最終更新日:2025年08月21日

1ビットLLMは、従来のLLMと比較して大幅に軽量化・効率化されたモデルです。Microsoftと中国科学院大学の共同研究チームがBitNet b1.58という画期的なSLMを発表した2024年の論文で提唱された用語です。

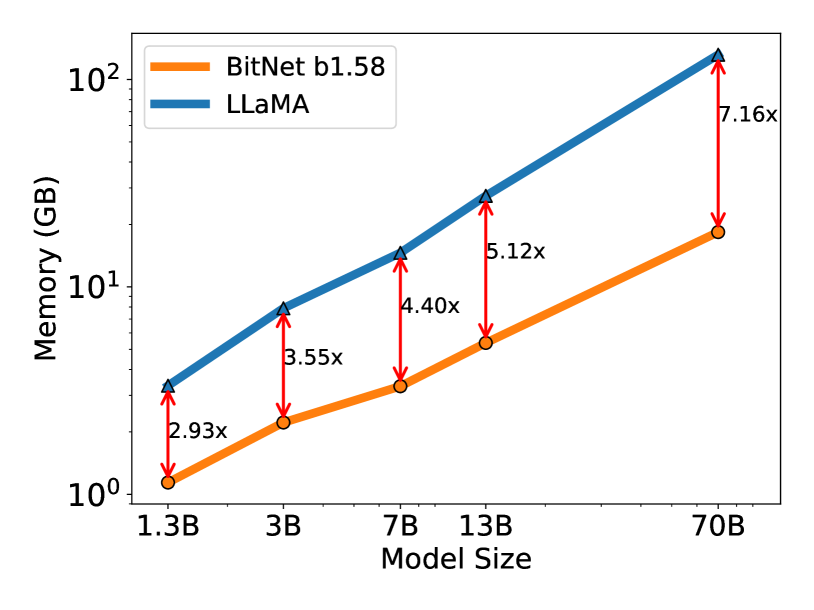

従来32ビットで表現していたモデルのパラメータを、わずか1.58ビットまで圧縮することで、必要なメモリ容量を7分の1程度に抑えることができるという小型LLMです。

本記事では、

LLMについてはこちらで詳しく説明していますので併せてご覧ください。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

ChatGPT/LLM導入・カスタマイズに強いAI開発会社を自力で選びたい方はこちらで特集していますので併せてご覧ください。

目次

BitNet b1.58が1ビットLLMと呼ばれる理由は?

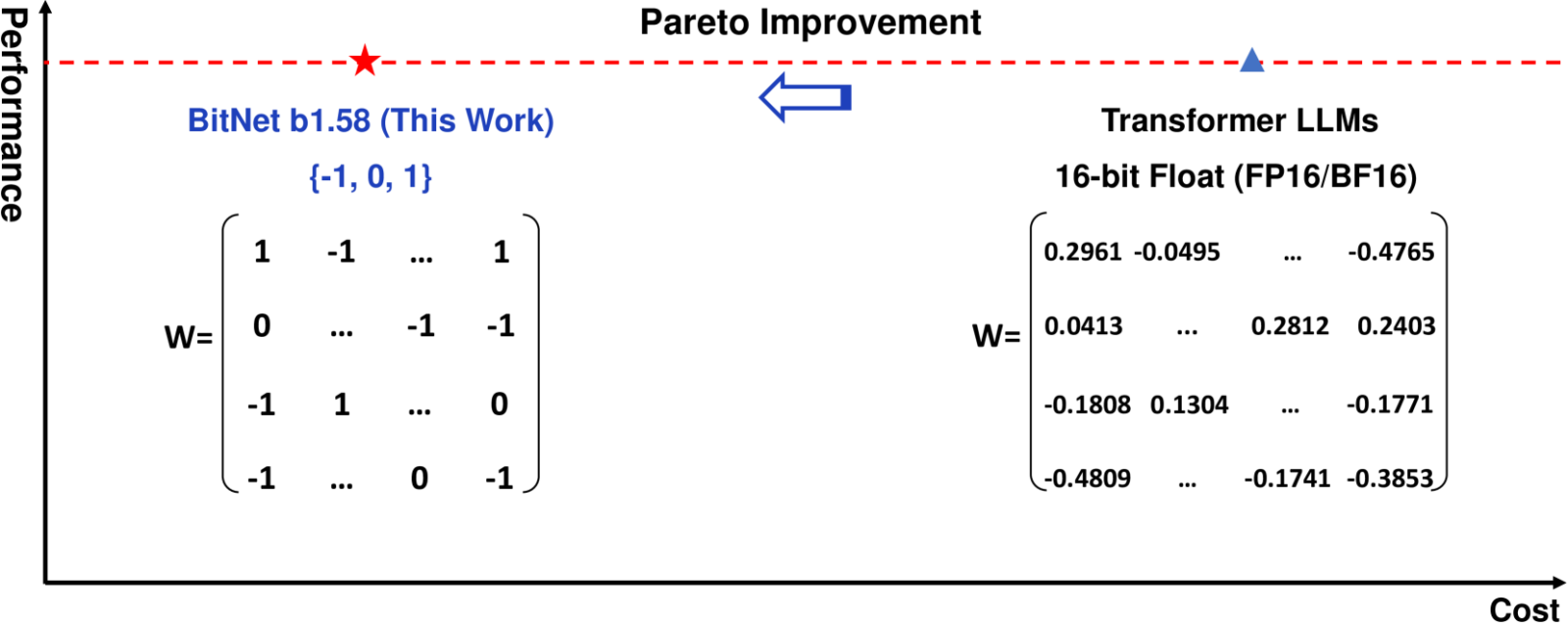

BitNet b1.58の「1.58」という数字は、パラメータの表現に使用されるビット数を示しています。BitNet b1.58では、各パラメータの重みを量子化し、-1、0、1の3つの値で表現しています。

情報理論では、3個の異なる状態を表現するのに必要なビット数はlog2(3) ≈ 1.58496…ですので、丸めて1.58ビットです。

ですので、より厳密には「1.58ビット」です。しかし、マーケティング的な効果も考えて、従来の多ビット表現と比べて極端に少ない情報量「1ビットLLM」という表現で注目を集めようとしているようです。

-1、0、1の3つの値で表現したことにより、従来の1ビット(2値)や2ビット(4値)表現よりも効率的にデータを圧縮できます。

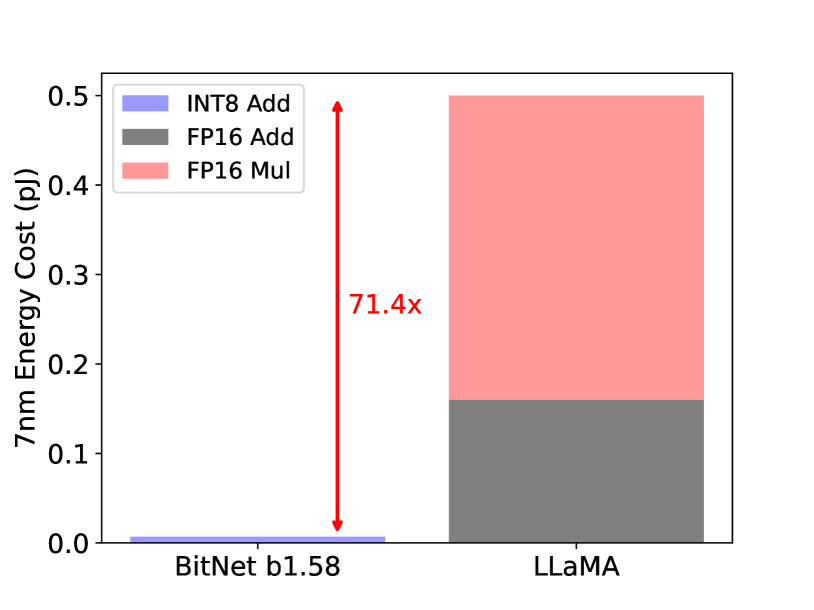

また、3値表現により、行列演算での複雑な乗算が不要になり、加算と減算のみで行えます。これにより計算速度が向上し、エネルギー効率も改善されます。

1ビットLLM、BitNet b1.58の技術は、モデルのパラメータを極限まで圧縮し、効率性を飛躍的に向上させることを目指しています。Microsoftの提供するPhi-3のようなSLM(小規模言語モデル)と同様のアプローチと言えるでしょう。

関連記事:「LLM・SLM・VLM・MLLM・LVM・LMMなどの用語、意味が分かる!」

BitNet b1.58と従来モデルとの性能比較

BitNet b1.58の性能は、多くの研究者や開発者の予想を上回るものでした。3値表現の圧縮方法でありながら、16ビットや32ビットといった多ビットのモデルと同等の性能を維持できることが示されています。

従来の高精度モデルと比較して、特定のタスクにおいては同等以上の性能を示すケースも報告されています。

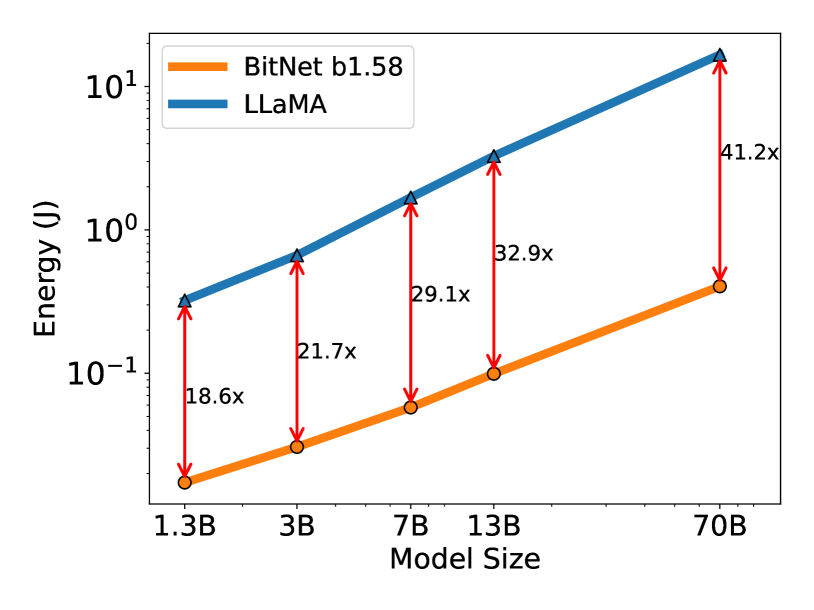

例えば、テキスト生成や質問応答などの一般的な自然言語処理(NLP)タスクにおいて、BitNet b1.58は従来のLLMと遜色ない結果を出しています。例えば、上記論文ではLLaMA 70Bモデルと比較して、メモリ消費は7.16倍少なく、レイテンシは4.1倍高速で、行列乗算のエネルギー消費も71.4倍削減されています。

ゼロショット精度においても、従来のモデルと遜色ない結果を示しています。

参照:arXiv|The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

1ビットLLM(BitNet b1.58)を使うメリットは?

1ビットLLMの登場は、従来のLLMが抱えていた課題を解決し、AIの実用性と効率性を飛躍的に向上させる可能性があります。

メモリ使用量の大幅削減効果

1ビットLLMの最も顕著な利点は、メモリ使用量の劇的な削減です。従来の32ビットLLMと比較して、1ビットLLMは同じモデルサイズでありながら、必要なメモリ容量を抑えることができます。

この削減効果は、モデルの規模が大きくなるほど顕著になります。例えば、70BパラメータのBitNet b1.58モデルは、同規模のLLaMAモデルと比較して7.16倍少ないメモリで動作することが可能です。

この大幅なメモリ削減により、LLMを比較的小さなハードウェア上で実行できるローカルLLMができるようになり、AIの応用範囲を大きく広げる可能性があります。

具体的には、ローカルLLMを活用することで、インターネットを介さない情報のやり取りができるため、高セキュリティなLLM運用が可能になったり、高速での処理が可能になるため、金融機関や政府機関など、堅牢なシステム構築が必要な場面での活用も期待されます。

関連記事:「ローカルLLMの概要や従来のLLMとの違い、メリット、課題、構築方法を解説」

計算コストの低減と処理速度の向上

BitNet b1.58の場合、従来のLLMと比較して推論時の処理速度が大幅に向上しています。具体的には、70BパラメータのモデルでLLaMAの4.1倍の速度で推論を行うことができます。この高速化は、1ビット表現による演算の簡素化と、専用のハードウェア最適化の可能性によるものです。

さらに、スループットの面でも大きな改善が見られ、同じハードウェア上で8.9倍高いスループットを実現しています。これは、1ビットLLMが単位時間あたりに処理できるデータ量が従来モデルの8.9倍に増加したことを意味します。

これらの改善により、リアルタイムの応答が求められるアプリケーションや、大量のデータ処理が必要なタスクにおいて、1ビットLLMは大きな優位性を持つことになります。

省エネルギー化への貢献

1ビットLLMの登場は、AI技術の省エネルギー化にも大きく貢献しています。従来のLLMは、その巨大なモデルサイズと複雑な計算プロセスにより、膨大な電力を消費することが問題視されていました。

しかし、1ビットLLMはこの課題に対する有力な解決策となる可能性があります。メモリ使用量の削減と計算の簡素化により、同じタスクを処理する際の消費電力を大幅に抑えることができるのです。

この省エネルギー効果は、データセンターの運用コスト削減だけでなく、AIの環境負荷低減にも直結します。

これにより、エッジデバイスやモバイル機器でのAI実装が容易になることで、より広範囲でのAI活用を可能にし、社会全体のエネルギー効率化にも寄与する可能性があります。さらに、VLM(Visual Language Model)は、視覚情報を組み合わせることで、より効率的なデータ処理と省エネルギー化を実現する可能性があります。

また、BitNet b1.58がオープンソースLLMであるという特性は、利用者や研究者が独自の最適化を行いやすい環境を提供し、持続的な省エネルギー効果の向上にも寄与します。

1ビットLLMの普及は、AIの持続可能な発展と環境への配慮を両立させる重要な技術革新として注目されています。

BitNet b1.58の幅広い活用方法

BitNet b1.58の軽量性と効率性を活かすことで、これまでは実現が困難だった領域でのAI実装が可能になります。と言っても、現時点では主に研究段階にあり、実際の応用にはさらなる開発と検証が必要です。今後の技術の進展と実用化に注目が集まっています。

ここでは、BitNet b1.58の主要な活用方法について詳しく見ていきましょう。

モバイルデバイスでのAI実装

1ビットLLMとも呼ばれるBitNet b1.58の登場により、の登場により、スマートフォンやタブレットなどのモバイルデバイスでの高度なAI機能の実装が現実味を帯びてきました。従来のLLMでは、その大きなモデルサイズと高い計算要求のため、モバイルデバイスでの直接的な実行は困難でした。

しかし、1ビットLLMを用いることで、以下のようなエッジLLMとしての応用を実現することが可能になります。

- 例えば、オフラインでも動作する高性能な翻訳アプリ

- ユーザーの行動パターンを学習して最適な提案を行うパーソナルアシスタント

- デバイス上でリアルタイムの自然言語処理

これにより、プライバシーの向上やネットワーク遅延の解消、さらにはバッテリー消費の削減など、ユーザー体験の大幅な改善が期待できます。

IoTセンサーネットワークでの活用

IoT(Internet of Things)デバイスは、限られた計算リソースと電力供給の中で動作する必要があります。1ビットLLM(BitNet b1.58)は、IoTのようなリソース制約の厳しい環境下でも高度な分析や意思決定を可能にします。

例えば、農業分野では、土壌センサーや気象ステーションからのデータをBitNet b1.58で分析することで、リアルタイムでの灌漑制御や病害虫予測が可能になります。また、工場の生産ラインでは、各種センサーからの情報を即座に解析し、製品品質の予測や設備の予防保全を行うことができます。

これらの応用により、IoTネットワークの知能化が進み、より効率的で自律的なシステムの構築が可能になります。

関連記事:「センサーの種類や選び方、IoTセンサーとAIを組み合わせたさまざまな産業での活用事例」

クラウドインフラの効率化

BitNet b1.58の導入は、クラウドインフラの効率化にも大きく貢献します。データセンターでは、従来のLLMの運用に膨大な計算リソースと電力が必要でしたが、1ビットLLMを採用することで、同じハードウェア上でより多くのモデルを並行して稼働させることが可能になります。

さらに、MLLMの柔軟なマルチモーダル処理能力を活用することで、クラウド上で異なる種類のデータを同時に効率良く扱うことが期待されます。

これにより、クラウドサービスのコスト削減やスケーラビリティの向上が実現します。例えば、大規模な顧客サポートシステムでは、1ビットLLMを用いることで、より多くのユーザーリクエストを同時に処理できるようになります。

また、ビッグデータ分析やリアルタイムの意思決定支援システムなど、高度な計算能力を要する分野でも、より効率的なリソース利用が可能になります。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

まとめ

BitNet b1.58によって現実味を帯びてきた1ビットLLM技術は、AIの実装コストを大幅に下げる可能性を秘めています。モバイルデバイスでの高度なAI機能の実装、IoTセンサーネットワークでの活用、クラウドインフラの効率化など、幅広い分野での応用が期待されています。

しかし、BitNet b1.58の活用には、精度と効率性のバランスや、既存システムとの統合など検討すべき課題もあります。

1ビットLLMについてよくある質問まとめ

- BitNet b1.58の特徴と性能はどうですか?

BitNet b1.58は1ビットLLMを提唱したモデルで、パラメータを-1、0、1の3値で表現します。この微調整により、効率性を維持しつつ表現力を向上させています。性能面では、特定のタスクで従来の32ビットモデルと同等以上の結果を示し、計算効率では圧倒的な優位性があります。

- 1ビットLLMは従来のLLMと比べて性能面での制約はありますか?

一般的なタスクでは従来モデルと同等の性能を示していますが、特に高度な推論や創造的なタスクについては、実証実験を通じた検証が推奨されます。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp