Llamaとは?Meta社LLMの料金プランやモデル一覧、機能、他の生成AIとの違いを徹底解説!

最終更新日:2026年02月06日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

- Metaが開発したLlamaは、高性能ながら原則無料で商用利用も可能なオープンソースのLLM(大規模言語モデル)

- クローズドなモデル(ChatGPT等)と異なり、自社の業務データで自由にカスタマイズでき、オンプレミスなどセキュアな環境で運用できる点が大きな利点

- モデル自体は無料ですが、その能力を最大限に引き出すには、環境構築や継続的な運用保守といった専門的な技術力が不可欠であり、導入には計画的なリソース確保

Meta社(旧Facebook)が開発したLlamaシリーズは、ChatGPTやGemini、Claudeと並ぶ性能を持つLLM(大規模言語モデル)でありながら、オープンソースとして無料で利用できることが特徴です。商用利用にも対応しているため、ファインチューニングモデルを構築したり、オフラインで利用できるようにしたりと、エンジニアや開発担当者にとって柔軟性の高い選択肢となっています。

また、モデルのバリエーションも豊富で、軽量なものから高性能なマルチモーダル対応モデルまで揃っており、用途やリソースに応じて最適な構成を選べる点も魅力です。

この記事では、Llamaとは何かという基本から、料金体系、ChatGPTなど主要モデルとの戦略的な違い、そしてビジネスで活用するための導入ステップから注意点までを解説します。導入を検討している方に役立つ内容となっていますので最後までご覧ください。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

LLMに強いAI会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

目次

Llamaとは?

Llama(ラマ)とは、Meta社(旧Facebook)が開発したオープンソースのLLM(大規模言語モデル)です。OpenAIのChatGPTやGoogleのGeminiと並び、自然言語処理、画像生成分野における高性能で実用的なAIモデルとして注目されています。

Llamaは、Metaによって「ソースコード」が公開されているオープンソースとして提供されており、一部モデルについてはローカル環境での利用も可能です。これにより、自社のセキュアなインフラ上での導入・運用ができ、モデルを自由に利用、改変、再配布できる点がエンタープライズ用途でも評価されています。

また、モデルのバリエーションが豊富で、研究用途や商用利用、さらには画像認識との連携を前提としたモデルが使用可能です。

料金プラン

Llamaは、オープンソースなので基本的には無償で提供されています。

Llama 1は研究・非営利目的に限定されていましたが、Llama 2以降はMetaへの申請後に商用利用可能です。

商用利用を想定している場合は、Meta社とのライセンス契約が求められるケースもあります。と言っても、Llamaを組み込んだ製品やサービスの月間アクティブユーザー数(MAU)が7億人を超えることが条件なので、ほとんどの企業にとっては実質完全無料と考えてよいでしょう。

ただし、Llama本体は無償でも、AWS (Amazon Bedrock)、Google Cloud (Vertex AI)、Microsoft (Azure AI) などLlamaのAPIを提供しているプラットフォームでは従量課金制となる場合があります。商用サービスへの組み込みや大規模な処理を行う場合は、外部インフラ利用の費用も含めてコストを算出することが重要です。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llamaのモデル一覧

Llamaは、バージョンごとに性能や用途が異なる複数のモデルが展開されています。以下では、各バージョンの特徴をリリース順に解説していきます。

Llama 1

Llama 1は、Metaが2023年2月に公開された、Llamaシリーズの原点といえるモデルです。モデルサイズは7B、13B、33B、65Bの4種類が用意されており、いずれもTransformerアーキテクチャに基づいて構築されています。

Llama 1は非商用ライセンスで提供されており、商用利用は認められていません。そのため、基本的には研究目的や実験用途での使用が前提とされています。

技術的には、公開当初から高い言語処理能力を備えており、GPT-3クラスのモデルと比較しても遜色のない性能を発揮しました。特に、英語圏におけるベンチマークでは高評価を得ており、今後のシリーズ展開に向けた基盤となる成果を残しています。

Llama 2

Llama 2は、2023年7月に発表された第2世代のモデルで、初めて商用利用が許可されたバージョンです。モデルサイズは7B、13B、70Bの3種類が展開されており、あらゆる規模のAI開発に対応可能な設計となっています。

Llama 1と比較して、事前学習データの規模やトークン数が大幅に拡張されており、自然言語処理の精度と安定性が向上しています。特に70Bモデルは、GPT-3.5に匹敵する性能を持ち、英語ベンチマークを中心に高い評価を獲得しています。

ライセンスは、Meta社の承認を受けたうえで無料提供されました。これにより、セキュリティ要件の厳しい業界やオンプレミス環境でも導入が進んでいます。

Llama 3

Llama 3は、2024年4月に公開された第3世代のモデルで、性能・機能の両面において大幅な進化を遂げたバージョンです。従来のLlama 2から学習データ量とトークン数が拡張され、より自然で高精度なテキスト生成が可能となりました。

現在公開されているモデルサイズは8Bと70Bの2種類です。

| スペック | Llama 3 8B | Llama 3 70B |

|---|---|---|

| パラメータ | 80億 | 700億 |

| 特徴 |

|

|

| 推奨用途 |

|

|

Llama 3では、事前学習に使用されたデータセットが1兆トークン以上に拡大されており、事実性・一貫性・論理性の面で従来モデルを上回ります。特に、MMLUやARCといったベンチマークにおいては、GPT-3.5やClaude 2に匹敵するスコアを記録しています。

その後Llama 3は、マルチモーダル機能が搭載された派生モデルも登場しています。

Llama 3.1

Llama 3.1は、Llama 3シリーズの改良版として開発されたモデルです。Llama 3の構造を踏襲しつつ、推論精度・処理速度が強化されています。

最高峰の性能を誇り、極めて高度で専門的なタスクに対応可能です。研究開発や大規模なデータ解析など、大規模なAIモデルの開発にも活用できます。

また、パラメータ数(4050億パラメータ)やコンテキスト長の拡張も進められており、長文かつ複雑な命令に対する応答精度の向上が図られています。また、対応言語が追加され、幅広いユーザーが活用できるようになりました。

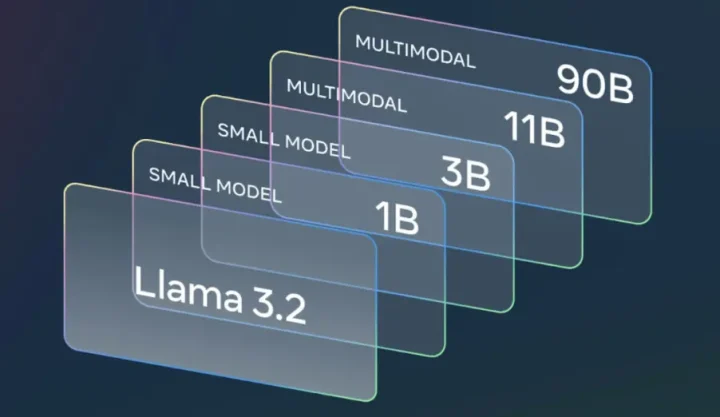

Llama 3.2

Llama 3.2は2024年9月に発表されたマルチモーダル対応モデルであり、テキストと画像の両方を入力として処理が可能です。従来のテキスト処理能力の向上に加え、画像を理解する「マルチモーダル機能」とスマートフォンなどのエッジデバイスで動作する「軽量モデル」という二つの大きな進化を遂げています。

モデルサイズは1B、3B、11B、90Bの4種類が提供されており、11Bおよび90Bモデルは画像認識機能を備えています。

画像認識機能を持つことで、視覚情報を含む以下のタスクへの対応が可能となりました。

- 画像キャプション生成

- VQA

- ドキュメント解析

また、非常に軽量なパラメータを持つテキスト専用の1Bおよび3Bモデルは、モバイルやエッジデバイスでの利用を想定して設計されています。オフライン環境や低リソース環境でも高いパフォーマンスを発揮します。

Llama 3.2は、Metaの公式サイトやHugging Faceなどのプラットフォームを通じて提供されており、商用利用も可能です。

Llama 3.3

Llama 3.3は2024年12月に公開された70Bパラメータのモデルで、テキストベースのタスクに最適化されています。128kトークンの長いコンテキストウィンドウを備え、長文の文書や複雑な対話の処理に対応可能です。

モデルのアーキテクチャと学習方法の最適化により、はるかに少ない計算リソース(サーバーコストや電力)で、極めて高いパフォーマンスを引き出すことに成功しています。

ベンチマークにおいても、HumanEvalでは88.4%、MGSMでは91.1%のスコアを達成し、コード生成や多言語推論タスクにおいて高い性能を示しています。わずか700億(70B)パラメータを持つテキストモデルが、Llama 3.1 405B モデルとほぼ同等の性能を発揮したのは注目点です。

また、英語、ドイツ語、フランス語、イタリア語、ポルトガル語、ヒンディー語、スペイン語、タイ語の8言語をサポートし、マルチリンガルな対話や自然言語処理において高い性能を発揮します。

Llama 3.3は、MetaのLlama 3.3 Community Licenseの下で提供されており、商用利用も可能です。

Llama 4

Llama 4は2025年4月に発表された第4世代のモデルであり、ネイティブなマルチモーダル対応を特徴としています。テキストと画像の両方を入力として処理できる能力を備えており、自然言語処理と視覚情報の統合解析が可能です。

このモデルでは、Mixture-of-Experts(MoE)アーキテクチャを採用しており、効率的な計算資源の利用を実現しています。入力トークンごとに必要なエキスパートを選択的に活性化することで、処理の効率化と性能の向上を両立可能です。

Llama 4では、3つのモデルを展開していて、用途に応じて使い分けることが可能です。以下でそれぞれのモデルについて解説していきます。

Llama 4 Scout

Llama 4 ScoutはLlama 4シリーズの軽量モデルで、17Bのアクティブパラメータと16のエキスパートから構成されています。総パラメータ数は1090億(109B)で、効率的な処理を実現しています。

特筆すべきは、最大1,000万トークンのコンテキストウィンドウをサポートしており、長文の処理や複雑な文書の解析に適している点です。

また、テキストと画像の両方を入力として処理できるマルチモーダル対応が可能で、自然言語処理と視覚情報の統合解析が可能です。これにより、画像キャプション生成や視覚的質問応答(VQA)など多様なタスクへ対応します。

Llama 4 Maverick

Llama 4 Maverickは17Bのアクティブパラメータと128個のエキスパートから構成され、総パラメータ数は4000億(400B)で、より高精度な推論、コーディング、画像理解が可能なモデルです。

多くのベンチマークにおいて、競合であるGPT-4oとGemini 2.0 Flashを上回り、推論とコーディングにおいては新しいDeepSeek v3と同等の結果を達成しました。しかも、アクティブパラメータは半分以下と、クラス最高のパフォーマンス対コスト比を提供しています。

Llama 4 Maverickでは12の主要言語に対応しており、多言語環境での利用にも適しています。また、コンテキストウィンドウは最大100万トークンをサポートしており、長文の処理や複雑な文書の解析に最適です。

Llama 4 Behemoth

Llama 4 Behemothは、総パラメータ数が約2兆に達する巨大な開発中のモデルです。ネイティブなマルチモーダル対応が可能で、複雑なタスクへの対応力が向上し、幅広い応用が期待されています。

Llama 4 Behemothは、Llama 4 ScoutやMaverickのトレーニングにおける「教師モデル」としても機能しており、性能向上に寄与しています。BehemothはSTEM分野のベンチマークにおいて、GPT-4.5やClaude Sonnet 3.7、Gemini 2.0 Proを上回る性能を示しているとのことです。

ただし、Behemothは現在学習中で、一般公開はされていません。リリース時期は未定であり、今後の動向に注目が集まっています。

Behemothの登場により、AIモデルの性能と応用範囲がさらに拡大することが期待されています。現時点でリリースされた場合、最も優れたAIモデルとなるでしょう。

派生モデル

Llamaシリーズは、オープンソースの強みを活かし、プログラミング支援や安全性担保、さらにはデバイス上での動作に最適化されたモデルなど、多様なバリエーションが展開されています。

| モデル名 | 主な役割・用途 | 特徴・強み |

|---|---|---|

| Llama Guard | 安全性の担保(ガードレール) | 入出力を監視し、有害・不適切な内容を検知・遮断することに特化 |

| Code Llama | プログラミング・コード生成 | コード生成、デバッグ、既存コードの解説に特化した学習を実施 |

| Llama Stack | 開発環境・API標準化 | 複数モデルの統合管理、RAG(検索拡張生成)のパイプライン構築 |

| Llama Vision | マルチモーダル(画像理解) | 視覚情報の解析が可能。画像の内容説明や図表のデータ化に対応 |

ChatGPT・Gemini・Claudeとの違い

Llamaは、OpenAIのGPTシリーズ、GoogleのGeminiシリーズ、AnthropicのClaudeシリーズと並ぶLLMですが設計思想や提供形態には違いがあります。

最大の特徴は、LlamaがGAFAの一角であるITジャイアントのMeta社によってオープンソースで実質無料提供されている点です。ChatGPTやGeminiがソースコードを公開していないのに対し、Llamaは自由に改変・カスタマイズできる「素材」として提供されています。

ローカル環境への導入、既存システムへの導入やカスタマイズが可能であり社内利用にも対応できます。

一方でChatGPTやClaudeは、API経由、または対話型プラットフォームとして完成された「サービス」の形で提供されています。基本的にはデータをベンダーのサーバーに送信する必要があるのでローカルLLMやエッジLLMとしては活用できません。

利用にかかる費用は、API利用量に応じた従量課金となります。さらに、APIの範囲内での調整のみなので、カスタマイズ性には限界があります。

一方、一般ユーザー向けの自然な対話性能や導入性の良さに重点が置かれており、UIが洗練されています。GeminiはGoogleの広範なクラウドサービスと連携可能で、検索連動などの実用性に強みを持っています。

目的に応じた生成AIモデルの選び方

| 比較軸 | Llama (オープンソース) | ChatGPT / Gemini / Claude (クローズドソース) |

|---|---|---|

| 基本戦略 | 自由に改変・カスタマイズできる「素材」を提供 | API経由で完成された「サービス」を提供 |

| カスタマイズ性 | ◎ 非常に高い (自社データで深く学習させ、特化AIを構築可能) | △ 限定的 (APIの範囲内での調整のみ) |

| データセキュリティ | ◎ 自社管理 (オンプレミスでデータを外部に出さずに運用可能) | △ ベンダー依存 (データをベンダーのサーバーに送信する必要がある) |

| コスト構造 | TCO (初期投資+運用費) or クラウド利用料 | API利用量に応じた従量課金 |

生成AIを業務に導入する際は、「何を目的とするのか」を明らかにし、モデルを選定することがポイントです。Llamaは業務自動化から研究用途、創造的なコンテンツ生成まで幅広く対応できますが、他のAIモデルとの比較検討が重要です。

例えば、AIチャット機能を導入したい場合は、ChatGPTやClaudeなどが有力候補となるでしょう。高い対話性能やユーザーインターフェースが整っており、開発工数を抑えながら活用できます。

一方、自社環境で安全にAIを運用したい場合は、Llamaのようなオープンソースモデルが最適です。カスタマイズやファインチューニングが可能なため、業界固有のデータや社内文書を活用した高度な適応が実現できます。

また、検索や情報要約に特化した機能を重視するなら、Google検索との統合や視覚情報との連携において優位性があるGeminiが適しています。

このように、利用目的に応じて各モデルの特性を見極め、性能・セキュリティ・導入工程といった観点から総合的に判断するようにしましょう。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llamaの機能・特徴

Llamaは、オープン性・高精度・軽量性など、実用性に優れたモデルです。以下では、Llamaシリーズに共通する機能や技術的特徴について解説していきます。

オープンソースなので基盤モデルとして活用できる

Llamaシリーズ最大の特徴は、Metaによってオープンソースとして提供されている点にあります。研究開発用途だけでなく、企業による商用サービスへの組み込みや独自カスタマイズも可能で柔軟かつ実践的な活用が広がっています。

Hugging Faceなどのプラットフォームを中心に巨大な開発者コミュニティが存在し、日々新しい派生モデルやツールが生まれています。

例えば、プログラミング用途に特化した「Code Llama」はLlama 2を基盤モデルとし、大量のコードデータを学習させています。コード生成や補完、バグ修正といった開発支援タスクに強みを発揮します。

このように、Llamaはオープンソースであるがゆえに、さまざまなユースケースに適応した特化モデルが派生・進化し続けています。

高いテキスト処理・推論能力

Llamaは、自然言語処理(NLP)における高いテキスト理解力と推論能力を備えています。特にLlama 2以降のモデルでは学習データ量やトークン数が大幅に拡張されており、文脈を正確に捉えた回答生成、論理的な推論、文章の要約や分類といったタスクを得意としています。

Llama 4 Scoutでは、最大1,000万トークンのコンテキストウィンドウをサポートしており、議事録や長編文書の解析にも対応可能です。これにより、従来のモデルでは分割が必要だった情報も一括処理できるようになります。

業務用途において、信頼性の高い自然言語処理が求められる場面では、Llamaシリーズのテキスト処理・推論能力は非常に有用です。

軽量

Llamaシリーズは、精度と計算効率のバランスを重視して設計されており、軽量でありながら高速な処理が可能な点も特徴です。Llama 2の7Bや13Bモデルは、単一のGPUでも動作可能な構成となっています。

Llama 4 の最新モデルではMixture-of-Experts(MoE)アーキテクチャが採用されていて、入力に応じて一部のエキスパートだけを選択的に動作し、推論時の計算負荷を大幅に軽減できます。これにより、高精度を維持しながらもリソース効率の良い処理が実現されます。

Llamaの軽量化モデルは、AIの導入ハードルを下げ、幅広いユーザーが活用しやすくする要因となります。限られたリソースで高品質な処理を行いたい開発現場では、Llamaが重宝されるでしょう。

プロンプトへの対応力

Llamaシリーズは、ユーザーからのプロンプトに対する高い理解力と応答精度を持ち、業務自動化ツールにおいて優れた操作性を発揮します。指示の意図を正確に汲み取り、文脈に沿った自然な出力が可能です。

Llamaのプロンプト応答力の高さは、事前学習で用いられたトークン数とデータ品質の向上、指示文形式のデータによるチューニングによって実現されています。複数ステップの命令や、曖昧な指示に対しても対応できるため、以下のビジネス用途にも適しています。

- レポート生成

- FAQ応答

- テンプレートベースの自動文書作成

プロンプト設計の柔軟性の高さは、プロンプトエンジニアリングによって出力を自在に制御できるため、業務ニーズに合わせた最適な応答生成が可能です。

アーキテクチャの拡張性

高い汎用性と柔軟な設計が特徴のLlamaシリーズは、アーキテクチャの拡張性に優れています。特にLlama 3以降のモデルでは基盤構造がモジュール化されており、用途に応じたカスタマイズやスケール拡張がしやすい設計となっています。

以下のような軽量学習手法との相性も良く、既存業務に即した形で機能を追加・最適化することが可能です。

- コンテキスト長や入出力構造の調整

- ファインチューニング

- LoRA(Low-Rank Adaptation)

- 量子化

さらに、Llama4ではMoEアーキテクチャを採用することで、必要に応じて専門的なエキスパートモデルを動的に切り替え、計算コストを抑えつつ高精度な処理を実現しています。これにより、ユーザーは処理要件や利用環境に合わせた効率的な運用が可能です。

このような拡張性の高さは、社内業務への統合や、新規サービス構築を行う際に大きなアドバンテージとなります。

Llamaの始め方

Llamaを活用するには、用途や環境に応じた導入手順を進める必要があります。

クラウドプラットフォームで試す

AWS、Google Cloud、Azureなどの主要クラウドサービスでは、専門知識がなくても数クリックでLlamaを試せる環境が用意されています。Amazon BedrockやVertex AI StudioといったコンソールからLlama 3を選択し、どのような応答が返ってくるかをテストするのが最初のステップとして最適です。

Meta公式サイトからライセンスを申請する

Llamaを企業や研究機関で利用する場合、Metaの公式サイトを通じてライセンスの申請を行う必要があります。申請時には、使用目的や所属機関、予定している利用範囲などを申請フォームに記載する必要があります。

申請内容が承認されるとモデルのダウンロードリンクや技術ドキュメントへのアクセスが許可され、ライセンスの範囲内で自由に活用できるようになります。

Meta公式サイトからのライセンス申請は信頼性の高いモデルを安心して導入するために不可欠ですので、適切な手順で進めましょう。

Hugging Faceからダウンロードする

Llamaシリーズのモデルは、Hugging Faceを通じて手軽に取得・利用することも可能です。Metaが公式に公開したチェックポイントがHugging Face Hub上で配布されています。

開発者はPythonやCLIツールを用いて簡単にモデルをダウンロードし、自身の環境に組み込めます。

利用にあたっては、まずHugging Faceのアカウントを作成し、Metaの利用規約に同意した上でアクセストークンを取得します。その後、Transformersライブラリなどを用いて、コードベースでモデルを呼び出すことができます。

Hugging Faceでは量子化済み・ファインチューニング済みのバージョンも提供されているため、開発リソースや用途に応じた柔軟な選択が可能です。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llamaを活用する際の注意点

Llamaの実運用においては、導入後の管理や運用面で注意が必要です。以下では、Llamaを活用するうえで留意すべきポイントを解説します。

開発者が環境構築・デプロイ・安全管理をすべて行う必要がある

Llamaはオープンソースで自由度の高いモデルである一方、ChatGPTのようにすぐに使える状態ではありません。そのため、導入に際しては、開発者が環境構築からデプロイ、安全管理までを一貫して行う必要があります。

これは、カスタマイズの柔軟性と引き換えに、技術的な責任領域が広くなることを意味します。

初期段階では、以下のようなインフラ対応が必須です。

- 依存ライブラリの導入

- モデルファイルの取得・設定

モデルによっては量子化や軽量化の対応も必要で、推論効率を最適化するための工夫が求められます。API化やWebアプリケーションへの統合には、バックエンドの設計やセキュリティ対策も不可欠です。

また、フィルタリングやログ管理、データ漏えい防止といった安全運用の設計を開発者側で実装する必要があります。商用サービスでの使用を想定する場合、不適切な出力や誤情報のリスク対応も重要です。

このように、Llamaは高性能と自由なカスタマイズが可能な反面、導入・運用のハードルが高いといえるでしょう。

定期的なデータ更新やファインチューニングが必要

Llamaを業務システムや顧客対応に活用する場合、モデルの精度や適応性を維持するために、定期的なデータ更新やファインチューニングが不可欠です。導入時点の学習データの状態では、ビジネス環境や法制度の変化に対応できなくなるリスクがあります。

例えば、業界用語や社内独自のフレーズを含む場合、追加学習を行わなければ、応答精度は低下します。そのため、継続的に社内データやナレッジベースを整理し、モデルに反映させる運用体制を整える必要があります。

ファインチューニングの方法としては、全体学習ではなくLoRAやQLoRAなどの軽量手法を用いることで目的に特化したモデル調整が可能です。また、ユーザーからの入力ログやフィードバックを活用した再学習も効果的です。

Llamaの運用は一度の導入で完了ではなく、継続的なアップデートと改善プロセスが必要となります。長期的な精度と信頼性を確保するためにも、データ更新と再学習のシステム・効果を組織内に定着させることがポイントです。

日本語性能の課題

標準モデルは英語中心に学習されているため、日本語のニュアンスや専門用語の扱いで期待した性能が出ない場合があります。ファインチューニングや、日本語に特化した派生モデルの利用を検討する必要があります。

例えば、ELYZA社が開発した「ELYZA-japanese-Llama-2」は、日本語の文脈理解に最適化されたモデルであり、Llama 2をベースに日本語コーパスで追加学習が行われています。

Llamaについてよくある質問まとめ

- Llamaとは、どのようなAIモデルですか?

Meta社が開発したオープンソースのLLM(大規模言語モデル)です。主な特徴は以下の通りです。

- ソースコードが公開されており、自由に改変や再配布が可能です。

- 原則無料で商用利用も認められています。(一部条件あり)

- 自社のセキュアな環境(オンプレミスなど)に導入・運用できます。

- ChatGPTやGeminiと並ぶ高い性能を持つと評価されています。

- LlamaはChatGPTやGeminiと何が違うのですか?

最大の違いは「オープンソース」か「クローズドソース」かという点です。

Llama (オープンソース):

- 自社データで自由にカスタマイズ可能。

- オンプレミス環境でデータを外部に出さずに運用できる。

- モデルライセンスは無料だが、運用にはインフラや人件費がかかる。

ChatGPT/Gemini (クローズドソース):

- API経由ですぐに利用できる「完成品サービス」。

- カスタマイズ性は限定的。

- 利用にはAPIに応じた従量課金が発生する。

- Llamaを使い始めるには、どうすればよいですか?

主に3つの方法があります。

- クラウドプラットフォームで試す: AWS, Google Cloud, Azureなどが提供するサービス上で、数クリックで手軽に試せます。

- Meta公式サイトから申請: 商用利用などを目的に、公式サイトからライセンスを申請し、モデルを直接入手します。

- Hugging Faceからダウンロード: 開発者向けプラットフォーム「Hugging Face」から、公式モデルやコミュニティが作成した派生モデルをダウンロードします。

- Llamaの主な機能や特徴は?

Llamaは、特に以下の5つの点で優れています。

- オープンソース: 自由に改変・カスタマイズが可能です。

- 高いテキスト処理能力: 文脈理解、論理的推論、要約などが得意です。

- 軽量性: モデルによっては単一のGPUでも動作可能で、計算効率と精度のバランスが取れています。

- プロンプトへの対応力: 複雑な指示や曖昧な要求も理解し、適切な出力を生成します。

- 拡張性: ファインチューニングや量子化など、用途に応じた機能追加・最適化が容易です。

- Llamaをビジネスで活用する際に注意すべき点は何ですか?

主に3つの点に注意が必要です。

- 環境構築と運用の負荷: オープンソースであるため、インフラの構築、デプロイ、安全管理などをすべて自社で行う必要があります。

- 継続的なメンテナンス: 精度を維持するため、定期的なデータ更新やファインチューニングが不可欠です。

- 日本語性能の課題: 標準モデルは英語中心のため、日本語特有の表現に対応するには、日本語データでの追加学習や日本語特化モデルの利用が推奨されます。

まとめ

Llamaは、Metaが提供するオープンな大規模言語モデルとして、柔軟なカスタマイズ性と商用利用を可能にする生成AIです。Llama 2以降は企業導入にも対応しており、用途やリソースに応じてモデルを選べることから、多様な業務に応用できます。

また、Llama 4シリーズでは画像認識やマルチモーダル処理といった高度な機能も加わり、次世代のAIとして注目されています。

しかし、その高い自由度は、裏を返せば導入から運用までの全責任を自社で担うことを意味します。最適なモデルの選定、インフラ環境の構築、継続的なファインチューニング、そしてセキュリティ管理には深い専門知識と技術力が不可欠です。

もしLlamaの導入を本格的に検討する中で技術的なハードルやリソースの課題に直面した場合は、無理に自社だけで解決しようとせず知見を持つ外部の専門家や専門企業の支援を仰ぐことがプロジェクト成功への確実な一歩となります。

LLMに強いAI会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp