Qwen3とは?特徴、性能、料金プラン、利用方法、 活用事例、Qwen2.5との違いまで徹底解説!

最終更新日:2025年11月23日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

- 2025年4月にAlibaba Cloudが発表した「Qwen3」は、Qwenシリーズ第三世代の大規模言語モデル群

- 従来比で倍増した36兆トークンの学習データと改良アーキテクチャにより、推論・数学・コーディング性能が大幅に向上

- 超大規模から軽量モデルまで多彩なラインナップを揃え、クラウドからローカル環境まで幅広く利用可能

2025年4月にAlibaba Cloudが発表した「Qwen3」は、Qwenシリーズの第三世代にあたるLLM(大規模言語モデル)群です。推論力や多言語対応力を強化し、研究から商用利用まで幅広いシーンに適応できる設計となっています。

柔軟に切り替え可能なハイブリッド推論モードや、119言語に及ぶ多言語処理能力、MoE構造を活用した効率的な推論性能を特長とし、教育・研究・開発・ビジネスなど多様な分野での活用が見込まれています。

本記事では、Qwen3の特徴、性能、料金プラン、利用方法、 活用事例、Qwen2.5との違いまでを徹底的に解説します。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

Qwen3とは?

Qwen3は、Alibaba CloudのQwenシリーズ第三世代にあたるLLM群です。MoE(Mixture of Experts)構造を採用したモデルとDense構造を持つモデルの両方が公開されています。

オープンソースかつ商用利用可能なLLMであり、テキスト処理モデルに加え、高度な画像認識能力を備えたマルチモーダルモデル「Qwen3-VL」もラインナップされています。

このQwenを搭載したAIアシスタント・画像生成・Web開発支援ツールも同名のQwenと名付けられています。

最大の特徴は、0.5B(5億)から235B(2350億)という幅広いパラメータサイズのモデルが提供されており、用途や計算リソースに応じて最適なものを選択できる柔軟性にあります。

モデルサイズのバリエーションとAPI料金

Qwen3はApache 2.0ライセンスのもと公開されており、研究から商用利用まで幅広く活用できます。

Qwen3には、235Bや30Bをはじめとする複数のモデルサイズが提供されています。最大規模のQwen3-235B-A22Bは総パラメータ数2,350億を誇り、数学やコーディング、複雑な推論タスクにおいて最先端の性能を発揮します。

性能面では、DeepSeek-R1やGemini 2.5 Proといった最先端モデルとも比較される水準に達しています。研究機関や大規模クラウド環境での利用を前提としたフラッグシップモデルといえます。

以下の表では、Qwen3の代表的なモデルを規模別に整理し、API料金とあわせて記載します。

| カテゴリ | モデル名 | API料金(1M tokensあたり) | 特徴 |

|---|---|---|---|

| 超大規模モデル | Qwen3-235B-A22B | Input: $0.7 Output: $2.8 Output (Thinking): $8.4 | 総パラメータ数2,350億。数学・コーディング・推論タスクで最先端の性能を発揮。研究機関や大規模サービス向け。 |

| 中規模モデル | Qwen3-30B-A3B | Input: $0.2 Output: $0.8 Output (Thinking): $2.4 | 3億アクティブパラメータを活用し、効率性と精度のバランスに優れる。QwQ-32Bを上回る性能で商用利用にも適する。 |

| 小規模モデル | Qwen3-32B / 14B / 8B | Qwen3-32B: $0.7 / $2.8 / $8.4 Qwen3-14B: $0.35 / $1.4 / $4.2 Qwen3-8B: $0.18 / $0.7 / $2.1 Input / Output / Output (Thinking) | 汎用性が高く、128Kの長いコンテキスト長に対応。開発や応用研究に幅広く利用可能。 |

| Qwen3-4B / 1.7B / 0.6B | Qwen3-4B: $0.11 / $0.42 / $1.26 Qwen3-1.7B: $0.11 / $0.42 / $1.26 Qwen3-0.6B: $0.11 / $0.42 / $1.26 Input / Output / Output (Thinking) | 軽量環境やエッジデバイス向け。計算資源が限られた環境でも従来より高い性能を維持。 |

このように、用途や環境に応じた多様なサイズ展開と料金設定は、Qwen3が幅広いニーズに応えられる基盤となっています。

参考:モデルの種類とAPI料金

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

Qwen3の7つの特徴

Qwen3は、従来モデルと比べて多くの点で進化した特徴を備えています。その主な特徴を紹介します。

ハイブリッド推論モード

Qwen3の最大の特長のひとつがハイブリッド推論モードです。以下の2つのモードを状況に応じて使い分けることが可能です。

- 思考モード(Thinking Mode)

- 非思考モード(Non-Thinking Mode)

思考モードでは、モデルが逐次的に推論を積み重ねてから回答を生成します。そのため、数学や論理的課題のように複雑な問題に強みを発揮できます。

一方、非思考モードでは即応性を優先し、単純な質問や会話に対して素早く答えることが可能です。

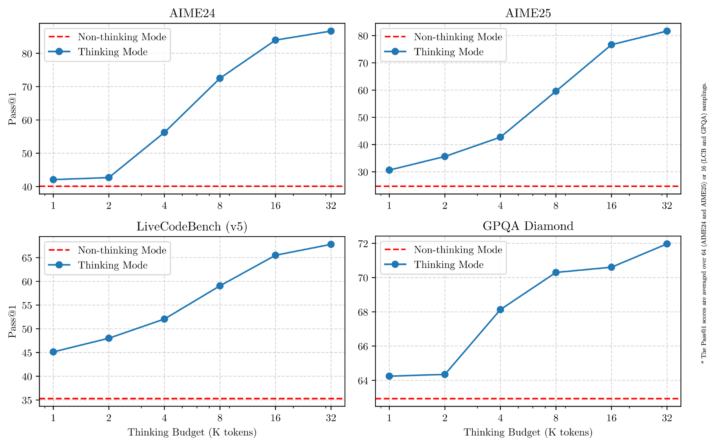

上記のグラフは、Qwen3における思考モード(青線)と非思考モード(赤線)の性能差を示したものです。

AIMEやLiveCodeBenchなどのベンチマークにおいて、思考トークン数(Thinking Budget)を増やすことで精度が大きく向上することが確認できます。これにより、タスクに応じて推論の深さを調整できるQwen3の柔軟性がわかります。

例えば、事業計画のドラフト作成や複数条件が絡み合う市場分析レポートの要約といった複雑な作業をAIに任せる際には「思考モード」が真価を発揮します。APIなどを通じてこのモードを制御できるため、開発者はタスクの性質に応じて最適なパフォーマンスを引き出すことが可能です。

多言語対応

Qwen3は119の言語・方言をサポートしています。英語や中国語、日本語などの主要言語はもちろん、アラビア語やヒンディー語、さらには少数言語まで幅広く対応します。

広範な多言語性によって、グローバルに利用可能なAI基盤として活用でき、研究や教育、ビジネスにおける多文化環境での利用を大きく支援します。

エージェント機能の強化

Qwen3は、外部ツールや環境と連携できるエージェント的機能が強化されています。

専用の「Qwen-Agent」を活用することで、MCP(Model Context Protocol)を通じたツール呼び出しが容易です。これにより、複雑なタスクの自動化が実現可能です。

コード生成や実行環境とのやりとりにも最適化されています。単なるテキスト生成にとどまらず、実務的なワークフローに組み込むことができます。

関連記事:「AIエージェントとは?生成AIとの違い・自律型の仕組み・種類」

大規模な事前学習データ

Qwen3は約36兆トークンという膨大なデータで事前学習されており、これは従来のQwen2.5(約18兆トークン)の倍にあたります。大規模化されたデータにより、モデルの理解力と表現力が大きく強化されています。

学習データにはウェブテキストに加え、PDFなどの文書形式から抽出した情報が含まれています。また、数学やコードの分野ではQwen2.5-MathやQwen2.5-Coderを用いて生成した合成データも活用されました。

教材、QAペア、コードスニペットといった形式で知識が補われています。これにより、一般知識だけでなくSTEM分野やプログラミングにおける精度も大幅に向上しています。

さらに、事前学習は複数の段階に分けて行われました。最終的には長文処理に対応するためのデータも取り込まれています。

その結果、長大な入力に耐えうるコンテキスト処理能力も獲得しました。

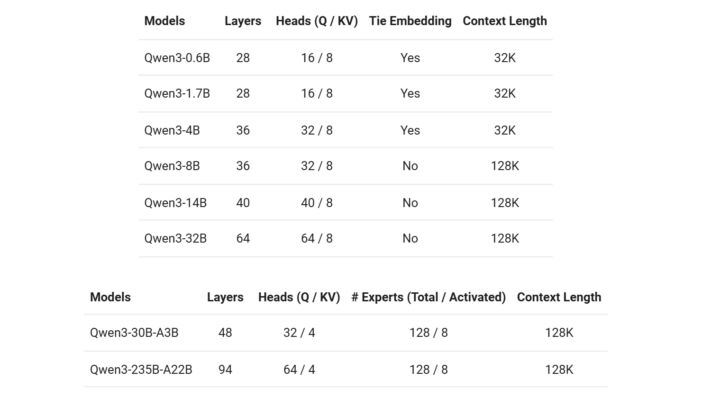

幅広いモデルラインナップ

Qwen3は、3つのモデルに分類され小規模な0.6Bや1.7Bモデルから、中規模の4B・8B・14B・32Bモデル、そして超大規模な30B-A3Bや235B-A22Bまで提供されています。これにより、軽量環境での利用から研究開発向けの大規模処理まで、利用者の目的や計算資源に応じた柔軟な選択が可能です。

また、構造面ではDenseモデルとMoEモデルの2種類が存在し、それぞれ異なる特性を持っています。

- Denseモデル:安定した構造で、規模ごとに性能と効率のバランスを取りやすい。再現性と運用のしやすさに優れ、研究や開発のベースに適する。

- MoEモデル:総パラメータは大きいが、推論時は一部のエキスパートのみを使用。計算資源を抑えつつ高い推論性能を発揮し、大規模サービスや効率重視の環境に適する。

両者が併存することで、実験から本番運用まで幅広いニーズをカバーできます。

進化版Qwen3-Nextの特徴と効率性

Qwen3-Nextは「次世代版」として、Qwen3の基本設計を土台に全く新しい改良を加えたモデルです。ここではラインナップの広さではなく、内部構造の改善に焦点が置かれています。

Gated DeltaNetとGated Attentionを組み合わせたハイブリッドアーキテクチャにより、長大なコンテキスト処理でも高い精度と速度を両立しました。また、Zero-Centered RMSNormや出力ゲーティングの採用によって学習安定性を強化し、マルチトークン予測によって推論効率を飛躍的に向上させています。

その結果、事前学習コストは従来の約1/10、長文推論では10倍以上のスループットを実現しています。さらに、Instructモデルはフラッグシップ級に迫る性能を持ち、Thinkingモデルは他社の競合モデルを上回る成果を達成しました。

ファインチューニングの容易さ

オープンソースであるQwen3の大きな利点の一つが、ファインチューニングのしやすさです。これは、自社に蓄積された独自のデータ(過去の問い合わせ履歴、製品マニュアル、社内報告書など)を追加学習させることでモデルを特定の業務領域に特化させ、応答精度を向上させる手法です。

例えば、業界特有の専門用語や社内の暗黙知を反映した企画書の草案作成など汎用モデルでは対応が難しいタスクも、ファインチューニングによって高精度に自動化できる可能性があります。Qwen3は、LoRA(Low-Rank Adaptation)など、比較的低コストでファインチューニングを行える手法にも対応しており、企業が独自AIを構築するハードルを下げています。

参考:Qwen3公式紹介記事

Qwen3の性能

Qwen3の性能を示すベンチマークについて説明します。

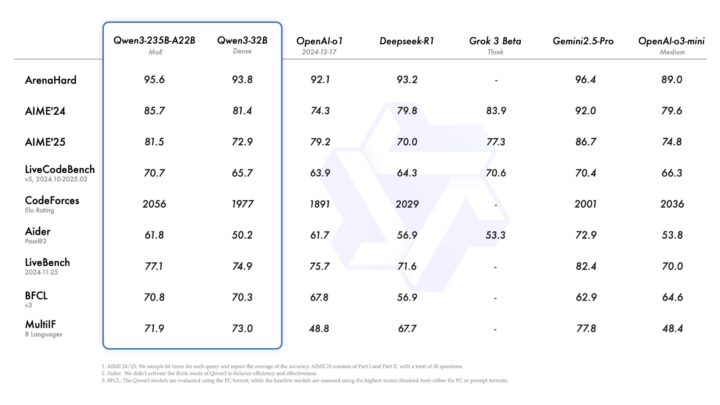

フラッグシップモデルはOpenAI o1やGemini 2.5 Pro、DeepSeek-R1に比肩

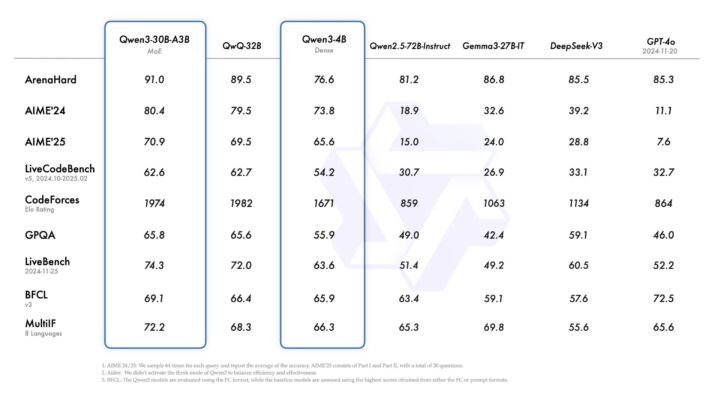

上記の表は、Qwen3を含む大規模言語モデルを、数学(AIME24/25)、プログラミング(LiveCodeBench)、多言語理解(MultiIF)、総合的な実力を測るArenaHardなど複数のベンチマークで比較した結果を示しています。

結果を見ると、フラッグシップモデルであるQwen3-235B-A22BやQwen3-32Bは、OpenAI o1やGemini 2.5 Pro、DeepSeek-R1といったトップモデルに並ぶ、あるいはそれ以上のスコアを記録しています。

特に数学や推論を必要とするタスクで高い精度を示しており、研究や高度な業務活用に十分耐えうる性能を持っています。

軽量モデルも効率的で高性能

一方で、Qwen3-30BやQwen3-8Bといった軽量モデルも安定したパフォーマンスを発揮しており、リソース制約のある環境や試験的な導入にも適しています。大規模モデルから軽量モデルまで幅広い選択肢がある点は、Qwen3シリーズの大きな強みと言えるでしょう。

さらに、4B、1.7B、0.6Bといった小型モデルも揃っており、エッジデバイスや軽量なサーバー環境でも運用可能です。これにより、ユーザーは「最高性能を追求する大規模モデル」から「限られた計算資源での実用に適した小規模モデル」まで、利用目的に応じて柔軟に選択できます。

さらに、小型モデルでも、従来のより大きなQwen2.5モデルと同等の精度を実現しており効率性と汎用性を兼ね備えています。

このようにQwen3は、ベンチマークでの客観的な評価と実際の利用シーンの両面から、高い競争力と柔軟性を備えたモデル群であることがわかります。

Qwen3とQwen2.5の違い

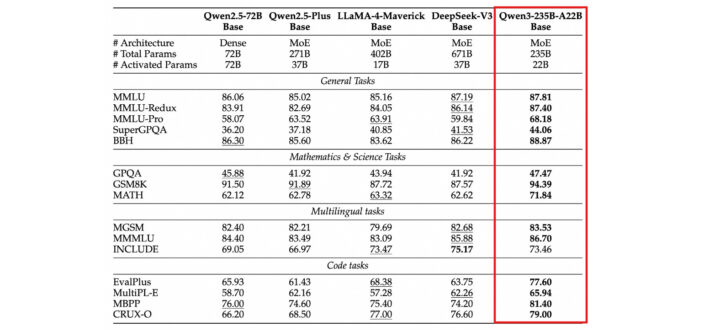

Qwen3はQwen2.5と比較して大幅な進化を遂げています。上記の表はQwen3が多領域で性能を底上げしていることを具体的に裏付けています。

事前学習データ量は18兆から36兆へと倍増し、学習対象に含まれる分野も拡張されています。

さらに、Denseモデルは少ないパラメータ数でもQwen2.5の大規模モデルに匹敵する精度を達成しました。

MoEモデルでは10%の活性パラメータで同等の性能を発揮する効率性が実現されています。これにより、計算資源の節約と高性能の両立が可能となり、コスト面での優位性も確保しています。

そして上記のベンチマーク結果を示した表からも違いは明確です。一般タスク(MMLU、BBHなど)では精度が安定して高く、特に数学(GSM8K、MATH)やコード生成(MBPP、CRUX-O)の分野で大幅な改善が見られます。

例えばGSM8Kでは94.39、MATHでは71.84とQwen2.5を大きく上回るスコアを達成しており、実践的な推論能力の強化が確認できます。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

Qwen3を使うには?

Qwen3は、一般ユーザーから研究者・開発者まで幅広い層が利用できるように設計されています。利用方法は大きく以下の3つに分けられます。

- 「公式サイトやアプリを通じた利用」

- 「API利用」

- 「モデルダウンロード」

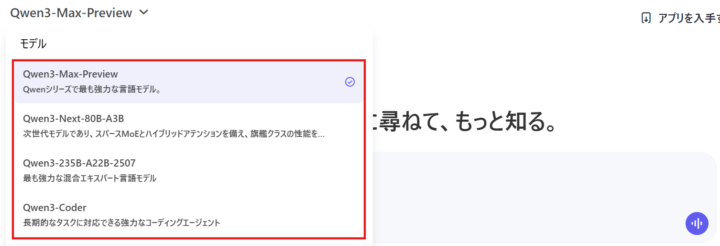

公式サイト・アプリから利用

一般ユーザーは「Qwen Chat」やモバイルアプリを通じて、すぐにQwen3を試すことができます。

公式サイト(https://chat.qwen.ai/)からアクセスでき、アカウントを作成しなくても基本的なチャット機能を利用可能です。翻訳や要約、多言語での会話といった幅広いタスクに対応しています。

ログインすれば履歴管理や高度な機能へのアクセスも可能となり、日常的な情報取得から学習・業務サポートまで幅広く活用できます。

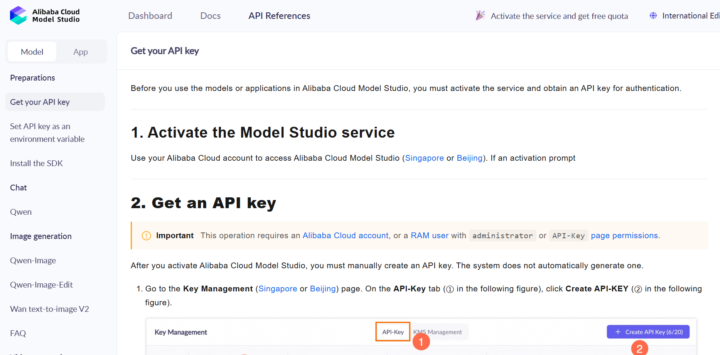

APIから利用

公式で公開されているAPIを活用して、モデルを利用することが可能です。

モデルをダウンロードして利用

Hugging Face Transformers、ModelScope、Kaggleといったプラットフォームを通じてモデルを入手でき、すぐに実験や研究に利用可能です。

ローカル環境での運用にも対応しており、Ollama、LMStudio、llama.cpp、KTransformers、MLXなどのツールを用いれば軽量かつ柔軟に動作させられます。また、SGLangやvLLMを利用するとOpenAI互換のAPIエンドポイントを構築でき、既存のワークフローやサービスにスムーズに統合できます。

Qwen3の活用事例

Qwen3は、研究や教育、ビジネスなど幅広い分野での活用が進められています。その中には、実際のユーザーによるローカル環境での利用事例も報告されています。

例えば、X(旧Twitter)では以下のような投稿が共有されています。

The new batch generation in MLX LM is pretty fast. Here’s 4 simultaneous generations with Qwen3 4B on my M4 max: pic.twitter.com/O0zCgyZpvu

— Awni Hannun (@awnihannun) September 16, 2025

この投稿は、Appleシリコン「M4 Max」を搭載したMac上で、MLX LMを利用してQwen3-4Bモデルを同時に4つの生成を実行した事例です。バッチ生成が高速に動作したことが報告されており、軽量モデルであるQwen3-4Bがローカル環境でも十分に実用的であることを示しています。

このような実例からも、Qwen3はクラウド利用だけでなくローカル環境での活用にも適していることがわかります。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

Qwen3についてよくある質問まとめ

- ハイブリッド推論モードとは何ですか?

Qwen3の最大の特徴の一つで、「思考モード」と「非思考モード」を状況に応じて使い分けられる機能です。

思考モードでは複雑な数学や論理的課題に対して逐次的に推論を積み重ねて回答し、非思考モードでは単純な質問や会話に対して素早く応答します。これによりコストと応答品質のバランスを調整できます。

- Qwen3はどのような言語に対応していますか?

Qwen3は119の言語・方言をサポートしています。

英語、中国語、日本語などの主要言語はもちろん、アラビア語、ヒンディー語、さらには少数言語まで幅広く対応しており、グローバルな利用が可能です。

まとめ

Qwen3は、研究や教育からビジネスまで幅広く応用可能な大規模言語モデル群です。進化した推論能力や多様なモデル構成により、今後もさまざまな分野での活用が期待されます。

また、オープンソースとして公開されている点も、多くの開発者や研究者にとって利用しやすい要素となっています。豊富なモデルサイズの選択肢や、クラウドからローカル環境まで対応できる柔軟性も備えており、導入のハードルが低いことも特長です。

総合的に見て、Qwen3は性能と効率のバランスに優れたモデル群として、今後のAI活用における有力な選択肢の一つとなるでしょう。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp