Gemma 3とは?Google開発のマルチモーダルLLMの特徴と活用法を徹底解説

最終更新日:2025年10月04日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

Gemma 3は、2025年3月に提供開始されたGoogle DeepMindによる最新世代のオープンソースLLMであり、従来のGemma 2を大幅に上回る性能を備えています。

研究や業務、個人開発のいずれにおいても高い汎用性を発揮できるのが大きな特徴で、今後ますます注目されるモデルファミリーとなっています。

本記事では、Gemma 3の特徴・機能・できること・性能・料金プラン・使い方・活用例まで徹底解説します。次世代の動画生成に興味がある方は、ぜひ参考にしてください。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

LLM・RAGに強いAI会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

目次

Gemma 3とは?

Gemma 3は、Gemini 2.0で培われた研究成果をもとに開発された高性能なオープンソースモデルファミリーです。

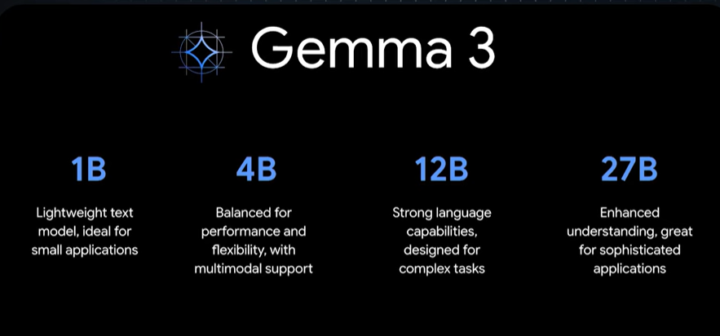

スマートフォンなどの限られたリソース環境から、ハイスペックなワークステーションやクラウドインフラまで、多岐にわたるデバイスで動作可能な柔軟性を持ち、モデルサイズは1B、4B、12B、27Bといった複数のバリエーションが用意されています。

これにより、比較的軽量な推論を行いたい場面から、大規模なデータ処理を必要とするタスクまで、幅広くカバーできます。

特に開発背景としては、Gemma 2に対してユーザーコミュニティから寄せられた要望を反映し、画像や動画を含む多様なデータを扱えるマルチモーダル処理能力を高め、さらに長大なテキストや多言語処理にも対応できるよう機能拡張が施されています。

用途としては文章生成、翻訳、コード生成、画像解析など、さまざまな分野で利用されることを想定しており、実際に研究機関や企業、個人開発者による導入事例も増えつつあると報告されています。

Gemmaファミリーには、汎用的な性格のGemmaのほかに、コード生成に特化したCodeGemma、プライバシー保護を特色としたVaultGemmaなどがあります。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Gemma 3でできること

高精度な翻訳タスク:140言語超の多様な表現に対応

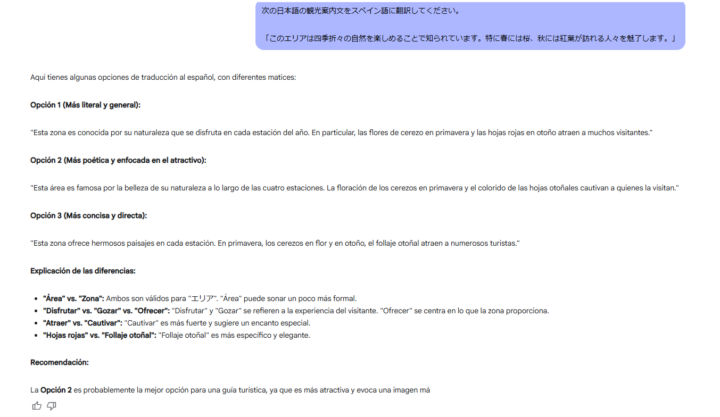

Gemma 3は、プリトレーニングされた140以上の言語に対応しており、特に35言語では高品質な出力が可能です。

原文のニュアンスを忠実に保持しつつ、各言語特有の文化的表現や言い回しにも配慮した出力が可能です。

そのため、単純な直訳に留まらず、スムーズで読みやすい翻訳文を生成することができます。

社内文書の翻訳、グローバル向けのWebコンテンツ作成、多言語間でのビジネスコミュニケーションなど、実務での多様なニーズにも柔軟に対応できる点が特徴です。

マルチモーダル対応による画像・動画データの解析と応用

Gemma 3は、従来のテキスト中心モデルとは異なり画像や動画といった視覚データも同時に処理するマルチモーダル能力を備えています。

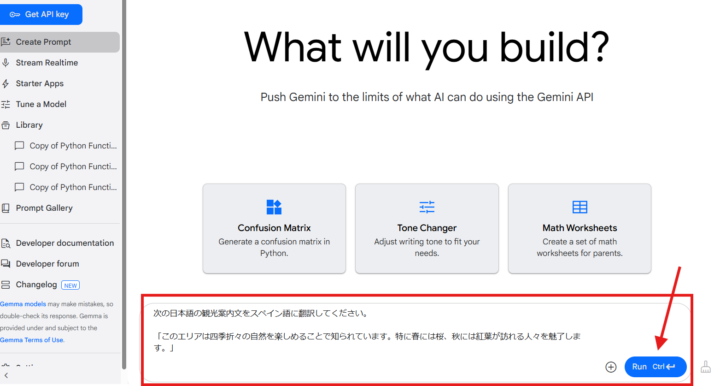

下記の画像は、Google AI Studioの操作画面です。矢印が示している箇所から、添付したい画像を選択することができます。

例えば、画像認識によって得られた情報をもとに、対象物の特徴を抽出し、その特徴に基づく説明文を自動生成することが可能です。

また、動画データを解析し、シーンごとの要約やイベント抽出を行うこともできるため、コンテンツ分析や監視システムへの応用が期待されます。

単なるテキスト処理に留まらない、マルチモーダルな応用領域を広げることができます。

自然言語によるコード生成と開発作業の効率化

Gemma 3は、自然言語による簡単な指示だけで、コードの雛形や関数のコードの自動生成を行うことが可能です。

具体的には、PythonやJavaScriptなどのプログラミング言語に対応し、標準的なコードパターンの出力や、定型的な処理の自動化が実現できます。

さらに、生成したコードに対してデバッグを支援する提案を行う機能も備えており、開発者の負担を軽減します。

これにより、プロトタイプ開発の加速、既存コードのリファクタリング、バグ修正支援といった幅広い場面でエンジニアリング作業を効率化できます。

関数呼び出し(Function Calling)によるタスク自動化とエージェント的応用

Gemma 3は、自然言語で指示を出すだけで、あらかじめ定義された関数を呼び出し、処理結果を返す「関数呼び出し(function calling)」機能に対応しています。

これにより、AIを使ったワークフローの自動化や、複数のステップからなるタスクの実行エージェントとして活用することが可能です。

モバイル特化のGemma 3n

Gemma 3nは、Gemma 3の登場後の2025年5月に発表された次世代の「モバイルファースト」なエッジAIモデルであり、スマートフォンやタブレットなどの限られたリソース環境でも高速かつ高精度に動作するよう最適化された軽量・高性能なアーキテクチャを採用しています。

そのため、Microsoftの提供するPhi-3やPhi-4のようないわゆるSLM(Small Language Model)と捉えて問題ありません。

Gemma 3nは、Google DeepMindとQualcomm、MediaTek、Samsungなどのモバイルハードウェア企業と連携して開発された新アーキテクチャに基づいて構築されており、Gemini Nanoの基盤技術としても利用されています。

Gemma 3nでは、Per-Layer Embeddings(PLE)や高度な量子化処理、KVC共有技術などにより、メモリ効率を大幅に改善しており、モデルサイズが5Bおよび8Bでありながら、2GB~3GBのRAMでも運用可能で、あたかも2B~4B相当のメモリ負荷で実行できる点が特徴です。

音声、画像、動画、テキストといったマルチモーダルデータの組み合わせ処理に対応し、ローカル環境でのリアルタイムな応答やプライバシー重視のアプリケーションにも適しています。

Announcing Gemma 3n preview: powerful, efficient, mobile-first AI

Gemma 3の特徴

128Kコンテキスト長による大量情報の一括処理

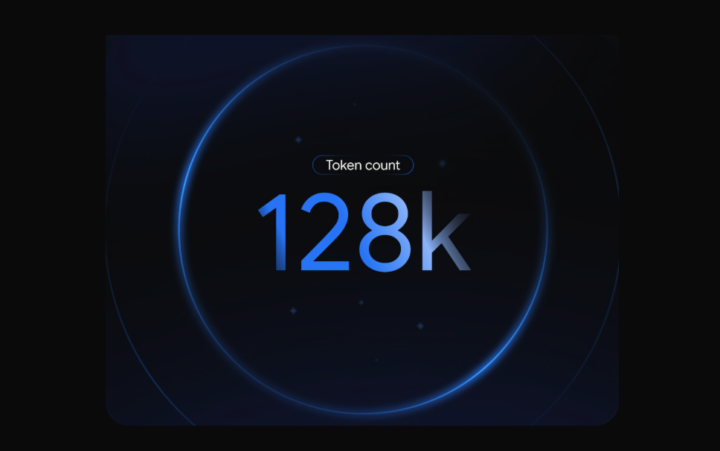

Gemma 3は、最大128Kという非常に長いコンテキストウィンドウを備えており、従来モデルの8Kに比べて格段に多くの情報を一度に処理することができます。

これにより、長文テキスト、複数の画像・動画データを組み合わせた情報解析、複雑な指示の理解といった、これまで難しかったタスクにも対応可能となっています。

質問応答や要約の整合性が高まり、長期的な文脈を踏まえた自然な応答を実現できるため、実用性が飛躍的に向上しています。

高い拡張性と外部ツールとのシームレスな連携

Gemma 3は、すでに利用している開発ツールやプラットフォームにそのまま統合できる高い拡張性を備えており、AI開発のスピードと柔軟性を大きく向上させます。

Hugging Face Transformers、Ollama、JAX、Keras、PyTorch、Google AI Edge、UnSloth、vLLM、Gemma.cpp など、主要なフレームワークやランタイムに対応しており、開発者は自分のプロジェクトやチームの技術スタックに応じて最適なツールを選択することができます。

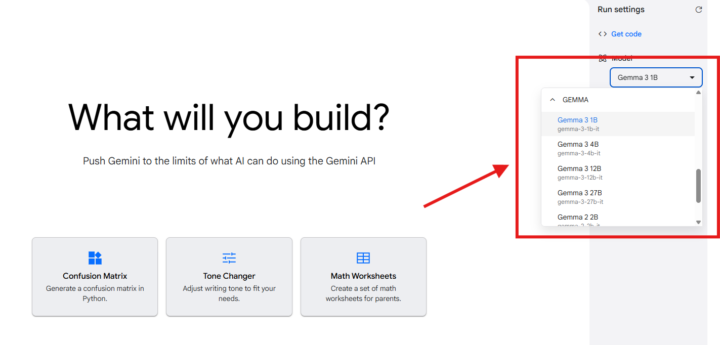

Google AI Studioを利用すれば、ブラウザ上ですぐにGemma 3の試用を開始でき、KaggleやHugging Faceからモデルを直接ダウンロードしてローカルでのカスタマイズも可能です。

また、Vertex AIやCloud Run、Google GenAI API、ローカル環境など、多様なデプロイメント手段をサポートしており、用途やインフラに応じた最適な運用が可能です。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Gemma 3の性能

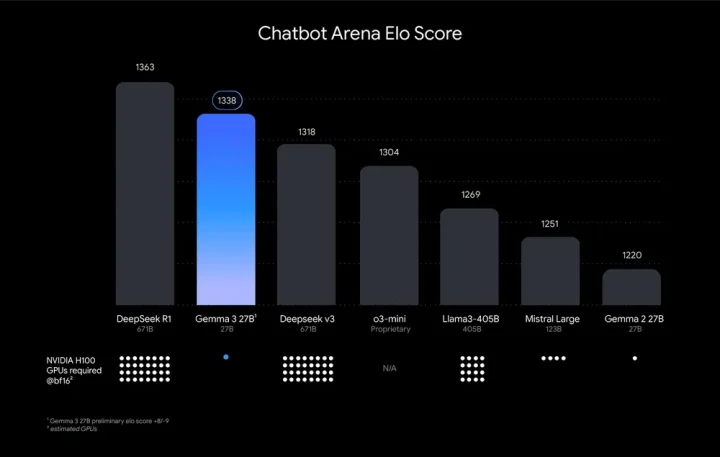

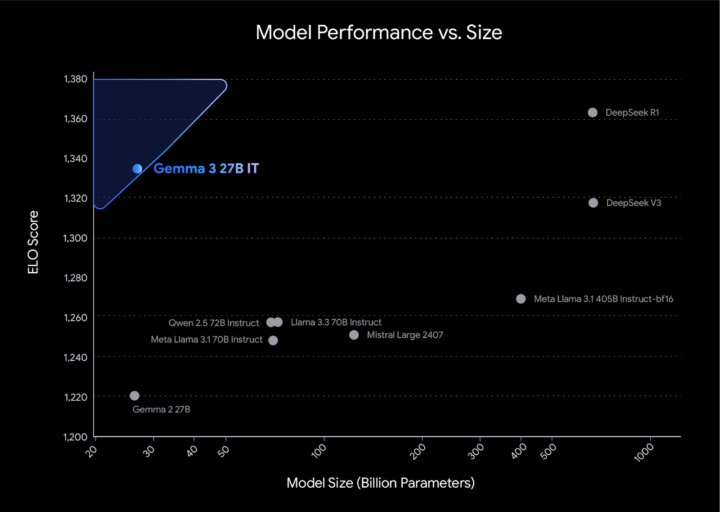

Gemma 3の性能は、「Chatbot Arena Eloスコア」において高く評価されています。スコア1338を記録し、DeepSeek v3(1318)やLlama 3-405B(1269)、Mistral Large(1251)といった強力な競合モデルを上回る結果となりました。

特に注目すべきは、Gemma 3がこの高スコアをわずか1枚のNVIDIA H100 GPUで実現している点です。

例えば、上位のDeepSeek R1やv3では6枚以上のGPUを必要とする一方、Gemma 3は単一GPUでも最先端の性能を発揮できるように設計されています。これは、Gemma 3がモデルサイズに対して非常に効率的であること、つまり「小さくて速くて強い」モデルであることを示しています。

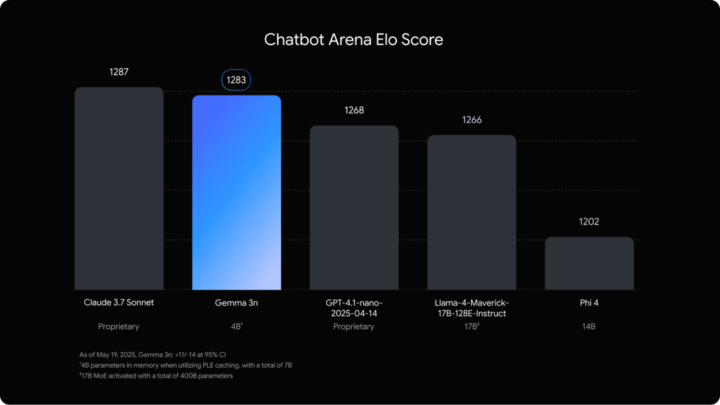

Gemma 3nの性能

Gemma 3nは、「Chatbot Arena Eloスコア」においても高い評価を受けており、同スコアでGemma 3 4Bを上回る応答速度と品質を達成しています。

また、MatFormerによる「Many-in-1」設計が特徴で、4Bモデル内部に2B相当のサブモデルをネスト構成として内包。ユースケースに応じて品質・応答速度のバランスを動的に切り替えられる柔軟な運用が可能です。

Gemma 2とGemma 3の違い

下記の比較表は、Gemma 2とGemma 3の主要な相違点をまとめたものです。

| 項目 | Gemma 2 | Gemma 3 |

|---|---|---|

| コンテキスト長 | 最大8K | 最大128K |

| 入出力 | テキストのみ | テキスト + 画像・動画 |

| 対応言語 | 一部主要言語 | 140以上 |

Gemma 2と比べた際の最大の進化点としては、まずコンテキスト長が8Kから128Kへと大幅に拡張された点が挙げられます。

また、多言語対応が140以上の言語に広がったことで、これまで対応できなかった地域の言語や専門性の高い言語でも、自然な応答を期待できるのが大きな特徴となっています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Gemma 3を使うには?

- Google AI Studioにログインし、Gemma 3のモデルを選択します。

ブラウザからGoogle AI Studioにアクセスし、Googleアカウントでログインします。ログイン後、AI Studioのホーム画面から「Gemma 3」を選択します。モデルの詳細ページで利用可能な機能や性能に関する説明を確認できます。

- 画面に表示されたチャットインターフェースに質問やプロンプトを入力します。

表示されるテキスト入力欄に、質問や指示を具体的かつ明確に記述して送信します。

- 送信ボタンをクリックすると、Gemma 3が生成した回答がチャット形式で表示されます。

表示された回答の内容が不明確または不十分な場合は、追加の質問を再度入力し送信することで、対話を継続し、モデルからさらに詳しい回答を得ることも可能です。

注意点

- 入力するプロンプトは明確かつ簡潔に記述しましょう。Gemma 3の性能を最大限引き出すためには、曖昧さを避けることが重要です。

- 質問や指示をする際、文脈を明確にすることで、より精度の高い回答を得られます。

- チャット履歴は一定期間保持されるため、個人情報や機密情報の入力は避けてください。

- Gemma 3から返される回答は生成モデルによるものであるため、重要な決定に使用する場合は、必ず人間による確認を推奨します。

Gemma 3の活用事例:実際の導入事例、業務活用、プロダクト開発、研究支援など

LM Studioのアップデートと量子化モデル揃ってたんで、Gemma 3 27Bをテスト。ローカルで動かせてVRAM16GBでフルオフロードできるモデルとしては、非常に満足度高い。

全般的な賢さは順当に向上してる。商用サービスには比べられないけど、コードの生成も理解もGemma… pic.twitter.com/CfrDkMpy73

— kogu (@koguGameDev) March 13, 2025

業務活用

問い合わせ対応用のチャットボットや、長文レポート作成を支援するツール、商品レビューの自動生成など、多くのビジネスシーンでGemma 3を活用できる可能性があります。

特にマルチモーダル対応を活かし、画像検索結果をテキスト化して在庫管理やカタログ作成に役立てる例などが考えられます。

プロダクト開発

オンデバイス推論を行う軽量モデルを用いることで、スマートフォンアプリや組み込み機器に高機能なAIを搭載することが可能です。

例えばカメラアプリにリアルタイムで画像認識と説明生成を組み込むなど、UI/UXの向上に直結する機能を追加できます。クラウド側と連携して、より大規模な推論やファインチューニングを行うハイブリッドな運用形態にも対応しやすいのがメリットです。

研究支援

大容量コンテキストを活用できるため、学術論文の要約や多言語コーパスを用いた分析など、高度な自然言語処理の研究にも応用可能です。

画像や動画の情報とテキスト処理を組み合わせたマルチモーダル研究においては、事前学習済みモデルとして実験を加速させる役割を果たします。独自ドメインのデータでファインチューニングを行うことで、専門的な分野にも特化できる点が大きな利点となります。

Gemma 3に関するよくある質問まとめ

- Gemma 3とGemma 2の主な違いは何ですか?

Gemma 3はGemma 2と比べて、コンテキスト長が8Kから128Kへと大幅に拡張され、テキストだけでなく画像や動画などの視覚情報も処理できるマルチモーダル対応が追加されました。

また、多言語対応が140以上の言語に拡充され、より自然な翻訳や多言語処理が可能になっています。さらに、モデルサイズのバリエーションが増え、1B、4B、12B、27Bと様々な用途に合わせた選択肢が提供されています。

- Gemma 3を利用する際の注意点は何ですか?

Gemma 3を含む生成AIモデル共通の注意点として、ハルシネーション(不正確な情報生成)のリスクがあります。重要な決定や判断に用いる場合は、人間によるレビューやクロスチェックのプロセスを整備することが推奨されます。

また、学習データに含まれる潜在的なバイアスが出力に影響を及ぼす可能性や、生成コンテンツの著作権問題なども考慮する必要があります。商用展開や公開を予定している場合には、法的リスクを十分に検討し、適切な運用ポリシーを整備することが重要です。

まとめ

Gemma 3は、前世代のGemma 2と比較して大幅に機能が拡張され、マルチモーダル入力や128Kのコンテキスト長、多言語対応などを実現することで、多様なタスクを一括して処理できる次世代のオープンモデルです。

研究開発からビジネス活用、個人によるアプリケーション開発まで幅広いニーズに応えられる一方、ハルシネーションやバイアス、著作権リスクなどへの対処が必要であり、開発者や運用者は常に責任を意識して扱わなければなりません。

ライセンス形態や料金体系については参照記事で明示されていないため、商用利用を検討する際は、今後の公式アナウンスを待ちつつ法的リスクや導入コストを十分に確認することが望まれます。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp