MLLM(マルチモーダルLLM)とは?LLMとの違い・メリット・代表モデル・活用分野を徹底解説!

最終更新日:2025年08月21日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

テキスト、画像、音声など、複数のデータを同時に理解・処理できるMLLM(マルチモーダル大規模言語モデル)の導入が、企業のAI(人工知能)活用デジタル変革を加速させています。

AIが生成する回答に、人間らしい自然さを求める方も多いでしょう。MLLMは多次元的な学習によって、高品質なタスク処理や生成を実現することが期待されています。

しかし、従来のLLMとの違いや、実際のビジネス価値について、明確な理解を持つことは容易ではありません。

この記事では、MLLMの概要からLLMとの違い、メリットについて解説していきます。さらには医療やロボティクスなど、各分野での実践的な活用方法まで、体系的に解説します。

MLLMの戦略的な導入を検討されている方々に、実務に直結する知見を提供します。

関連記事:「LLMの正しい理解と具体的な活用方法、導入コストの分析をわかりやすく解説」

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

LLMのカスタマイズに強いAI開発会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

目次

MLLMとは?

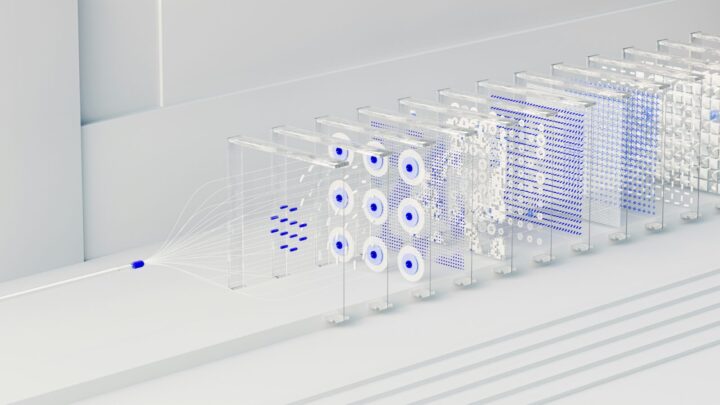

MLLM(Multimodal Large Language Model)とは、テキストだけでなく、画像、音声、動画などの複数のモダリティを同時に処理・理解できるAIモデルです。LLM(大規模言語モデル)を基盤としながら、画像や音声、動画などのデータを統合的に扱います。

言語データに加え、視覚的なデータセットや音声データセットも活用してMLLMが開発されるため、複数の情報を融合した処理が実現しています。多角的な情報処理が可能となり、複雑なタスクにも適応することが可能です。

マルチモーダルなタスクに対応できるモデルであり、それまでの特化型AIにはない汎用性を備えています。

LLM(大規模言語モデル)・VLMとMLLMの違い

MLLMとLLMの違いは、その処理能力と適用範囲にあります。LLMは主にテキストデータに特化して設計されています。そのため、テキストデータを用いて訓練されたモデルであり、自然言語処理(NLP)タスクに特化しています。

VLMは、LLMを拡張して主にテキストと画像の2つのモダリティに特化しています。MLLMの前身として開発され、画像-テキスト統合処理の基礎となりました。

一方で、MLLMは複数のデータ形式を同時に処理できる点で大きく異なります。テキストデータだけでなく、視覚的なデータや音声データを統合して処理できるよう設計されています。この違いにより、MLLMは次のようなより複雑なタスクに対応することが可能です。

- 画像を解析してその内容を文章で説明する

- 音声データをテキスト化し、追加の分析や生成を行う

- 文章に関連する画像や動画を生成する

技術的な観点から言えば、LLMはテキストデータのみを訓練データとして使用しますが、MLLMでは複数のデータ形式を組み合わせた多次元的な訓練が行われます。この結果、MLLMは異なるデータを一貫性のある形で理解することが可能です。

関連記事:「LLM・SLM・VLM・MLLM・LVM・LMMなどの用語、意味が分かる!」

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

MLLMを導入することでもたらされるメリット

MLLMが持つマルチモーダルな性能は、従来のAIモデルでは難しかった高度で多面的なタスクを可能とし、さまざまなメリットが期待されています。

以下では、MLLMを活用するメリットについて解説していきます。

人間に近いレベルでタスク処理が可能になる

マルチモーダルな性能を備えたMLLMを活用することで、人間に近いレベルでのタスク処理を可能にします。

例えば、画像を見ながらその内容を文章で説明し、関連する質問に答えるといった複雑なタスクに対応できます。これにより、人間が自然に行うマルチモーダルな認識や意思決定を、AIで再現することが可能です。

MLLMは会話だけでなく、画像や動画を交えたコミュニケーションも可能にするため、これまで以上に自然なタスク処理を実現できるでしょう。情報の相関性を理解する能力も高く、曖昧な質問や不完全な情報にも対応できる点で、MLLMは人間の感覚を再現しやすいモデルと言えます。

画像・音声・動画の出力も可能

MLLMは単なるテキスト生成にとどまらず、画像・音声・動画といった多様な形式のデータを生成、出力する機能を備えています。これにより、従来のAIシステムでは不可能だった幅広い応用が可能になりました。

例えば、ユーザーが入力した文章を視覚的に表現する画像を生成したり、教育やプレゼンテーションの場で利用できる動画の作成にも対応します。音声合成の分野においても、MLLMは入力テキストに基づいて自然で人間らしい音声を生成することが可能です。

こうしたマルチモーダルな技術は、ユーザーエクスペリエンスの向上や業務の効率化にも役立ちます。学習データの多角化によって、従来以上のユーザー体験を実現できるでしょう。

ユーザーインターフェースが向上する

MLLMをサイトに導入することで、ユーザーインターフェースの向上も期待できます。

例えばオンラインショッピングにおいては、ユーザーが入力した情報に基づき、関連する画像や動画を即座に提示できます。これにより視覚的な理解が深まり、選択肢を比較する時間が短縮されます。

音声による会話やリアルタイムの動画を利用した対話など、MLLMの導入によりコミュニケーション方法の幅が広がります。さらに、視覚障害者向けの画像説明生成や、聴覚障害者向けの音声テキスト変換など、MLLMの活用によりアクセシビリティが向上します。

さらに、異なる情報を一元的に提示する能力にも優れています。複雑な情報を視覚的なインフォグラフィックや動画で説明し、必要に応じて詳細なテキストや音声で補足することが可能です。

MLLMは従来のUIの枠を超え、より直感的でユーザー中心の体験を実現します。顧客満足度の向上やサービス利用率の増加も期待できます。

LLMベースの知見や技術を応用できる

MLLMは、LLMの知見や技術をそのまま応用できる点で高い利便性を誇ります。企業が活用してきた既存のLLMを無駄にすることなく、進化したモデルへと移行することが可能です。

また、LLMを活用したアプリケーションやサービスの移行時も、技術的な連続性が保たれるため、追加の開発コストを最小限に抑えられます。

例えば、LLMを活用して構築されたチャットボットに画像や音声の処理能力を付加することで、よりインタラクティブで直感的なユーザー体験を提供できます。エッジLLMを取り入れることで、より即応性の高いシステム設計が可能となります。

さらに、LLMの研究や開発によって蓄積されたノウハウがMLLMにも活かされるため、新しい技術の導入をスムーズに進めることも可能です。

代表的なMLLMモデル

MLLMを活用したモデルは既に開発されており、多くのユーザーや会社で活用されています。以下では、代表的なMLLMモデルについて解説していきます。

GPT-4o(omni)

GPT-4o(omni)は、OpenAIによって開発されたMLLMであり、画像や音声データも高度に処理できる点が特徴です。ChatGPTに搭載されています。

従来のLLMであるGPTシリーズを基盤に、マルチモーダル対応を可能にする技術を統合しています。

GPT-4o(omni)の特徴は、音声認識や言語理解など、複数のデータ処理を同時に行い、それに基づいて自然な応答や出力を生成するマルチモーダルな機能です。それまでにリリースされていたGPTモデルよりも高い汎用性を持ち、自然なインタラクションを目指します。

GPT-4o(omni)についてはこちらの記事で詳しく解説しているので、併せてご覧ください。

Gemini

GeminiはGoogleが開発したMLLMで、マルチモーダルなタスク処理において卓越した性能を発揮するモデルです。世界最大の検索プラットフォームのGoogleが蓄積したデータ資産とAI研究をもとに設計されております。テキスト・画像・音声・動画といったデータ形式を統合的に理解・処理する能力を備えています。

特に注目されるのは、GeminiがGoogleの各種システムと密接に連携している点です。これにより、Google Workspaceや検索エンジンといった既存のプラットフォームでのシームレスな統合が可能となり、業務効率を大幅に向上させます。

GoogleDocument内での高度な文章生成や、スライド作成における画像とテキストの統合的提案が挙げられます。

Geminiについてはこちらの記事で詳しく解説しているので、併せてご覧ください。

KOSMOS

KOSMOSは、Microsoftが開発したMLLMシリーズです。このシリーズには、KOSMOS-1とKOSMOS-2が含まれています。

KOSMOS-1は、テキストと画像を統合的に処理できる最初のモデルです。自然言語と視覚的コンテンツの両方を認識し、処理できます。画像のキャプション生成や、画像に関連した質問への回答が可能です。

KOSMOS-2は、KOSMOS-1の後継モデルで、より高度な機能を備えています。主な特徴は以下の通りです。

- テキスト、画像、動画、音声を理解し生成することが可能

- 1.8億以上のサンプルを含む大規模なデータセットで訓練

- タスク適応的な微調整が可能

KOSMOSシリーズは、人間のように複数の感覚を統合して情報を処理する能力を持つことで、より自然で高度な人工知能の実現に向けた重要な一歩となっています。

Phi-3-vision

Phi-3-visionは、Microsoftが開発したPhi-3ファミリーに属する42億パラメータのマルチモーダルなSLM(小規模言語モデル)です。SLMは特定タスクの処理を得意とする軽量型の言語モデルです。Phiシリーズのほかに、「1ビットLLM」として有名なBitNet b1.58が代表的なモデルです。

Phi-3-visionは、テキストと画像の両方を処理できる能力を持ちます。特に言語、推論、コーディング、数学のタスクで高い性能を示しています。チャート、図表、ダイアグラムなどの視覚的情報を分析し、それに基づいて推論を行うことができます。

42億パラメータという比較的小さなサイズながら、同等またはより大きなモデルと比較して優れたパフォーマンスを発揮します。小型モデルであるため、限られたリソースやローカル環境でも効率的に動作します。これにより、モバイルデバイスなどでのローカルLLMやエッジコンピューティング環境での利用が可能になります。

関連記事:「AI在庫管理で業務効率化!導入事例や問題点も解説」

LLaMA-Omni

LLaMA-Omniは、中国科学院大学(UCAS)の研究者が開発したオープンソースのMLLMです。音声とテキストの両方を統合的に処理できる能力を持っています。

LLaMA-OmniはMetaのLlama-3.1-8B-Instructモデルをベースにしています。これにより、高品質な言語処理能力を継承しています。

音声指示から直接テキストと音声の応答を同時に生成でき、応答遅延はわずか226msと非常に短いです。

関連記事:「オープンソースLLMの特徴やビジネスでの活用メリット、代表的なモデルの比較ポイント」

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

MLLMの分野別活用方法

MLLMの高度なデータ統合能力により、さまざまな分野での活用が進んでいます。以下では、具体的な活用事例を通してMLLMがどの分野で用いられているか見ていきましょう。

医療

医療分野におけるMLLMは、画像診断や音声入力の電子カルテ作成に対応できるため、医療現場の負担を軽減しつつ、精度の高い医療を提供することが可能です。

例えばMRIやCTスキャンの画像を解析し、異常の兆候を迅速かつ正確に検出できます。見逃されがちだった病変を早期に発見し、迅速な治療に結びつけることが可能です。

さらに、MLLMは医療従事者向けに症例データを視覚的に示したり、複雑な医療情報を要約することで、学習の質を向上させます。また、患者に対しては治療法や薬の説明を分かりやすく提示し、治療に対する理解と安心感を提供します。

こうした特性により、MLLMは医療の品質と診断効率を高める技術として、今後導入が進むでしょう。

ロボティクス

ロボティクス分野でMLLMを活用することで、ロボットの知覚能力と応答性の向上が期待されています。従来のロボットには難しかった、複雑なタスクへの対応が可能になります。

MLLMを搭載したロボットは、カメラを通じて視覚的な情報を認識し、物体の識別や状況の把握を行いながら、音声入力をもとにユーザーの指示を理解することが可能です。これにより、物流や製造現場でのピッキング作業や、家庭内での掃除や料理のサポートといったタスクに対応できるようになります。

また、MLLMの学習能力はロボットが動的な環境に適応する性能を強化することも可能です。例えば教育分野では、ロボットが表情や声のニュアンスを理解し、より人間らしいコミュニケーションを実施することも期待されています。

MLLMの導入により、ロボティクスは日常生活においても可能性を広げることになるでしょう。

自動運転

自動車分野においては、次世代のスマートカーや自動運転技術の実現をMLLMが大きく後押しします。MLLMのマルチモーダルデータ処理能力により、従来の車両システムでは難しかった複雑な状況の把握や、ユーザーとの高度なインタラクションが可能となります。

自動運転の場面では、MLLMがカメラやセンサーから取得した画像や動画を解析し、周囲の状況や歩行者の動きを正確に認識します。同時に、リアルタイムでこれらの情報を統合し、車両の動きを適切に制御することで、安全性の向上も実現します。

MLLMについてよくある質問まとめ

- MLLMとは?

MLLMは、主に2023年以降に登場した複数のモダリティを統合した大規模言語モデルです。テキストや画像だけでなく、音声や動画といった異なる形式のデータを一貫して理解し、生成することが可能です。

- MLLMとLLMはどう違いますか?

MLLMとLLMの主な違いは、その処理能力と対応範囲です。LLMは主にテキストデータの処理に特化し、言語の理解や生成に優れています。一方、MLLMは複数のデータ形式を同時に扱える点で特徴があります。

- MLLMは既存のAIシステムと併用できますか?

はい、多くの場合、既存のAIシステムとの統合が可能です。特にLLMベースのシステムとは高い親和性があり、段階的な機能拡張が可能です。ただし、データ形式の標準化やAPIの連携など、技術的な調整が必要になる場合があります。

まとめ

MLLMは、テキスト以外に画像や音声、動画といった複数のデータ形式を統合的に処理する能力を持つ、次世代のAIモデルです。従来のLLMを基盤としつつ、その枠を超えたマルチモーダルなタスク処理を可能にし、さまざまな分野での応用を広げています。

自動運転の実現やロボットの信頼性向上、人間らしい自然な回答生成など、特化型のAIにはない、新たなソリューションを提供してくれることは間違いありません。

GPT-4oやGeminiなど、既にMLLMとして利用できるモデルもあります。しかし、効果的な導入には、業界固有の要件や既存システムとの統合など、専門的な検討が必要です。具体的な実装方針の策定には、AI専門のコンサルタントや、各分野の専門家との連携をお勧めします。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp