オープンソースLLM15選!特徴・活用メリット・モデルの比較ポイントも徹底解説

最終更新日:2025年10月04日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

ChatGPTに搭載されているOpenAIのGPTモデルなど、クローズドなLLM(大規模言語モデル)が圧倒的なシェアを有する状況ですが、企業のユニークなニーズに特化させるためにオープンソースのLLMの開発も進んでいます。

オープンソースのLLMは、自社のサーバやローカル環境にインストールすることで、ライセンス料金を負担することなく、無料で自由に企業のニーズに合うようにカスタマイズできることから、多くの企業での活用が進み始めています。

本記事では、

LLMとは何か?についてはこちらで詳しく説明していますので併せてご覧ください。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

ChatGPT/LLM導入・カスタマイズに強いAI開発会社を自力で選びたい方はこちらで特集していますので併せてご覧ください。

オープンソースのLLMとは?

オープンソースLLMとは、誰でも自由に無料で利用・改変・再配布できる形で公開されたLLM(大規模言語モデル)を指します。ソースコード、アーキテクチャ、学習済みの重みなどが公開されています。

ChatGPTなどのクローズドLLMは、ソースコードが非公開で利用に制限があります。しかし、オープンソースのLLMを活用すれば、自社のニーズに合わせてカスタマイズし、独自のソリューションを構築できます。

以下では、活用メリットとデメリットについて紹介します。

オープンソースLLMのメリット

オープンソースLLMには以下のメリットがあります。

- コストの削減:オープンソースLLMはライセンス料が不要で、開発コストを大幅に削減できる

- 多様性: 様々なモデルから選択可能

- セキュリティとプライバシーの向上:ローカル環境で運用すればデータを外部送信する必要がなく機密情報の保護につながる

- 柔軟なカスタマイズ:ファインチューニングやRAG機能追加により、自社のニーズに合わせたカスタマイズが容易にできる

- 説明可能性の向上:出力のプロセスが明確なため、信頼性を持って活用できる

- コラボレーション: コミュニティによる継続的な改善

クローズドソースLLMと比較すると、オープンソースLLMはセキュリティ向上や柔軟なカスタマイズが可能なことから、自社の要件に合わせた効率的かつ安全なAI(人工知能)ソリューションの構築が容易となります。

オープンソースLLMを企業が使う際の注意点

オープンソースLLMにはいくつか以下のようなデメリットも存在します。

- 商用利用時のライセンス条件:ライセンス情報の提供など利用の際には一部条件があるため、導入前に確認が必要

- セキュリティリスク:オープンソースには潜在的に悪意のあるコードが含まれる可能性もあり、強固なセキュリティ対策が必要

- 計算リソースが必要

- 品質や安全性は独自に検証が必要

- 専門知識の必要性:カスタマイズには高度な技術と専門知識を持つ開発者が必要

- 言語対応:日本語に対応していないモデルが多い

特に、英語などほかの言語のみで日本語に対応していないLLMでは、いくらカスタマイズ性が高くても日本語の生成精度が低くなる傾向にあるため、利用する際には注意しましょう。これらの課題を理解したうえで導入を進めることが重要です。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

代表的なオープンソースLLM

ここでは、LLMのオープンソースを紹介します。それぞれの日本語対応の有無や性能、商用利用の可否などの基本情報を比較しましょう。

Meta Llama

Llama(Lifelong Language Model Architectures)は、Meta(旧Facebook)によってリリースされたオープンソースLLMです。以下のように順次モデルが発表されています。

- Llama 1:2023年2月に初めて公開

- Llama 2:2023年7月に発表され、商用利用が可能に

- Llama 3:2024年4月に発表され、8Bと70Bのモデルが公開

- Llama 3.1:2024年7月24日に発表され、8B、70B、405Bの3サイズのモデルが公開

- Llama 3.2:マルチモーダル機能を持つ大型モデルとエッジLLMとして携帯端末での利用を可能にする1Bと3Bの軽量モデルを含む:

- Llama 3.3:2024年12月7日に発表され、70Bパラメータの高性能テキスト専用モデルとして公開

- Llama 4:2025年4月6日に発表された、マルチモーダル対応、高い長文処理性能とコストパフォーマンスを持つモデル

Llama 2以降のモデルは商用利用が可能になり、これにより以下をはじめとする多くの派生モデルが開発されています。

- 株式会社ELYZA「ELYZA-japanese-Llama-2-70b」

- rinna株式会社「Llama 3 Youko 8B」

- LLaMA-Omni:Llama-3.1-8B-Instructモデルをベースにして開発された、音声指示からテキストと音声の応答を同時に生成できるMLLM

日本をはじめさまざまな国におけるLLM開発が促進されています。また、プログラミング支援機能である「Code Llama(ラマ)」を搭載しており、容易に開発できる点も魅力の一つです。

ただし、Llama 3.1以降の商用利用については、条件がある場合があるので利用規約の確認が必要です。

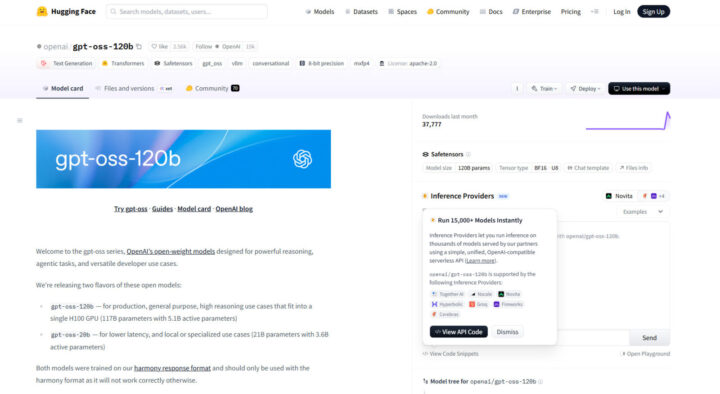

gpt-oss

gpt-ossは、OpenAIが2025年8月に公開した、商用利用も可能なオープンソースLLMです。高い推論能力を持つ高性能版「gpt-oss-120b」と、一般的なPCでも動作する軽量版「gpt-oss-20b」の2種類が提供されています。

専門家(エキスパート)ネットワークを切り替えるMixture-of-Experts(MoE)技術により、OpenAIのクローズドモデル「o4-mini」に匹敵する性能と計算効率を両立しています。Apache 2.0ライセンスのもと、誰でも自由にモデルを改変・利用できるため、オンプレミスでのセキュアなAI開発や、革新的なアプリケーション創出を加速させる存在として期待されています。

Google Gemma

Gemma(ジェマ)は、Googleが2024年2月21日にリリースされた商用利用可能なオープンソースLLMで、テキスト生成を主な用途としています。

関連記事:「Gemma 2とは?特徴・メリット・デメリット・活用分野を徹底紹介!」

小規模な「Gemma 2B」と大規模な「Gemma 7B」が提供され、どちらも開発者向けのノートパソコンやデスクトップで実行できる軽量さが特徴です。また、プリトレーニングされたバージョンと、指示調整済みバージョンの両方が提供されており、特定のタスクに合わせたチューニングが容易です。

このような特徴から、エッジAIをはじめ幅広いビジネスアプリケーションでの活用が期待されています。

また2024年5月には、Gemmaを基盤とした、データを参照することで事実性の高い生成が可能な「DataGemma」が公表されました。RIG(Retrieval-Interleaved Generation)とRAG(検索拡張生成:Retrieval-Augmented Generation)の2つのアプローチを使用していることが特徴です。

「Data Commons」を利用したファクトチェック機能を持ち、信頼性の高い数値情報の生成に強みを持ちます。Gemmaの性能とDataGemmaのデータ信頼性を組み合わせることで、より正確で効率的なAIソリューションの構築が期待されています。

2024年10月3日、日本語版Gemma 2 2Bの公開が発表されています。優れた文章力と指示内容の的確な理解力を持ち、自社評価ではGPT-3.5を上回る性能を示している。

Gemmaファミリーには、ほかにもコード生成に特化したCodeGemma、プライバシー保護を特色としたVaultGemmaなどがあります。

Mistral 7B

Mistral 7Bは、フランスに本社を置く生成AI専門企業の「Mistral AI」によって2023年9月にリリースされたLLMです。

Grouped Query Attention(GQA)やSliding Window Attention(SWA)により、高速な推論と高精度な回答を可能にしている点が特徴です。実際にAIベンチマークでは、Llama 2 13Bをすべてのベンチマークで上回り、多くのベンチマークでLlama 1 34Bを上回っています。

商用利用が許可されており、高速なテキスト生成やリアルタイムアプリケーションでの活用が期待されています。HuggingFaceやGitHubで公開されています。

関連記事:「Mistral AIとは?特徴や主要モデルをわかりやすく徹底解説!」

DeepSeek-R1

DeepSeek-R1は、中国のAI企業DeepSeekが開発したLLMです。MITライセンスで提供されており、オープンソースで商用利用も可能です。

Mixture of Experts (MoE) アーキテクチャで671億パラメータを持ち、最大128,000トークンのコンテキストを処理可能です。強化学習 (RL) を用いて推論能力を向上させ、教師あり微調整 (SFT)RLSFTで言語一貫性を高めています。

公式サイトで無料で利用可能です。API利用料金も低価格ですが、数学やプログラミングなどのタスクでOpenAI-o1と同等の性能を収めています。

関連記事:「DeepSeek-R1とは?OpenAI o1に迫る高性能モデルの料金・アーキテクチャの特徴、使い方、注意点を徹底解説」

Stable LM

画像生成AIモデルで有名なStable Diffusionを開発・提供しているStability AIは、オープンソースLLMである「Stable LM 2 1.6B」も提供しています。

16億パラメータの小規模言語モデル(SLM)となっており、高速な処理を可能とします。

Stability AI Membershipに登録することで、商用利用も可能となっている他、Hugging Faceで試すことも可能です。また、Stable LMには、日本語特化のモデルである「Japanese Stable LM 2 1.6B」もあります。

関連記事:「Stable Diffusionの概要や使い方、メリットを解説」

Qwen

Alibaba Cloudが開発する「Qwen(通義千問)」は、商用利用も可能なオープンソース大規模言語モデル(LLM)の代表格です。最大の特徴は、軽量な小規模モデルから超大規模モデルまで幅広い選択肢を提供し、用途やコストに応じて柔軟に選べる点にあります。

2025年に発表されたQwen3では、複雑な問いに対して思考してから回答する「ハイブリッド推論」機能を搭載し、論理的思考力や精度が飛躍的に向上しました。高い性能と開発の自由度を両立しており、Meta社のLlamaシリーズなどと並び、企業が独自のAIソリューションを構築する際の有力な選択肢として世界中から注目されています。

GPT-NeoX-20B

GPT-NeoX-20Bは、EleutherAIが開発したオープンソースの自己回帰型言語モデルで、GPT-3と似たアーキテクチャを採用しています。

このモデルは、200億個のパラメータを持ち、効率的に学習できるように分散学習や3D並列化(複数のGPUに分割する機能)に対応している点が特徴です。

モデルの重みとコードはGitHubで公開されています。商用利用が許可されているため、企業は新しいLLMモデルの研究や製品開発に活用することが可能です。

ただし、研究用途を主目的としており、製品化や人間とのインタラクションには適していない可能性があります。

GPT-J-6b

GPT-J-6Bは、EleutherAIが開発した60億個のパラメータを持つ事前トレーニング済みGPTです。プロンプトに基づいて、人間らしいテキストを生成する目的で開発されました。

英語の自然言語データセットで学習されていることから、英語のテキスト生成には幅広く適用可能ですが、英語以外の言語には対応していないため、翻訳や日本語生成サービスで利用する際は注意が必要です。

商用利用が許可されていることからも、英語のLLMサービスを展開する企業にとっては効果的なツールとなります。

多様な英語テキストを含む大規模なデータセットThe Pile データセットで訓練されているため、不適切な内容を生成する可能性があります。人間による監視や修正が必要です。

また、英語のみのモデルであり、他言語への翻訳や生成には適していません。

BLOOM

BLOOM(BigScience Large Open-science Open-access Multilingual Model)は、BigScienceが2022年7月に開発したオープンソースの多言語LLMです。GPT-3アーキテクチャをベースにした自己回帰型言語モデルです。

BigScienceは、1,000人以上の研究者が70か国以上から参加した大規模な共同プロジェクトです。

BLOOMは、1,760億(176B)個のパラメータを持ち、46の自然言語、13のプログラミング言語に対応しています。また、商用利用が許可されているため、海外研究や海外マーケティングなどで多言語への翻訳が必要なシーンなど、企業が国際展開を目指す際に役立つLLMといえます。

だし、BigScience RAIL License v1.0も適用されており、医療アドバイスや法執行、移民・難民プロセスなど、特定の用途での使用が制限されています。

Falcon

Falcon(ファルコン)は、アブダビにあるTechnology Innovation Institute(TII)が2023年に開発したLLMです。バリエーションが豊富で、以下のように多様なモデルが提供されています。

- Falcon-7B:70億個のパラメータ

- Falcon-40B:400億個のパラメータ

- Falcon-180B:1,800億個のパラメータ

- Falcon 2シリーズ:110億個のパラメータ

特に、3.5兆トークンのデータで学習されたFalcon-180Bは自然言語処理能力が高く、長いコンテキストを扱えるほか、英語やフランス語、イタリア語など多言語に対応可能です。また、大規模なデータセットで学習されており、コーディングや論理的推論、知識テストなど幅広いタスクで応用できます。

Falconは商用利用が許可されており、高度な自然言語処理を必要とするビジネスシーンでの活用が期待されています。

最新のFalcon 2シリーズは、マルチモーダル機能を持ち、画像から言語への変換能力を持っています。

OPT-175B

OPT-175Bは、米国のMetaによって2022年5月に開発されたLLMです。最大1,750億個のパラメータを持ち、GPT-3に匹敵するパフォーマンスを発揮します。

OPT-175Bは、事前学習済みモデルとソースコードの両方が公開されており、LLMの研究者や開発者にとって貴重なリソースとなっています。

学習ログ、学習プロセスの詳細な情報が公開されており、LLM研究の透明性向上に貢献しています。

ただし、2024年10月時点では主に研究目的での利用を想定しており、非商用ライセンスの下で提供されているため、商用利用を考えている企業は同じMetaから発表されているLlamaなど別の商用利用可能なモデルの検討が必要です。

Vicuna-13B

Vicuna-13Bは、オープンソースLLMの「LLaMa 13B」を基に、「ShareGPT」で収集されたユーザーの会話データを使用して微調整されたオープンソースの会話モデルです。カリフォルニア大学バークレー校を中心とするLMSYS Orgによって開発されました。

このモデルは、高度な自然言語処理が可能な「BardやChatGPT」の90%程度の機能を達成し、LLamaなどほかのオープンソースと比べても高品質な会話生成が可能とされています。

そのため、自然文から質の高い回答が必要とされるカスタマーサービスや医療、金融などの業界での応用が期待されています。

ただし、現時点では、完全なモデルではなく、コードやパラメータなどは非商用目的でのみ公開されているため、企業が活用する際には利用範囲に注意が必要です。

MPT-7B

MPT-7Bは、米国のAIスタートアップ企業「MosaicML」が2023年5月に公開した商用利用可能なTransformerモデルです。67億個のパラメータを持ち、LLAMA-7Bと同じレベルの高度なパフォーマンスを発揮します。

また、非常に長いコンテキストを扱えるように、1兆トークンもの英語テキストとコードから事前学習されているため、技術文書やコラムの生成に向いています。

約20万ドル、9.5日間で学習され、人間の介入なしで開発されたことで注目されました。ベースモデルに加えて、以下の特殊化されたモデルが提供されています。

- MPT-7B-StoryWriter-65k+(長文生成用)

- MPT-7B-Instruct(指示対応用)

- MPT-7B-Chat(チャット用)

XGen-7B

XGen-7Bは、Salesforce社が2023年7月にリリースした70億個のパラメータを持つオープンソースLLMで、商用および研究目的で利用可能です。

また、最大8Kのシーケンス長と1.5Tトークンで学習されており、長いコンテキストの入力に対応可能です。比較的小規模ながらも優れたパフォーマンスを発揮し、LLaMAやFalconなど他の大規模なオープンソースモデルと比較して、同等以上の結果を達成しています。

以下のような複数のバリエーションがあります。

- XGen-7B-4K-base:4Kコンテキストをサポート

- XGen-7B-8K-base:8Kコンテキストをサポート

- XGen-7B-{4K,8K}-inst:指示データで学習された版

XGen-7B-4K-baseとXGen-7B-8K-baseはApache 2.0ライセンスで公開されており、商用利用が可能です。XGen-7B-{4K,8K}-instは非商用ライセンスで、研究目的のみに利用可能です。

LLM-jp-13B

LLM-jp-13Bは、日本の国立情報学研究所(NII)が主導する「LLM勉強会」から2023年にリリースされた130億個のパラメータを持つオープンライセンスのLLMです。LLaMAアーキテクチャを採用しています。

約2,600億トークン(日本語約1,300億、英語約1,200億、プログラミング言語約100億)で訓練されています。日本語と英語を中心に事前学習されている点が大きな特徴で、国内のアカデミアや産業界での研究開発への活用など、今後の日本語NLPの発展に貢献することが期待されています。

オープンソースLLMの比較ポイント

数多く提供されるオープンソースLLMの中で、自社にとって最適なLLMを見極める際の比較ポイントを紹介します。比較ポイントを理解し、企業のニーズに最も適したLLMを選定することが成功へのカギとなります。

モデルのサイズ

モデルのサイズは、パフォーマンスとコストに大きな影響を与えます。一般的に、パラメータ数が多いモデルほど高精度な結果が期待できますが、それに伴い必要な計算リソースも増加します。例えば、BLOOM 176Bのような大規模なモデルは高精度ですが、大量の計算リソースが必要です。

そのため自社の活用ケースやインフラに応じて、適切なサイズのモデルを選ぶことが重要です。タスクの複雑さ、必要な推論速度、利用可能なハードウェアを考慮しましょう。

特に、リソースが限られた環境での導入では、「GPT-NeoX-20B」や「XGen-7B」などの効率性の高い軽量モデルがおすすめです。量子化技術を用いて、モデルサイズを圧縮し、推論速度を向上させることも検討できるでしょう。例えば、1ビットLLMが、その一例として注目されます。

日本語対応の有無

オープンソースLLMの中には、「LLM-jp-13B」や「LLama」のように日本語の処理が可能なLLMも存在しますが、主に英語に最適化されたモデルが多いため、言語対応状況を確認することが重要です。

日本語対応が可能なオープンソースLLMを活用すれば、日本語の自然な問いかけでも利用できるなど日本人ユーザーにとってより使いやすいLLMの提供が可能となり、ユーザー体験の向上につながります。

BERTやRoBERTaなどの事前学習済みモデルを日本語コーパスでファインチューニングすることで、日本語処理能力を向上させることも可能です。

日本語特化のLLMはこちらの記事で解説していますので、ご参考ください。

カスタマイズ性

モデルのアーキテクチャが柔軟であり、カスタマイズがどの程度容易かも、LLM選定の重要な要素です。例えば、以下のような手段でビジネスニーズに応じて最適化できるかどうかを確認しましょう。

- ファインチューニング:特定タスクに特化したモデルの作成

- プロンプトエンジニアリング:タスク特化型の入力設計

- RAG(検索拡張生成:Retrieval-Augmented Generation): 外部知識の統合

- Few-shot learningやZero-shot learning:少量のデータでもタスクに適応させる

自社のワークフローやデータ環境に合わせたカスタマイズが可能なLLMであれば、より質の高いLLMの開発が可能となります。また、画像や音声、動画の生成や分析が必要であればVLMやMLLMの活用も視野に入れましょう。

関連記事:「LLM・SLM・VLM・MLLM・LVM・LMMなどの用語、意味が分かる!」

商用利用の範囲

オープンソースLLMの中には、「LLaMA」や「MPT-7B」のように商用利用が認められ多くの企業に活用されているLLMもある一方で、商用利用が制限されているものもあります。

そのため、企業は導入前に商用利用のライセンス条件を詳細に確認する必要があります。一部のモデルは研究目的での利用に限られ、商用展開には適していない場合があるため、使用目的に応じたライセンスの選択が重要です。

また、ライセンス条件により、追加の費用や制約が発生する可能性があるため、事前の確認が不可欠です。

パフォーマンスとベンチマーク

モデルの実際の性能を評価するためには、標準的なベンチマークを参照することが重要です。以下は、LLMの代表的な各用途における代表的なベンチマークです。

- 言語理解:GLUE, SuperGLUE

- 質問応: SQuAD, TriviaQA

- 推論能力:LAMBADA, HellaSwag

上記ベンチマークを参考にしながら、自社の具体的なユースケースに基づいたカスタムベンチマークを作成し、実際の業務環境での性能を評価しましょう。A/Bテストを実施し、異なるモデルやバージョン間のパフォーマンスを比較検証することが重要です。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

オープンソースLLMについてよくある質問まとめ

- オープンソースLLMの商用利用は可能ですか?

多くのオープンソースLLMは商用利用が可能ですが、モデルによってはライセンス条件が異なります。

導入前に必ずライセンス内容を確認し、商用利用が許可されているかを確認することが重要です。

- 日本語に対応したオープンソースLLMはありますか?

LLM-jp-13Bなど一部のオープンソースLLMは日本語に対応していますが、現在リリースされている大半のモデルは英語に最適化されています。

そのため日本語対応が必要な場合は、対応しているモデルを選択するか、カスタマイズや追加トレーニングを検討する必要があります。

まとめ

オープンソースLLMは、コスト削減やカスタマイズの柔軟性など多くのメリットがありますが、セキュリティや専門知識の必要性といった課題も存在します。

近年LLMの需要拡大に合わせて

選定する際には今回紹介した

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp