LLMとは?企業活用事例・世界モデルとの違い・導入方法とコスト・代表的モデルを徹底解説!AI Marketでの導入相談事例付き

最終更新日:2025年12月20日

生成AI(ジェネレーティブAI)の発展に伴い、「LLM(大規模言語モデル)」への関心が高まっています。特に、ChatGPTの急速な普及によりメディアでも非常に多く取り上げられています。

多くの企業が導入を検討する一方で、どのモデルを選べばいいのか、自社開発は必要なのか、どう活用できるのかといった疑問を抱えています。

この記事では、LLMとはなにか、正しい理解と具体的な活用方法、導入コストの分析、さらには、AI Marketで実際に開発企業の紹介を行った事例についてもわかりやすく解説します。LLMの適切な選定と活用がどう自社の成長につながるのかを理解できるでしょう。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

LLM・RAG開発が得意なAI開発会社について知りたい方はこちらで特集していますので併せてご覧ください。

目次

- 1 LLM(大規模言語モデル)とは?

- 2 LLMの特徴

- 3 LLMで何ができる?

- 4 LLMの仕組み

- 5 AI MarketでのLLMに関連する相談事例

- 6 企業でのLLMの活用事例

- 7 LLMの企業導入に伴う課題とリスク

- 8 LLM導入を成功させるためのポイント

- 9 代表的なLLM

- 9.1 OpenAI GPT-3系

- 9.2 OpenAI GPT-4系

- 9.3 OpenAI oシリーズ

- 9.4 OpenAI GPT-5

- 9.5 Gemini

- 9.6 Meta Llamaシリーズ

- 9.7 Anthropic Claudeシリーズ

- 9.8 Mistral AI Mistralシリーズ・Mixtralシリーズ

- 9.9 IBM Graniteシリーズ

- 9.10 DeepSeek-R1

- 9.11 Cohere Commandシリーズ

- 9.12 Qwen

- 9.13 Google Gemmaファミリー

- 9.14 Google LaMDA

- 9.15 Google PaLM2

- 9.16 Google BERT

- 9.17 Alpaca 7B

- 9.18 Cotomi

- 9.19 Grok

- 9.20 BitNet b1.58

- 9.21 OpenELM

- 9.22 Omnilingual ASR

- 10 LLMは自社開発よりもカスタマイズの方がコスパがよい?

- 11 LLMカスタマイズの手順

- 12 LLMから派生した関連用語

- 13 LLMについてよくある質問まとめ

- 14 まとめ

LLM(大規模言語モデル)とは?

LLM(Large Language Models)とは、多くのテキストデータから学習し、人間のような文章を生成できるAIモデルの一種です。自然言語処理(NLP)の分野で最先端の技術であり、昨今注目されている生成AIの代表格と言えます。日本語では、「大規模言語モデル」と言われます。

AIモデルにどんな種類があるかこちらの記事で詳しく説明していますので併せてご覧ください。

ほとんどのLLMはインターネット上の膨大なテキスト情報からパターンを学び取ります。自然言語処理(NLP)の分野の一種であり、人々が普段使う言語を理解し生成する能力を持ちます。

大量のデータと複雑なアルゴリズムに基づいて動作し、多岐にわたるタスクで使用されることが一般的です。

LLMの歴史

自然言語処理の初期の段階では、ルールベースや統計ベースの手法が主に用いられました。

2010年代初頭ごろから、ディープラーニング(深層学習)の進展に伴い、単語の埋め込みやRNN、LSTMなどのアーキテクチャが開発されました。また、word2vecもこの時期に登場し、従来の自然言語処理技術に革新をもたらしました。

関連記事:「ディープラーニングと機械学習の違いは?使い分け注意点、ビジネス活用事例徹底解説!」

2017年、GoogleがLLMのベースとなるTransformerというモデルを発表しました。このモデルは文中の単語どうしの関連性を理解するAttention機構(注意機構)を導入し、自然言語処理の分野に革命をもたらし、昨今のLLMの全世界的な流通の発端となっています。

このTransformerをベースに、BERTやGPTのような有力モデルが登場しました。特に、GPTシリーズは大規模なパラメータを持つモデルとして注目されています。

2020年代に入ると、より大規模なモデルが開発され、LLMが主流となりました。OpenAIのGPT-3、GPT-4などが代表例です。

ChatGPTはLLM?

ChatGPTは直接的にLLM(大規模言語モデル)ではなく、LLMを基に構築された対話型AIのサービスです。OpenAIのOpenAI o1、GPT-4oと言ったLLMによって駆動されており、質問への回答、文章生成、会話シミュレーションなどを行います。

Googleの対話型AIであるBard(現在はGemini)は、GoogleのLLMであるPaLMやGeminiをベースとしており、MicrosoftのCopilotでは、GPTをベースとしています。

このように、ChatGPT自体はLLMではなく、LLMをベースとし、コミュニケーションを取りやすいインターフェースを持つ対話型サービスというのが正確な表現です。

関連記事:「ChatGPTとは?できることは?どのように活用できるのか?ChatGPTの基本を徹底解説」

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

LLMの特徴

LLMの特徴は以下の通りです。

| 特徴 | 特徴がもたらすメリット・デメリット |

|---|---|

| 規模 | 数百億から数兆のパラメータを持っているので、複雑なパターンと構造を学習可能 |

| 訓練データ | 広範なドメインと言語で訓練されており、多岐にわたるタスクに対応可能 |

| 汎化能力 | 大規模なパラメータとデータにより、LLMは新しいデータやタスク(未見のデータ)に対して正確に予測や分析を行える |

| コスト | 訓練と実行は非常にコストがかかり、専門的なハードウェアと人員が必要 |

上記の特徴が、LLMが複雑で高度なタスクを実行できる理由を説明しています。

ただし、パラメータをとにかく大きくしようとする時代も限界が見え始めているという意見もあります。量子技術を用いて計算量を抑制することで高性能なハードウェアを不要とする量子LLMも既に実用化されています。

LLMと世界モデルの違い

LLM(大規模言語モデル)は、膨大なテキストデータを学習し、文章生成や要約といった言語タスクに特化したAIです。いわば「言葉の世界」の専門家であり、テキストのパターンを理解して、次に来る確率が最も高い単語を予測することで機能します。

一方、世界モデルは言語に留まらず、動画などの多様なデータから物理法則や因果関係といった世界の仕組み自体を学習し、内部でシミュレーションするAIです。これにより、「この行動を取ったら、次に何が起こるか」といった未来を予測し、より現実に即した計画を立てることを目指します。

つまり、LLMがテキスト上の文脈を扱うのに対し、世界モデルは物理的な文脈や状況を理解しようとします。世界モデルは、より汎用的な知能の実現に向けた壮大なアプローチであり、その中でLLMが世界を理解・表現する要素の一つとして活用される関係にあります。

関連記事:「世界モデルとLLMの違いは?定義・ベース技術・活用シーンの比較や相互補完する関係性を徹底解説!」

LLMで何ができる?

LLMは、以下の主要な機能を提供しています。

| 機能 | 概要 |

|---|---|

| テキスト生成 | 物語や記事など、特定のテーマに基づいて文章を作成する能力。ニュース記事の自動生成などに利用 |

| 文章の理解と解釈 | 与えられた文章の意味を理解し、特定の質問に答えることや要約を提供する能力 |

| 機械翻訳 | 英語から日本語など、異なる言語間での文章の翻訳が可能 |

| 感情分析 | レビューなどの文章から、人々が商品やサービスに対してどのように感じているかを分析する能力 |

| マルチタスク学習 | 複数の異なるタスクを一つのモデルで学習する能力で、効率的な学習が可能 |

| 音声認識と生成 | 音声データをテキストに変換したり、逆にテキストから音声を生成 |

| 画像認識 | 一部の先進的なモデルは、画像を理解してそれに関する質問に答える能力も持っています。 |

| ベクトル検索 | テキストや画像などのデータを数値ベクトルに変換し、それらの類似性を計算することで関連情報を効率的に検索する技術。LLMの知識検索や文脈理解の向上に貢献します。 |

尚、GPTやGeminiのようにLLMとして知られているモデルも、言語処理以外にも画像認識やデータ分析等が可能なモデルとして発展しています。

AIエージェントを支えるのもLLM

LLM(大規模言語モデル)は、近年のAIエージェントの能力を飛躍的に向上させる上で、中心的な役割を担っています。AIエージェントが自律的にタスクを処理し、ユーザーと自然に対話するためには高度な言語理解能力、推論能力、そしてコミュニケーション能力が不可欠であり、LLMはこれらの「知能」の源泉となるからです。

具体的に、LLMはAIエージェントに対して以下のような形で貢献します。

まず、ユーザーの指示や意図の理解です。AIエージェントは、LLMが持つ優れた自然言語解釈能力を活用することで、人間からの曖昧な表現や複雑な要求内容を的確に把握します。

これにより、エージェントは「何をすべきか」を正確に認識できます。

次に、タスク遂行のための計画立案と推論です。LLMは学習データから得た広範な知識と文脈理解能力を基に、目標達成に向けたステップを論理的に組み立てたり、状況に応じた判断を下したりする能力を持ちます。

そして、自然な対話によるコミュニケーションです。タスクの進捗報告、必要な情報の問い合わせ、あるいはユーザーへの提案など、AIエージェントが人間と円滑に意思疎通を図るために、LLMの高度な文章生成能力が活用されます。

このように、LLMはAIエージェントの「頭脳」や「対話インターフェース」として機能し、その自律性と実用性を支える基盤技術と言えます。

LLMの仕組み

LLMの基本的な仕組みは「次に来る単語を予測すること」です。

与えられた文脈(例えば「今日は天気が」)に続く最も適切な単語(この場合「いい」など)を確率的に予測し、その積み重ねで文章を生成します。

この予測は、過去に学習した膨大なテキストデータをもとに、「次にどんな言葉がくる可能性が高いか」を判断することで行われます。

また、上記の仕組みに加え、人間のフィードバックによる強化学習(Reinforcement Learning from Human Feedback: RLHF)を取り入れています。

これは、人間が生成された文章に対して「良い」「悪い」と評価を与えることで、より人間にとって自然で有用な出力ができるようにモデルを調整していく手法です。

このプロセスにより、単なる確率的な予測だけでなく、文脈や意図を考慮した応答ができるようになります。

これらの仕組みを実現するLLMの内部では、以下のような技術で構成されています。

| LLMの仕組み | 概要 |

|---|---|

| Transformer | 文章内の単語間の関係を捉えるための特別な設計です。 単語同士がどう関連しているかを理解し、より人間に近い文章の生成を可能にします。 |

| ディープラーニング(深層学習) | 多くの層を持つニューラルネットワークを使用して、人間の脳のように情報を処理します。 多くの層があるほど、より複雑なパターンを学ぶことができます。 |

| 転移学習 | 一般的な知識を学ぶために大量のデータで訓練した後、特定のタスクに対して追加の学習を行う方法です。 これにより効率的な学習が可能になります。 |

LLMで使用されるアルゴリズム

以下は、LLMがどのように動作するかを支える主要なアルゴリズムと技術です。

| アルゴリズム | 概要 |

|---|---|

| 自己注意(Self-Attention)機構 | 単語が文中の他の単語とどのように関連しているかを理解するための技術。 例えば、「彼は」が誰を指しているのかを特定します。 |

| 位置エンコーディング(Positional Encoding) | 位置符号化とも呼ばれる。単語の順序(どの単語が先に来るかなど)をコンピューターに教えるための情報。 言語は順序に敏感なので、これは重要な概念です。 |

| マルチヘッドアテンション (Multi-head Attention) | 文章をいくつかの部分に分割してそれぞれに注意を払う機能。 異なる側面からの理解が深まります。 |

| 正則化技術 | モデルが訓練データだけでなく、未知のデータに対してもうまく機能するように調整する技術。 |

| 最適化アルゴリズム | 訓練プロセスを速く効率的に進めるための数学的な手法。モデルが迅速に学ぶのを助けます。 |

これらの機能と仕組みは、LLMを非常に強力で多岐にわたるタスクをこなせるツールにしており、その応用範囲は今後も広がりを見せるでしょう。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

AI MarketでのLLMに関連する相談事例

LLMに関連する、実際にAI Marketに相談のあった企業様の事例をご紹介します。(会社名が特定できる情報は伏せています)

1on1面談ログの感情分析で面談品質を可視化

大手企業向けに人事評価システムを提供するITベンダー企業様が、社員と上司が行う1on1面談の質を可視化する新機能を検討していました。従来は面談後に担当者が内容を読み取り、雰囲気や信頼関係を評価していましたが、主観に左右され標準化が難しいことが課題でした。

そこで同社は、面談音声をリアルタイム参加または録音アップロードで取得し、自動文字起こししたテキストから「良い雰囲気だったか」「信頼関係が築けているか」など感情・関係性の指標をAIで抽出しスコア化したいとAI Marketに相談されました。

評価軸自体もAIの洞察を踏まえて設計し、できるだけ早期にプロダクトへ組み込みたいという要望でした。

AI Marketのパートナー紹介

AI Marketは、お客様の課題をヒアリングした上で、相談内容に合わせ、以下のような技術を提供できるAI会社・サービスを紹介致しました。

- 音声認識・自動文字起こし技術

- LLM/自然言語処理によるセンチメント/感情分析

写真スタジオのLINE問い合わせ自動化のご相談

写真スタジオを運営する企業様から、LINE経由のお問い合わせ対応をAIで自動化したいというご相談です。同社のお問い合わせは以下の三段階に分かれています。

- 見学希望

- 予約済み

- 撮影後フォロー

特に上記1では「空いている日時を知りたい」という要望に対し、社内の予約カレンダーと連携して候補日時を提示する機能が必須でした。同2,3では既存のFAQをベースに案内を自動化し、必要に応じて有人対応へ円滑に切り替える設計を想定しているとのことです。

問い合わせ内容により相談フェーズを自動判別し、最短の導線で回答に到達させる対話設計と、応対品質を維持するためのナレッジ更新の仕組みまで含めた全体設計が求められました。

AI Marketのパートナー紹介

AI Marketは、お客様の課題をヒアリングした上で、相談内容に合わせ、以下のような技術を提供できるAI会社・サービスを紹介致しました。

- LINE Messaging API連携と対話設計

- 予約・カレンダーシステムのAPI連携(空き枠検索・候補提示・予約確定)

- FAQ自動応答基盤(RAG)とLLMによる自然な対話チャットシステムの構築

企業でのLLMの活用事例

LLMは人材育成から製品開発まで、幅広い分野で企業の効率と革新を向上させる重要なツールとなっています。企業はこれらの機能をうまく活用することで、市場での競争力を強化し、未来への成長を促進することが可能です。

LLMをビジネス活用するためのアイデアを以下で提案します。

カスタマーサポートの自動化と効率化

LLMの使用は、カスタマーサポート業務を革新的に変革しています。LLMを活用したチャットボットは、顧客からの質問に24時間365日対応することが可能で、人的リソースの削減と応答時間の短縮が実現しています。

また、多くのLLMは多言語対応が可能で、異なる言語を話す顧客へのサポートも効率的に提供できます。

特に、RAG(検索拡張生成:Retrieval-Augmented Generation)と呼ばれる技術を用いて、企業独自の内部データ(例えば製品に関するよくある質問と回答など)を元に回答を行えるようにすることで、企業ごとに適切なカスタマーサポートを実現することが可能になります。

さらに、エンタープライズサーチを併用することで、内部情報の有効活用とサポート業務の最適化が図れます。

オリジナルの回答を行うLLMを構築する手法として、ファインチューニングと呼ばれる手法もありますが、外部に保管したデータを参照しながら回答を生成するRAGのほうが一般的にコストメリットが優れているため、多くの企業がRAG技術を取り入れています。

そして、顧客の過去の対話履歴を活用したり、購買履歴データと組み合わせることで、より個人個人に合わせたサポートを提供することも可能です。

RAGについてはこちらで詳しく解説しています。

関連記事:「PKSHAグループと三井住友トラストHDがLLM(大規模言語モデル)を活用した次世代コンタクトセンターを構築開始」

コンテンツ生成とマーケティングの強化

マーケティング領域でも、LLMの力を借りることで多くの進展が見られます。LLMは、コンテンツライターと連携して、効率的に高品質なコンテンツを生成することができます。

そして、顧客の嗜好や行動を解析し、ターゲットに合った広告内容を自動生成することが可能です。ソーシャルメディア戦略では、ソーシャルメディア上のトレンドを分析し、最適なタイミングでの投稿やキャンペーンの設計が可能になります。

ただし、LLMの特性として、ハルシネーションと呼ばれる「もっともらしく嘘をつく(事実に基づかない情報を生成する)」という性質があるため、コンテンツを提供する前に専門家による人力チェックなどの工程が欠かせませんので注意が必要です。

データ分析とインサイト抽出の最適化

データドリブンな決定を支援するためにも、LLMの活用が進んでいます。さらに、Chain-of-Thoughtプロンプティングを取り入れることで、分析プロセスの透明性と精度が向上する可能性があります。大量のデータを処理し、意味のある可視化を提供することで、企業はより迅速な意思決定が可能になります。

データドリブン経営のメリットをこちらの記事で詳しく説明していますので併せてご覧ください。

ChatGPT等を通して活用可能なデータ分析機能では、データの中から重要なパターンやトレンドを自動的に特定し、ビジネス戦略の構築に活用することができます。さらに、過去のデータから未来のトレンドを予測し、供給チェーン管理や販売予測など、さまざまな業務で使用することができます。LLMは、それらの分析結果を適切な表現で言葉で出力することができます。

例えば、アンケート内容の分析など、多くのテキストデータからマーケットニーズや顧客の声を可視化することも可能です。

人材育成と教育プログラムのサポート

LLMは、人材育成と教育の分野にも影響を与えています。

LLMは学習者の能力や興味に応じたカスタマイズされた学習プランを生成できます。これにより、各個人のニーズに合わせた効率的な学習が可能になります。複雑なテーマや専門知識を要する分野でも、LLMは容易に理解できる教材やチュートリアルを生成できます。

さらに、ロールプレイングと組み合わせることで、学習者に対してリアルタイムでフィードバックを提供し、学習プロセスを強化します。

また、LLMを議事録用にカスタマイズすることで、研修やミーティングの内容を整理した議事録として出力することも可能になります。そして、多言語対応のLLMを使用することで、世界中のさまざまな言語を話す学習者にも、均等な教育の機会を提供できます。

また、LLMは、熟練者の経験や暗黙知を効果的に形式知化する能力を持っています。例えば、熟練者との対話をLLMが分析し、その知識を構造化された形で抽出することができます。これにより、長年の経験に基づく微妙なニュアンスや判断基準を、より明確な形で後継者に伝えることが可能になります。

関連記事:「技能伝承でのAI活用は?継承が進まない原因やAIを導入するメリット、活用事例を徹底解説!」

製品開発とイノベーションの推進

LLMは、製品開発とイノベーションの推進にも貢献しています。クリエイティブなプロセスを支援するために、LLMは新しいアイデアやコンセプトをスピーディーに提案できます。

LLMの解析と提案能力により、企業は新しいテクノロジーの探求や既存製品の改善をより迅速に行えるようになります。

例えば、SWOT分析やPEST分析など、戦略を検討するための分析をLLMが行うことなども可能です。

LLMはインターネット上の大量のデータから、市場トレンドや競合分析を迅速に実行し、製品開発の方向性を提供します。さらに、商用利用も可能なオープンソースのLLMOpsプラットフォームDifyを活用することで、プロトタイプ開発の効率向上が期待できます。

そして、技術的なドキュメントや設計ガイドラインを解釈し、エンジニアとデザイナーがプロトタイプを効率的に開発するのを助けることができるでしょう。

サプライチェーン管理とロジスティクスの改善

LLM(大規模言語モデル)をサプライチェーン管理とロジスティクスに適用することで、サプライヤーとの通信(例えばメール連絡など)を自動化し、情報共有の効率を上げ、協力関係を強化することもできます。

他にも、サプライチェーンに影響のある政治的な状況などを、ニュースから分析して、リスク管理を行うことなども可能になります。

法規制とコンプライアンスのモニタリング

法規制とコンプライアンスの分野でも、LLMは非常に役立つツールです。例えば、世界中の異なる司法管轄で変わる法規制の最新情報を効果的に追跡するのをサポートし、企業が常にコンプライアンスを維持できるようにします。

多国籍企業の場合、異なる国の法規制を同時に追跡し、必要に応じてその地域の言語で対応することが可能になるでしょう。

また、契約書や企業内ポリシーなどの文書を分析し、法規制や業界基準との整合性を自動でチェックします。LLMによって、法的リスクの評価を自動化し、企業がリスクを最小限に抑えるための対策を策定できるように支援されるでしょう。

関連記事:「弁護士ドットコムとPKSHA Technologyがリーガル領域に特化したLLM「リーガルブレイン」を共同開発」

マテリアルズインフォマティクスでも活用

GPTなどのLLMは、マテリアルズインフォマティクス(材料科学)の複雑な知識構造やデータフレームを自動的に学習し、レビュー論文からの情報抽出に利用されています。

材料科学におけるLLMの適用は、エンティティ認識(NER)、関係抽出(RE)などの自然言語処理(NLP)技術と組み合わせて使用されます。これにより、材料名、物性、合成パラメータなどの情報を科学文献から効果的に抽出し、材料の性能を評価する際に必要な関係を抽出することが可能になります。

特許検索

特許検索におけるAI検索技術は、LLM(大規模言語モデル)を中心に急速に進化しています。

ユーザーが自然言語で入力した検索クエリを理解し、適切な検索キーワードや特許分類に変換します。また、特許文書の意味や文脈を理解し、類似技術や関連特許を高精度で抽出するセマンティック検索が可能です。

LLMを使えば、異なる言語間での特許検索を可能にし、グローバルな特許調査を効率化可能です。

論文検索

研究者や技術者にとって、論文調査は研究活動の根幹をなす重要な業務です。しかし、従来のキーワード検索では、情報過多な現代において必要な論文を見つけるまでに膨大な時間を要し、関連性の低い論文に埋もれてしまうことも少なくありません。

そこで近年、急速に活用が進んでいるのが、LLM(大規模言語モデル)を搭載したAIによる論文検索です。LLMは、高度な自然言語処理能力によって、論文の内容を深く理解し、単なるキーワードの一致にとどまらず、文脈や意味、関連性を考慮した検索を実現します。

これにより、研究者は効率的に必要な情報にアクセスし、研究開発の加速化、新たな発見につなげることが期待されています。

文書管理

企業内には報告書やマニュアル、議事録など膨大な文書が存在しますが、それらが各所に散在し、必要な情報がすぐに見つからないという課題は深刻です。特に、熟練者の経験則やコツといった言語化されにくい「暗黙知」は、個人の退職などによって組織から失われるリスクを常に抱えています。

LLM(大規模言語モデル)を文書管理に活用することで、これらの課題解決に繋がります。LLMは、社内のあらゆるデータを横断的に検索するエンタープライズサーチを次世代のレベルへと進化させます。

従来のキーワード検索とは異なり、文章の文脈や意図を理解するため、「過去の類似トラブルの対処法は?」といった自然な問いかけで、関連文書を瞬時に探し出すことが可能です。

これにより、これまで個人の頭の中にしかなかった「暗黙知」を文書データから引き出し、誰もが活用できる形式知へと変換します。若手社員がベテランの知見に容易にアクセスできる環境は、円滑な技能伝承を促し、組織全体の技術力向上に貢献します。

LLMの企業導入に伴う課題とリスク

ビジネスでの活用において、業務改善の実現性を高めてくれるLLMですが、企業で本格的に導入する際にはいくつかの注意点とリスクが存在します。

以下に代表的な課題を挙げ、導入時に注意すべきポイントを解説します。

ハルシネーションのリスク

LLMは時に事実と異なる情報を、もっともらしい言い回しで生成する(ハルシネーション)という性質があります。これは、LLMの仕組みで解説した通り、LLMは次の単語を確率的に予測する、という仕組みで動いているためです。

例えば、社内問い合わせチャットボットにLLMを活用しているケースで、「制度改定前の古いルールを正しい情報として回答してしまう」などが起きると、大きな混乱やクレームにつながる恐れがあります。

このため、重要な情報提供に用いる際には、人間の確認プロセスや事実確認の仕組みを設けたり、正確な情報以外の回答を生成しない仕組みを構築するなどの対策が不可欠です。

機密情報漏えいの懸念

クラウド型のLLMサービスを利用する場合、入力した社内情報が外部に送信されるリスクも考慮する必要があります。

例えば、社内文書や顧客情報を誤って入力した結果、サービス提供側に情報が蓄積されてしまうと、情報漏えいやコンプライアンス違反につながる可能性があります。

特に機密性の高い業務では、軽量型LLM(=SLM)を活用したオンプレミスサーバやローカルでの利用や、プロンプト制御・マスキングといった情報保護の仕組みが求められます。

導入コストやROIへの不安

LLMの自前開発や高度なカスタマイズには莫大なコストがかかる可能性があり、初期投資に見合う効果が出せるかどうか、ROIに不安を抱く企業も少なくありません。

特に、業務改善やコスト削減効果がすぐに現れにくい用途では、「本当に導入すべきか」の判断が難しくなります。

LLMの導入に際しては、必ずLLM導入後のオペレーションを設計し、導入前と比較した検証を行うようにしましょう。

関連記事:「LLM導入のROI(投資対効果)測定方法は?注意点と最大化に有効な改善策を徹底解説!」

社内人材・体制の問題

LLMを活用するには、AIやデータの知識を持つ専門人材が必要ですが、そうしたAI人材が社内にいない、あるいは不足しているという課題は多くの企業が抱えています。

また、現場に導入しても「使い方がわからず活用されない」「一部の担当者しか使えない」といった宝の持ち腐れ状態になるケースも見られます。組織全体での受け入れ体制や、運用ルールの整備も行うようにしましょう。

LLM導入を成功させるためのポイント

上記のようなリスクを理解しつつ、LLM導入を成功に導くためには、以下のポイントを押さえることが重要です。

導入目的とKPIの明確化

まず、「何のためにLLMを導入するのか」「どんな成果を期待するのか」を具体的に定義することが不可欠です。

例えば、「カスタマーサポートの対応時間を30%短縮する」「社内ナレッジ検索の精度を向上させる」など、経営課題と結びついたKPIを設定することで、プロジェクトの成功確率が高まります。

小規模なPoC(実証実験)から開始

LLMに限らず、AIプロジェクト全体で共通していますが、LLMを含めたAIは、いきなり全社導入をするのではなく、まずは限定的な範囲でPoCを実施し、効果や課題を検証しましょう。

例えば、「社内FAQの一部をLLMチャットボット化して応答精度を測定する」といった方法が有効です。応答精度が求めている精度(業務で使えるレベル)として判断できるのであれば、対応範囲を広げていく、といった形です。

このような段階的なアプローチにより、リスクを抑えつつ、現場からのフィードバックを得て改善を進めることができます。

関連記事:「LLMの精度を評価・改善するテクニックとは?データ戦略のポイントも徹底解説!」

社内体制の整備と教育

LLMを導入する際は、運用体制の整備と人材教育が欠かせません。

利用者向けの操作トレーニングだけでなく、プロンプトの書き方や、情報管理に関するガイドライン(AIガバナンス)も整備する必要があります。

技術を「使える環境」に加えて、組織として「使いこなせる文化」を醸成することが導入成功の鍵となります。

LLMを評価する社内体制の構築手法はこちらの記事で詳しく説明していますので併せてご覧ください。

専門パートナーの活用

社内にAI人材がいなかったりして十分な知見がない場合は、LLM導入に精通した外部のAIパートナーと連携することも有効です。

技術支援だけでなく、ユースケース設計やPoCの実施、セキュリティ設計などをトータルでサポートしてもらうことで、導入リスクを低減しつつ、より高い成果を得ることが可能です。

特に、RAGを活用したプロジェクトでは、精度の問題が発生するケースが多いため、こういったケースでは、LLM活用に長けた企業とパートナーシップを組んで進めていくことをおすすめします。

例えば、以下のXでの投稿のように、LLMでのRAG活用については、常に議論されている話題です。

「RAGを作ってみたけど精度があまり出ない」

その原因は非構造化情報の扱いの難しさにあります。

そんな課題を解決する技術として、本日、 NTT Com から生成AI向けの情報の構造化技術である「rokadoc」のパブリックベータをリリースしました!ぜひこちらもお試しください!(プレスのURLはリプに) pic.twitter.com/wUfNvpItbI

— iwashi / Yoshimasa Iwase (@iwashi86) February 19, 2025

リランキングモデルによってRAGの日本語検索精度が上がる、というブログを書きました。リランキングモデルの解説および評価結果を載せてます。https://t.co/eBwun2Vg09

「リランキングモデル」という言葉は聞いたことあるけどよく分かってない、効果があるか分からない、という方はぜひ! pic.twitter.com/ejCFHtL3MZ

— Omiita (@omiita_atiimo) March 3, 2025

RAGシステムの精度改善フローを描いてみた。

生成AIを企業で本格的にシステム導入する場合、継続的に精度を測定・改善する運用設計が重要。

これからのITエンジニアは簡単なRAGを実装するだけでなく、生成AIシステムの運用保守まで考慮したアーキテクチャの設計力が求められる。 pic.twitter.com/eF592lzyZe

— ヤマゾー@AIエンジニア (@yamazombie1) January 30, 2025

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

代表的なLLM

商用利用可能な商品を含めて、主要LLMには以下があります。基本的に、一つのシステムで一つのLLMが実装されていますが、LangChainの活用により複数のLLMを組み合わせて順番に使用することも可能です。

こちらでLangChainの機能、活用事例を詳しく説明しています。

OpenAI GPT-3系

GPT-3は、1750億のパラメータを持つ強力なモデルで、20種類以上の言語を理解し生成できます。文章生成、翻訳、要約、質問応答など、多岐にわたるタスクに対応しています。

OpenAIのGPTシリーズは多言語対応の強力なモデルで、大規模な訓練データと洗練されたアーキテクチャによって、さまざまな言語の生成と理解が可能です。ChatGPTに搭載されていることで実社会でもムーブメントを巻き起こして、生成AIの代名詞となっています。

OpenAIのGPTシリーズは、多言語対応の強力なモデルとして進化を続けています。

OpenAI GPT-4系

GPT-4は、GPT-3をさらに強化したモデルです。パラメータ数は非公開ですが、GPT-3を大幅に上回ると推測されています。GPT-4は、テキストだけでなく画像入力も受け付けるマルチモーダルモデルとなりました。

2023年11月に発表されたGPT-4 Turboは、GPT-4の改良版です。学習データが2023年4月まで更新され、コンテキストウィンドウがGPT-4の4倍の12万8000トークンに拡大しました。

また、パフォーマンスの最適化により、GPT-4と比較して入力トークンの価格は3分の1に、出力トークンの価格は半額になりました。

2024年5月に発表されたGPT-4o(”o”は”omni”の略)の主な特徴は以下の通りです。

- マルチモーダル機能:テキスト、音声、画像、動画の入力を受け付け、テキスト、音声、画像の出力が可能です。

- 効率性の向上:GPT-4 Turboと比較して2倍高速で、APIでの利用価格が安くなっています。

- 感情表現の向上:音声出力において、感情を込めた話し方や歌唱が可能になりました。

GPT-4o miniは、OpenAIが2024年7月18日に発表したGPT-4oの小型版モデルです。以下にGPT-4o miniの主な特徴と機能をまとめます。

- コスト効率:GPT-3.5 Turboと比較して60%安価で、入力トークンあたり15セント、出力トークンあたり60セントです。

- 高速処理:GPT-4oの2倍の速度で動作し、113トークン/秒の出力速度を持ちます。

- 大規模コンテキスト:128,000トークンのコンテキストウィンドウと、16,384トークンの最大出力トークン数を持ちます。

GPT-4.5は、OpenAIが2025年2月27日に発表したLLMです。

教師なし学習のスケーリングを進化させ、直感的で自然な対話、創造性の高い出力、感情知能(EQ)の強化を実現しています。

OpenAI oシリーズ

OpenAIのoシリーズは従来のGPTシリーズとは異なるアプローチを採用しており、思考時間を設けることによって、より複雑な課題を解決する能力を持つ推論モデルです。数学の問題やプログラミングなど思考力を必要とする問題をGPTよりも効果的に解決することができます。

2024年9月、o1-previewは従来のGPTシリーズとは一線を画すoシリーズの試験的なモデルとして発表されました。o1-previewと同時に軽量版のo1 miniも発表されました。

o1はo1-previewの正式版として2024年12月にリリースされました。o1-previewをベースに改良が加えられ、推論時間が大幅に短くなっているだけでなく、特にプログラミング分野で大幅に性能が向上しています。

また、o1と同時にo1の上位モデルとして、o1 proも発表されました。o1 proはo1よりも長い推論時間で難しい問題に対してより正確な回答を生成する点が特徴です。

さらに、o1が正式にリリースされてから約2週間後、o1の次世代モデルとしてOpenAI o3が発表されています。

GPT-4を活用して自身の誤りを発見する新たなAI評価モデルCriticGPTや新しいAI検索機能SearchGPTなど、LLMの世界でOpenAIは先頭を突き走っています。

OpenAI GPT-5

2025年8月に発表されたOpenAIの「GPT-5」は、知能・速度・信頼性が飛躍的に向上しました。最大の進化は、これまで分かれていた高速応答のGPT-4o系と、高度な推論のo系(o3など)が完全に一つのシステムに統合された点です。

ユーザーは意識することなく、システムが質問の複雑さに応じて最適な思考プロセスを自動で選択します。これにより、専門家レベルの深い思考が、誰でもシームレスに利用できるようになりました。

ハルシネーション(事実誤認)も大幅に削減され、信頼できる開発パートナーや相談相手として機能します。無料ユーザーにも提供され、AIの民主化を大きく前進させるモデルです。

Gemini

Geminiとは、Googleが開発した生成AIモデルです。LLM(大規模言語モデル)ですが、そもそもの設計がマルチモーダルであるため、テキスト、画像、オーディオ、ビデオ、コードなど様々な種類の情報を扱うことができ、人間の学習や相互作用に近いMLLM(マルチモーダルLLM)です。

ディープラーニングを搭載したAIで囲碁の世界チャンピオンに勝ったことで知られる囲碁プログラムAlpha Goを開発したDeep Mind社が関わっており、GeminiにはAlpha Goの技術が備わっていることが発表されています。

2024年2月に発表されたGemini 1.5 Proは、主要な指標の多くでGPT-4を上回る性能を示しています。特に、100万トークンのコンテキストウィンドウを持ち、最大1,500ページまでの大規模なデータセットやドキュメントを効率的に処理できます。

2024年12月に発表されたGemini 2.0 Flashは、従来のGemini 1.5 Proの2倍の処理速度を実現しつつ、推論能力が強化されているため、複数のステップを要する質問や高度な数式、コーディングなどにも対応可能です。さらには、テキスト、画像、音声などのマルチモーダル入力に対応し、複雑なタスクを自律的に実行できます。

またGemini 2.0 Flashが発表された約1週間後に、より強力な推論機能を備えたGemini 2.0 Flash Thinkingも試験運用版モデルとしてGoogle AI Studioで公開されました。

Geminiは、Google検索、Google広告、Chrome、開発支援を目的としたDuet AIなど、Googleの主要な製品・サービスに順次導入されています。また、Vertex AI上でGemini APIとして利用可能になり、開発者がGeminiを利用したアプリケーション開発を行えるようになりました。

Googleが提供する生成AIモデルのプロトタイピングと実験に特化しているGoogle AI Studioで、Gemini 1.5 Pro、Gemini 1.5 Flash、 Gemini 1.5 Flash-8B、Gemini 2.0 Flash、Gemini 2.0 Flash Thinkingなどを利用可能です。

さらに、Project Astra(現Google Live)ではGeminiモデルをベースにマルチモーダル情報を素早く処理し、コンテキストを理解して質問に応答できるAIエージェントの開発が進められています。

Geminiとは?どんな特徴があるか?こちらの記事で詳しく説明していますので併せてご覧ください。

Geminiの有料プランであるGemini Advanced(現在はGoogle AI Proプランに統合)では、拡張された機能を利用することが可能です。

また、音声による対話を実現するモバイルアプリ用の機能としてGemini Liveも提供されています。

Meta Llamaシリーズ

Llama 2(ラマ2)はMetaとMicrosoftが共同で開発した次世代のLLM(大規模言語モデル)で、オープンソースとして研究や商用利用に無料で提供されています。その名前は「Large Language Model Meta AI」の略から来ています。

以下のように順次モデルが発表されています。

- Llama 1:2023年2月に初めて公開

- Llama 2:2023年7月に発表され、商用利用が可能に

- Llama 3:2024年4月に発表され、8Bと70Bのモデルが公開

- Llama 3.1:2024年7月24日に発表され、8B、70B、405Bの3サイズのモデルが公開

- Llama 3.2:マルチモーダル機能を持つ大型モデルとエッジデバイスや携帯端末での利用を可能にする1Bと3Bの軽量モデルを含む

- Llama 3.3:2024年12月7日に発表され、70Bパラメータの高性能テキスト専用モデルとして公開

- Llama 4:2025年4月6日に発表された、マルチモーダル、MoE採用モデルとして公開

Llama 2以降のモデルは商用利用が可能になり、これにより以下をはじめとする多くの派生モデルが開発されています。

Llama 2はGoogleやOpenAIのLLMの代替として機能し、大量のテキストデータを学習することでさまざまな自然言語処理タスクをこなすことができます。

Llama 2は、3つの異なるモデルを提供しており、それぞれ70億、130億、700億のパラメーターでトレーニングされています。さらに、会話に特化した「Llama 2 Chat」というバージョンもリリースされています。

そして2024年4月19日には、Llama 3、2024年9月にはマルチモーダル機能を持つ「Llama3.2」も発表されました。

また、2024年12月に軽量にもかかわらず高い性能を誇るLlama 3.3も発表されました。なお、Llama3.3はテキストプロンプトのみでマルチモーダル機能は持ちません。

Llama 2、Llama 3ともにオープンソースなのでローカルLLMなど別企業のカスタムLLMのベースとされて使われることも多いLLMです。

Llamaの詳細な特徴、使い方をこちらの記事で詳しく説明していますので併せてご覧ください。

Anthropic Claudeシリーズ

Anthropic Claudeシリーズは、OpenAIの元研究幹部らが「Helpful, Honest, and Harmless(有用、誠実、無害)」なAIを目指して設立したAnthropic社の基盤モデルです。

その歩みは、単なるチャットボットから、業務を代行する「パートナー」への進化そのものです。

- Claude 1・2シリーズ:業界最大級のコンテキストウィンドウ(入力容量)を武器に、長文要約や解析分野をリード。

- Claude 3シリーズ(2024年):マルチモーダル化と推論能力の強化。「3.5 Sonnet」での「Computer Use(PC操作)」実装がエージェント化の幕開けとなった。

- Claude 3.7 Sonnet(2025年2月):迅速な応答が可能な「標準モード」と、段階的で詳細な推論を実施する「拡張思考モード」の2つの動作モードを搭載

- Claude 4シリーズ(2025年5月):推論速度と精度が飛躍的に向上。複雑な長期的タスクの自律実行能力において、新たな業界標準を確立

- Claude Opus 4.1:2025年8月に発表されたコーディング能力、リサーチ能力が大きく進歩したモデル

2025年3月からは3.7 sonnet上で利用可能なWeb検索機能が搭載された他、2025年4月には、Google Workspaceとの連携機能の提供も開始されました。

単なるテキスト生成ツールから、自律的にタスクをこなす「エージェント」へと変貌を遂げつつあります。自然な日本語処理に加え、Claude 4の高度な推論能力をブラウザ操作に直結させるClaude for Chromeや、生成したコードやプレビューを即時展開する「Artifacts」機能など、開発者体験(DX)を重視した設計も大きな支持を集める理由です。

Mistral AI Mistralシリーズ・Mixtralシリーズ

Mistralシリーズ・Mixtralシリーズは、フランスのAIスタートアップMistral AIが開発したLLM(大規模言語モデル)です。高性能かつ効率的な自然言語処理能力を持ち、研究や商用利用に提供されています。

Mistral AIのモデルは、テキスト生成、コード補完、多言語対応など幅広いタスクをこなすことができ、ChatGPTやGPT-4などの競合モデルに匹敵する性能を示しています。特に、Pixtral Largeは画像認識能力も備えており、次世代のAIモデルとして注目を集めています。

Mistralシリーズは、主に以下のモデルで構成されています。

- Mistral 8B:8Bパラメータの高密度トランスフォーマーモデルで、小規模ながら高い能力を発揮します。

- Mistral Small:32,000トークンのコンテキストウィンドウを持ち、シンプルなタスクに最適化されています。

- Mistral Large:複雑な推論や専門的なタスクに適した高性能モデルです。

- Mistral Large 2:多言語対応や会話能力が強化された最新バージョンです。

- Pixtral Large:1,240億パラメータを持つマルチモーダルAIモデルで、テキストと画像の両方を処理できます。

これらのモデルは2023年から2024年にかけて順次リリースされ、一部はオープンソースとして提供されています。また、APIを通じたライセンス契約での利用も可能です。

関連記事:「Mistral AIの魅力や提供モデル、特徴を詳しく解説し、その活用方法についてご紹介」

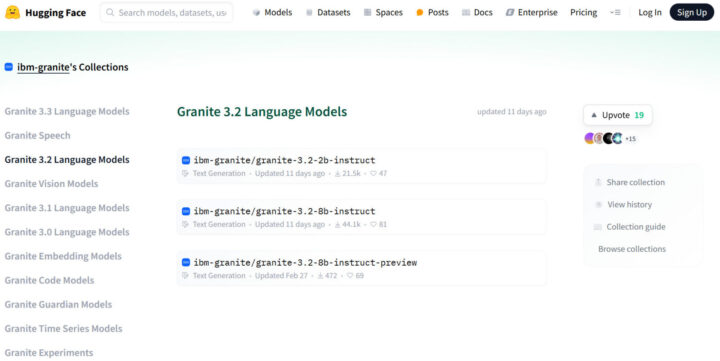

IBM Graniteシリーズ

GraniteはIBMが開発した企業向けのオープンソースAIモデル群で、自然言語処理だけでなく、コード生成、画像理解、時系列予測、地理空間解析など多様な用途に対応しています。

企業が求める安全性と透明性を重視しつつ、計算リソースを抑えながら高性能なAI活用を可能にする設計となっています。

2025年5月時点の最新版であるGranite 3.3は、128Kの長文コンテキストや強化された推論機能、コード補完に対応しており、日本語を含む多言語処理の精度も向上しています。

Graniteコードモデルは116のプログラミング言語に対応し、文書や画像の理解に対応したビジョンモデル、AIの出力リスクを検出するガーディアン、安全な検索を支える埋め込みモデルなど、多様なモデルがラインナップされています。

これらのモデルは多くがApache 2.0ライセンスの下で無償提供されており、商用利用やカスタマイズも自由に行えます。

関連記事:「IBMの生成AIモデルGraniteとは?できること・特徴・料金プラン・他モデルとの比較まで徹底解説!」

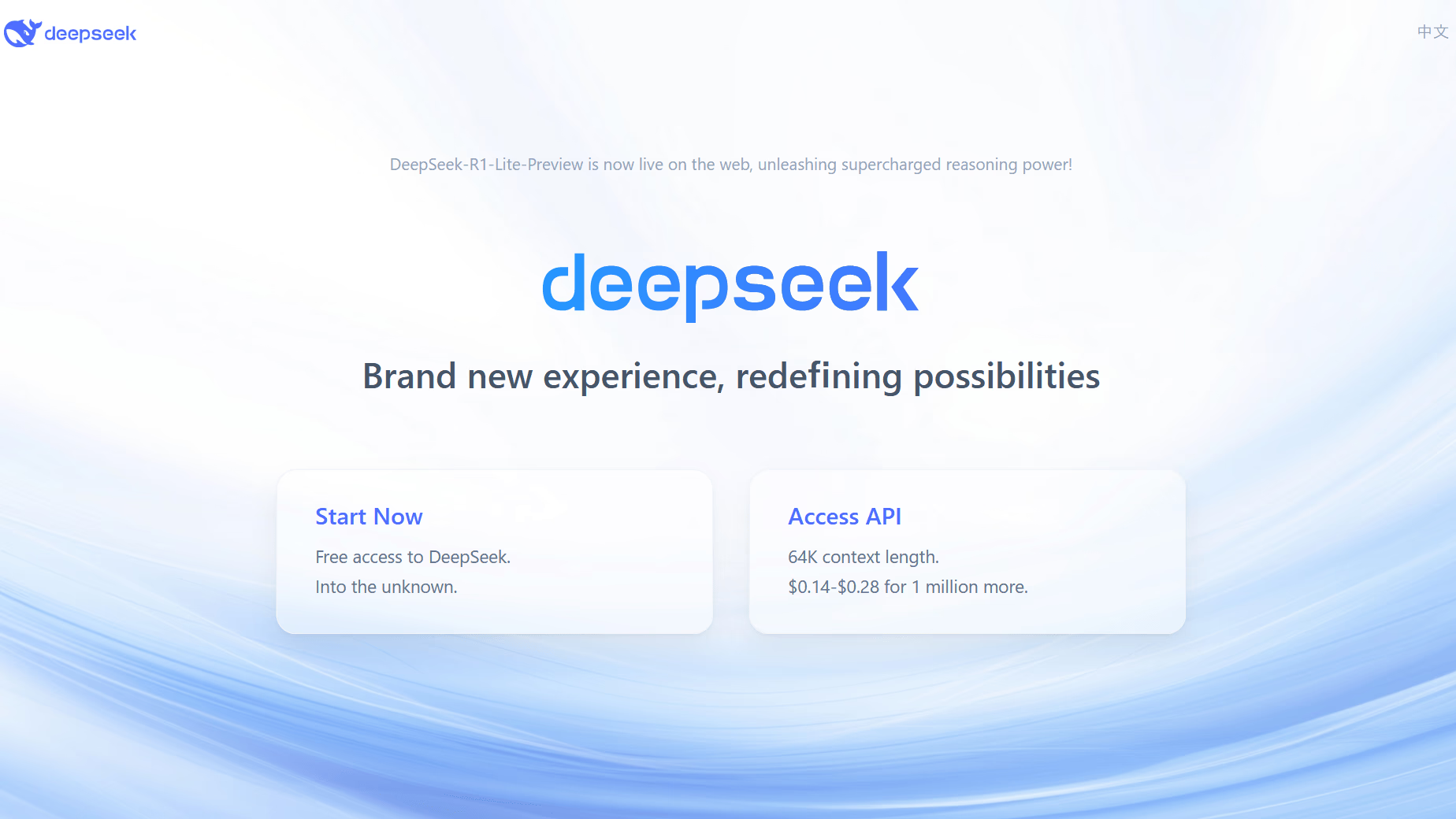

DeepSeek-R1

DeepSeek-R1は、中国のAI企業DeepSeekが開発したLLMです。Mixture of Experts (MoE) アーキテクチャで671億パラメータを持ち、最大128,000トークンのコンテキストを処理可能です。

強化学習 (RL) を用いて推論能力を向上させ、教師あり微調整 (SFT)RLSFTで言語一貫性を高めています。

OpenAI-o1と比較して大幅に安価で、API利用料金が低価格ですが、数学やプログラミングなどのタスクでOpenAI-o1と同等の性能を収めています。

MITライセンスで提供されており、オープンソースで商用利用も可能です。

関連記事:「DeepSeek-R1とは?OpenAI o1に迫る高性能モデルの料金・アーキテクチャの特徴、使い方、注意点を徹底解説」

Cohere Commandシリーズ

カナダのAI企業Cohereが開発する「Commandシリーズ」は、実社会のビジネス課題解決に特化したLLMです。

Command R+は、企業のデータベースと連携して正確な回答を生成するRAG(検索拡張生成)技術に優れ、ハルシネーション(AIがもっともらしい嘘をつく現象)を抑制します。日本語を含む多言語対応と、複数の業務を自動化するツール連携機能も強みです。

Command Aは、このR+の強力な言語能力を維持しつつ、より少ない計算資源で動作する効率性を追求したモデルです。

そして2025年7月に発表されたCommand A Visionは、Command Aを基盤に画像認識能力を統合したマルチモーダルAIです。これにより、テキスト情報だけでなく、請求書や図面といった視覚的なドキュメントも正確に理解し、データ化することが可能になりました。

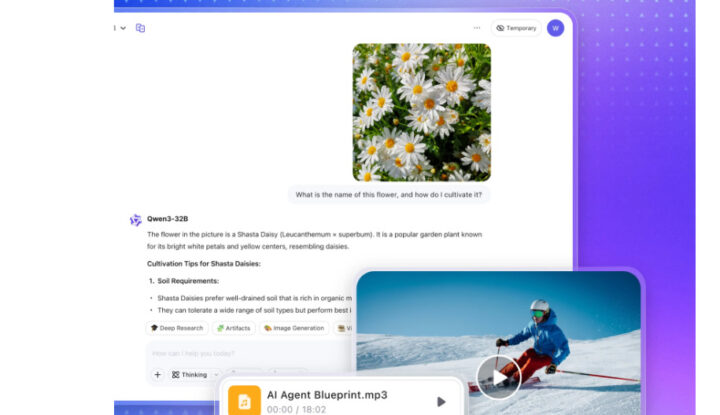

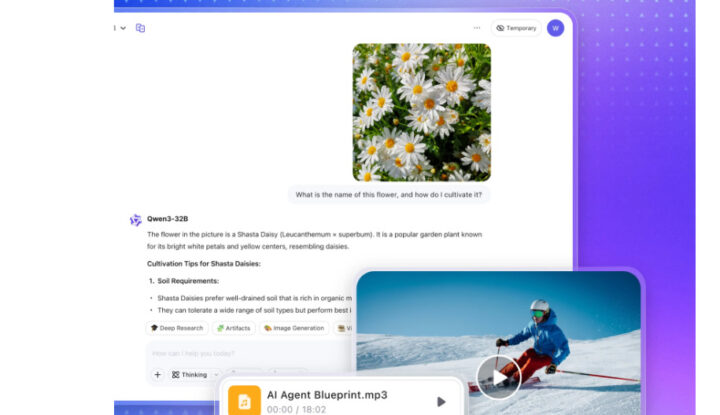

Qwen

Qwen(クエン)は、Alibaba Cloudが開発した最先端の大規模言語モデル(LLM)ファミリーです。単一のモデルではなく、汎用的な対話モデルからコーディングや視覚理解に特化したモデルまで、多様なサイズと用途のモデル群で構成されています。

その性能は各種ベン-チマークで実証されており、GPT-4oやGeminiといった世界最高峰のLLMに匹敵、あるいは一部では凌駕します。テキストだけでなく画像も深く理解する高度なマルチモーダル能力や、長大な文書を一度に処理できる長文脈対応も大きな特徴です。

さらに、API経由での利用に加え、モデルの多くがオープンソースとして公開されている点がQwenの大きな魅力です。これにより、世界中の開発者がモデルを自由に研究できるほか、企業は自社のデータでファインチューニングを行い、独自の特化型AIをオンプレミス環境で安全に構築することも可能です。

| リリース時期 | モデル名 | 主な特徴 |

|---|---|---|

| 2023年4月 | Tongyi Qianwen (通義千問) | Alibaba Cloudによる初期ベータ版 |

| 2023年8月 | Qwen-7B / Qwen-VL | 初のオープンソースモデル(7B)が登場 画像と言語を理解するマルチモーダルモデルQwen-VLも公開される。 |

| 2024年2月 | Qwen1.5 | 性能を大幅に向上させた主力モデルシリーズ 複数のパラメータサイズ (0.5B〜72B) がオープンソース化 |

| 2024年6月 | Qwen2 | 特に多言語対応能力とコーディング性能が大幅に強化された。 |

| 2025年4月 | Qwen3 | ハイブリッド推論(思考モード)を搭載し、複雑なタスクの精度を飛躍的に向上 幅広いモデルサイズ(0.6B〜235BのMoEモデルまで)が提供され、性能と効率を両立 |

| 2025年9月 | Qwen3-Omni | テキスト、画像、音声、動画を統合的に処理できるオムニモーダル(万能型)モデル 単一モデルで多様な入出力を扱うことができ、より高度なAIエージェントの構築を可能にする |

Google Gemmaファミリー

GoogleのGemmaファミリーは、Geminiの技術を基盤とした、高性能かつ軽量なオープンモデル群です。開発者が幅広い用途で活用できるよう、様々なサイズや特性を持つモデルが用意されています。

Gemma 2やGemma 3も、今後の進化の一環として開発が期待されています。

その中でも特徴的なのが、特定の課題解決に特化したモデルです。例えば「DataGemma」は、AIの回答が事実と異なる情報を生成する「ハルシネーション」という課題に対応します。

信頼性の高い公開統計データベースと連携し、RAG(検索拡張生成)などの技術を用いることで特に数値データに基づく正確な回答生成を得意とします。

一方、「VaultGemma」はセキュリティとプライバシー保護を最優先事項として設計されました。「差分プライバシー」という技術を学習の全工程で適用し、モデルが個人情報などの機密情報を記憶してしまうリスクを数学的に防止します。

これにより、金融や医療といった機密データを扱う領域でも安全にAIを活用する道を開きます。このようにGemmaファミリーは、汎用性に加え、特定のビジネス課題に応える多様な選択肢を提供しているのが大きな特徴です。

Google LaMDA

Google LaMDA(Language Model for Dialogue Applications)は1370億のパラメータを持ち、特に会話型アプリケーションに焦点を当てた言語モデルです。2017年にオープンソース化されています。

LaMDAは、自然な会話の流れを模倣する能力を持ち、人と人との対話のように感じる応答を生成できます。現在はGoogleの対話型AI「Bard」に採用されています。

Google PaLM2

PaLM2は、多言語対応、推論、コーディングの性能を向上させた最先端のLLM(大規模言語モデル)で、前世代のPaLMの研究を発展させています。100以上の言語テキストを学習し、ニュアンスを含む表現の理解、翻訳、生成が可能で、効率的に高速な動作を実現しています。

一部報道によれば、PaLM2のパラメータ数は3400億とされており、従来のモデルよりも高性能であると言われています。

PaLM2の特徴、すごいところをこちらの記事で詳しく説明していますので併せてご覧ください。

Google BERT

Google BERT(Bidirectional Encoder Representations from Transformers)は、Googleが2018年10月に発表した自然言語処理(NLP)モデルです。日本語では「Transformerによる双方向のエンコード表現」と訳されています。

BERTは、翻訳、文書分類、質問応答などのNLPタスクにおいて2018年当時の最高スコアを叩き出し、大きな注目を集めました。強みはその汎用性で、WikipediaやBooksCorpusなどの大量の文章データを事前学習し、様々なタスクに応用できる点です。

Googleは、検索システムにBERTを導入し、ユーザーへの理解を深めており、その実績は「GLUE」という指標で最高スコアを収めています。

関連記事:「BERTとは?Googleの自然言語処理モデルが重要な理由・アーキテクチャ・メリット・活用例を徹底解説!」

Alpaca 7B

「Alpaca」とはスタンフォード大学が開発・公開した特別な言語モデルで、MetaのLLM(大規模言語モデル)「Llama」の7B(70億)パラメータモデルを基盤としています。このLlamaモデルは、他の一般的なLLM(大規模言語モデル)と比べてパラメータ数が少なく、その効率性から世界中の研究者が利用しています。

Alpacaは学術目的にのみ利用が許可されており、商用利用は禁止されています。

Alpacaの開発においては、特に「命令追従性」に焦点が当てられました。これにより、より小さな環境でGPT-3.5と似た動作を簡単かつ安価に再現できる能力が提供されています。

Cotomi

NECは、日本語に特化した生成AIであるCotomiを開発し、それに関連したサービスをトータルで提供すると発表しました。Cotomiは、130億パラメーターを持ち、世界最大級の日本語に特化したモデルとされています。

Cotomiの最大の特長は、性能で海外製のLLMを凌駕しつつ、非常にコンパクトで超軽量化されている点です。パラメータサイズは海外製と比較して13分の1に抑えられており、標準的なサーバーでも動作可能な設計になっています。これにより、アプリのスムーズな動作や電力消費、サーバーコストの削減が可能になります。

Cotomiの性能は、日本語言語理解の評価システム「JGLUE」で確認され、知識量で81.1%、文書理解で84.3%のスコアを記録しました。これは「世界トップレベルの性能」と評され、従来、日本語のLLMがほとんど存在しなかった中で、あらゆる業界の業務に適応可能なモデルとなると期待されています。

関連記事:「日本語特化LLMおすすめ徹底解説!なぜChatGPTだけでは不十分?現状と今後の期待」

Grok

Grokは、イーロン・マスク率いるxAI社が開発した対話型生成AIモデルで、X(旧Twitter)上の最新情報を学習元としている点が特徴です。リアルタイムで情報を収集・分析することで、ニュースや市場動向に迅速に対応し、ユーザーへユーモアを交えた回答を提供します。

さらに、Grokは自身が記事の生成と検証を行うオンライン百科事典「Grokipedia」のエンジンとしても機能しており、AIによる新たな知識基盤の構築も目指しています。

Grokには、Grok-2、Grok-2 mini、Grok 3など複数のモデルが存在しており、Grok-2はGPT-4 Turboを凌駕する性能が評価されています。330億パラメータながら、Mixture-of-Expertsアーキテクチャを採用することで、タスクに最適化された効率的な処理が可能となっています。

また、Grok 3はDeepSearch機能により、詳細な情報収集と論理的推論を実現しています。

2025年7月には、Grok 4が登場しています。

さらに、GrokはXプラットフォームと統合され、Xアカウントを持つユーザーなら誰でも無料プランを利用できるほか、有料のプレミアムプランも用意されています。

BitNet b1.58

BitNet b1.58は、Microsoft Research AsiaとChinese Academy of Sciencesの共同研究チームによって開発された軽量LLMモデルです。2024年2月27日に論文『The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits』で発表されました。

主な特徴を以下に挙げます。

- 量子化技術:各パラメータを-1、0、+1の3値で表現する1.58ビット量子化技術を採用しています。

- メモリ使用量:70Bパラメータモデルで、LLaMAの7.16分の1

- 推論速度:LLaMAの4.1倍

- エネルギー効率:行列乗算のエネルギー消費がLLaMAの71.4分の1

- 性能:従来の32ビットや16ビットモデルと同等の性能を発揮しつつ、大幅な効率化を実現しています。

- スケーラビリティ:モデルサイズが大きくなるほど、効率性が向上する傾向があります。

BitNet b1.58は、LLM(大規模言語モデル)の軽量化と効率化に大きな可能性を示しており、AIの社会実装を加速させる潜在力を持っています。ただし、現時点では研究段階にあり、実用化にはさらなる開発と検証が必要です。

この技術の進展により、モバイルデバイスでのAI実装やクラウドインフラの効率化など、様々な分野でのイノベーションが期待されています。

関連記事:「1ビットLLMの衝撃!BitNet b1.58の概要と活用方法について徹底解説!」

OpenELM

Apple OpenELM(Open-source Efficient Language Model)は、2024年4月にAppleが公開したエッジデバイス向けオープンソースLLMです。iPhoneやiPad上でローカル実行可能な設計が特徴で、自然言語処理タスクを端末内で効率的に処理します。

「270M・450M・1.1B・3B」の小規模なパラメータ構成のシリーズが提供されています。しかし、性能は十分で、実際に行われたベンチマークでは同規模のモデルよりも高性能な推論結果を示しています。

関連記事:「OpenELMとは?Appleの狙い・商用利用・始め方・メリット・注意点を徹底紹介!」

Omnilingual ASR

Metaが2025年に公開した「Omnilingual ASR」は、LLMアーキテクチャを音声認識の中核に据えたモデルです。最大の特徴は、最大70億(7B)パラメータのLLMをデコーダとして採用し、音声認識を単なる音素変換ではなく「文脈に基づく言語生成タスク」として処理する点にあります。

これにより、従来の技術では学習データ不足で実用化が困難だったロングテール言語においても、LLMの持つ強力な言語知識で補完し、高精度な認識を実現しました。対応言語数は驚異の1,600以上に及びます。

Apache 2.0ライセンスで公開されているため、企業は商用利用や自社データでのファインチューニングが容易であり、多言語ビジネス展開においてOpenAIのWhisperと並ぶ重要な選択肢となっています。

LLMは自社開発よりもカスタマイズの方がコスパがよい?

LLMの導入に際しては、様々なコストが発生します。具体的なビジネスニーズや目的に応じた慎重な計画と評価が必要です。

なお、LLMを活用するという観点で、LLMを自社開発する、という考え方を持つことはあまり適切ではありません。もちろん不可能ではありませんが、LLMを自社開発するには、高性能なGPUの調達を始め、膨大な費用と時間が必要となります。

そのため、Microsoftから大型の資金調達を実施しているOpenAIや、Google、Metaといった巨額の研究開発費用を注ぐことのできる会社が独自LLMを提供していることが多いです。(日本でも研究開発費を投資し、自社LLMを提供している会社もあります)

そのため、LLMを自社開発するのではなく、提供されている基盤モデルとなるLLMを適切にカスタマイズして活用する、という考え方に立ったほうが良いということを前置きします。

企業のサイズ、業界、戦略によって最適な導入戦略は変わるため、専門的なコンサルテーションも検討する価値があります。

LLMのカスタマイズに必要なハードウェアとソフトウェアコスト

| コスト種類 | 概要 |

|---|---|

| ハードウェアコスト | LLMを社内でホストする場合、必要な計算能力に応じたサーバーやGPUのコスト クラウドサービスを使用する場合は、使用した計算リソースに応じて費用 |

| ソフトウェアライセンス | 既存のLLM製品を使用する場合はライセンス(API)料(例:GPT-4oであれば100万トークン当たり出力10ドル、等) オープンソースのモデルをカスタマイズする場合はライセンス料は発生しないが、カスタマイズに関連する開発コスト |

| 保守とサポート | ソフトウェアの保守、アップデート、技術サポートにかかる費用 |

開発や運用の人件費

| 人件費の種類 | 概要 |

|---|---|

| 開発人件費 | モデルのカスタマイズや統合で専門的な技術スキルを持つ開発者の人件費 RAGなどを用いてオリジナル回答を生成するためのデータベースの構築にかかる人件費 |

| 運用人件費 | LLMの継続的な運用、監視、最適化を担当するスタッフの人件費 |

| トレーニング費用 | 既存のスタッフがLLMの操作や管理に不慣れな場合のトレーニング費用 |

関連記事:「AI人材とはどういう人材か、AI人材の種類や必要なスキル、今後の需要などを紹介」

総合的な費用対効果分析

LLM導入の費用対効果を総合的に評価するには、以下のLLMOps指標を活用することが効果的です。LLMOpsは、LLMの開発から運用までのライフサイクル全体を管理するための専門的な実践手法です。

- 導入による業務効率の向上

- 人的リソースの節約

- 新しいサービスや製品の提供による収益増加

- コンプライアンスの強化やエラーの減少によるリスクの緩和

- 今後の成長や拡張に対する準備としての投資

- プロンプト最適化による応答品質向上率

- 自動化された業務プロセスの割合

- 顧客満足度の変化

これらの指標を定期的に測定し、LLM導入前後で比較することで、投資対効果を定量的に評価することができます。LLMOpsの枠組みを活用することで、単なるコスト削減だけでなく、ビジネス価値の創出という観点からLLM導入の効果を最大化することが可能になります。

関連記事:「LLMOpsとは?MLOpsとの違い・導入メリット・最適ツール、活用のコツを徹底解説」

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

LLMカスタマイズの手順

以下、LLMを企業でカスタマイズして活用する手順とコスト分析について詳細に分析します。

- 基盤モデルの選択

- RAGの実装

- ファインチューニング

- LangChainを用いた統合

- LLM-as-a-Judgeによる評価

基盤モデルの選択

基盤モデルの選択は、LLMカスタマイズの最初のステップです。以下の点を考慮して選択します。

- モデルの規模(パラメータ数)

- 事前学習データの範囲と質

- 推論速度とリソース要件

- ライセンスと使用条件

- 特定のタスクや言語に対する適性

関連記事:「オープンソースLLM厳選!特徴・活用メリット・モデルの比較ポイントも徹底解説」

RAGの実装

RAG(Retrieval-Augmented Generation)は、LLMの回答生成能力を向上させるための手法です。RAG技術を用いて既存の知識ベースやデータベースから関連情報を取得し、LLMの入力に組み込むことで、より正確で具体的な回答を生成することができます。

RAGの実装には、効率的な検索アルゴリズムと適切なデータ管理が必要です。

ファインチューニング

ファインチューニングは、既存のLLMを特定のタスクや領域に適応させるプロセスです。企業固有のデータセットを使用してモデルを再訓練することで、特定の業界や用途に特化した性能を引き出すことができます。

ただし、大量の高品質なデータと計算リソースが必要となります。

関連記事:「LLMで学習データはなぜ重要?必要なデータ種類、収集方法、前処理・アノテーションの手法まで徹底解説!」

LangChainを用いた統合

LangChainは、LLMを他のシステムやツールと統合するためのフレームワークです。これを使用することで、LLMを既存のビジネスプロセスやアプリケーションにシームレスに組み込むことができます。

LangChainは、複雑なワークフローの構築や外部データソースとの連携を容易にします。さらに、LLaVAを活用することで、ビジネスプロセスにおける視覚データの活用が促進され、システム統合の幅が広がる可能性があります。

LLM-as-a-Judgeによる評価

LLM-as-a-Judge(LLMによる評価)は、カスタマイズしたLLMの性能を客観的に自動的・定量的に評価するための手法です。別のLLMを「審判」として使用し、生成された回答の品質、適切性、一貫性などを評価します。

この方法により、人間による手動評価の負担を軽減しつつ、大規模かつ迅速な評価が可能になります。

LLMから派生した関連用語

また、LLMという言語に特化したモデルだけでなく、画像や音声など他のモーダルを統合的に扱うモデルや、特定の目的に最適化されたモデルなど、多様なモデルが存在し、LLMと似たような用語が多く存在します。

以下では、その例をいくつか紹介します。

VLM(Vision-Language Model)

VLMは画像などの視覚情報とテキストを統合的に扱い、両者を関連づけて学習・推論するモデル。画像の内容を言語で説明したり、テキストから画像を生成するなど、視覚と言語の両面で理解・表現が必要なタスクに幅広く適用することができます。

VLA(Vision-Language-Action)

VLAは「視覚(Vision)と言語(Language)の理解を、具体的な行動(Action)に結びつけるAIモデル」です。

これまでのAIとの決定的な違いは、物理的な「行動」を直接出力できる点にあります。

従来のAIが、画像を見て「これはリンゴです」と説明したり、テキストでコーヒーの淹れ方を解説したりする「解説者」だったとすれば、VLAは自らコーヒーメーカーを操作してコーヒーを淹れることができる実行者です。

この「解説」から「実行」への飛躍こそが、VLAがもたらす最大のインパクトでしょう。

MLLM(Multimodal Large Language Model)

MLLMはテキストだけでなく、画像や音声など複数のモーダルを総合的に処理する大規模言語モデル。モデル内部で複数のモーダルの情報を結合し、それぞれに対応する表現を統一的に学習するため、高度な推論や総合的な理解が可能となります。

MLM(Masked Language Model)

MLMは文章中の一部をマスク(伏字)にし、その隠された部分を予測することで言語表現を学習するモデル。文章を部分的に隠すことで、モデルは文脈から欠損した単語やフレーズを補う学習を行い、結果として多様な下流タスク(文章分類、感情分析、QAなど)での性能向上に繋がります。

以上のように、元となるLLMからさまざまな派生・拡張が生まれており、マルチモーダル化・用途特化などの方向性へ細分化が進んでいます。

SLM

2023年後半頃からは、LLMと対をなすキーワードとしてSLMという言葉が使われるようになりました。

SLMとは小規模言語モデルを指し、特定の用途に限定した活用が可能で、計算コストが少なくコスト効率に優れた言語モデルとなっており、LLMに比べてデバイス搭載など多用途で扱いやすいとされている軽量のモデルです。

SLMはスマートフォンやIoTデバイスに搭載して、エッジLLMとして活用されることもあります。

GPTはLLMであるのに対し、SLMにはMicrosoftのPhi-2、Phi-3や、NTTのtsuzumiが該当します。

SLMとは何か、どんなモデルがあるか、こちらの記事で詳しく説明していますので併せてご覧ください。

LLMについてよくある質問まとめ

- LLM(大規模言語モデル)とは何ですか?

LLMは、大量のテキストデータから言語のパターンを学習し、文章生成や文章理解などのタスクを行うことができる人工知能技術です。多岐にわたる応用が可能で、ビジネスから日常生活まで幅広く利用されています。詳しくはこちらにジャンプ。

- LLMの具体的なビジネスへの活用例は何がありますか?

LLMは、カスタマーサポートの自動応答、マーケティングでの個別化されたコンテンツ生成、製品レビューや感情分析など、多岐にわたるビジネスの現場で活用されています。そのため、業種や目的に応じて様々な活用法が考えられるでしょう。詳しくはこちらにジャンプ。

- LLMを活用するために必ず自社開発が必要なのでしょうか?

いいえ、必ずしも自社開発は必要ありません。既存のLLMサービスをRAGやLangChainなどの技術で自社の用途に適合させる方法が、多くの場合でコスト効率が良く現実的な選択肢となります。

- AI MarketではLLMに関してどんな相談ができますか?

AI Marketでは、LLM(大規模言語モデル)活用をご検討の企業様へ、課題解決に最適なパートナーをご紹介しています。

例えば、人事評価システムを提供する企業様には、1on1面談のログを音声認識・LLMで感情分析し、面談品質を可視化できるAI会社を紹介しました。

また、写真スタジオを運営する企業様には、予約システムと連携し、LINEからの問い合わせに自動応答するチャットボットを構築できる会社をご案内しました。

- LLMによって能力の差はありますか?

はい、LLM(大規模言語モデル)には明確な能力差があります。

この差は、主に学習データ量の質と量、モデルのアーキテクチャ、ファインチューニング(追加学習)の方法に起因します。

具体的な能力差としては、指示の正確な理解・実行(指示遵守能力)、複雑な論理的推論力、最新情報の知識、創造的な文章生成力などに現れます。ユーザーの特定の用途(プログラミング、翻訳、データ分析など)によって、最適なモデルは異なります。

AI Marketでは代表的なChatGPT、Claude、Geminiについて以下の観点で詳細な検証を行っています。

まとめ

LLMの定義と概要、活用方法、導入コスト、サービスとツールを解説しました。LLM(大規模言語モデル)は、ビジネスの多岐に渡る分野での活用が期待されています。

しかし、適切なサービスやツールの選定は簡単ではありません。

具体的なビジネスへの活用方法を計画し、開発と調整を検討する段階では、外部開発会社への委託も選択肢となるでしょう。LLMを実業に役立てたい企業経営者にとって、

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp