楽天が日本語特化型の言語モデル「Rakuten AI 2.0」を発表、従来比4分の1の計算量で8倍の処理能力を実現

最終更新日:2024年12月18日

楽天グループは2024年12月18日、日本語処理に特化した大規模言語モデル「Rakuten AI 2.0」と小規模言語モデル「Rakuten AI 2.0 mini」を発表した。

Mixture of Experts(MoE)アーキテクチャを採用した「Rakuten AI 2.0」は、8つの70億パラメータで構成される「エキスパート」と呼ばれるサブモデルを実装。

従来の高密度モデルと比べて計算量を4分の1に抑えながら、8倍規模の処理性能を実現した。両モデルは来春にオープンソースとして公開される予定だ。

<本ニュースの10秒要約>

- Mixture of Expertsアーキテクチャ採用により、計算効率を大幅に向上させた日本語特化型の大規模言語モデルを開発

- 従来モデル「Rakuten AI 7B」と比較して、8つのタスクにおける平均日本語性能が62.93から72.29へと向上し、高精度な処理を実現

- 15億パラメータの小規模言語モデル「Rakuten AI 2.0 mini」を同時開発し、プライバシー保護とコスト効率の両立を実現

MoEアーキテクチャによる革新的な効率化

Rakuten AI 2.0は、入力トークンに対して最適な「エキスパート」を動的に選択するMoEアーキテクチャを採用している。

8つの70億パラメータで構成されるサブモデルのうち、最適な2つのエキスパートのみを使用して処理を行うことで、計算効率と性能を最適化している。この方式により、8倍規模の高密度モデルと同等の性能を発揮しながら、計算量を4分の1程度に抑制することに成功した。

日本語処理性能の大幅な向上

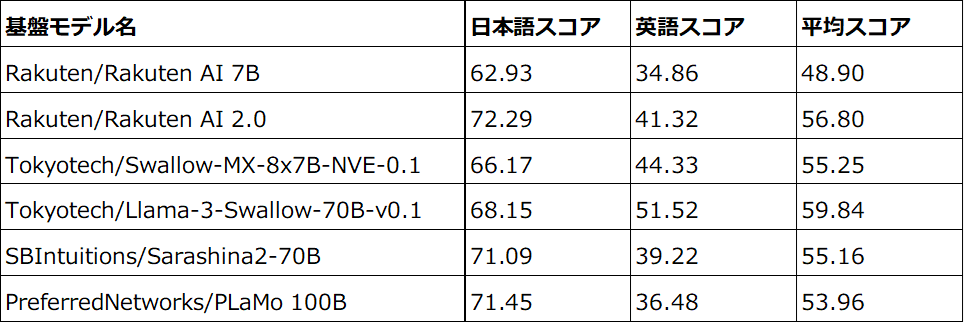

LM-Harnessを使用した評価では、Rakuten AI 2.0の平均日本語性能が、従来モデルのRakuten AI 7Bと比較して、8つのタスクにおいて62.93から72.29へと大幅に向上した。

これは、高品質な日本語と英語の言語データを用いた継続的な学習と、効率的なアーキテクチャの採用による成果だ。

小規模モデルの特徴と活用方法

Rakuten AI 2.0 miniは、15億パラメータの小規模言語モデルとして設計された。

モバイル端末への導入が可能で、データをリモートサーバーに送信することなく自社運用できる特徴を持つ。内製の多段階データフィルタリングとアノテーションプロセスにより、テキスト生成において高性能かつ高精度な処理を実現している。

Rakuten AI 2.0 miniは、プライバシーの保護、低遅延、コスト効率が求められる特定のアプリケーションに最適化されている。モバイル端末での活用を想定し、エッジコンピューティングの領域での活用が期待される。

今後、オープンソースコミュニティへの公開により、さらなる発展と活用の広がりが見込まれる。

AI Market の見解

楽天の新AIモデルは、日本語処理に特化したMoEアーキテクチャの採用により、計算効率と性能の両立を実現した点が特筆される。

特に、従来比4分の1の計算量で8倍の処理能力を実現したことは、AIモデルの実用化における重要な進展だ。また、15億パラメータの小規模モデルの開発は、エッジコンピューティング時代のAI活用に向けた現実的なソリューションを提供している。

オープンソース化により、日本語AIモデルの発展が加速することが期待される。コスト効率とプライバシー保護の両立は、企業のAI導入における重要な課題を解決する可能性を秘めており、市場への影響は大きいと考えられる。

参照元:PR TIMES

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp