LLM導入での評価体制構築で難しいのは?生成AI改善サイクルの運用フロー、自動評価を実現するポイントを徹底解説!

最終更新日:2025年09月25日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

- LLMは従来のシステムと異なり、継続的に評価し改善を繰り返す「育てる」視点が不可欠

- 正確な評価はIT部門の技術的視点だけでは不可能。業務部門の利用実感、経営層の投資対効果、法務のコンプライアンスといった多角的な視点

- 評価と改善は、PDCAサイクルとして定常的に運用する仕組みが重要

生成AIの活用が広がる中で、LLM(大規模言語モデル)を導入した企業は少なくありません。しかし、導入そのものがゴールではなく、評価・改善のサイクルを確立できるかどうかが、真の導真入効果を左右します。

そのためには、精度やコスト削減といった短期的な成果ではなく、継続的な評価と改善サイクルを運用できるかがLLMを戦略的資産にできるかの分岐点となります。

本記事では、LLMの評価体制の構築に必要な、評価指標(KPI)の設定や評価チームの組織化、そして改善サイクルの運用フローを解説します。評価の自動化を実現するポイントについても紹介し、実証実験で終わらない実務的な運用フローが理解できる内容となっています。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

目次

社内で行うLLM導入評価のプロセス

LLMの導入には、回答の精度や応答速度だけでなく、事業目標に沿った評価体制を整えることが重要です。LLM評価プロセスは、大きく以下の4つの段階に分けられます。

- KPIの設定

- 評価チームの組織化

- 改善サイクルの運用

- 評価の自動化

まず、LLMをどの業務に活用するのかを明確にし、定量的な数値指標と定性的なユーザー体験の両面からKPIを設計します。その上で、複数の視点を持つLLM評価チームを編成することで、確実な評価が可能になります。

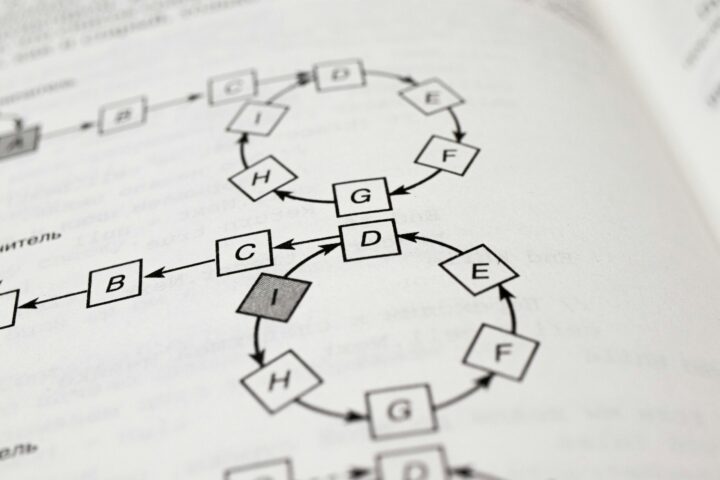

さらに、Plan-Do-Check-Actの改善サイクルを運用し、LLM継続的評価を仕組み化することで、単発的な検証に終わらせずに済みます。

加えて、LLMOpsや評価ツール、人手評価との併用を導入すれば、モデル性能の変化やデータドリフトを自動で検知でき、安定した運用体制を確立できます。

なぜLLMには特別な評価体制が必要なのか?

従来のシステム開発では、要件定義に基づき「正しく動くか」「仕様通りか」が評価の主軸でした。インプットに対してアウトプットは一意に決まり、その正誤は明確です。

一方、LLMは「非決定的(Non-deterministic)」なシステムです。同じ質問をしても、その時々で表現が揺らいだり、異なる回答が生成されたりします。

100点満点の「完璧な正解」が存在しないケースも多く、そのアウトプットの価値は、利用するユーザーやビジネスの文脈によって大きく変動します。

ここに、従来の開発手法との大きなギャップがあります。

LLM導入プロジェクトは、リリースしてからが本番。ユーザーからのフィードバックや利用データを元に、対話をしながら「LLMを育てていく」という発想が不可欠です。

この「育てる」活動の根幹をなすのが、適切な評価体制と、それに基づく継続的な改善サイクルなのです。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

LLM評価チームの組織化に含めるべき部署は?

LLM評価体制を機能させるには、複数部門の連携した評価チームが組織化されていることが欠かせません。

- IT部門

- 業務部門

- 経営層

- 法務・セキュリティ

それぞれ異なる視点を持ち寄ることで、総合的な評価が可能となります。以下では、それぞれの部門での役割について解説していきます。

IT部門:モデル性能検証、システム統合

IT部門の主な役割は、LLMの性能を検証し、既存システムとの統合を円滑に進めることです。

性能検証においては、正答率、応答速度、処理負荷といった技術的な指標をベースにLLM評価プロセスを体系的に進めます。また、APIや基盤システムとの連携テストも行い、現場で利用できる運用体制を安定的に整備することも求められます。

さらに、モデル更新やバージョン管理を効率化し、LLM評価のサイクルづくりを推進する役割も担います。評価の自動化やログ解析によって、データドリフトを早期に検知できるようになります。

こうした性能検証やシステム統合は、業務部門や経営層が安心してLLMを活用できる基盤となり、運用体制全体においても信頼性を高めます。

業務部門:利用シナリオや業務効率の観点で評価

業務部門は、実際の利用シナリオを通じて、LLMが業務改善に貢献できるかを評価する役割を担います。

IT部門が性能検証を行うのに対し、業務部門は日常業務の中で、使いやすさや業務効率の向上度を軸に確認します。例えば、顧客対応では応答スピードやオペレーターの負担軽減といった観点がKPIに直結します。

また、業務フローの中でLLMを組み込む効果を検証し、現場から改善点をフィードバックするのにも役立ちます。業務支援ツールとしてではなく、属人化の解消やナレッジ共有の加速といった組織的な課題解決に寄与しているかを見極めることが求められます。

これらの知見は、LLM改善サイクルに反映され、運用体制全体の最適化につながります。業務部門の評価が充実するほど、導入効果が実感されやすくなり、現場への定着もスムーズになるでしょう。

経営層:ROIや投資判断の評価

経営層は、LLM導入による投資効果を評価・判断し、事業戦略に反映させる役割を担います。

特に注目すべきはROI算出で、導入コストや運用費用に対して、業務効率化や売上アップが実現できたかを把握することに貢献します。そのためには、定量的KPIと定性的KPIを総合的に判断し、成果を数値として示す必要があります。

また、経営層の視点では短期的な成果ではなく、中長期的な競争優位性の確保も検討対象となります。LLM運用体制が持続的に機能するか、改善サイクルが組織文化として定着するかを評価し、追加投資や事業拡大を決断します。

経営層がLLM評価に関与することで、LLMの導入は企業成長を支える戦略的取り組みへと昇華されます。そのためには、経営層がLLMの評価サイクルに関与する必要があります。

法務・セキュリティ:リスクやコンプライアンスの管理

法務・セキュリティ部門は、LLM運用のリスクマネジメントとコンプライアンスの確保を担います。

LLMは膨大なデータを扱うため、著作権や個人情報保護に関わる法的リスクを常に伴っています。そのため、評価段階では利用データの取り扱いが法規制や社内ポリシーに適合しているかを確認し、リーガルリスクを未然に防ぐ仕組みを整える必要があります。

また、セキュリティ面では入力データや生成結果が外部に漏洩しないよう、アクセス制御や暗号化、監査ログの運用が不可欠です。さらに、AI倫理や説明責任の観点から、不適切な出力が業務に与える影響を想定し、対応ガイドラインを策定することも必要です。

法務・セキュリティ部門の関与は、LLMの継続的評価を安心して進めるための前提条件といえるでしょう。

LLMの改善サイクルの運用フロー

LLMは一度導入しただけ継続的な効果を得ることは難しいです。そのため、導入後の改善サイクルを運用フローとして組み込むことが重要です。

具体的には、Plan-Do-Check-Actの仕組みをベースに、目的設定から効果検証、改善施策の反映までを定常的に回すことで、LLM評価プロセスの運用体制を成長させることが可能です。

評価結果の分析と課題特定

収集した定性的・定量的な評価データを分析し、課題のボトルネックを特定します。

まず重要なのはエラー分析です。

なぜ間違った回答をしたのか? Hallucination(幻覚)か、参照した情報が古いのか、質問の意図を誤解したのか、と言ったエラーの傾向を分類します。そして、最もインパクトの大きい課題から優先順位をつけます。

さらに、「👎」が押された回答や、「役に立たなかった」というコメントの裏にある、ユーザーの真のニーズを探ります。単なる不満ではなく、次の改善に繋がる貴重なヒントの宝庫です。

関連記事:「LLMの導入・改善効果をA/Bテストで測定できる?指標設定から実施手順、分析の流れを徹底解説!」

具体的な改善アクションの検討

特定された課題に基づき、改善策を実行します。LLMの改善アプローチは以下のように多岐にわたります。

プロンプトエンジニアリング

最も手軽で即効性のある改善策です。LLMへの指示(プロンプト)をより具体的に、より明確にすることで、出力の質は劇的に向上します。

RAGの改善

RAG(検索拡張生成)を使った社内文書検索などの用途では、回答の質は参照するデータの質に大きく依存します。検索精度を上げるためのアルゴリズム見直し(キーワード検索からセマンティック検索へ)、参照させるドキュメントの追加や前処理の改善などが有効です。

ファインチューニング(Fine-tuning)

ファインチューニング(Fine-tuning)は、特定のタスクや業界用語への対応力を高めるために、独自のデータセットを使ってモデルを追加学習させる手法です。コストと手間がかかりますが、汎用モデルでは達成できない高いパフォーマンスを発揮する可能性があります。

モデルの変更

より高性能な新モデルに乗り換えたり、あるいは特定のタスク(例:コーディング)に特化したモデルを試したりすることも重要な選択肢です。モデルごとのコストと性能のトレードオフを常に見極める必要があります。

関連記事:「LLMの精度を評価・改善するテクニックとは?データ戦略のポイントも徹底解説!」

定着

重要なのは、一度にすべてを完璧にしようとしないことです。「プロンプトを少し変えてみてA/Bテストにかける」「参照データを1つ追加して正答率の変化を見る」といった小さな改善を毎週のように繰り返します。

そして、その効果をKPIで測定し、次のアクションに繋げる。このアジャイルな開発プロセスこそが、「育てる」LLMプロジェクトの核心です。

それによって、LLM評価体制は組織に定着し、拡張させることも可能です。

また、改善結果は文書化し、ナレッジとして社内に共有することで属人化を防ぎ、次のサイクルを効率的に回せる基盤を築けます。

拡張

定着と同様に重要なのが拡張です。特定部門で成果を確認できたら、他の業務領域や新規プロジェクトにも展開することで全社的なAI活用へと発展させられます。

顧客対応での効果検証→社内情報検索や文書管理への応用など、段階的に適用範囲を広げる方法が有効です。

このように、継続的評価を前提とした改善サイクルを繰り返し、運用を拡張していくことで評価サイクルが確立され、精度を上げていくことが可能です。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

LLMの継続的評価を自動化するポイント

LLMの運用を持続的に改善していくには、人手による検証だけでなく、評価プロセスの自動化が不可欠です。定期的なモデル検証を効率化することで、安定した運用体制を維持できます。

評価データと基準の自動更新

LLMを長期的に運用する上で欠かせないのが、評価データと基準の更新です。導入初期に設定した評価セットや基準値は、時間経過や業務環境の変化により陳腐化する可能性があります。

そのため、新しい業務シナリオやユーザーニーズを反映した評価データを定期的に追加し、自動的に更新される仕組みを構築することが重要です。

実務では、ログデータや問い合わせ履歴を自動収集して、評価用データセットに組み込み、過去のKPIと比較しながら基準値を調整する手法が有効です。これにより、最新の環境を反映したLLM評価プロセスを実現できます。

また、MLOpsや専用ツールと連携することで自動更新を効率化でき、属人的な判断を排して、客観的なLLM改善サイクルを回せるようになります。

データドリフト検出・性能低下検知

LLMを継続的に運用する中で避けられないのが、データドリフトや性能低下です。学習時と運用時でデータの性質が変化すると、モデルの出力品質が劣化するリスクが高まります。これを放置すると、誤答の増加や業務効率の低下につながるため、早期に検出し、対策が不可欠です。

そのためには、入力データの分布変化をモニタリングする仕組みを導入し、異常値を検出した時点でアラートを発する方法が有効です。また、定期的にベンチマークテストを自動実行し、過去の性能指標と比較することで、性能低下を迅速に把握できます。

他にも、評価基準と連動した自動ログ解析を行えば、どの領域で問題が生じているかを特定しやすくなります。これにより、改善サイクルにおけるCheckとActのフェーズを回せるようになり、LLM評価の信頼性を維持できます。

LLM-as-a-JudgeやLLMOpsなどのツール導入

LLMの評価を継続的なものにするには、専用のツールを導入することも効果的です。その一つがLLM-as-a-Judgeで、生成された回答を別のLLMで自動的に評価することで、人的リソースに依存せず客観的な品質評価を可能にします。

特に大規模なテストケースを扱う場合、LLM-as-a-Judgeによって評価工数の大幅削減につながります。

加えて、LLMOpsはモデルの学習、デプロイ、監視、改善を一貫して管理するため、評価プロセスを自動化・標準化する基盤となります。RAGASやLangChain、LlamaIndexといったオープンソースのフレームワークには、LLMアプリケーションの評価機能が組み込まれています。

これらのツールを活用することで、LLM評価体制を継続的に回せる基盤へと進化していきます。ツールの導入については、AI開発を専門とする会社に相談・依頼することも検討してみてください。

LLMの評価体制についてよくある質問まとめ

- なぜLLMの評価は、従来のシステム開発と違うのですか?

従来のシステムは仕様通りの正解が一つに決まりますが、LLMは同じ入力でも回答が異なり「完璧な正解」が存在しないためです。そのため、ビジネスの文脈に合わせて継続的に性能を改善していく「育てる」というアプローチが不可欠になります。

- 評価チームにはどの部門に参加してもらうべきですか?

LLMの評価は多角的な視点が必要なため、以下の部門を参加させるのが効果的です。

- IT部門:モデル性能検証やシステム統合を担当

- 業務部門:現場の利用シナリオや効率改善の観点で評価

- 経営層:ROIや投資判断の評価を行い、導入の方向性を決定

- 法務・セキュリティ部門:リスク管理やコンプライアンス対応を担当

- LLMの評価を効率的に行う方法はありますか?

はい、評価プロセスを自動化することが非常に有効です。具体的には以下のような方法があります。

- 評価に使用するデータや基準値を自動で更新する仕組みを構築する。

- 入力データの変化(データドリフト)を自動検知し、性能低下を監視する。

- 「LLM-as-a-Judge」(LLMに他のLLMを評価させる手法)やLLMOpsといったツールを導入する。

まとめ

LLMの導入効果を最大化するには、単発的な検証で終わらせるのではなく、継続的な改善サイクルを定着させることが不可欠です。KPIを設定して効果を可視化し、IT部門・業務部門・経営層・法務セキュリティが連携する評価チームを組織することで多角的かつ実務的な評価が可能になります。

ただし、こうした評価体制や改善サイクルを自社だけでゼロから構築し、円滑に運用していくには専門的な知見と経験が求められるのも事実です。

もし、KPIの具体的な設定方法、評価プロセスの自動化、あるいは客観的な視点での課題特定などでお困りの際は専門家の知見を活用することも有効な選択肢です。LLMを真のビジネスパートナーとして育てるために、ぜひ一度ご相談ください。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp

WEBから無料相談(60秒で完了)

今年度問い合わせ急増中

Warning: foreach() argument must be of type array|object, false given in /home/aimarket/ai-market.jp/public_html/wp-content/themes/aimarket/functions.php on line 1594

Warning: foreach() argument must be of type array|object, false given in /home/aimarket/ai-market.jp/public_html/wp-content/themes/aimarket/functions.php on line 1594