LLMの自動評価の代表的指標は?評価ツール・ベンチマーク、タスク別の使い分けと限界を徹底解説!

最終更新日:2025年09月29日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

- LLMの性能評価には、単語の一致率を測る伝統的な指標(BLEU, ROUGE)から文脈や意味の近さを捉える指標(BERTScore, LLM-as-a-Judge)まで多様な「モノサシ」

- 評価作業を効率化するフレームワーク(Hugging Face Evaluate, LangSmithなど)があり、モデル選定や開発、運用といったフェーズごとに使い分ける

- 自動評価は万能ではなく、事実の正確性(ハルシネーション)や文脈への適合性を測るには限界

LLM(大規模言語モデル)を自社ビジネスに導入する際、「どのモデルが本当に優れているのか」「開発チームが話す性能スコアは何を意味するのか」といった疑問に直面することはないでしょうか。

感覚的な判断や断片的な情報だけでは、投資対効果の高いモデル選定や継続的な品質改善は困難です。

この記事では、LLMの性能を客観的に評価するための「共通言語」となる自動評価に使われる指標を解説します。翻訳や要約タスクで使われてきた伝統的な指標から、BERTScoreのような意味の近さを測る先進的な手法、さらには開発フェーズごとに最適な評価ツールまでを網羅的に紹介します。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

目次

LLM以前から用いられる自然言語処理ベースの評価指標

LLM(大規模言語モデル)の精度評価や性能評価のうち、定量的に測定できる要素を機械的に測定し数値化する考え方の多くは、LLM登場以前の自然言語処理(NLP)タスクや自然言語生成(NLG)タスクで培われてきた手法にそのルーツを持っています。

これらは今でもベースラインとして利用されるため、基本的な考え方を理解しておくことは非常に重要です。

関連記事:「LLM導入での評価指標(KPI)種類は?生成AIを最大活用できる選び方・設定の落とし穴」

BLEUスコア

BLEU(Bilingual Evaluation Understudy)スコアは、機械翻訳タスクの評価指標として広く使われてきた指標です。現在もLLM自動評価の基礎として活用されています。

一言で言えば、「モデルが生成した訳文(候補文)が、人間が作成した高品質な訳文(参照文)とどれだけ似ているか」を単語の一致率で評価します。

生成されたテキストと参照テキストのn-gram(一連の単語の並び)一致率を計算し、類似度を0〜1のスコアで表現します。スコアが高い(1に近い)ほど参照文に近い出力とみなされ、翻訳や形式が定まったテキストの生成品質を測定できます。

計算がシンプルで高速なのが長所です。

一方で、BLEUスコアは表面的な一致度に依存するため、同じ意味でも異なる言い回しを用いた場合にスコアが過小評価される傾向があります。例えば、「I have a pen」(私はペンを持っています)と「A pen is what I possess」(私が所有しているペン)のような、意味はほぼ同じでも表現が異なる文を正しく評価できないという大きな弱点があります。

そのため、自由度の高い対話生成やクリエイティブな文章生成では、評価の精度が不十分となる可能性があります。

ROUGEスコア

ROUGE(Recall-Oriented Understudy for Gisting Evaluation)スコアは、要約の評価に特化した指標で単語やフレーズの重複度を測定します。要約タスクでは重要語句がどれだけ再現されているかを定量的に評価できるため、BLEUスコアと並び広く利用されています。

BLEUが候補文を基準にするのに対し、ROUGEは参照文を基準に考えます(再現率重視)。参照文中のn-gram(一連の単語の並び)やLCS(最も長い共通部分文字列)が、生成された要約文にどれだけ出現するかを測定します。

代表的な指標としては、以下の通りです。

| 指標 | 概要 | 特徴 |

|---|---|---|

| ROUGE-N | 参照文と生成文のn-gram一致率を評価 |

|

| ROUGE-L | 最長共通部分列を用いて語順を含めた類似度を測定 | より自然な要約の品質評価に向いている |

| ROUGE-W | 長い一致に重みを置いてスコアを計算 | 情報のまとまりや一貫性を重視する場合に有効 |

| ROUGE-S / ROUGE-SU | スキップバイグラムを用いた指標 離れた単語の関係を評価可能 | 言い換えを含む要約の品質を評価する |

ROUGEでは、どれだけ情報を取りこぼさずに含められたかを重視する一方で、不要な情報をどれだけ排除できたかを測定することはできません。また、BLEUと同様に表面的な単語の一致しか見ておらず、同義語や言い換えを十分に考慮できないのが弱点です。

そのため、表現の多様性が高い出力では評価が低めに出る傾向があります。BERTScoreなど意味的類似度を扱う指標と組み合わせることで、より精度の高い評価が可能です。

METEOR

METEOR(Metric for Evaluation of Translation with Explicit ORdering)は、BLEUやROUGEの「単語の完全一致しか見ない」という弱点を改善するために開発された評価指標です。

単なる文字列の一致だけでなく、WordNetという類義語辞書を用いて同義語を評価したり、語幹を揃えて比較したりすることで、より意味的に近いかを評価しようと試みた点が特徴です。

| 項目 | METEOR | BLEUスコア |

|---|---|---|

| 評価方法 | 単語一致に加え、同義語・語形変化・語順を考慮 | n-gram一致率を計算 |

| メリット | 意味的に近い表現を評価でき、人間の主観評価との相関が高い | 計算が高速かつシンプルで、研究・産業での利用実績が豊富 |

| デメリット | 複数参照文がない場合は評価が不安定になりやすい | 言い換えや語形変化を考慮できず、低スコアになる場合がある |

| 適しているタスク |

|

|

METEORは一致率(Precision)と再現率(Recall)の両方を重視しており、生成文が短すぎて情報を欠落させている場合や、逆に冗長な場合でも評価可能です。

ただし、計算がやや複雑で処理コストが高いため、大量の出力をリアルタイムで評価する場面では負荷が大きい課題があります。LLM時代以前の指標でありながら、表面的な一致から一歩踏み込んだ先進的なアプローチとして知られています。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

LLM出現以降の定量評価に用いられる代表的な自動指標

BLEUやROUGEの課題であった「意味の類似性」を評価するため、LLMの基盤技術でもあるBERTなどの事前学習済みモデルを活用した、より高度な評価手法が登場しました。

BERTScore

BERTScoreは、文字列の一致率だけで評価するのではなく、事前学習済みの言語モデル(BERTなど)のベクトル表現を用いて文脈に応じた意味的な類似度を測定する指標です。

各単語を埋め込み空間にマッピングして、候補文と参照文の各単語を文脈に応じたベクトル(数値の列)に変換します。そして、単語同士のベクトルの向きがどれだけ似ているか(コサイン類似度)を計算し、文全体の類似度をスコアリングします。

表現が異なっていても意味が近ければ高いコサイン類似度スコアになります。そのため、パラフレーズや表現の多様性が求められるタスクでも評価可能です。

また、BERTScoreは翻訳・要約・対話生成など幅広いタスクに適していて、人間の主観評価との相関も高いことが報告されています。BLEUやROUGEでは拾えない意味の正確さや自然さを反映できます。

一方で、使用するモデルや事前学習データに依存するため、異なるモデル環境ではスコアが再現しづらいという課題があります。また、文章の流暢さや文法的な正しさ、論理的な一貫性までは評価が難しいことも弱点です。

LLM-as-a-Judge

LLM-as-a-Judgeは、近年注目されている新しい評価アプローチで、LLM自体を評価者として活用する手法です。

具体的には、ChatGPTやClaudeなど事前学習済の高性能LLMに対して品質をスコア化するプロンプトを与え、モデル自身に採点させます。これにより、文脈や意味的整合性、自然さ、論理的妥当性を含めた総合的な評価を高速化・自動化することが可能です。

LLM-as-a-Judgeは、複雑な対話生成や長文要約など、従来の自動指標が苦手とする領域で特に有効です。

LLMを自動評価するためのフレームワークとベンチマーク

自動評価指標を実務で使いこなすためには、評価フレームワークと標準化されたベンチマークを組み合わせるのが重要です。次に、LLMの自動評価で用いられる代表的な評価フレームワークと主要ベンチマークを紹介します。

評価フレームワーク

LLMの自動評価指標を運用するには、複数の評価指標を一元的に実行できるツールを活用するのがおすすめです。代表的なツールとしては、以下の4つです。

| 評価ツール | 概要 | 特徴 | 適しているタスク |

|---|---|---|---|

| Hugging Face Evaluate | Hugging Faceが提供するPythonライブラリ |

| 汎用的なタスク全般に適していて、モデル比較や研究開発向き |

| OpenAI Evals | OpenAIが提供する評価フレームワーク |

|

|

| LM Evaluation Harness | EleutherAIが開発した研究者向け評価スイート |

|

|

| LangChain Evaluation(LCEL) | LangChainと連携する開発・運用プラットフォーム |

|

|

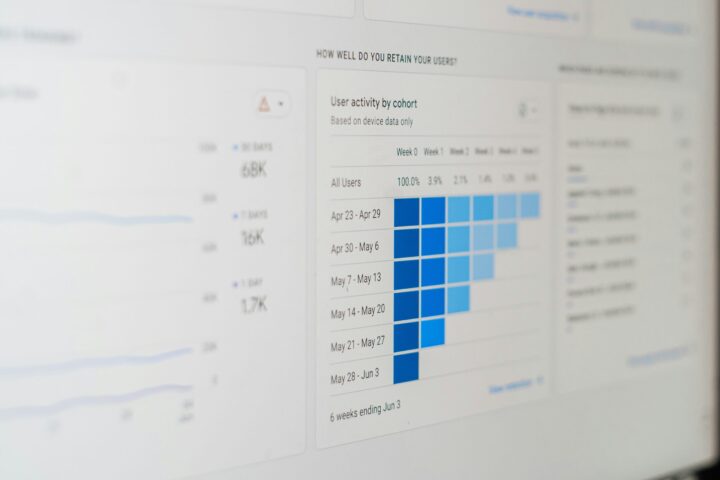

これらのツールは単体で使うのではなく、適切に組み合わせることで、開発・検証・運用の各フェーズで評価を自動化し、改善サイクルを高速に回せます。使い分けとしては、以下の方法がおすすめです。

| フェーズ | フレームワーク使い分け |

|---|---|

| モデル選定 | LM Evaluation Harnessで、候補となるモデルの総合的な基礎能力を比較 |

| 開発・プロトタイピング | LangChain & LangSmithでアプリケーションの各コンポーネントが意図通りに動いているか、トレース機能で詳細にデバッグ・評価 |

| CI/CD・リリース前 | OpenAI Evalsで定義したテストケース(重要なプロンプトなど)で性能が劣化していないか、自動で回帰テストを実行 Hugging Face Evaluateで独自の定量的指標(例:特定の用語を必ず含んでいるか)をCIパイプラインに組み込み、品質ゲートとして利用 |

| 運用・モニタリング | LangSmithで本番環境でのユーザーとのやり取りを監視し、予期せぬエラー、レイテンシーの悪化、低評価の応答などを検知 |

これらのフレームワークは競合するだけでなく、開発ライフサイクルの各段階で相互に補完し合う関係にあります。目的とフェーズに応じて適切に使い分けることが、高品質なLLMアプリケーションを迅速に開発・改善する鍵となります。

ベンチマーク

現代のLLMは、翻訳や要約だけでなく、質問応答、文章生成、推論など、極めて多様なタスクをこなします。そのため、単一の指標で性能を測るのではなく、複数のタスクをまとめたベンチマークを用いて、総合的な能力を評価するのが主流となっています。

例えば、MMLU (Massive Multask Language Understanding)は、近年の主要なLLMの性能発表で必ずと言っていいほど引用されるデファクトスタンダード的なベンチマークです。

LLMの性能を客観的に比較する標準化されたベンチマークの代表的なものとして、以下の4つが挙げられます。

- MMLU:57分野にわたる多肢選択問題を通じて、知識と推論力を評価

- GLUE:自然言語理解のタスク(文分類、文類似度、自然言語推論など)を網羅

- SuperGLUE:GLUEの発展版で、より複雑な推論や常識的判断を必要とするタスクに対応

- JGLUE:日本語向けに設計されたベンチマークで、分類・要約・自然言語推論など日本語特有の課題を網羅

ベンチマークを選ぶ際は、自社のユースケースにどれだけ近いかを重視することが重要です。社内文書検索システムの評価ならMMLUやJGLUE、要約生成ならROUGEスコアを用いたベンチマークを選ぶのが最適です。

ベンチマークはスコア比較だけにとどまらず、モデルが得意とする分野や弱点を可視化し、改善の優先順位を明確にする役割を持ちます。

MMLUでは。初等数学、米国史、コンピュータサイエンス、法律など57の幅広い分野にわたる四択問題を解かせることで、モデルの広範な知識と問題解決能力を測定します。人間で言えば、様々な分野の専門知識を問う総合学力テストのようなものです。

LLMに強い会社・サービスの選定・紹介を行います 今年度LLM相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

LLM自動評価には限界がある

自動評価を用いたLLMの品質評価では、タスクの種類に応じて選び分けることが重要になります。同時に、自動評価だけでは測りきれない部分も理解しておく必要があります。

オールマイティな指標は存在しない

万能の指標は存在しません。

例えば、BLEUスコアやROUGEスコアは表面的なn-gram一致に依存しており、文脈の正しさや論理的整合性を正確に捉えることはできません。BERTScoreなど意味的類似度を扱う指標も、参照文にない新しい情報を判断できるかは保証されません。

さらに、評価指標の数値は相対的なものであり、絶対的な品質保証にはならない点にも注意が必要です。数値を盲目的に追うと、ユーザー体験やビジネス目標に合致しない最適化を行う危険性もあります。

そのため、自動評価は第一段階のスクリーニング(足きり)として位置づけ、最終的な品質確認には人手評価やユーザーテストを組み合わせることが望まれます。

事実の正確性(ハルシネーション)

もっともらしい嘘を生成していないか、その内容が事実に基づいているかの評価は困難です。また、倫理性や公平性の観点を考慮できない可能性もあり、差別的表現や事実誤認を見逃すリスクがあります。

文脈や背景情報への適合性

ユーザーの意図や状況に即した、気の利いた回答ができているかといった評価はできません。ベンチマークスコアが高くても、自社の特定のユースケースで高い性能を発揮するとは限りません。

例えば、カスタマーサポートの自動応答であれば「回答の正確性」「共感性」「解決率」、社内文書の要約であれば「専門用語の正確性」「重要事項の網羅性」など、自社の業務に合わせた独自の評価基準や小規模なテストデータセットを構築することが導入成功の鍵を握ります。

創造性・倫理観

クリエイティブな文章の質や、差別的・攻撃的な内容を含んでいないかといった倫理的な側面の評価は人手が必要です。

特に顧客向けのサービスなど、品質が事業に直結する領域では、自動評価のスコアだけを鵜呑みにせず、必ず人間の目で最終的な品質をチェックすることが不可欠です。

人手評価との組み合わせが必要

自動評価は効率性を高めますが、評価の精度としては不安定と言えます。そのため、最終的な品質保証には人手評価を組み合わせる必要があります。

自動評価と人手評価は、互いに補完し合う関係にあります。自動評価は大量の生成結果を一括でスクリーニングすることが可能で定量的に品質を比較するのに適しています。これにより、評価サイクルを短縮できます。

一方で人手評価は、文脈の妥当性、読みやすさ、論理性、倫理性といったような自動評価では判定が難しい定性的要素を確認する役割を担います。特に、意思決定や本番リリース前の最終チェックの段階では、人手評価が不可欠です。

このように、自動評価で膨大なデータを絞り込み、人手評価でそのデータを深く掘り下げるのが自動評価と人手評価の両立です。これができれば、どちらかの評価方法に依存するよにも信頼性の高いサイクルを確立できます。

関連記事:「LLM導入での評価体制構築で難しいのは?生成AI改善サイクルの運用フロー、自動評価を実現するポイント」

LLMの自動評価についてよくある質問まとめ

- 昔から使われているLLMの評価指標にはどんなものがありますか?

LLM登場以前の自然言語処理タスクで用いられてきた、以下の代表的な指標があります。

- BLEUスコア: 主に機械翻訳で使われ、参照文と生成文の単語の並び(n-gram)がどれだけ一致しているかを測ります。

- ROUGEスコア: 主に文章要約で使われ、参照文の重要な情報が生成文にどれだけ含まれているか(再現率)を測ります。

- METEOR: BLEUやROUGEの弱点を補い、単語の語幹や類義語も考慮して、より意味的な近さを評価しようとする指標です。

- LLMの時代になって新しく登場した評価指標は何ですか?

LLMの高度な能力を評価するため、文脈や意味の類似性を捉える新しいアプローチが登場しています。

- BERTScore: BERTなどの言語モデルを使い、単語の表面的な一致ではなく、文脈に応じた意味のベクトルがどれだけ近いかを測定します。

- LLM-as-a-Judge: 高性能なLLM自体を「評価者」として活用する手法です。評価用のプロンプトを与え、LLMに文章の品質を採点させることで、文脈の整合性や自然さといった複雑な要素の評価を自動化します。

- タスクごとの使い分けは?

タスクに応じた指標選定が重要です。

- 機械翻訳:BLEU、METEOR、BERTScore

- 要約タスク:ROUGE-N、ROUGE-L、BERTScore

- 自由文生成や対話:BERTScore、LLM-as-a-Judge

- LLMの評価を効率的に行うためのツールや基準はありますか?

はい、評価を効率化・標準化するための「フレームワーク」と「ベンチマーク」が存在します。

- 評価フレームワーク: Hugging Face EvaluateやLM Evaluation Harness、LangChain & LangSmithなどがあり、開発のフェーズ(モデル選定、開発、運用)に応じて使い分けることで評価プロセスを自動化・高速化できます。

- ベンチマーク: MMLUやGLUE、日本語用のJGLUEなどがあり、標準化されたタスクセットでモデルの総合的な能力を公平に比較できます。

- ベンチマークはどれを選べばよいですか?

自社のユースケースに近いベンチマークを選ぶことが、基本でありもっとも重要です。

- 汎用的な言語理解:GLUE、SuperGLUE

- 知識・推論力:MMLU

- 日本語対応:JGLUE

- LLMの自動評価で注意すべき点は何ですか?

自動評価には限界があり、以下の点には特に注意が必要です。万能な指標はないため、複数の指標や人手評価を組み合わせることが重要です。

- 事実の正確性: もっともらしい嘘(ハルシネーション)を検知するのは困難です。

- 文脈への適合性: ユーザーの細かな意図や背景に沿っているかまでは評価できません。

- 創造性・倫理観: 文章の創造的な質や、差別的・攻撃的な内容を含んでいないかの判断は人手が必要です。

まとめ

LLMの自動評価は、品質チェックの効率化に留まらず、モデル開発と改善サイクルを回すための基盤としても機能します。適切な指標を使い分けることで、出力の品質を定量的に把握できます。また、評価ツールやベンチマークを活用すれば、再現性の高い評価環境を構築できるでしょう。

しかし、これらの評価手法を自社の具体的な業務要件に合わせて設計し、再現性の高い評価環境をゼロから構築するには専門的な知識と経験が求められます。特に、自動評価の限界を理解し、それを補う人手評価のプロセスをいかに効果的に組み込むかがプロジェクト成功の鍵を握ります。

もし、自社に最適な評価基準の策定や、開発から運用までを見据えた評価体制の構築にお悩みでしたら一度専門家にご相談ください。貴社のビジネス目標達成に向け、最適なLLMとその評価戦略をご提案します。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp

WEBから無料相談(60秒で完了)

今年度問い合わせ急増中

Warning: foreach() argument must be of type array|object, false given in /home/aimarket/ai-market.jp/public_html/wp-content/themes/aimarket/functions.php on line 1594

Warning: foreach() argument must be of type array|object, false given in /home/aimarket/ai-market.jp/public_html/wp-content/themes/aimarket/functions.php on line 1594