パナソニックHD、「SparseVLM」で視覚情報理解AIモデルを約2倍高速化

最終更新日:2026年03月04日

記事監修者:AI Market ニュース配信チーム

パナソニックR&Dカンパニー オブ アメリカとパナソニックHDが、北京大学、復旦大学、カリフォルニア大学バークレー校、上海交通大学と共同で、視覚情報を言語で理解するVision Language Model(VLM)を軽量化する技術「SparseVLM」を2025年7月4日に発表した。

本技術は入力プロンプトに関連する視覚情報のみを処理する新たなアプローチにより、高い質問応答精度を維持しつつ推論時間や演算量を大幅に削減することに成功した。

<本ニュースの10秒要約>

- 入力プロンプトに関連する視覚情報のみを処理する新しいスパース化技術により、VLMの効率性を向上

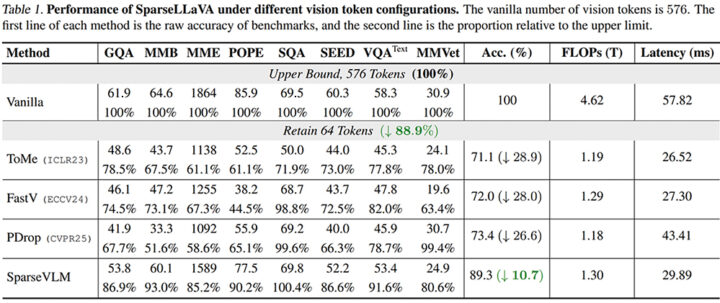

- 平均89.3%の精度を維持しながら48.3%の高速化と71.9%の演算量抑制を実現

- AI・機械学習技術のトップカンファレンスICML 2025に採択され、技術の先進性を国際的に認められた

近年、視覚情報とテキスト情報を同時に処理し、視覚情報に対する質問に回答するAIモデルであるVLMが盛んに開発されているが、特に高解像度の画像や長時間の映像では、AIモデルが扱う情報量が増えるため、推論時間や演算量が増大してしまうという課題があった。

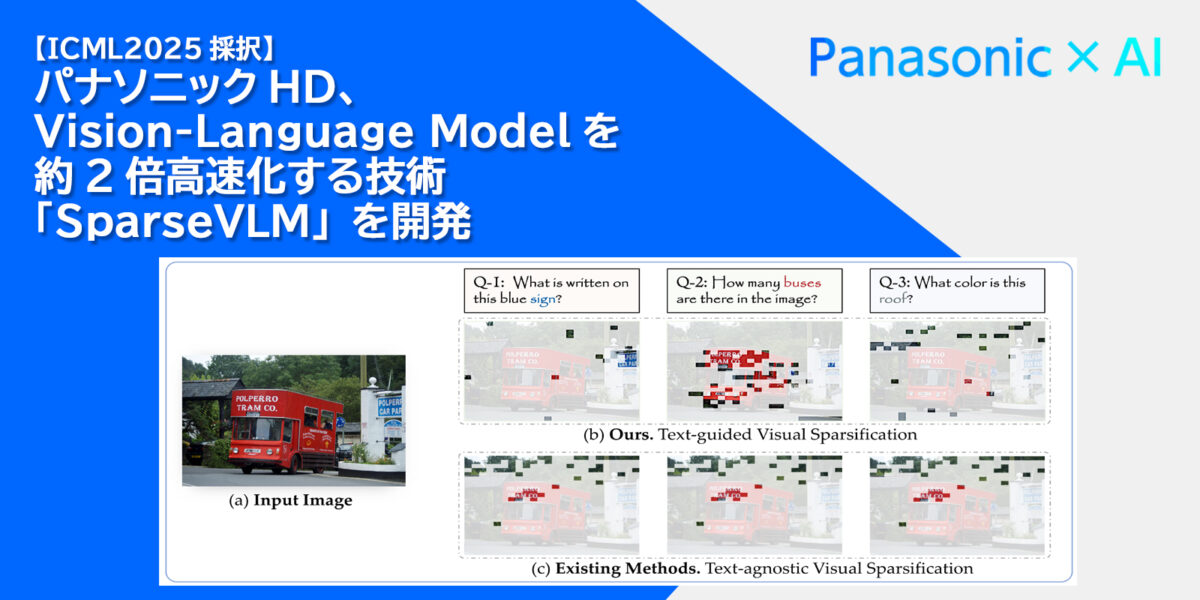

従来のVLM軽量化手法は画像のみから処理する視覚特徴を選択しており、入力したテキスト情報(プロンプト)との関係性を考慮せず軽量化を行うため、プロンプトに関連しない視覚特徴も処理しているという点で非効率的であり、改善の余地が残っていた。

「SparseVLM」は、入力したプロンプトに関連する視覚特徴のみを処理し、それ以外の特徴を削減(スパース化)するVLM軽量化手法を提案した。

具体的には、プロンプトから入力した画像や映像に関連する単語を選択した上で、選択された単語に関連する視覚特徴のみを処理する仕組みを採用している。

この技術により、例えば「青い標識には何と書いているか?」という質問に対して、画像中の右上の標識の領域に注目して回答するなど、入力したプロンプトに応じて回答に必要な視覚特徴のみを選択して効率的に処理することが可能となった。

ほとんどの既存手法は、軽量化するためにデータセットを準備して追加で学習することが必要であるのに対し、提案手法は追加の学習不要で軽量化可能であることも大きなメリットとなっている。

評価実験では、8種の画像に対する質問応答ベンチマークにおける性能を既存手法と比較した結果、軽量化前のモデルに対して平均89.3%の精度を維持しつつ、48.3%の高速化および71.9%の演算量抑制を達成し、既存手法に対する優位性が確認できた。

本技術は、先進性が国際的に認められ、AI・機械学習技術のトップカンファレンスであるThe 42nd International Conference on Machine Learning(ICML 2025)に採択され、2025年7月13日から2025年7月19日までカナダ バンクーバーで開催される本会議で発表される予定である。

今回開発した「SparseVLM」は、従来のVLM軽量化手法では考慮されていなかった入力プロンプトを考慮することで、質問応答精度を保ちながら処理速度を約2倍に高速化する技術である。

ユーザの状態や周辺環境を視覚情報から高速に認識し、言語化することが求められる多くの分野での活用が期待できる。

パナソニックHDは、今後もAIの社会実装を加速し、お客様のくらしやしごとの現場へのお役立ちに貢献するAI技術の研究・開発を推進していく方針を示している。

AI Market の見解

パナソニックHDが開発したSparseVLMは、VLMの軽量化技術において重要な技術的進歩を示している。

従来のスパース化技術がプロンプトとの関連性を考慮せずに視覚特徴を削減していたのに対し、本技術はプロンプトに関連する視覚特徴のみを処理する点で技術的優位性を持つ。追加学習が不要である点も実用性の観点から評価できる。

約2倍の処理速度向上と89.3%の精度維持という性能は、リアルタイム処理が要求される産業用途や消費者向けデバイスにおいて大きな価値を提供すると想定される。

特に、スマートホーム機器、監視システム、自動運転車載システムなど、エッジコンピューティング環境でのAI処理需要が高まる中、計算資源の制約下でも高精度な視覚言語理解を実現できる本技術の市場価値は高いと想定される。

参照元:Panasonic

SparseVLMに関するよくある質問まとめ

- SparseVLMは既存のVLM軽量化技術と何が違うのか?

従来の手法は画像のみから処理する視覚特徴を選択していたが、SparseVLMは入力したプロンプトに関連する視覚特徴のみを処理する点が異なる。

これにより、プロンプトに関連しない視覚特徴の処理を避けることができ、より効率的な軽量化が可能になった。

- SparseVLMを実用化するために追加の学習は必要か?

既存のほとんどの軽量化手法は追加のデータセットを準備して学習が必要だが、SparseVLMは追加の学習不要で軽量化が可能である。

これにより、既存のVLMに対して直接適用でき、実用化のハードルが大幅に下がる。

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp