gpt-ossとは?オープンソースLLMの特徴やできること、性能、料金、使うには?、活用事例まで徹底解説!

最終更新日:2025年08月20日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

- OpenAIが推論特化型のMoEモデル「gpt-oss」を無償公開し、開発や研究用途での幅広い活用が可能に

- Apache 2.0ライセンスの下で商用利用も含めた自由な再利用やファインチューニングが認められている

- ツール呼び出しや推論深度の調整、Structured Output出力など多機能なエージェント向け設計を採用

gpt-ossは、ChatGPTを提供するOpenAIが2025年8月に提供を開始したオープンウェイトのLLM(大規模言語モデル)で、推論性能、安全性、展開の柔軟性に優れています。

Apache 2.0ライセンスのもと、商用利用を含む幅広い用途に無償で対応し、研究機関から個人開発者まで多様なユーザーが活用可能です。

また、モデルのバリエーションも豊富で、軽量なものからマルチモーダル対応モデルまで揃っており、用途やリソースに応じて最適な構成を選べる点も魅力です。

この記事では、gpt-ossとは何かという基本から、特徴・できること、性能、料金、使うには、活用事例までを解説します。導入を検討している方に役立つ内容となっていますので最後までご覧ください。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

「gpt-oss」を発表して数日もたたないうちに、OpenAIは待望のGPT-5で世界に衝撃をもたらしました。2025年8月はライバルのAnthropicがClaude 4.1を発表していますので、生成AIウォッチャーにとっては気が休まる暇がないのではないでしょうか?

LLMに強いAI会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

目次

gpt-ossとは?

We released two open-weight reasoning models—gpt-oss-120b and gpt-oss-20b—under an Apache 2.0 license.

Developed with open-source community feedback, these models deliver meaningful advancements in both reasoning capabilities & safety.https://t.co/PdKHqDqCPf

— OpenAI (@OpenAI) August 5, 2025

gpt-ossは、OpenAIが開発したMixture-of-Experts(MoE)型のオープンウェイトLLM(大規模言語モデル)です。ChatGPTからモデル選択して使用するのではなく、Hugging Face等から無料でモデルをダウンロードして、ローカルで環境を構築して利用します。

OpenAIにとっては2019年のGPT-2以来となるオープンウェイトLLMのリリースです。誰でもモデルの重み(ウェイト)をダウンロードできます。

そして、自社のサーバーやローカル環境で自由に実行、改変、再配布できます。Apache 2.0ライセンスのもとで公開されているので、商用利用も可能です。

gpt-ossは2つのモデルサイズ

gpt-oss-120bとgpt-oss-20bの2つが提供されており、それぞれ36層・24層構造、最大128エキスパート構成で設計されています。

- gpt-oss-120b: 1200億パラメータを持つ、より高性能なモデル。

- gpt-oss-20b: 200億パラメータのSLM(小規模言語モデル)で、一般的なGPUやノートPC、スマートフォンでも動作するように設計されています。

用途としては、推論重視のAIアプリケーションやエンタープライズ向けシステム、オンデバイス推論などが想定されています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

gpt-ossの特徴・できること

gpt-ossは、多様な用途に柔軟に対応できます。

カスタマイズと拡張性

Apache 2.0ライセンスの下、ユーザーはgpt-ossモデルを自由にファインチューニングし、独自のアプリケーションや研究開発に適用できます。

ファインチューニングに必要なモデルウェイトやトークナイザーもHugging Faceで公開されており、ローカル環境や主要クラウドプラットフォームを問わず容易に展開できます。

また、Windows環境向けにはONNX対応の最適化モデルも提供されています。

長文処理に適した128kコンテキスト

両モデルは128,000トークンまでの長文コンテキストに対応しており、文書要約や長編チャットなどにも対応可能です。

また、位置エンコーディングにはRoPE(Rotary Positional Embedding)が使用され、長文における文脈保持の精度が向上しています。

ワークフローへの統合

gpt-ossは、以下のような機能を活用することで、ツールやエージェントシステムと組み合わせた自律的なワークフローにも対応できます。

- Web検索やPythonコードの実行など、外部ツールの呼び出しに対応

- JSON形式などのStructured Outputを生成可能

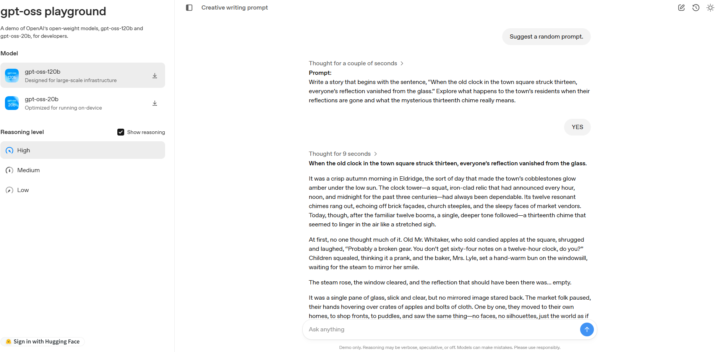

- reasoning_effortの設定によって推論の深さを調整

- Chain-of-Thought(思考の連鎖)による段階的な推論が可能

優れた推論力とスケーラビリティ

gpt-ossは、標準・中・高の3段階で推論レベル(reasoning effort)を制御でき、Chain-of-Thought(CoT)を効果的に活用して複雑な問題にも段階的に対応します。例えば、単純なタスクでは計算量を抑え、複雑な問題にはより深く思考させるといった制御が可能です。

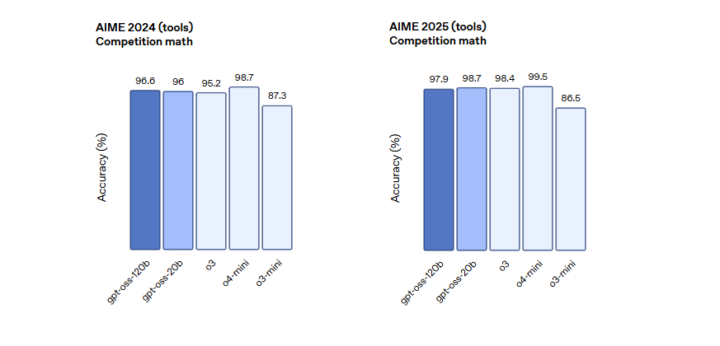

高精度のAIMEベンチマークやGPQAでの成績は、OpenAI o3-miniを上回り、o4-miniに匹敵する水準です。

Mixture-of-Experts (MoE)による効率性と展開性

gpt-ossモデルは、一般的なハードウェア環境でも実行可能なように最適化されており、gpt-oss-20bは16GBのGPUで、gpt-oss-120bは80GBのGPUで動作します。

これは他の同規模モデルと比較して非常に効率的で、推論性能を損なうことなく低リソース環境での活用を可能にしています。

また、Mixture-of-Expertsの設計により、入力に応じたパラメータのみを活性化することで、推論時の計算コストを抑えつつ性能を最大化しています。Mixture-of-Experts (MoE)は、複数の専門家(エキスパート)ネットワークの中から、入力に応じて最適なものを選択して処理する技術です。

これにより、モデル全体のパラメータ数は大きいながらも、推論時に実際に動作するアクティブなパラメータ数を抑え、計算コストを削減します。

- gpt-oss-120b: アクティブパラメータ 51億

- gpt-oss-20b: アクティブパラメータ 36億

学習と評価プロセス

gpt-ossは、CBRN(化学・生物・放射線・核)に関連する高リスクデータを学習から除外し、事後学習では熟慮的アライメントやプロンプト拒否技術を導入することで、安全性を重視したモデル挙動を実現しています。

さらに、悪意あるファインチューニングへの耐性を確認するための独立評価も実施され、攻撃シナリオ下での健全性が検証されています。

参考:gpt-oss-120b & gpt-oss-20b Model Card

gpt-ossの性能

以下の表は、gpt-ossシリーズおよびOpenChatシリーズのモデル(120b/20b/o4-mini/o3/o3-mini)を対象に、7つのベンチマークで性能を比較した結果をまとめたものです。

| 評価項目 | gpt-oss-120b | gpt-oss-20b | o4-mini | o3 | o3-mini |

|---|---|---|---|---|---|

| AIME 2024(競技数学) | 96.6% | 96.0% | 98.7% | 95.2% | 87.3% |

| AIME 2025(競技数学) | 97.9% | 98.7% | 99.5% | 98.4% | 86.5% |

| GPQA Diamond(PhD科学) | 80.1% | 71.5% | 81.4% | 83.3% | 77% |

| MMLU(一般知識) | 90% | 85.3% | 93% | 93.4% | 87% |

| Tau-Bench(ツール使用) | 67.8% | 54.8% | 65.6% | 70.4% | – |

| HealthBench(標準) | 57.6% | 42.5% | 50.1% | 59.8% | 37.8% |

| HealthBench Hard | 30% | 10.8% | 17.5% | 31.6% | 4% |

gpt-oss-120bは、複数のベンチマークにおいてOpenAIのo4-miniと同等またはそれ以上のスコアを記録しており、特にHealthBench HardやMMLUなどの推論系タスクで高いパフォーマンスを示しました。

gpt-oss-20bはSML(小規模言語モデル)ながら、競技数学分野では120bに匹敵する精度を達成し、軽量な推論モデルとして評価されています。基本的には、o3-mini と同等クラスの性能を発揮し、コストパフォーマンスに優れています。

参考:gpt-oss が登場

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

gpt-ossを使うには?

gpt-ossは、Playgroundによる試用、ローカル実行、クラウドサービス連携など、さまざまな方法で使用可能です。以下に、主な利用方法について説明します。

gpt-oss Playgroundでモデルを試す

gpt-ossを実際に試してみたい場合は、「gpt-oss Playground」にアクセスすることで、ブラウザ上で手軽にモデルを体験できます。

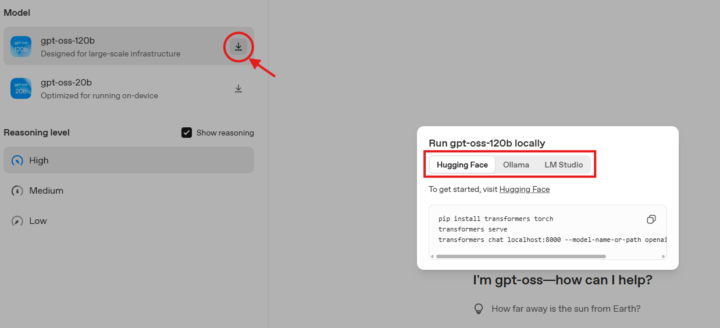

ローカルGPUでの実行

モデルのウェイトとトークナイザーはHugging Faceからダウンロード可能で、PyTorchやApple Metal向けのリファレンス実装はGitHub上で公開されています。

また、ローカル環境にダウンロードすれば、インターネットに接続しない状態でも推論を実行でき、セキュリティ要件の高い用途や、プライバシー重視のユースケースに適しています。

注意点として、ローカル環境でモデルを実行する場合は高いスペックが必要で、GPUを搭載しているPCで実行することが推奨されます。

クラウド・外部サービスでの利用

gpt-ossは、さまざまなサードパーティのAI推論基盤やツールを通じて利用可能です。事前構築された環境でAPIを介して呼び出すことができ、クラウド・ローカル問わず柔軟な開発が行えます。

- Together AI

- Fireworks

- Baseten

- Databricks

- Azure / AWS などのクラウド環境

- OpenRouter

- LM Studio

- Foundry Local

- Ollama

- VS Code用AIツールキット

主要なAI推論プロバイダーがgpt-ossをサポートしています。これらのサービスを使えば、APIキーを設定するだけで、Webブラウザからすぐにモデルを実行できます。

Hugging FaceのInference Providersでの利用

gpt-ossモデルは、Hugging FaceのInference Providers上でOpenAI互換のChat Completions APIまたはResponses APIを通じて利用できます。この方法の場合、ローカルでモデルを動かす場合とは異なり、PCに高いスペックは要求されません。

利用する場合は、まずHugging Faceの設定ページでトークンを取得します。

以下のコマンドをターミナルで実行し環境変数に設定します。your_token_hereには取得したトークンを入力してください。

export HF_TOKEN="your_token_here"次に、OpenAI公式SDKをインストールします。以下のコマンドを実行して下さい。

pip install openai最後に、以下のコードを入力したpythonファイルを実行します。

import os

from openai import OpenAI

client = OpenAI(

base_url="https://router.huggingface.co/v1",

api_key=os.getenv("HF_TOKEN"),

)

response = client.chat.completions.create(

model="openai/gpt-oss-120b:cerebras",

messages=[{"role": "user", "content": "Tell me a fun fact about the Eiffel Tower."}],

)

print(response.choices[0].message.content)今回は「エッフェル塔の面白い事実について教えて(Tell me a fun fact about the Eiffel Tower.)」というプロンプトになっているため、その回答がコマンドラインに出力されます。

さらに詳しい情報は公式のドキュメントをご参照ください。

gpt-ossの活用事例

以下に、X(旧Twitter)などで報告されているgpt-ossの活用例を紹介します。

Macローカルでgpt-oss-120Bを単体実行

Mac m4 max 64GBローカルだけででopenai/gpt-oss-120B動いた〜〜〜🔥🔥🔥

120Bですよ〜これはすごい嬉しいし、ローカルとは思えない賢さ!💡「モデルをメモリに保持」をオフにするのがミソです!🙌o-kenさん( @tamanimitel )マジ気づいてくれてありがとうございます〜ホームランすぎました!⚾️✨… pic.twitter.com/nA10W6wjpT

— あきらパパ【生成AI活用エンジニア&3児のパパ】 (@akira_papa_IT) August 5, 2025

Threadripper搭載PCでのローカル推論実行

OpenAIのgpt-oss:120bをThreadripper 7980X、メインメモリ384GBのローカルマシンで動かすとこれくらいの速度 pic.twitter.com/KuMupBLmYH

— Rui Ueyama (@rui314) August 6, 2025

他にも、以下のような活用が可能です。

開発者向けローカルコーディング補助

gpt-oss-20bは、16GBメモリでも動作するため、Windows上のFoundry LocalやVS Codeと連携し、コーディング補助やローカル検証用AIとして活用されています。

オンプレミスでの医療データ活用

AI Swedenなどの事例では、プライバシーの懸念がある医療分野において、gpt-ossをオンプレミスで運用し、外部接続なしでの自然言語応答システムを構築しています。

企業のカスタムAIワークフロー

OrangeやSnowflakeは、独自ドメインに特化したgpt-ossのファインチューニングとシステム組み込みを行い、社内ナレッジ検索やツール連携エージェントを構築しています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

gpt-ossに関するよくある質問まとめ

- 商用利用は本当に無料ですか?

はい。gpt-ossはApache 2.0ライセンスで提供されており、商用利用を含むあらゆる用途で無料で使用可能です。

- モデルはどこからダウンロードできますか?

モデルのウェイトとトークナイザーはHugging Faceで公開されており、GitHub上にはPyTorchおよびApple Metal向けの実装も用意されています。

まとめ

gpt-ossは、強力な推論性能・ツール統合機能・多言語対応・安全性配慮を兼ね備えたオープンウェイトモデルとして、実用的なAI構築を支援します。

gpt-oss-120bは大規模業務向けに、gpt-oss-20bは軽量かつ高速展開向けに適しており、幅広いユースケースに対応可能です。Apache 2.0ライセンスのもと、無償かつ柔軟に導入できる点も大きな魅力です。

LLMに強いAI会社をご自分で選びたい場合はこちらで特集していますので併せてご覧ください。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp