Mixture of Experts(MoE)とは?得意分野・採用モデル・メリット・課題を徹底紹介!

MoEは複数の「専門家モデル」と「ルーター」を組み合わせたAIアーキテクチャで、必要な専門家のみを動かす「スパース活性化」により大規模モデルでありながら高い計算...

生成AI、画像認識、AI開発企業等のAI会社マッチング支援サービス

MoEは複数の「専門家モデル」と「ルーター」を組み合わせたAIアーキテクチャで、必要な専門家のみを動かす「スパース活性化」により大規模モデルでありながら高い計算...

近年、LLM(大規模言語モデル)は数学、プログラミング、論理推論といった高度なタスクにも対応できるほど精度が向上し、汎用的なAIシステムとして急速に進化していま...

Grok 3はxAIが開発した大規模言語モデルで、数学、コーディング、一般知識、命令理解など、あらゆるタスクで高性能を発揮。 Thinkモードによる高度な推論、...

OpenAIのGPTシリーズに匹敵する性能を持つLLMでありながら、オープンソースであり、API利用料金も低く抑えられ、2025年前半の大きな話題となった「De...

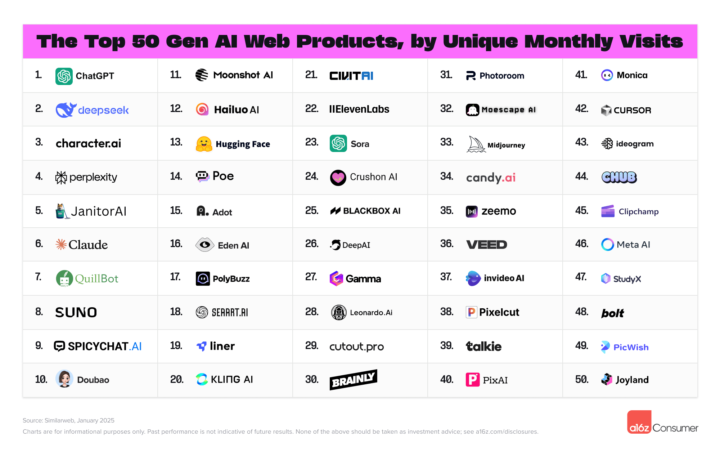

米国を代表するVCであるAndreessen Horowitz(略称:a16z)は、2025年3月6日(現地時間)に生成AIコンシューマーアプリTOP100ラン...