Meta V-JEPA 2とは?動画から物理世界を理解する世界モデルの仕組み、メリット、ロボティクスでの応用を徹底解説!

最終更新日:2025年10月15日

- V-JEPA 2は、映像の見た目(ピクセル)の予測ではなく、物理法則という世界のルールを抽象的に学習

- 膨大な動画から自律的に学習し、ロボットの行動データを学ぶ二段階プロセスにより未知の状況にも対応できる実践的な予測能力

- ロボットの自律性を飛躍的に高めるため、製造・物流現場の自動化(ファクトリーオートメーション)を大きく前進させる

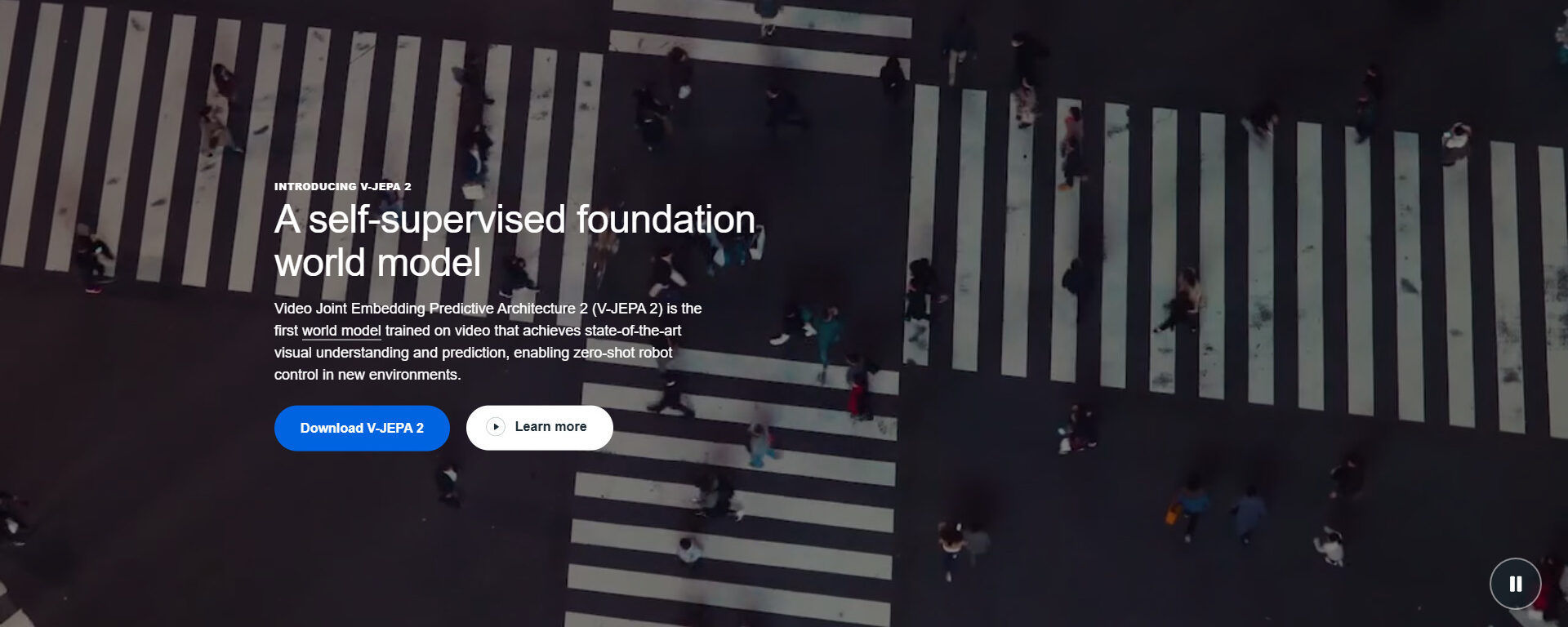

Meta社が2025年6月に発表したV-JEPA 2は、単に映像を認識するだけでなく、物理世界の法則を理解し「次に何が起こるか」を予測する能力を持つ世界モデルです。

本記事では、V-JEPA 2が未知の状況にも対応できる学習の仕組みから、ファクトリーオートメーションやデジタルツインといった具体的なロボティクス分野での応用例までを専門家が解説します。

ロボティクスに強いAI会社の選定・紹介を行います 今年度AI相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 ロボティクスに強いAI会社選定を依頼

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

目次

Meta社が発表したV-JEPA 2とは?

Meta社が発表したV-JEPA 2(Video Joint Embedding Predictive Architecture2)とは、動画学習で物理世界を理解し、将来の事象を推論できる能力を持つ世界モデルです。V-JEPAという概念は、映像を抽象的な数値の埋め込みに変換し、その抽象空間で予測を行うというものです。

従来の多くの動画関連AIは、動画の次のフレームをピクセル単位で予測・生成することを目指してきました。しかし、必ずしも映像の「意味」を理解しているわけではありませんでした。

V-JEPA 2の根幹をなすJEPA(Joint Embedding Predictive Architecture)というアーキテクチャは、具体的な映像(ピクセル)そのものではなく、背後にある抽象的な情報を予測します。

V-JEPA 2の主要コンポーネント

V-JEPA 2の中核には、エンコーダとプレディクタと呼ばれる2つの主要コンポーネントがあります。

- エンコーダ:動画や画像の情報を抽象的なベクトル表現に変換する

- プレディクタ:エンコーダで変換されたベクトルから未来や隠された情報を予測する

この技術的構造は、人間が見えない部分を想像するという認知プロセスに近く、より汎用的な世界理解を可能にします。

さらにMeta社は、V-JEPA 2の性能を客観的に測るために物理推論ベンチマークを公開しており、物理世界を理解するモデルとしての優位性を示しました。V-JEPA 2は単なる映像解析モデルではなく、物理世界を理解し行動に結びつける基盤として設計されているのです。

Metaが公開したAIの物理推論能力を評価するベンチマーク

Meta社はV-JEPA 2の研究成果を裏付けるために、物理世界の理解力を測定するベンチマークを公開しています。これらのベンチマークは、物体の動きや因果関係をどれだけ理解しているかを検証する設計となっています。

ベンチマークは以下の3つです。

| ベンチマーク | 評価対象 | タスク例 | 特徴 |

|---|---|---|---|

| IntPhys | 直感的理解 (物理的に可能か不可能か) |

| 赤ちゃんが持つようなコアな物理知識を備えているかを定性的に測定する |

| MVPBench | 予測的理解 (次にどう動くか) |

| スポーツ選手のような運動予測能力を持っているかを定量的に評価する |

| CausalVQA | 論理的理解 (なぜそうなったか) |

| 大人が持つような論理的説明能力を持っているか |

これらのベンチマークは、従来の視覚モデルが得意としてきた分類や検出を超え、世界のルールを理解し因果的に推論する力を測ります。従来の視覚モデルはラベル予測に強みを持っていましたが、V-JEPA 2は因果関係を捉える能力によって優位性を発揮しました。

ロボティクスに強いAI会社の選定・紹介を行います 今年度AI相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 ロボティクスに強いAI会社選定を依頼

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

V-JEPA 2の学習プロセス

V-JEPA 2では、二段階の学習プロセスが採用されています。

第一段階:100万時間を超える動画データと100万枚の画像を用いた自己教師あり学習

V-JEPA 2は、特定の指示や正解ラベルが与えられていない、インターネット上の膨大な動画データ(100万時間以上)を「自己教師あり学習(Self-Supervised Learning)」することで、物理世界の仕組みを自ら学んでいきます。

これは、AIに特定のタスクを教え込むのではなく、大量の事例を見せることで、AI自身にデータ背後にあるパターンや構造を発見させる手法です。これにより、人間が明示的に教えることが難しい「常識」や「物理法則」を、AIが自律的に獲得することが期待されます。

詳細なプロセスは、以下の4つです。

- マスキング

- エンコード

- 予測

- 比較と学習

それぞれの学習プロセスについて解説します。

マスキング

V-JEPA 2におけるマスキングでは、動画の一部を意図的に隠すことでモデルが欠けている部分をどのように補完できるかを学習します。

ここで重要なのは、隠す対象が空間的にも時間的にも多様である点です。画面内の特定の領域を隠す場合もあれば、数フレーム先の未来の映像を隠すケースもあります。

このようにランダムなパターンでマスキングを行うことで、V-JEPA 2は抽象的かつ因果的な理解を獲得していきます。結果として、視覚的な欠損情報を推測する力を備えることが可能です。

エンコード

エンコードでは、マスクされていない部分の動画をエンコーダに通してベクトルデータに変換します。

入力データのピクセル情報をそのまま処理するのではなく、以下のような本質的な特徴を抽出し、入力されたデータ(動画の一部)を「潜在空間」と呼ばれる抽象的な情報空間にマッピング(エンベディング)します。

- 物体の形状

- 位置関係

- 動きのパターン

これにより、JEPAは、潜在空間内で隠された部分の情報を予測して、物理世界を理解するための基盤表現を獲得できるのです。

このように、空間的特徴と時間的特徴の両方を捉える工程があることで、どのような動きや変化が起こり得るかを合理的に推測できる基盤が整います。

予測

エンコードによって得られた抽象表現を基盤に、V-JEPA 2はマスクされた部分を推測するプロセスに移ります。この予測では、既知の情報(マスクされていない映像部分の表現)を手掛かりに、隠された領域がどのような抽象表現を持つべきかを推定します。

ここで用いられるのがプレディクタで、エンコーダが生成したベクトルをもとに未来や欠損部分の特徴を仮想空間で再構築していきます。

この予測プロセスは、人間の直感的な想像力に近いといえます。画面の外に消えたボールがどこに現れるのか、物体同士が衝突した後にどうなるのかといった因果的推論を人間が想像して予測するように、モデルも内部的にシミュレーションすることが可能です。

比較と学習

予測によって生成された抽象表現は、そのままでは正確性を保証できません。そのため、実際にマスクされていた部分を、エンコーダに通して得られる正解の抽象表現とプレディクタが推測した結果を比較します。

この比較プロセスを通じて両者の差異を測定し、その誤差を最小化するように学習が進められます。いわば、モデルが自らの推論を訂正し、物理世界への理解を洗練させていくのです。

この学習サイクルは繰り返し実行されることで、モデルは一般化された因果的理解を獲得していきます。結果として、部分的な情報から全体像を推定する力が強化され、未知の映像や複雑な状況にも適応できる柔軟性を身につけることが可能です。

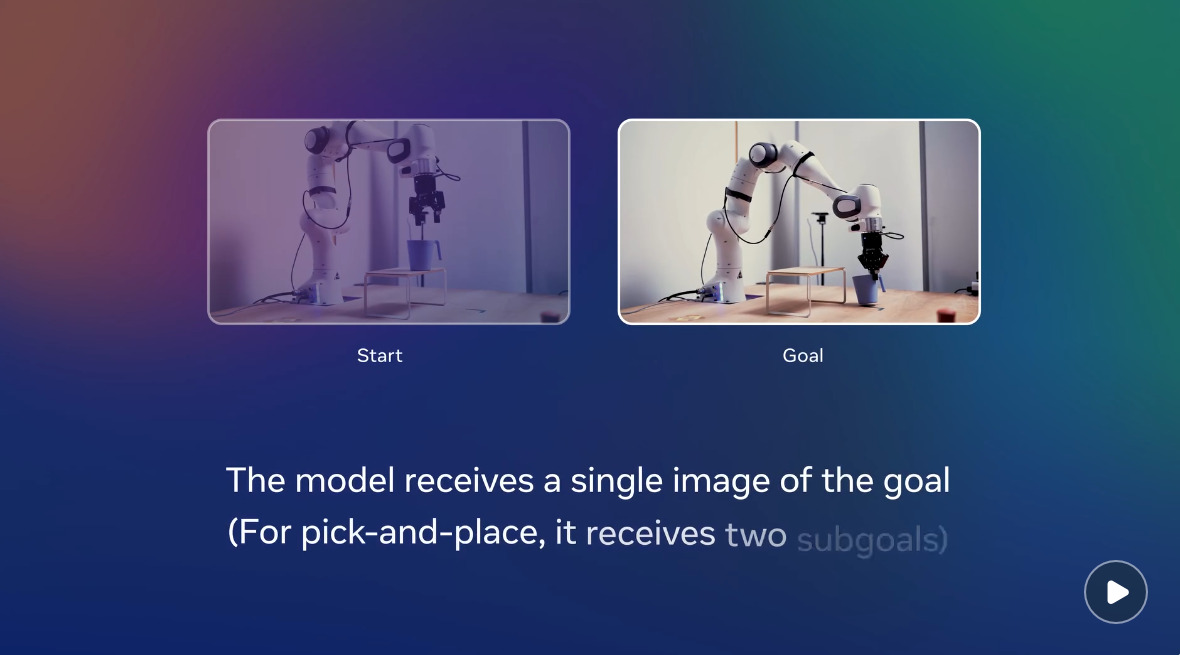

第二段階:62時間のロボットデータを用いた行動条件付き学習

第一段階の学習が完了したら、抽象的な世界理解を実際の行動へと結びつけるために、62時間分のロボット実験データを用いた第二段階へと進みます。

この段階では、自己教師あり学習で獲得した物理世界のルールを、具体的なタスク実行に応用できるようにすることが目的です。

行動条件付き学習では、ロボットが実際に行った動作とその結果の映像データを組み合わせ、どの行動がどの結果につながるかをモデルに学ばせます。これにより、モデルは行動の因果性を理解し、結果を見越した判断ができるシステムへと進化します。

この第二段階を経ることで、V-JEPA 2は現実のロボティクス分野に直結する能力を獲得します。これは環境に応じたアクションを選択できる知能を備えている状態を意味し、実世界での応用力が飛躍的に高まります。

V-JEPA 2の特徴・メリット

V-JEPA 2は、汎用的な世界理解と行動推論を実現できる能力があり、さまざまな特徴やメリットがあります。

LLMでの動画データ学習との違い

V-JEPA 2の学習が従来のLLM(大規模言語モデル)の動画データ学習と根本的に異なる点は、出力するまでのアプローチにあります。

LLMはテキストデータを前提に設計されており、動画を扱う場合もフレームを分解してピクセル単位で符号化し、その連続性を統計的に学習する手法が一般的です。そのため、より解像度を高めていくことが重視されており、本質的にはテキストとしての動画学習とも言えます。

しかしこの方法では、物体の運動や因果関係といった動画固有の情報が断片化され、時間的な一貫性や物理的ルールの把握に限界が生じてしまいます。

一方で、V-JEPA 2は動画の一部をマスキングして隠し、残された情報から「本来どうあるべきか」を予測する仕組みになっています。これにより、物体がどのように動き、何が起こるかという因果的推論を学習することが可能です。

例えば、動画の中でボールが障害物の後ろに隠れた場合、ピクセルを予測するモデルは「障害物の後ろにあるであろうボールの見た目」を生成しようとします。一方、V-JEPA 2は「そこにはボールが存在し、次はこちら側に出てくるだろう」という概念的な情報を予測します。

つまり、V-JEPA 2は抽象的な空間を予測します。アプローチの対象がテキストか動きかという点で従来のLLMとV-JEPA 2は根本的な違いがあります。

関連記事:「世界モデルとLLMの違いは?定義・ベース技術・活用シーンの比較や相互補完する関係性を徹底解説!」

汎用的な世界理解が可能になる

V-JEPA 2の最大の特徴は汎用的な世界理解を実現できる点です。膨大な映像から物理法則や因果関係を獲得しているため、未学習の状況でも対応できます。

例えば、物体が隠れた後に再び出現する位置を推測したり、障害物の挙動を予測したりする能力は学習データに含まれていない環境下でも発揮されます。これは人間が過去の経験を基に新しい出来事を理解する仕組みに近いです。

この汎用的な理解力があるからこそ、V-JEPA 2は映像解析ツールにとどまらず、予測というプロセスを可能にしているのです。

ゼロショット転移によるデータ収集の大幅な効率化

V-JEPA 2のもう一つの特徴は、ゼロショット転移によって新しいタスクに対応できる点です。自己教師あり学習で培った世界の因果関係や物理的ルールを基盤として持っているため、未知の状況でも追加データなしで応用できます。

これにより、ロボティクス分野における開発コストや学習時間を大幅に削減でき、実装スピードを格段に高めることができます。

ゼロショット転移についてはこちらの記事も参考にしてみてください。

オープンソース化

Meta社はこれまでもAI研究の成果を公開してきましたが、V-JEPA 2に関しても2025年6月の発表と同時に、研究者や開発者が利用できるようモデルと学習用のコードがGitHubで公開されています。

オープン化により、世界中の研究者が追試や改良を行えるため、技術の発展が加速することが期待されています。

実用化が目指せる12億パラメータ

V-JEPA 2は約12億パラメータの規模で設計されており、これは実用化を目指せるスケールとなっています。近年のAIモデルはパラメータが圧倒的に多い巨大モデルが主流です。

しかし、その分学習コストや推論負荷が膨大になり、現場での導入にハードルとなっているケースが見られます。

一方、12億パラメータという規模感は、十分な表現力を確保しつつも、企業や研究機関が利用できる計算資源で動作可能なサイズと言えます。そのため、研究開発用途だけでなく、産業分野での応用においても運用は現実的です。

また、モデルの学習やファインチューニングに必要なコストも軽減され、幅広い企業が利用しやすくなります。このように、V-JEPA 2は実装を見据えた軽量化を実現している点で大きな意義があります。

ロボティクスに強いAI会社の選定・紹介を行います 今年度AI相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 ロボティクスに強いAI会社選定を依頼

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

ロボティクス分野で期待されるV-JEPA 2の応用

V-JEPA 2は特に、ロボティクス分野での応用が期待されています。

物体操作

物体同士の相互作用や物理的制約を理解できる点で、V-JEPA 2はロボットの物体操作タスクに強みを発揮します。「物体は押すと動く」「持ち上げれば重力で落下する」といった普遍的な物理ルールを基盤にしているため、一貫性のない物体管理や不規則な環境でも適応が可能です。

具体的な応用例としては、製造現場での部品組み立てや物流倉庫でのピッキング作業が挙げられます。形状が異なる物体を扱う場合でも、ゼロショット転移によって追加学習なしで対応できる点は大きなメリットです。

ナビゲーション

時間的な変化と空間的な因果関係を同時に理解することで、V-JEPA 2はロボットのナビゲーション能力を大幅に向上させることが可能です。自己教師あり学習で得た世界理解を活用し、状況に応じて物体や人がどう動くかを因果的に推論できます。

これによって、動的な環境においても、衝突を避けつつ効率的な経路を選択することが可能です。倉庫内での自律搬送ロボットや工場内でのAGV(無人搬送車)においては、混雑した環境でもスムーズに移動できるようナビゲートします。

監視・異常検知

V-JEPA 2は監視や異常検知の領域でも役立ちます。物体や人物が本来どう動くべきかという物理的・因果的な予測を基準に検知できます。

そのため、設備異常の早期検出、公共施設でのセキュリティ監視、さらにはインフラ点検の自動化に直結します。

工場ラインでの機械部品の挙動が通常と異なる場合や監視カメラ映像で人があり得ない動きをした場合でも、追加学習を行わず異常として判断可能です。

デジタルツイン

V-JEPA 2による現実世界の因果関係の抽象化によって、デジタルツインの精度向上に貢献します。見えていない部分を推測する技術によって、センサーで取得できない情報や将来的な環境変化を高精度に補完できます。

例えば、工場のライン設備における部品の摩耗進行を予測したり、都市インフラの利用状況をシミュレーションしたりといった応用が可能です。

さらに、ロボット操作や物流システムと統合することで現実と仮想空間をシームレスに結び付け、リアルタイムでの最適化やリスク検知を実現できます。

ファクトリーオートメーション

初めて見る物体や状況であっても、ロボットが「どう動かせば良いか」を自律的に判断できるようになります。これにより、従来のプログラムされた動きしかできなかった産業用ロボットが、より複雑で変化の多い環境(例:物流倉庫でのピッキング、家庭での手伝い)で活躍するファクトリーオートメーションへの道が拓けます。

V-JEPA 2の今後の展望

V-JEPA 2は、現状でも高い物理推論能力を示していますが、可能性はさらに広がっていくでしょう。ここからは、今後の発展に向けた展望を解説します。

階層的なモデル拡張

V-JEPA 2の今後の展望として注目されるのが、階層的なモデル拡張です。現在のモデルは、動画から抽象表現を獲得し因果関係を理解する仕組みを持っていますが、さらに複数のレベルで知識を階層化することで、より高度な推論が可能になると考えられています。

- 低レベル:物体の動きや衝突といった物理的事象を扱う

- 中レベル:シーン全体の文脈やタスクの意図を理解する

- 高レベル:長期的な計画や行動戦略を導き出す

このような多層構造の学習によって、目の前で起こることの予測から、数分先・数時間先にどうなるかまでを見通せるモデルへと進化します。

この階層的拡張が実現すれば、ロボットが物体を操作するだけでなく、状況を把握しながら計画的に行動することが可能になります。AIは単なる「物理シミュレーター」から、目的志向の自律的AIエージェントへと進化します。

例えば、製造ラインでは、長期的な工程全体の最適化までを一貫して支援できるようになります。

マルチモーダル統合

V-JEPA 2の進化において欠かせないのがマルチモーダル統合です。現行モデルは主に映像や画像を中心に学習していますが、今後は音声、テキスト、センサー情報といったより多様なデータを統合することで包括的な物理世界の理解を目指します。

例えば、ロボットが作業を行う場面では、視覚情報だけでなく、モーターの振動音や環境センサーの温度データといった非視覚的要素も重要です。

V-JEPA 2のアーキテクチャは、これら異種の情報を共通の潜在空間で扱うように設計されているためマルチモーダル化との親和性が非常に高いのが特徴です。

人間の指示やマニュアルを理解した上で、視覚情報と照合しながら行動を決定することも可能です。

汎用人工知能(AGI)の基盤技術としての貢献

V-JEPA 2は、汎用人工知能(AGI)を実現する上での重要な布石と位置付けられます。

従来のAIは、特定のタスクに最適化された、いわゆる狭い知能に留まりがちでした。しかしV-JEPA 2は、物理世界を予測することで、未知の状況にも適応できる柔軟性を獲得します。

V-JEPA 2単体でAGIが実現するわけではありませんが、そのアーキテクチャや学習方法は、将来のAGIが備えるべき中核的な能力(推論、計画、世界の理解)の基盤となります。

これは、人間のように経験をもとに学び、推論し、行動できる知能に近づく大きな一歩と言えるでしょう。つまり、V-JEPA 2は個別の応用を超えて、AGI実現のためのモデル構築に貢献する基盤技術になり得るのです。

ロボティクスに強いAI会社の選定・紹介を行います 今年度AI相談急増中!紹介実績1,000件超え! ・ご相談からご紹介まで完全無料 完全無料・最短1日でご紹介 ロボティクスに強いAI会社選定を依頼

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

V-JEPA 2についてよくある質問まとめ

- V-JEPA 2とは?

V-JEPA 2はMeta社が2025年に発表した最新の世界モデル(World Model)です。映像を通じて物理世界を理解し、因果関係を推論する能力を持ちます。

- V-JEPA 2はどのようにして世界を学習するのですか?

以下の二段階のプロセスで学習します。

- 自己教師あり学習

100万時間を超える膨大な動画データから、物理法則や因果関係といった普遍的なルールを自律的に学びます。 - 行動条件付き学習

ロボットの実際の行動データを用いて、学んだ知識を具体的なタスク実行能力へと結びつけます。

- 自己教師あり学習

- V-JEPA 2にはどのような特徴がありますか?

主に以下の5つの特徴・メリットがあります。

- 汎用的な世界理解: 未知の状況にも応用できる、柔軟な予測能力を持ちます。

- ゼロショット転移: 追加学習なしで新しいタスクに対応でき、データ収集を効率化します。

- オープンソース: モデルとコードが公開されており、誰でも研究・開発に利用できます。

- 実用的なパラメータ数: 約12億と、巨大モデルに比べて導入しやすい規模です。

- LLMとの違い: テキストベースではなく、物理的な動きや因果関係の予測に特化しています。

- V-JEPA 2はロボティクス分野でどのように応用できますか?

物理世界を理解する能力を活かし、以下のような応用が期待されています。

- 物体操作: 部品の組み立てや倉庫でのピッキング作業。

- ナビゲーション: 自律搬送ロボット(AGV)などが障害物を避けて効率的に移動。

- 監視・異常検知: 工場設備の異常な動きや、監視カメラでの不審行動を検知。

- デジタルツイン: 現実世界を高精度にシミュレーションし、未来を予測。

- ファクトリーオートメーション: より複雑で変化の多い環境でのロボットによる自動化。

まとめ

V-JEPA 2はMetaからリリースされた世界モデルで、抽象的な解釈によって物理世界を予測します。実業務での活用も期待されており、特にロボティクス分野では注目技術と言えます。

V-JEPA 2はこれからも進化していくため、いずれはオープンソース化やAGIの実現にも寄与するかもしれません。

一方で、こうした「世界モデル」を自社の事業に組み込むには、その特性を深く理解し、費用対効果を慎重に見極める専門的な知見が不可欠です。V-JEPA 2の活用可能性やAIによる現場課題の解決についてより具体的に検討されたい場合は、ぜひ一度、知見の豊富な専門家にご相談ください。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp