MetaがSAM 3を発表、テキストと画像プロンプトで動画内オブジェクトの検出・セグメンテーション・追跡を実現

最終更新日:2025年12月08日

記事監修者:AI Market ニュース配信チーム

Metaは2025年11月19日、画像と動画における物体の検出・セグメンテーション・追跡を統合したSegment Anything Model 3(SAM 3)を発表した。(SAM 3特集記事はこちら)

テキストや画像プロンプトによる柔軟な指定が可能で、従来システムと比較して約2倍の性能向上を達成し、モデルウェイトとベンチマークデータセットを公開した。

- テキストや画像プロンプトで任意の視覚概念を検出・セグメンテーション・追跡できる統合モデルを実現

- AIと人間の協働データエンジンにより400万以上の概念を含む大規模データセットを構築し学習を効率化

- Instagram「Edits」やFacebook Marketplaceの新機能に実装され、実用的なクリエイティブツールとして展開

SAM 3は、従来のセグメンテーションモデルが抱えていた固定ラベルセットの制約を解消し、自由なテキストフレーズや画像例示によるプロンプトを受け付ける。

「縞模様の赤い傘」のような詳細な概念指定が可能となり、SAM 1とSAM 2で導入されたマスク、ボックス、ポイントといった視覚的プロンプトとの併用もできる。

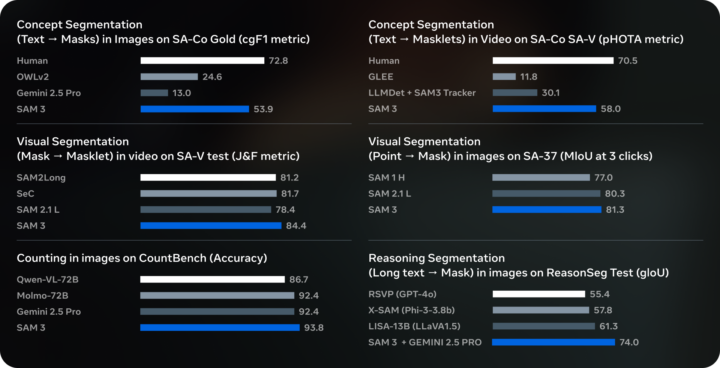

Metaが新たに構築したSA-Coベンチマークでの評価では、画像と動画の両方で既存システムの2倍のcgF1スコアを達成し、Gemini 2.5 ProやOWLv2などの専門モデルを上回る性能を示した。ユーザー調査では、最強ベースラインであるOWLv2と比較して約3対1の割合でSAM 3の出力が選好された。

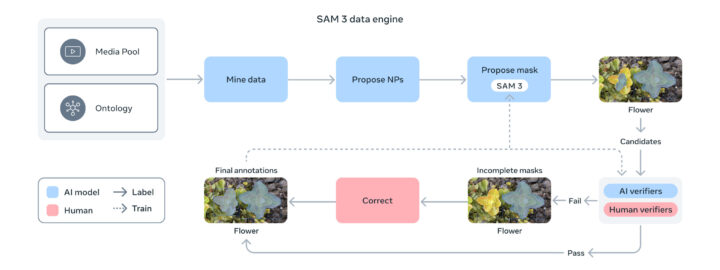

モデル開発における重要な課題は、高品質なアノテーションデータの大規模収集だった。Metaは、SAM 3とLlamaベースのキャプショニングシステム、人間アノテーターを組み合わせた新しいデータエンジンを構築した。

AIモデルが画像と動画からキャプションを自動生成し、テキストラベルに解析してセグメンテーションマスクの候補を作成する。人間とAIアノテーターがこれらを検証・修正することで、フィードバックループが形成される。

特にLlama 3.2vベースのAIアノテーターは人間と同等以上の精度でマスク品質の検証を行い、人間のみのパイプラインと比較して2倍以上のスループットを実現した。この仕組みにより、ネガティブプロンプトで約5倍、ポジティブプロンプトで36%の高速化を達成し、400万を超える独自概念を含む大規模データセットを構築した。

アーキテクチャ面では、MetaのMeta Perception Encoderをテキストと画像エンコーダーに採用し、DETRモデルをベースとした検出器、SAM 2のメモリバンクとメモリエンコーダーを基礎とした追跡コンポーネントを統合した。

H200 GPU上で単一画像あたり100以上のオブジェクトを30ミリ秒で処理し、動画では約5つのオブジェクトをほぼリアルタイムで追跡できる。

多モーダル大規模言語モデルと組み合わせたSAM 3 Agentは、「馬を制御し導くために使われる物体は何か」といった複雑なクエリにも対応し、ReasonSegやOmniLabelなどのベンチマークで先行研究を上回る性能を示した。

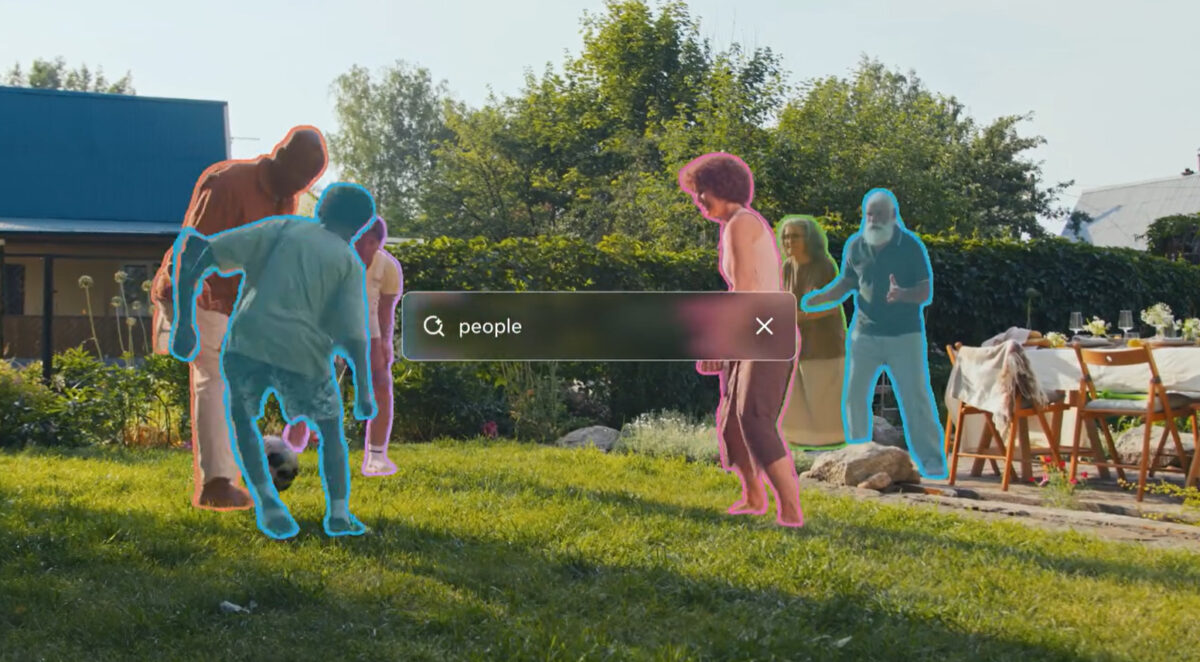

実用化面では、Instagram「Edits」アプリで動画内の特定の人物やオブジェクトにエフェクトを適用する新機能、Facebook Marketplaceの「View in Room」機能でのホームデコレーションアイテムの配置シミュレーションなどに活用される。

科学分野でもConservation X LabsおよびOsa Conservationと協力し、100種以上の動物を含む1万本以上のカメラトラップ動画からなるSA-FARIデータセットを公開した。

さらに、Segment Anything Playgroundという新プラットフォームを通じて、技術的専門知識なしに誰でもSAM 3を試せる環境を提供し、顔やナンバープレートのぼかし、スポットライトエフェクトなどのテンプレートを用意した。

AI Marketの見解

SAM 3は、コンピュータビジョンにおける基礎モデルの実用性を大きく前進させる技術と想定される。固定ラベルセットから解放されたプロンプタブル・コンセプト・セグメンテーションの実現は、ユーザーの多様な要求に柔軟に対応できることを意味し、汎用性の高いビジュアルAIツールとしての可能性を示している。

特筆すべきは、AIと人間の協働によるデータエンジンの設計で、人間の専門性とAIの処理速度を組み合わせることで、従来困難だった大規模かつ高品質なデータセット構築を実現した点だ。

この手法は他のドメインにも応用可能と想定される。ビジネス面では、既にMeta自社製品への統合が進んでおり、クリエイティブツールやEコマースでの具体的なユースケースが示されている。

モデルウェイトとベンチマークの公開により、コミュニティ主導の改善と新規アプリケーション開発が促進され、エンタープライズ領域や科学研究での採用拡大が期待できる。

ただし、医療や科学分野などドメイン特化概念へのゼロショット対応には限界があり、ファインチューニングが必要となる点は実装時の考慮事項となる。

参照元:Meta

SAM 3に関するよくある質問まとめ

- SAM 3は従来のセグメンテーションモデルと何が違うのか?

SAM 3は固定されたラベルセットに制約されず、自由なテキストフレーズや画像例示をプロンプトとして受け付けることができる。「人」のような一般的な概念だけでなく、「縞模様の赤い傘」といった詳細で稀な概念も認識可能だ。また、検出・セグメンテーション・追跡の機能を単一モデルに統合し、画像と動画の両方に対応している点も大きな違いとなる。

- SAM 3のモデルやデータセットは誰でも利用できるのか?

Metaはモデルウェイト、評価用のSA-Coベンチマークデータセット、ファインチューニング用コードを公開している。

Segment Anything Playgroundを通じて技術的専門知識がなくても試用でき、Roboflowとの提携により独自データでのアノテーション、ファインチューニング、デプロイも可能だ。野生動物監視用のSA-FARIデータセットも研究コミュニティに公開されている。

AI Market ニュース配信チームでは、AI Market がピックアップするAIや生成AIに関する業務提携、新技術発表など、編集部厳選のニュースコンテンツを配信しています。AIに関する最新の情報を収集したい方は、ぜひ𝕏(旧:Twitter)やYoutubeなど、他SNSアカウントもフォローしてください!

𝕏:@AIMarket_jp

Youtube:@aimarket_channel

TikTok:@aimarket_jp

過去のニュース一覧:ニュース一覧

ニュース記事について:ニュース記事制作方針

運営会社:BizTech株式会社

ニュース掲載に関するご意見・ご相談はこちら:ai-market-press@biz-t.jp