Llama Guardとは?モデルの種類から検知できるリスク・使い方・課題まで徹底解説!

最終更新日:2026年02月06日

記事監修者:森下 佳宏|BizTech株式会社 代表取締役

- Llama Guardは、生成AIの入出力をリアルタイムで分析し、不適切・有害なコンテンツを検知・制御することに特化したLLMベースのセーフティガードモデル

- 単なるキーワードの照合ではなく、文章全体の意図をセマンティック(意味論的)に解釈するため、「正当な議論」と「悪意ある攻撃」の判別が可能

- 8Bクラスの軽量モデルを監視役に据えることで、高価なメインモデルの計算リソースを浪費せずに安全性を担保できる

生成AIの業務活用が進む一方で、不適切な出力や法令・倫理面のリスクをどのように管理するかは、企業にとって避けて通れない課題となっています。特に、LLM(大規模言語モデル)を自社システムに組み込む場合、安全性をどのように担保するのかという観点は設計段階から明確にしておく必要があります。

こうした背景のもと注目されているのが、生成AIの入出力を文脈ごとに評価・分類するセーフティモデルであるLlama Guardです。

本記事では、Llama Guardの仕組みからモデルの種類、分類されるリスクカテゴリ、具体的な使い方を解説します。また、Llama Guardが持つ限界も提示し、導入すれば解決するわけではない点にも触れています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

AI開発会社をご自分で選びたい方はこちらで特集していますので併せてご覧ください。

目次

Llama Guardとは?

Llama Guardとは、生成AIが出力するコンテンツの安全性をリアルタイムで評価・制御するために開発されたLLM(大規模言語モデル)ベースのセーフティガードモデルです。生成AIが不適切・有害・違法と判断され得る内容を出力していないかを分類・検知する役割を担います。

通常のチャットAIが「回答を作る」のが仕事であるのに対し、Llama Guardは「その質問(プロンプト)は安全か?」「その回答は自社のポリシーに反していないか?」をチェックすることに特化しています。

MetaのLlama系モデルを前提とした設計思想を持っており、ユーザーとメインLLMの間に「検問所」として設置され、入力と出力をチェックします。

MetaがLlama Guardを開発した背景

LLMは高い表現力と汎用性を持つ一方で、設計次第では有害表現や不適切な助言、違法行為を助長する内容を生成してしまうリスクを内包しています。特に、企業利用や公共性の高い領域では経営リスクや法的リスクといった深刻な問題にも直結します。

Metaは、LlamaをはじめとするオープンなLLMエコシステムを推進する立場として、モデルの公開だけでなく、安全に使える前提条件を整備する必要性を認識していました。オープンソースモデルの場合、安全制御の責任は利用者側に委ねられます。

この安全制御のギャップを埋めるために登場したのが、LLM自身でリスクを分類・判断するための専用モデルであるLlama Guardです。Metaは、LLMの文脈理解を安全制御にも応用することで、より拡張性の高いアプローチを提示しようとしています。

Llama Guardモデルの種類

Llama Guardは単一のモデルではなく、生成AIを取り巻くリスクの高度化や運用要件の変化に対応するため、世代ごとに改良が重ねられています。MetaはLLaMA系モデルの進化に合わせてLlama Guardも段階的にアップデートしており、精度・カバレッジ・実運用への適合性が強化されています。

以下では、代表的なLlama Guard 2〜4の特徴を整理します。

| モデル | 概要 | 特徴 | 用途 |

|---|---|---|---|

| Llama Guard 2 | 実運用向けの初期成熟モデル | 明確に定義されたリスクカテゴリに基づく分類性能を強化 | プロンプト・出力の基本的な安全チェック |

| Llama Guard 3 | 高精度・高網羅性モデル | 複雑な文脈理解とリスク判定精度の向上 | 業務システムに組み込む本格運用 |

| Llama Guard 4 | 最新世代・拡張性重視 | ポリシー設計やカスタマイズを前提とした柔軟な構造 | 企業独自の基準や高度なガバナンス対応 |

LaMa Guard 2は、LLaMA系モデルと組み合わせて使うことで、従来のフィルタリングでは難しかった文脈依存のリスク判定を可能にしました。これにより、生成AIの業務利用における最低限の安全ラインを比較的低コストで実装できます。

一方、Llama Guard 3以降では、実際の運用フローを意識した設計が重視されています。曖昧な表現や境界ケースに対しても、より安定した判定が期待でき、誤検知や過剰ブロックの抑制につながります。

最新の世代であるLlama Guard 4は、企業ごとのポリシーや業界特有のルールを前提に、制御レイヤーとしての拡張性を意識して作られています。オープンソースである点は従来と同様ですが、自社要件に合わせて組み込むことを想定した位置づけが強まっています。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llama Guardとフィルタリングとの違い

| 比較項目 | 従来のフィルタリング(キーワード/正規表現) | Llama Guard(AIベースのガードレール) |

|---|---|---|

| 判断の仕組み | 特定の単語(NGワード)やパターンの照合 | LLMによるセマンティック(意味論的)な内容理解 |

| 文脈の解釈 | 不可 | 可能 |

| 回避手法への耐性 | 弱 | 強 |

| メンテナンス | 膨大な「NGワードリスト」の更新が永続的に必要 | 標準的な「安全カテゴリ」が学習済 必要に応じて微調整 |

| 多言語対応 | 言語ごとに辞書を作成・管理する必要 | モデル自体が多言語のニュアンスを理解 |

| 出力の制御 | 0か1(通すか、消すか)の二択 | 確率スコアに基づいた多段階の制御 |

| 処理負荷 | CPUのみで高速動作 | GPUリソースが必要 |

Llama Guardと従来のフィルタリングの違いは、判断の基準と理解の深さにあります。

一般的なフィルタリングは、特定のキーワード・正規表現・ルールセットに基づいてコンテンツを遮断・許可されます。実装が容易で処理も高速ですが、文脈や意図を十分に考慮できないという限界を抱えています。

例えば、特定の禁止語句が含まれているだけで無条件にブロックされるケースでは、正当な技術解説や学術的議論まで遮断してしまう可能性があります。一方で、言い換えや婉曲表現を用いた不適切な指示は単純なフィルタリングを容易にすり抜けてしまいます。

これに対してLlama Guardは、LLMによる文脈理解を用いて、コンテンツの意図や意味合いを分類する点が異なります。単語単位ではなく文章全体を入力として受け取り、攻撃的表現なのか、違法行為を助長しているのかといったリスクカテゴリ単位で判断を行います。

そのため、表面的には問題のある語句を含んでいても、説明・批判・注意喚起といった安全な文脈であれば、適切に区別できるようになります。

Llama Guardであれば多段階の対応も可能

また、フィルタリングは遮断するorしないという二値的な制御になりがちですが、Llama Guardでは後続の制御ロジックを柔軟に設計でき、以下のような多段階の対応も可能です。

- 即時ブロック

- 警告を表示して継続

- 人手レビューに回す

フィルタリングが入口で弾く仕組みだとすれば、Llama Guardは、生成AI活用を前提としたリスク評価レイヤーと言えるでしょう。

Llama Guardの仕組み

Llama Guardは、生成AIの前後に組み込むことで効果を発揮します。以下では、Llama Guardの代表的な活用パターンを2つ解説します。

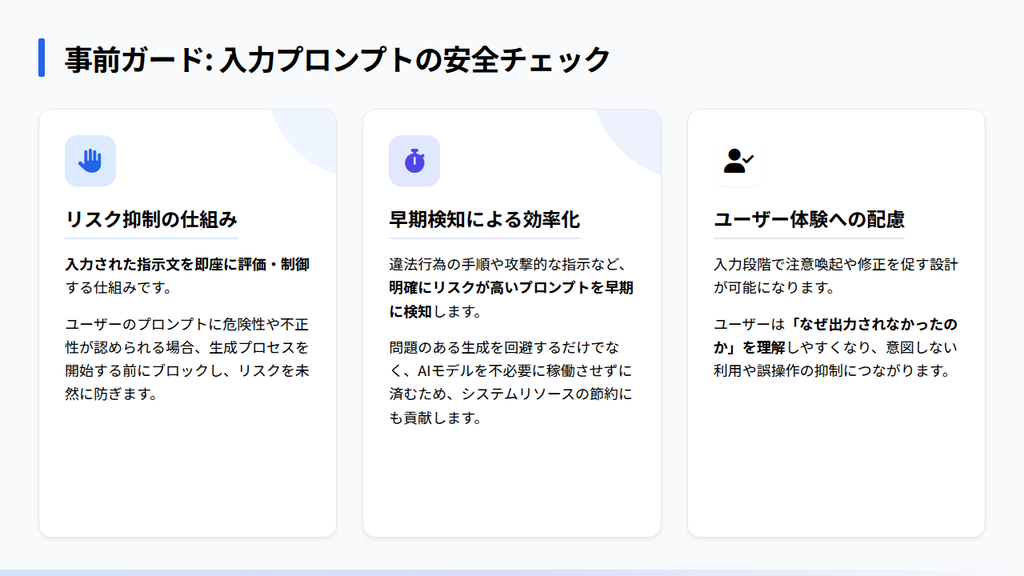

プロンプト入力時のチェック(事前ガード)

プロンプト入力時のチェック、いわゆる事前ガードは、生成AIが不適切な出力を行う前段階でリスクを抑制するための活用方法となります。ユーザーが入力した指示文をLlama Guardで評価し、危険性や不正性が認められる場合には、その時点で処理を制御します。

このアプローチでは、問題のある生成結果が生まれにくくなります。違法行為の手順や攻撃的な指示など、明確にリスクが高いプロンプトを早期に検知することで生成AIを不必要に稼働させずに済みます。

また、事前ガードはユーザー体験の観点でも有効です。入力段階で注意喚起や修正を促す設計にすることで、なぜ出力されなかったのかを理解しやすくなり、意図しない利用や誤操作の抑制につながります。

Llama Guardを事前ガードとして組み込むことは、生成AIを安全なインターフェースとして提供するための実装パターンと言えます。

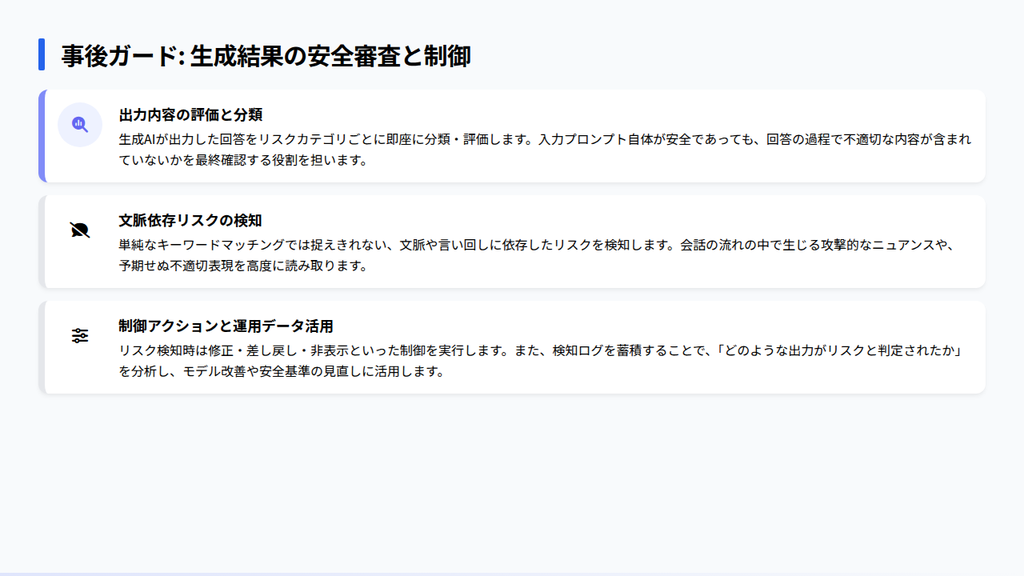

生成結果のチェック(事後ガード)

生成結果のチェック、いわゆる事後ガードは、生成AIが出力したコンテンツをLlama Guardで評価し、ユーザーに提示する運用方法です。事前ガードでは防ぎきれない文脈依存のリスクや、生成過程で生じる予期せぬ表現を検知する役割を担います。

生成AIは、入力自体に問題がなくても、回答の展開や言い回しによって攻撃的・不適切な内容を含んでしまうことがあります。そこで事後ガードを組み込むことで、出力内容をリスクカテゴリごとに分類し、修正・差し戻し・非表示といった制御を行えます。

また、事後ガードは運用データの蓄積にも適しています。どのような出力が、どのリスクカテゴリで検知されたのかを記録することで安全基準の見直しやモデル改善に活用できます。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llama Guardが分類するリスクカテゴリは?

Llama Guardでは、リスクの性質ごとに整理されたカテゴリに分類する設計を採用しています。以下では、Llama Guardが代表的に分類対象としているリスクカテゴリについて解説します。

攻撃性・有害性を含むコンテンツ

Llama Guardが重視して分類するリスクの一つが、攻撃性や有害性を含むコンテンツです。以下のような、特定の個人や集団に対して社会的・心理的な被害を生む可能性のある内容を指します。

- 誹謗中傷

- 差別的表現

- 暴力的な言動

- 脅迫

このカテゴリは、表現そのものではなく文脈によって有害性の有無が変わります。強い言葉遣いであっても批評や注意喚起として成立している場合もあれば、同じ表現が明確な攻撃やハラスメントになる場合もあります。

Llama Guardでは、文章全体の意図や対象を考慮することで、こうした違いを分類しようとします。

企業や業務システムに生成AIを組み込むとなると、攻撃的・有害な表現が混入することはブランド毀損や顧客トラブルに直結します。そのため、このリスクカテゴリは事業継続や信頼性確保の観点からも重要な判定対象となるでしょう。

違法・不正行為の助長

違法行為や不正行為を助長する可能性のあるコンテンツは、以下のように利用者の行動を直接的に誘発し得る情報を含みます。

- 犯罪行為の手順説明

- 詐欺や不正アクセスの指南

- 規制対象物の製造・入手方法

このリスクは、生成AIが質問に忠実に答えるという性質を持つがゆえに顕在化します。悪意のあるユーザーでなくとも、法令違反につながる行為を助長してしまうケースは少なくありません。

Llama Guardは、単なる知識提供と実行可能な助言との境界を意識しながら、行為の実現性や具体性に着目して分類します。国際的な安全基準(MLCommons等)に基づいたハザード・タクソノミー(有害性の分類学)を学習済みなので、導入したその日から高度なガバナンスを効かせることが可能です。

企業が生成AIを業務で提供・活用する場合、違法・不正行為の助長は法的責任や社会的信用の失墜に直結します。そのため、このカテゴリはコンテンツ品質の問題ではなく、コンプライアンスとリスクマネジメントの中核として扱われます。

自己危害・危険行為の促進

自己危害や危険行為を促進する可能性のあるコンテンツは、自傷行為や自殺に関する助言・正当化、極端な健康リスクを伴う行動の推奨、生命や身体に重大な危険を及ぼす行為の具体的な手順提示などを含みます。

この領域は、情報提供と危険行為の助長の境界が非常に曖昧である点が特徴です。例えば、医学的・教育的な説明として成立する内容であっても、表現や文脈次第では、受け手に誤った行動を取らせる引き金になりかねません。

Llama Guardは、内容の具体性や実行可能性、促進・肯定のニュアンスに着目しながら、リスクとして扱うべきかどうかを分類します。

企業が生成AIを通じてユーザーと接点を持つ場合、このカテゴリへの対応は特に慎重さが求められます。万が一、自己危害や危険行為を助長する出力が行われた場合、その影響は深刻であり、社会的責任や企業倫理の観点からも看過できません。

センシティブ・倫理的配慮が必要なテーマ

Llama Guardが分類対象とするリスクが、センシティブで倫理的な配慮を要するテーマです。これは、特定の価値観や立場によって受け取り方が大きく異なる話題や、社会的影響が大きい領域に関するコンテンツを指します。

政治、宗教、ジェンダー、医療、社会問題などが代表例であり、必ずしも違法ではないものの、扱い方を誤ると誤解や対立を生む可能性があります。

このカテゴリの特徴は、明確に禁止すべき内容ではなく、文脈・目的・表現方法によってリスクが変動する点にあります。中立的な解説として成立する場合もあれば、特定の立場を過度に擁護・否定することで、偏りや差別と受け取られるケースもあります。

Llama Guardは、こうした曖昧さを前提に、単純な可否判定ではなく、注意喚起や追加制御が必要なコンテンツとして分類します。意図せず偏った情報や配慮を欠いた表現を発信してしまうと、信頼低下や炎上につながりかねません。

Llama Guardが生成AI活用にもたらすメリットは?

Llama Guardは、生成AIのリスクを抑制するだけでなく、業務で安心して使い続けるための基盤技術として価値を発揮します。

判断ブラックボックスの解消

生成AIを業務に導入する際、多くの企業が直面する課題が、なぜその出力が許可され、なぜブロックされたのか分からないというブラックボックス性です。外部APIやクローズドな安全機構に依存すると判断基準や制御ロジックが見えず、運用や改善が属人的になりがちです。

Llama Guardを用いることで、安全性の判断を自社システムの一部として組み込むことが可能です。どの入力・出力が、どのリスクカテゴリに分類されたのかを把握できるため、生成AIの挙動を運用側が理解しやすくなります。

AIが勝手に判断しているという状態から脱し、人が理解・管理できる安全制御レイヤーとして生成AIを位置づけられるようになります。

オープンソースであるため安く早く実装できる

Llama Guardが生成AI活用にもたらす価値の一つが、オープンソースとして提供されている点です。大量の学習データ収集からアノテーション、モデル学習、評価といった工程における安全性判定のベースラインを、既存モデルとしてそのまま利用できます。

独自の安全フィルターをゼロから開発・調整するのは膨大なコストがかかります。

Llama Guardは、すでに整理されたリスクカテゴリと学習済みモデルを前提に実装できるため、短期間で生成AIの安全ガードを組み込むことが可能です。PoCや段階的な業務導入を進めたい企業にとっては特に大きなメリットとなるでしょう。

さらに、オープンソースであることで、特定ベンダーのAPI利用料や従量課金に縛られず、自社インフラやオンプレミス環境での運用も選択できます。

制御によって柔軟な設計が可能になる

Llama Guardの特徴として、安全性を制御可能な判断レイヤーとして組み込める点が挙げられます。リスクを分類したうえで、その結果をどのように扱うかはシステム設計側で決められるため、業務要件や利用シーンに応じることが可能です。

特定のリスクカテゴリに該当した場合でも、即時に出力をブロックのではなく、注意文言を付与して継続させたり、人手レビューを介在させたりといった運用が可能になります。

また、企業ごとに許容される表現やリスク水準は異なります。そのため、その分類結果をトリガーとして活用することで自社ポリシーに沿った制御ロジックを後付けで設計できます。

ガバナンスやコンプライアンスに対応する

生成AIを業務に導入する段階では、ガバナンスやコンプライアンスへの対応が不可欠になります。Llama Guardは、生成AIの出力をリスクカテゴリごとに分類できるため、どのような基準で安全性を判断しているのかを組織として説明しやすい構造を持っています。

Llama Guardでは、外部APIに依存したブラックボックスな安全制御と異なり、自社のポリシーや業界ガイドラインに基づいた判断フローを設計できます。これにより、内部統制や利用規約・社内ルールへの反映が行いやすくなり、場当たり的な施策ではなく、統制の取れた業務プロセスとして定着させることが可能です。

また、AI規制や社内ルールの変更にもLlama Guardは対応できます。ガバナンス要件をモデル外の制御ロジックとして設計できるため、制度変更に伴う調整を最小限に抑えられます。

LLM-as-a-Judgeによるコスト最適化

巨大なメインLLMは高度な推論には不可欠ですが、1トークンあたりの計算コスト(GPU消費量)が極めて高価です。ここに安全チェックという「定型的な検閲タスク」も任せてしまうと、運用コストが膨れ上がり、ビジネスの収益性を圧迫します。

Llama Guardは8B(80億パラメータ)前後の軽量なモデルであるため、高速かつ低コストで検問機能を維持できます。推論にかかるインフラ費用をメインモデルの数分の一から数十分の一に抑えることが可能です。

「思考」には高価な大型モデルを使い、「監視」にはLlama Guard(8B/1B等)のように軽量・高速・安価な専用モデルを配置します。

LLMに強い会社・サービスの選定・紹介を行います

今年度LLM相談急増中!紹介実績1,000件超え!

・ご相談からご紹介まで完全無料

・貴社に最適な会社に手間なく出会える

・AIのプロが貴社の代わりに数社選定

・お客様満足度96.8%超

・GPT、Claude、Gemini、Llama等の複数モデルに対応

完全無料・最短1日でご紹介 LLMに強いAI会社選定を依頼する

Llama Guardが抱える限界とは?

Llama Guardは、生成AIのあらゆるリスクを排除できる仕組みではありません。具体的には、以下のような限界を抱えています。

統計的・確率的な分類に留まる

Llama Guardの判断は、あくまで統計的・確率的な分類結果に基づいています。人間のように意図や倫理観を理解しているわけではなく、学習データに基づいて、リスクに該当する可能性が高いかどうかを推定しています。

そのため、境界的な表現や新しい言い回し、学習時に十分に含まれていないケースでは誤検知や見逃しが発生する可能性があります。安全と判断されるべき内容がブロックされる場合もあれば、逆にリスクを完全には捉えきれない場合もあります。

実運用においては、Llama Guardの判定を絶対的な正解とみなすのではなく、補助的な判断材料として扱うことが重要です。人手レビューや追加ルールと組み合わせつつ、確率的な分類の限界を補完する必要があります。

業務・業界固有の文脈まではカバーが難しい

Llama Guardは汎用的なリスクカテゴリに基づいて分類を行うため、多くのケースで一定の安全性評価を実現できます。一方で、一般的な有害性ではなく業務・業界固有の文脈に依存するリスクもあります。

金融・医療・法務のように規制やガイドラインが厳しい領域では、同じ表現でも許容範囲が異なります。社内規程・広告表現規制・個人情報の取り扱い基準などは企業ごとに差があるため、一般的に危険であるかどうかよりも、その組織にとって許容されるかが重要になります。

Llama Guardは汎用モデルである以上、こうした内部規定や業務プロセスまでを前提に判断することは困難です。

ユーザーへのレスポンス速度に影響する

Llama Guardを導入することで、ユーザーへのレスポンス速度に影響を与える可能性があります。これは、プロンプトや生成結果を追加でモデルに通し、評価・分類する工程が発生するためです。

特に事前ガードと事後ガードを併用する場合、生成AI本体の出力に加えてLlama Guardの推論処理が重なるため、応答までのレイテンシは増加します。リアルタイム性が求められるチャットUIや業務支援ツールでは、この遅延がユーザー体験の低下につながることもあるでしょう。

そのため、実運用ではすべてのリクエストに一律で適用するのではなく、リスクの高い用途に限定したり、非同期処理やキャッシュを活用するなど安全性と応答性能のバランスを考慮した設計が重要になります。

リスクの根拠を説明できるわけではない

Llama Guardは、判断に至るまでの根拠を人間が理解できる形で説明できるわけではありません。分類結果はあくまでモデルの内部表現に基づく推定であり、なぜ危険と判断されたのかを論理的に分解して提示する機能は現時点で限定的です。

特に、利用者や関係部署から判断理由の説明を求められた際、モデルの確率的判断だけでは十分な説明責任を果たせないケースも想定されます。Llama Guardはブラックボックス性を低減する手段ではありますが、完全な説明可能性(Explainability)を提供するものではない点は認識しておく必要があります。

LLama Guardについてよくある質問まとめ

- LLama Guardとは何ですか?

Llama Guardとは、生成AIの入出力の安全性やリスクを文脈単位で分類・評価するためのセーフティモデルです。Metaが公開しているオープンソースモデルで、LLM(大規模言語モデル)の文脈理解能力を活用して、リスクカテゴリごとの判定を行います。

- LLama Guardはどんな内容を制御しますか?

LLama Guardは、生成AIが扱うコンテンツのうち、業務上・社会的に問題となり得るリスクを分類します。

- 攻撃性・有害性を含むコンテンツ

- 違法・不正行為の助長

- 自己危害や危険行為の促進

- センシティブで倫理的配慮が必要なテーマ

- LLama Guardの限界は?

Llama Guardには、以下のような限界があり、導入すれば解決するわけではありません。

- 統計的・確率的な分類に留まる

- 業務・業界固有の文脈まではカバーが難しい

- ユーザーへのレスポンス速度に影響する

- リスクの根拠を説明できるわけではない

- 自社特有の専門用語や厳しい社内規定がある場合、汎用的なLlama Guardだけで対応可能ですか?

Llama Guardは汎用的な安全基準には強いですが、業界固有の規制や社内ルールを完璧にカバーするには、独自のデータを用いたファインチューニングや、ルールベースの仕組みとの併用が必要です。AI Marketでは、貴社の業界に特化した開発実績を持つ企業を厳選してご紹介し、カスタマイズ性の高いセーフティ設計の支援を行っております。

- Llama Guardを導入することで、ユーザーへのレスポンス速度が落ちる(遅延が発生する)のが心配です。

モデルを二重に通すため、物理的なレイテンシはゼロではありません。しかし、モデルの量子化技術やエッジ側での推論、非同期処理の最適化により、ユーザーがストレスを感じないレベルまで短縮可能です。AI Marketのコンシェルジュにご相談いただければ、安全性とレスポンス速度のバランスを最適化したインフラ構築が得意な技術パートナーをご提案します。

まとめ

Llama Guardは、生成AIのリスクを設計段階で管理できる基盤を作り出す技術です。フィルタリングでは対応しきれない文リスクを分類し、生成AI活用を前提とした安全設計を可能にします。

一方で、Llama Guardは統計的判断や汎用モデルであることに起因する限界も併せ持っています。だからこそ、Llama Guardを単体で完結させるのではなく、業務要件・ポリシー・人手レビューと組み合わせ、運用として成立させる必要があります。

生成AIを実験的な取り組みから、業務基盤へと移行させるためには、安全性・説明責任・ガバナンスを避けて通ることはできません。Llama Guardは、その基盤を構築するための選択肢であり、生成Aの活用を可能にするピースと言えるでしょう。

自社のビジネス領域において、どのレベルのガードレールが必要なのか。また、最新のLlama 4世代を見据えたアーキテクチャをどう構築すべきか。具体的な実装フェーズで最適解を導き出すには、技術トレンドとビジネスリスクの両面に精通した専門家の知見が求められます。

安全かつ効率的なAI運用の第一歩として、まずは専門的なコンサルティングを通じて、貴社専用のセーフティポリシーを定義することをお勧めします。

AI Market 運営、BizTech株式会社 代表取締役|2021年にサービス提供を開始したAI Marketのコンサルタントとしても、お客様に寄り添いながら、お客様の課題ヒアリングや企業のご紹介を実施しています。これまでにLLM・RAGを始め、画像認識、データ分析等、1,000件を超える様々なAI導入相談に対応。AI Marketの記事では、AIに関する情報をわかりやすくお伝えしています。

AI Market 公式𝕏:@AIMarket_jp

Youtubeチャンネル:@aimarket_channel

TikTok:@aimarket_jp

運営会社:BizTech株式会社

掲載記事に関するご意見・ご相談はこちら:ai-market-contents@biz-t.jp